4.ENTROPIA E INFORMAZIONE

4.1. Entropia come misura dell'incertezza statistica. In uno dei recenti dibattiti pubblici sulle questioni educative, è stato suggerito che ogni persona istruita dovrebbe comprendere la natura fondamentale del concetto di incertezza. Negli ultimi decenni, questo termine ha preso con sicurezza il comando tra i primi principi fisici, penetrando in nuove aree della conoscenza. In questa sezione, dovresti acquisire più familiarità con questo concetto e comprendere la connessione tra l'incertezza e le caratteristiche di formazione del sistema.

L’incertezza può avere origini diverse. Uno dei suoi tipi è sconosciuto– considerato dalla teoria della conoscenza e dalla filosofia; questo tipo di incertezza sorge quando, ad esempio, poniamo la domanda “C’è vita su altri pianeti?” o "Ci sono altre civiltà?" e così via.

Un altro tipo di incertezza vaghezza, confusione,- ad esempio: “Quanti granelli di sabbia bisogna prendere per formare un mucchietto”? Incontriamo incertezze di questo tipo nella meccanica quantistica. Sulla sua base è stata costruita una versione non locale della termodinamica, in grado di rispondere a una domanda simile: “quante particelle sono necessarie per formare un macrolivello e qual è la dispersione quantistica di questo numero?” Questa incertezza è oggettiva; è caratteristico che non possa essere eliminata durante il processo di misurazione. In matematica, la teoria degli insiemi fuzzy si occupa di tale incertezza. Va notato di sfuggita che la sfocatura è una proprietà caratteristica del linguaggio: “un uomo alto (che altezza?) giovane (che età esattamente?) (chi è?) è entrato nella stanza (cosa?), ecc.

Il terzo tipo di incertezza è incidente. Si basa su leggi statistiche stabilite dalla teoria della probabilità. Questo tipo di incertezza viene utilizzato dalla fisica statistica e insieme all'incertezza del secondo tipo nella meccanica quantistica. Una caratteristica distintiva dell'incertezza statistica è che è possibile stabilire una misura quantitativa su quale parleremo Ulteriore.

Lasciamo per ora da parte la questione del significato pratico della misura statistica dell'incertezza, concentrandoci sulla sua essenza. Consideriamo alcune semplici situazioni, che chiameremo esperimenti A, B e C. Si presuppone che il lettore abbia familiarità con gli elementi della teoria della probabilità.

L'esperimento A consisterà nel lanciare una moneta. In questo esperimento ce ne sono due possibili risultato(K=2): “testa o croce”. Ovviamente, la probabilità di ciascun risultato( io=1,2).

Esperimento B – lancio di un dado a sei facce. Ci sono già sei possibili risultati in questo esperimento ( K=6). La probabilità di ciascun risultato.

L'esperimento C prevede il lancio di due dadi contemporaneamente. Per questa esperienza K=36 e.

Valutare l’incertezza dei risultati sperimentali è una valutazione della difficoltà di prevedere il risultato di un esperimento. È intuitivamente chiaro che tra tutte le situazioni descritte, l'esperienza C presenta la massima incertezza, poiché il numero di risultati qui è il maggiore ed è più difficile prevedere in anticipo l'esito di questa esperienza.

Per passare a una valutazione quantitativa dell'incertezza, formuliamo i requisiti di base per una funzione che dovrebbe svolgere il ruolo di misura dell'incertezza. Indicheremo questa funzione con la lettera H.

Primo requisito. Funzione N dovrebbe aumentare monotonicamente con l’aumentare del numero di risultati sperimentali.

Secondo requisito. Funzione N deve essere uguale a zero se esiste un solo risultato ( K=1). Ciò significa che se è possibile un solo risultato, non vi è alcuna incertezza e il risultato dell'esperimento può essere previsto senza errori.

Terzo requisito. Prestiamo attenzione al fatto che un esperimento C può essere considerato come due esperimenti B, e richiediamo che il valore di entropia totale di due esperimenti B sia uguale all'entropia dell'esperimento C

o in generale non per due, ma N semplici esperimenti

Se il terzo requisito non fosse soddisfatto, allora la valutazione dell'incertezza dell'esperienza C risulterebbe contraddittoria e dipenderebbe dall'interpretazione soggettiva dell'esperienza stessa - se considerare che l'esperienza C abbia avuto luogo, oppure se i dadi non siano stati soddisfatti. cadere contemporaneamente e si sono verificate due esperienze B. Accettare questo requisito equivale a introdurre proprietà di additività per la futura valutazione dell'incertezza. Per impostazione predefinita, si presuppone che gli elementi (ossa) in questione non interagiscano tra loro. Nell'interpretazione termodinamica ciò equivale ad accettare un sistema ideale.

Risolviamo l'equazione funzionale (4.1) per la funzione . Per fare ciò, differenziamo entrambi i lati dell'espressione (4.1-1) rispetto a K, utilizzando il requisito di monotonicità della funzione:

Ora differenziamo la (4.1) rispetto a N

Dividiamo l'equazione (4.2) per (4.3)

che è equivalente

Integrando questa espressione e utilizzando l'integrale della tabella per il membro di destra, otteniamo

dove è la costante di integrazione.

Dall'ultima espressione

Poiché con l'aumento K l'entropia aumenta (primo requisito), quindi C>0, e questa espressione può essere riscritta nella seguente forma finale:

,UN>1.

Ne consegue che esso soddisfa anche il secondo requisito. Scegliere la base dei logaritmi per UN>1 non ha importanza e determina solo la scelta dell'unità di misura dell'incertezza. I più comunemente usati sono i logaritmi binari o naturali. Se si utilizzano i logaritmi binari, allora l'incertezza di un esperimento che ha due risultati ugualmente probabili (esperimento A) viene presa come unità di misura dell'incertezza. Questa situazione corrisponde all'entropia di una cella elementare di un computer, che memorizza 0 o 1. Per questa cella

Questa unità di misura si chiama morso(dall'inglese Binarydiget – unità binaria).

Cosi quando K risultati ugualmente probabili, l’incertezza dell’esperienza lo è

Dove P– probabilità dell’esito dell’esperimento.

Considerandolo per esiti altrettanto probabili

quindi, moltiplicando la (4.4) per uno sotto forma di somma di probabilità, otteniamo

Ogni termine sul lato destro di questa espressione può essere considerato come il contributo di un risultato individuale all’incertezza complessiva dell’esperienza. Nel caso di risultati ugualmente probabili, il contributo di ciascuno di essi all'incertezza complessiva dell'esperimento è lo stesso e la formula (4.5) collassa nella (4.4).

L'espressione (4.5) è facilmente generalizzabile al caso in cui le probabilità dei risultati sono diverse. In questo caso la (4.5) può essere considerata come l'entropia media dell'esperienza, e le probabilità prima del log assumono il significato di coefficienti di ponderazione. Si presuppone ora che il contributo di ciascun risultato all’incertezza totale dell’esperienza non sia necessariamente lo stesso. Un esempio di situazione con risultati disuguali è l'esperienza di estrarre una pallina a caso da un'urna contenente un gran numero di palline di diversi colori. La riserva relativa al gran numero di palline è stata fatta appositamente per sottolineare il carattere probabilistico della misura dell'incertezza.

L'espressione (4.5) può essere scritta in forma compatta

Se il numero di esperimenti N, tenendo conto quindi dell'additività dell'entropia

L'entropia come misura dell'incertezza fu introdotta dal matematico americano Claude Shannon nel 1949 mentre sviluppava la teoria matematica della comunicazione. Una funzione come (4.6), o entropia di scelta spesso chiamato anche Entropia di Shannon. Poiché il concetto di entropia oggi sta diventando scientifico generale, l'indicazione della sua origine informativa, di regola, viene utilizzata solo nei casi in cui il testo dovrebbe distinguere tra entropia informativa e termodinamica (fisica).

Riso. 4.1. Dipendenza dell'entropia per due risultati dell'esperimento

Consideriamo alcune proprietà dell'entropia. Notiamo innanzitutto che l'entropia non può assumere valori negativi: poiché , è sempre positiva. Se, allora (a titolo di prova, l'incertezza del tipo deve essere divulgata). Se, allora anche.

Da solo quando P=0 o P=1, allora l'entropia dell'esperienza è zero solo nel caso in cui una delle probabilità è uguale a uno e, quindi, tutte le altre sono uguali a zero. Questa circostanza è in buon accordo con il significato della quantità H come misura dell'incertezza: in questo caso l'esperienza non contiene alcuna incertezza, poiché il risultato dell'esperienza può essere previsto in anticipo.

La Figura 4.1 mostra il grafico della funzione H per due risultati di un esperimento, da cui è chiaro come cambia l'entropia quando uno dei risultati dell'esperimento cambia da zero a uno. Dal grafico ne consegue valore massimo l’entropia corrisponde ad eventi ugualmente probabili. In questo caso, il valore massimo di entropia

Nel caso generale, ad es. non per due, ma K risultati dell'esperimento, corrisponde il valore massimo di entropia.

Il fatto che il massimo di entropia corrisponda ad eventi ugualmente probabili è coerente con il significato di entropia. Infatti, nel caso di eventi ugualmente probabili, è impossibile dare la preferenza a qualsiasi risultato e quindi è molto difficile prevederne l’esito.

4.2. Entropia come misura della quantità di informazione. Torniamo agli esperimenti più semplici con una moneta o un dado. Prima di condurre un esperimento, c'è qualche incertezza associata alla non conoscenza del risultato dell'esperimento. Dopo l'esperimento, ad es. dopo aver ricevuto il risultato, questa incertezza viene eliminata e scompare. Tuttavia, questo non è sempre il caso e, in pratica, molto spesso ci sono casi in cui rimane ancora qualche incertezza dopo la fine dell'esperimento.

Se l'incertezza prima dell'esperimento fosse N(incertezza a priori), e dopo l'esperimento –( incertezza posteriore), allora ovviamente l’incertezza eliminata durante l’esperimento sarà:

Questa differenza si chiama quantità di informazioni.

Così, la quantità di informazioni è la quantità di incertezza eliminata. In un caso particolare, quando l'incertezza risultante dall'esperimento è completamente eliminata, come nel caso degli esperimenti A, B e C, otteniamo: Anche se qui la quantità di informazione è formalmente uguale all’entropia, bisogna tenere presente il diverso significato della quantità di informazione e dell’entropia. L'entropia (incertezza) esiste prima dell'esperimento, mentre l'informazione appare dopo l'esperimento. Va solo tenuto presente che per la valutazione quantitativa dell'informazione non esiste altra misura oltre all'entropia. La relazione tra i concetti di entropia e quantità di informazione assomiglia alla relazione tra i concetti fisici di potenziale (entropia) e differenza potenziale (quantità di informazione).

La quantità di informazioni, come l'entropia, viene misurata in bit. Un bit di informazione è la quantità di informazioni che indica quale dei due eventi ugualmente probabili si è verificato. Ad esempio, la quantità di informazione contenuta in una cella elementare di computer contenente 0 o 1 è un bit.

Consideriamo un esempio in cui apparirebbe un'incertezza a posteriori. Lascia che il metodo di enumerazione delle opzioni cerchi la radice di un'equazione accurata con un semiintero. È noto in anticipo che il valore della radice è compreso tra 1 e 100, quindi dovresti passare attraverso 200 opzioni. Quindi lo sarà l'incertezza del valore della radice nella versione altrettanto probabile (4.4). H = tronco d'albero 2 200 = 13,3 bit.

Supponiamo che siano state controllate 150 varianti di possibili valori di radice, ma che non sia stata trovata alcuna radice. Tuttavia, si ottengono alcune informazioni sul significato della radice? Indubbiamente, per determinarla, è necessario prima trovare l’incertezza residua (posteriore): H 1 = tronco d'albero 2 (200 – 150) = 5,6. Quindi la quantità di informazioni richiesta sarà = 13,3 – 5,6 = 7,7 bit.

Entropia condizionata. Consideriamo il concetto di quantità di informazioni utilizzando l'esempio della trasmissione del segnale. Lascia che un gruppo di segnali venga trasmesso in codice Morse:

Fino a quando non viene ricevuto il carattere successivo dal destinatario, c'è incertezza su "quale segnale verrà inviato?" Questa incertezza può essere caratterizzata dall'entropia “per carattere” (4.6) con il numero di risultati k = 3 (punto, linea, spazio) con probabilità p i (i = 1, 2, 3). La probabilità che un punto, un trattino o uno spazio appaia all'estremità ricevente, ad es. Gli specialisti conoscono le probabilità (frequenze) di utilizzo dei simboli in una particolare lingua dall'analisi statistica di un grande volume di testi in quella lingua. Calcolando l'entropia per carattere, utilizzando la formula (4.6) è facile determinare l'entropia totale del messaggio (4.7). IN in questo esempio 10 caratteri compreso lo spazio e quindi N = 10.

Quindi, al destinatario, prima di ricevere il messaggio, c'era un'incertezza a priori (4.7) o un segno (4.6). Dopo aver ricevuto il messaggio, l'incertezza è stata eliminata ed è stata ricevuta l'informazione I=H– 0.

Tuttavia, tale situazione semplice si verifica se il messaggio viene trasmesso senza interferenze ( canale senza rumore). Se c'è rumore, la sua azione porta al fatto che il simbolo trasmesso può rimanere lo stesso (i-esimo) o essere sostituito accidentalmente da qualsiasi altro (n-esimo) simbolo. La probabilità di tale sostituzione è indicata con p(y n x i), dove x si riferisce al segnale trasmesso e y al segnale ricevuto al ricevitore. In un canale senza interferenze y n = x i . Viene chiamata la probabilità p(y n x i). probabilità condizionale x i) è la probabilità che il segnale i-esimo inviato corrisponda al segnale n-esimo all'estremità ricevente. Naturalmente questa situazione può essere considerata anche dal lato del trasmettitore, utilizzando probabilità condizionate della forma p(x i y n). In questo caso, ð(xi y n) è la probabilità che il segnale venga ricevuto dal destinatario ennesimo segnale corrisponde al segnale i-esimo sul lato trasmittente. Introduce il concetto di probabilità condizionata entropia condizionata in funzione della probabilità condizionata. In generale, questo è scritto nella seguente notazione:

I(X,Y) = H(X) – H(XY)

I(X,Y) = H(Y) – H(YX)

In queste identiche espressioni, l'entropia condizionale gioca il ruolo dell'entropia posteriore, e lo è la quantità di informazione misura di conformità due oggetti casuali X e Y.

Questa misura ci permette di capire connessione tra concettoinformazioni e la loro quantità. L'informazione è il riflesso di un oggetto da parte di un altro. In questo esempio, questi oggetti sono il ricevitore e il trasmettitore. La quantità media di informazioni è una caratteristica numerica della completezza di questa riflessione, del grado di corrispondenza e, infine, grado di interazione questi oggetti. Ma quando interagiscono, gli oggetti si influenzano a vicenda e siamo abituati a distinguere tra causa ed effetto. La descrizione quantitativa delle informazioni è un altro tipo di descrizione delle interazioni che non è in alcun modo correlata alle classiche descrizioni di causa-effetto. Questo tipo di comunicazione è tipico per NVT.

Qui è utile fare riferimento al paragrafo 3.6, dove abbiamo già accennato ai limiti del classico meccanismo di causa-effetto nel descrivere le interazioni in un sistema aperto.

4.3.Entropia di un insieme continuo. Recensito in precedenza entropia di un insieme discreto. Ciò significa che si intendevano sistemi in cui il numero di possibili risultati (elementi dell'insieme) è finito. Tuttavia, spesso incontriamo situazioni in cui il numero di elementi può essere arbitrariamente grande. Dalla teoria della probabilità è noto che in questo caso non si dovrebbe occuparsi della probabilità di un risultato individuale, che è uguale a zero, ma della densità della distribuzione di probabilità. Questa funzione ha la proprietà che la quantità è la probabilità che la variabile ci interessi X(il valore della radice nell'esempio della clausola 4.2.) assumerà valori nell'intervallo da X Prima x+dx.

Ora, per stimare l’incertezza, è necessario ricorrere all’entropia di un insieme continuo, che, per analogia con l’entropia di un insieme discreto (4.5), ha la forma

![]() . (4.9)

. (4.9)

Come esempio di utilizzo di questa funzione, proveremo a stimare l'incertezza dell'esperienza associata a una ricerca casuale in dato intervallo valori root (vedere clausola 4.2) in assenza di restrizioni sulla precisione della ricerca.

Aumentando i requisiti per l'accuratezza della risposta, ci si può aspettare un numero arbitrariamente elevato di possibili risultati dell'esperimento. In questo caso, la probabilità di ciascun risultato tende a zero e la radice desiderata può assumere tutti i possibili (innumerevoli) valori in un dato intervallo numerico compreso tra 0 e 200. Proviamo a utilizzare l'entropia di un insieme continuo per lo stesso problema. Introduciamo un segmento di lunghezza l=x 1 –x 0 unità relative. La probabilità di trovare il valore della radice nell'area dx è dx/ 1 . D'altra parte, questa stessa probabilità è per definizione. Pertanto, per il caso altrettanto probabile = dx/l u= 1/ l. Sostituendo questo valore nella (4.), è facile ottenerlo H = ceppo 2 l= 5,6 bit.

Confrontiamo il risultato ottenuto con l'esempio del paragrafo 4.2. Nel caso di un insieme discreto, l'entropia utilizza il numero di intervalli discreti su un segmento selezionato e, nel caso di un insieme continuo, la lunghezza relativa del segmento stesso. Si noti che la lunghezza deve essere espressa in forma relativa, altrimenti sotto il logaritmo comparirebbe una quantità dimensionale. La scala di riduzione a una forma relativa non è di fondamentale importanza per l'entropia dell'informazione, poiché fin dall'inizio l'entropia è stata introdotta con precisione rispetto a un fattore (fino alla costante di integrazione, vedere la procedura di integrazione nel paragrafo 4.1).

Entropia di un insieme continuo o entropia differenziale(4.9) possiede la maggior parte delle proprietà dell'entropia degli insiemi discreti.

IN letteratura moderna si possono trovare critiche al concetto di entropia differenziale e al concetto risultante quantità differenziale di informazioni. Questa critica nella sua natura coincide con la critica al concetto di continuità, discussa in precedenza nella sezione 3.5.

4.4.L'entropia come misura della diversità, del disordine, del caos. Finora il concetto di entropia è stato associato all’incertezza. L’entropia consente un’altra interpretazione. Immaginiamo un sistema costituito da una camera in cui sono presenti N palline di tipo diverso, ad esempio, nel colore . Si presuppone che N sia un numero sufficientemente grande. Indichiamo la frazione di palline io-esimo tipo (colore) –. Se eseguiamo un esperimento sul sistema, che consiste nell'estrarre a caso una pallina, allora l'entropia di un esperimento, secondo la (4.6), sarà:

Si presuppone che le dimensioni delle palline siano le stesse, diversamente varia la probabilità di estrazione delle palline io-quel tipo non corrisponderà esattamente alla loro quota nella Camera. Entropia di tutti gli esperimenti sul sistema

Poiché il lato destro delle ultime espressioni include parametri che caratterizzano il contenuto del sistema, sorge la domanda se, senza fare riferimento ad esperimenti con le palle, sia possibile capire da quale punto di vista queste funzioni caratterizzano il contenuto della camera.

La prima delle due funzioni caratterizza grado di disordine sistema o il grado di diversità in esso, tenendo conto della caratteristica selezionata per distinguere gli elementi del sistema (il colore delle palline). Se nella camera c'erano palline dello stesso tipo, allora uno dei valori di probabilità P=z sarebbe uguale a uno, e tutti gli altri sarebbero uguali a zero, e l'entropia sarebbe valida valore nullo. Ciò significherebbe che il sistema è completamente ordinato o, che è la stessa cosa, che non esiste alcuna diversità nel sistema in termini di attributo valutato (colore).

La seconda funzione (4.11) misura il disordine (diversità) nel sistema in modo leggermente diverso. La differenza tra queste due funzioni può essere illustrata dal seguente esempio. Se la camera è divisa in due parti, allora è sufficiente grandi quantità palle in esso parti di palle io-esimo tipo in ciascuna delle due parti rimarrà lo stesso, ma il numero di palline sarà dimezzato, e anche il disordine stimato dalla formula (4.11) sarà dimezzato. Tuttavia, il grado di disordine per ciascuna delle due parti, stimato dalla funzione (4.10), rimarrà lo stesso.

Per analogia con l'esempio appena considerato, è possibile utilizzare la formula (4.11) per stimare il disordine del flusso di una miscela di sostanze qualsiasi. In questo caso, la concentrazione io-esimo componente in frazioni molari; N– portata ovvero il numero di molecole che attraversano una determinata sezione trasversale nell’unità di tempo. Dal numero N V problemi praticiè sempre molto grande, possiamo spostarci su una scala diversa per l’entropia. Ad esempio, dividendo i lati sinistro e destro per il numero di Avogadro, otteniamo

Dove F– portata, kmol/unità. tempo. La designazione dell'entropia sulla nuova scala rimane la stessa.

Pertanto, l'entropia valuta la diversità degli elementi in un sistema in base ad alcune caratteristiche specifiche che potrebbero interessarci in un compito particolare; vedere le clausole 4.6 e 4.7.

Notiamo che l'espressione (4.10) coincide, a meno di un fattore, con l'espressione termodinamica dell'entropia molare di miscelazione di un gas ideale

S= –R, (4.13)

dove R è la costante dei gas.

In questo esempio si può notare la connessione tra l'entropia dell'informazione, introdotta nelle sezioni precedenti senza utilizzare alcun principio fisico, e la termodinamica. Qui è anche utile notare non solo l'analogia esterna e strutturale. L'entropia della miscelazione (4.13) è solo l'entropia di una miscela termodinamicamente ideale. Quando si considera la camera a sfera, sono state adottate anche alcune restrizioni, ad esempio il requisito dimensioni uguali palle.

Viene spesso chiamata entropia scritta in termini di probabilità funzionale, in contrasto con l'entropia espressa in termini di frazioni molari, che viene chiamata attributivo.

4.5 Connessione dell'entropia dell'informazione con la fisica. Il concetto di entropia fu introdotto per la prima volta nella termodinamica da Clausis come relazione che collega l'incremento elementare di entropia dS con una quantità elementare di calore dQ ad una temperatura T

dS = dQ/T(4.14)

Questa espressione dice poco sull'essenza fisica dell'entropia. In fisica sono stati fatti ripetutamente tentativi per rivelare il contenuto di questo concetto, guidati da concetti modello.

Entropia di Boltzmann. Consideriamo la nota equazione di Boltzmann basata su un approccio statistico

Dove K B– costante di Boltzmann, K B=1.3810J/K;W – numero di microstati.

Per comprendere l'essenza dei metodi statistici, come primo esempio, consideriamo un gas come un insieme elevato numero particelle. La prima cosa che sembra necessario fare quando si costruisce un modello matematico del comportamento delle particelle è provare a scrivere l'equazione del moto di ciascuna di esse, perché un gas, almeno in prima approssimazione, è un sistema di particelle in movimento secondo le leggi della meccanica newtoniana.

Tuttavia, con questo approccio, il numero di equazioni diventa inimmaginabilmente grande, per non parlare del fatto che per integrare queste equazioni sono necessarie le velocità iniziali e le coordinate di ciascuna molecola. Tuttavia, questo percorso non è solo complicato, ma anche infruttuoso, poiché la conoscenza delle traiettorie e della legge di movimento delle singole molecole non fornisce alcuna informazione riguardante le proprietà del gas nel suo complesso. Il fatto è che in un sistema costituito da molte particelle sorgono nuovi modelli sistemici o integrativi puramente statistici che non esistevano in un sistema con un piccolo numero di particelle.

Utilizzando un modello molto semplificato, tracciamo come appaiono queste nuove proprietà associate al concetto di entropia di Boltzmann.

Per chiarezza, prendiamo un sistema di sole dieci particelle ( N=10), distribuito su quattro livelli energetici, aventi relativi valori energetici pari a 1, 2, 3 e 4. L'energia totale del sistema è 20 unità relative. Il compito è quello di esprimere alcune considerazioni riguardo lo stato che assumerà il sistema se lasciato a se stesso, ovvero riguardante la distribuzione delle particelle nei livelli energetici.

Per fare ciò, scopriamo quali distribuzioni energetiche delle particelle sono possibili. In questo caso, distingueremo tra cambiamenti nel micro e macrostato del sistema. Se c'è un cambiamento nel numero di particelle a qualsiasi livello energetico, allora parleremo di cambiamento macrostati sistemi. Se ci fosse solo uno scambio di particelle tra livelli energetici, ma il numero di particelle a ciascun livello energetico rimanesse lo stesso, registreremo il cambiamento microstati sistemi. Per un osservatore esterno che monitora solo i macrostati del sistema, i cambiamenti di natura microscopica passeranno inosservati e i microstati saranno indistinguibili. Un macrostato può essere realizzato da molti microstati.

Pertanto, uno dei possibili macrostati nel sistema di dieci particelle considerato è il seguente: al primo livello energetico c'è una particella ( N 1 =1), sul secondo ci sono otto particelle ( N 2=8) e uno occupa il terzo livello ( N 3 = 1). Il quarto livello non è occupato. L’energia totale è 11+82+13+ 40=20. Supponiamo che le particelle siano numerate. Quindi questo macrostato potrebbe essere realizzato in diversi modi (attraverso diversi microstati), ponendo, ad esempio, al livello energetico 1 particelle a turno con i numeri 1, 2, 3, 4, 5, ecc., cioè effettuare vari riarrangiamenti di particelle senza disturbare il macrostato del sistema.

![]() . (4.16)

. (4.16)

Qui R– numero di livelli energetici; in questo esempio R= 4.

Se ora passiamo ad un altro macrostato, cioè prendiamo una diversa distribuzione delle particelle sui livelli di energia, ad esempio, N 1 =2,N 2 =7,N 3 =0 e N4=1 (energia totale 21+72+14 = 20), allora il numero di modi per implementare questo macrostato W risulta essere pari a 360.

Concetto Entropia

introdotto per la prima volta nel 1865 da R. Clausius in termodinamica per determinare la misura della dissipazione irreversibile di energia. L'entropia viene utilizzata in vari rami della scienza, inclusa la teoria dell'informazione, come misura dell'incertezza di qualsiasi esperienza, test, che può avere risultati diversi. Queste definizioni di entropia hanno una profonda connessione interna. Pertanto, sulla base delle idee sull'informazione, si possono dedurre tutte le disposizioni più importanti della fisica statistica. [ESSERE S. Fisica. M: Grande Enciclopedia Russa, 1998].

Questa quantità è anche chiamata entropia media messaggi. L'entropia nella formula di Shannon è caratteristica media– aspettativa matematica della distribuzione variabile casuale.

Ad esempio, nella sequenza di lettere che compongono una frase in russo, compaiono lettere diverse con frequenze diverse, quindi l'incertezza dell'occorrenza è minore per alcune lettere che per altre.

Nel 1948, mentre esplorava il problema della trasmissione razionale delle informazioni attraverso un sistema rumoroso canale di comunicazione, Claude Shannon proponeva un rivoluzionario approccio probabilistico alla comprensione delle comunicazioni e creò la prima teoria veramente matematica dell’entropia. Le sue idee sensazionali servirono rapidamente come base per lo sviluppo della teoria dell'informazione, che utilizza il concetto di probabilità. Il concetto di entropia come misura della casualità fu introdotto da Shannon nel suo articolo "A Mathematical Theory of Communication", pubblicato in due parti sul Bell System Technical Journal nel 1948.

In caso di eventi altrettanto probabili ( caso speciale), quando tutte le opzioni sono ugualmente probabili, la dipendenza rimane solo dal numero di opzioni considerate e la formula di Shannon è notevolmente semplificata e coincide con la formula di Hartley, proposta per la prima volta da un ingegnere americano Ralph Hartley nel 1928, come uno degli approcci scientifici alla valutazione dei messaggi:

, dove I è la quantità informazioni trasmesse, p – probabilità di un evento, N – numero possibile di messaggi diversi (ugualmente probabili).Compito 1. Per eventi ugualmente probabili.

Ci sono 36 carte nel mazzo. Quante informazioni sono contenute nel messaggio che una carta con il ritratto di un "asso" è stata presa dal mazzo; "asso di spade"?

Probabilità p1 = 4/36 = 1/9 e p2 = 1/36. Utilizzando la formula di Hartley abbiamo:

Risposta: 3.17; 5,17 bit

Si noti (dal secondo risultato) che per codificare tutte le carte sono necessari 6 bit.

Dai risultati risulta inoltre chiaro che quanto minore è la probabilità di un evento, tanto maggiore è la probabilità che si verifichi un evento maggiori informazioni contiene. ( Questa proprietà chiamato monotonia)

Compito 2. Per eventi disegualmente probabili

Ci sono 36 carte nel mazzo. Di queste, 12 sono carte con “ritratti”. Una per una, una delle carte viene presa dal mazzo e mostrata per determinare se raffigura un ritratto. La carta viene rimessa nel mazzo. Determina la quantità di informazioni trasmesse ogni volta che viene mostrata una carta.

Quantità di informazioni

introduzione

2. Incertezza, quantità di informazione ed entropia

3. Formula di Shannon

4. Formula di Hartley

5. Quantità di informazioni ricevute durante il processo di comunicazione

Elenco della letteratura usata

introduzione

Secondo la definizione dell'A.D. Ursula – “l’informazione riflette la diversità”. La quantità di informazioni è una misura quantitativa della diversità. Questa potrebbe essere la diversità dei contenuti aggregati della memoria; la diversità del segnale percepito durante un particolare messaggio; varietà di risultati di una situazione particolare; la diversità degli elementi di un certo sistema... è una valutazione della diversità nel senso più ampio del termine.

Qualsiasi messaggio tra la fonte e il destinatario dell'informazione ha una certa durata nel tempo, ma la quantità di informazioni percepite dal destinatario come risultato del messaggio è in definitiva caratterizzata non dalla lunghezza del messaggio, ma dalla varietà del segnale generato nel destinatario da questo messaggio.

La memoria di un portatore di informazioni ha una certa capacità fisica in cui è in grado di accumulare immagini, e la quantità di informazioni accumulate nella memoria è in definitiva caratterizzata dalla diversità nel riempire questa capacità. Per gli oggetti inanimati questa è la diversità della loro storia; per gli organismi viventi questa è la diversità della loro esperienza.

La varietà è essenziale quando si trasmettono informazioni. Non si può dipingere bianco su bianco, lo Stato da solo non basta. Se una cella di memoria è in grado di trovarsi in un solo stato (iniziale) e non è in grado di cambiare il suo stato sotto l'influenza esterna, ciò significa che non è in grado di percepire e ricordare informazioni. La capacità informativa di tale cella è 0.

La diversità minima è assicurata dalla presenza di due stati. Se una cella di memoria è in grado, a seconda dell'influenza esterna, di assumere uno dei due stati, che di solito sono indicati con "0" e "1", ha una capacità informativa minima.

Come unità di misura della quantità di informazioni viene presa la capacità informativa di una cella di memoria, che può trovarsi in due stati diversi, 1 bit.

1 bit (bit - abbreviazione di cifra binaria inglese - numero binario) è un'unità di misura della capacità e della quantità di informazioni, nonché un altro valore: l'entropia dell'informazione, di cui parleremo in seguito. Bit, una delle unità di misura più incondizionate. Se l'unità di misura della lunghezza potesse essere fissata arbitrariamente: cubito, piede, metro, allora l'unità di misura dell'informazione non potrebbe essere essenzialmente un'altra.

A livello fisico, un bit è una cella di memoria che in un dato momento si trova in uno dei due stati: “0” o “1”.

Se ogni pixel di un'immagine può essere solo bianco o nero, tale immagine viene chiamata bitmap, poiché ogni pixel rappresenta una cella di memoria con una capacità di 1 bit. Anche una lampadina che può essere “accesa” o “spenta” simboleggia il ritmo. Un classico esempio che illustra 1 bit di informazione è la quantità di informazioni ottenute lanciando una moneta: "testa" o "croce".

Rispondendo ad una domanda “sì”/“no” si può ottenere una quantità di informazioni pari ad 1 bit. Se inizialmente c'erano più di due opzioni di risposta, la quantità di informazioni ricevute in una particolare risposta sarà superiore a 1 bit, se ci sono meno di due opzioni di risposta, ad es. uno, allora questa non è una domanda, ma un'affermazione, quindi non è necessario ottenere informazioni, poiché non vi è incertezza.

La capacità di informazione di una cella di memoria in grado di ricevere informazioni non può essere inferiore a 1 bit, ma la quantità di informazioni ricevute può essere inferiore a 1 bit. Ciò si verifica quando le opzioni di risposta “sì” e “no” non sono ugualmente probabili. La disuguaglianza, a sua volta, è una conseguenza del fatto che alcune informazioni preliminari (a priori) su questo tema sono già disponibili, ottenute, ad esempio, sulla base di precedenti esperienze di vita. Pertanto, in tutti i ragionamenti del paragrafo precedente, va tenuto conto di un avvertimento molto importante: essi sono validi solo per il caso altrettanto probabile.

Indicheremo la quantità di informazioni con il simbolo I, la probabilità è denotata con il simbolo P. Ricordiamo che la probabilità totale di un gruppo completo di eventi è uguale a 1.

2.Incertezza, quantità di informazione ed entropia

Il fondatore della teoria dell’informazione, Claude Shannon, definì l’informazione come la rimozione dell’incertezza. Più precisamente, ottenere informazioni - condizione necessaria per rimuovere l’incertezza. L’incertezza sorge in una situazione di scelta. Il compito che si risolve eliminando l'incertezza è ridurre il numero di opzioni prese in considerazione (ridurre la diversità) e, in definitiva, scegliere un'opzione adeguata alla situazione tra quelle possibili. Eliminare l’incertezza rende possibile prendere decisioni informate e agire. Questo è il ruolo di controllo delle informazioni.

Una situazione di massima incertezza presuppone la presenza di più alternative (opzioni) ugualmente probabili, ovvero nessuna delle due opzioni è preferibile. Inoltre, quanto più si osservano opzioni ugualmente probabili, tanto maggiore è l'incertezza, tanto più difficile è fare una scelta univoca e maggiori sono le informazioni necessarie per ottenerla. Per N opzioni, questa situazione è descritta dalla seguente distribuzione di probabilità: (1/N, 1/N, … 1/N).

L’incertezza minima è 0, cioè si tratta di una situazione di assoluta certezza, nel senso che la scelta è stata effettuata e sono state ricevute tutte le informazioni necessarie. La distribuzione di probabilità per una situazione di completa certezza è questa: (1, 0, …0).

La quantità che caratterizza la quantità di incertezza nella teoria dell'informazione è indicata con il simbolo H e si chiama entropia, più precisamente entropia dell'informazione.

L'entropia (H) è una misura dell'incertezza espressa in bit. L'entropia può anche essere considerata una misura dell'uniformità della distribuzione di una variabile casuale.

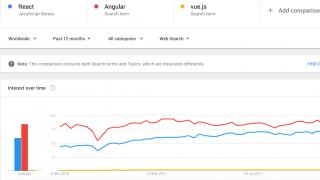

Riso. 1. Comportamento dell'entropia

per il caso di due alternative.

La Figura 1 mostra il comportamento dell'entropia nel caso di due alternative, quando cambia il rapporto tra le loro probabilità (p, (1-p)).

L'entropia raggiunge il suo valore massimo in questo caso quando entrambe le probabilità sono uguali tra loro e uguali?, il valore di entropia zero corrisponde ai casi (p0=0, p1=1) e (p0=1, p1=0).

Riso. 2. Relazione tra entropia e quantità di informazione.

La quantità di informazione I e l'entropia H caratterizzano la stessa situazione, ma da lati qualitativamente opposti. I è la quantità di informazione necessaria per rimuovere l'incertezza H. Secondo la definizione di Leon Brillouin, l'informazione è entropia negativa (negentropia).

Quando l’incertezza è completamente rimossa, la quantità di informazioni ricevute I è uguale all’incertezza H inizialmente esistente.

Quando l’incertezza viene parzialmente rimossa, la quantità di informazioni ricevute e l’incertezza rimanente che rimane irrisolta si sommano all’incertezza originale. Ht + It = H.

Per questo motivo, le formule che verranno presentate di seguito per il calcolo dell’entropia H sono anche formule per il calcolo della quantità di informazione I, cioè quando parliamo della completa rimozione dell'incertezza, H in essi può essere sostituito da I.

3.Formula di Shannon

In generale, dipendono dall'entropia H e dalla quantità di informazioni che ho ottenuto rimuovendo l'incertezza quantità originaria opzioni N e probabilità a priori di attuazione di ciascuna di esse P: (p0, p1, …pN-1), ovvero H=F(N, P). L’entropia in questo caso viene calcolata utilizzando la formula di Shannon, da lui proposta nel 1948 nell’articolo “Teoria matematica della comunicazione”.

Nel caso speciale, quando tutte le opzioni sono ugualmente probabili, la dipendenza rimane solo dal numero di opzioni considerate, cioè H=F(N). In questo caso, la formula di Shannon è notevolmente semplificata e coincide con la formula di Hartley, proposta per la prima volta dall'ingegnere americano Ralph Hartley nel 1928, vale a dire 20 anni prima.

La formula di Shannon è la seguente:

Riso. 3. Trovare il logaritmo di b in base a significa trovare la potenza alla quale devi elevare a per ottenere b.

Ricordiamo cos'è un logaritmo.

Il logaritmo in base 2 è detto binario:

log2(8)=3 => 23=8

log2(10)=3,32 => 23,32=10

Il logaritmo in base 10 si chiama decimale:

log10(100)=2 => 102=100

Proprietà di base del logaritmo:

1. log(1)=0, perché qualsiasi numero elevato a zero dà 1;

2. log(ab)=b*log(a);

3. log(a*b)=log(a)+log(b);

4. log(a/b)=log(a)-log(b);

5. log(1/b)=0-log(b)=-log(b).

Il segno meno nella formula (1) non significa che l'entropia è un valore negativo. Ciò è spiegato dal fatto che pi1 è per definizione e il logaritmo di un numero inferiore a uno è un valore negativo. Per la proprietà del logaritmo, quindi questa formula può essere scritta nella seconda versione, senza il segno meno prima del segno di somma.

viene interpretato come una particolare quantità di informazioni ottenute nel caso di implementazione dell'opzione i-esima. L'entropia nella formula di Shannon è la caratteristica media: l'aspettativa matematica della distribuzione di una variabile casuale (I0, I1, ... IN-1).

Un esempio di calcolo dell'entropia utilizzando la formula di Shannon. Lasciamo che la composizione dei dipendenti in qualche istituzione sia distribuita come segue: ? - donne, ? - uomini. Quindi l’incertezza su, ad esempio, chi incontrerai per primo quando entrerai in un’istituzione, sarà calcolata attraverso una serie di azioni mostrate nella Tabella 1.

Tabella 1.

Ii=log2(1/pi), bit

pi*log2(1/pi), bit

Se è noto a priori che nell'istituzione è presente un numero uguale di uomini e donne (due opzioni ugualmente probabili), allora quando si calcola utilizzando la stessa formula dovremmo ottenere un'incertezza di 1 bit. Questa ipotesi è testata nella Tabella 2.

Tavolo 2.

Ii=log2(1/pi), bit

pi*log2(1/pi), bit

4.Formula di Hartley

La formula di Hartley è un caso speciale della formula di Shannon per alternative ugualmente probabili.

Sostituendo il suo valore (nel caso altrettanto probabile indipendente da i) nella formula (1) al posto di pi, otteniamo:

Pertanto, la formula di Hartley sembra molto semplice:

Da ciò consegue chiaramente che maggiore è il numero di alternative (N), maggiore è l'incertezza (H). Queste quantità sono correlate nella formula (2) non linearmente, ma attraverso un logaritmo binario. Logaritmo in base 2 e riduce il numero di opzioni a unità di informazione: bit.

L'entropia sarà un numero intero solo se N è una potenza di 2, cioè se N appartiene alla riga: (1, 2, 4, 8, 16, 32, 64, 128, 256, 512, 1024, 2048...)

Riso. 3. L'entropia dipende dal numero di scelte ugualmente probabili (alternative equivalenti).

Per risolvere problemi inversi, quando l'incertezza (H) o la quantità di informazioni ottenute come risultato della sua rimozione (I) è nota ed è necessario determinare quante alternative ugualmente probabili corrispondono al verificarsi di questa incertezza, utilizzare il metodo inverso Formula di Hartley, che deriva secondo la definizione del logaritmo e sembra ancora più semplice:

Ad esempio, se è noto che come risultato della determinazione che Kolya Ivanov che ci interessa vive al secondo piano, sono state ottenute 3 bit di informazioni, allora il numero di piani della casa può essere determinato con la formula (3) come N = 23 = 8 piani.

Se la domanda è: “una casa ha 8 piani, quante informazioni abbiamo ricevuto quando abbiamo saputo che Kolya Ivanov, che ci interessa, vive al secondo piano?”, è necessario utilizzare la formula (2): I=log2 (8)=3 bit.

5.Quantità di informazioni ricevute durante il processo di comunicazione

Fino ad ora sono state fornite formule per il calcolo dell'entropia (incertezza) H, indicando che H in esse può essere sostituito da I, perché la quantità di informazioni ottenute quando l'incertezza di una determinata situazione viene completamente rimossa è quantitativamente uguale all'entropia iniziale di questa situazione.

Ma l’incertezza può essere rimossa solo parzialmente, quindi la quantità di informazioni che ho ottenuto da un determinato messaggio viene calcolata come la diminuzione di entropia avvenuta come risultato della ricezione di questo messaggio.

Per il caso altrettanto probabile, utilizzando la formula di Hartley per calcolare l’entropia, otteniamo:

La seconda uguaglianza si ricava in base alle proprietà del logaritmo. Quindi, nel caso equiprobabile, I dipende da quante volte è cambiato il numero di scelte considerate (diversità considerata).

Sulla base della (5) si può dedurre quanto segue:

Se, quindi, viene rimossa completamente l'incertezza, la quantità di informazioni ricevute nel messaggio è uguale all'incertezza che esisteva prima di ricevere il messaggio.

Se quindi l'incertezza non è cambiata, non è stata ricevuta alcuna informazione.

Se, allora => , se, => . Quelli. la quantità di informazioni ricevute avrà valore positivo se, a seguito della ricezione del messaggio, il numero di alternative in esame è diminuito, negativo se è aumentato.

Se il numero di alternative considerate a seguito della ricezione del messaggio viene dimezzato, ad es. , allora I=log2(2)=1 bit. In altre parole, ricevere 1 bit di informazione elimina dalla considerazione la metà delle opzioni equivalenti.

Consideriamo, ad esempio, un esperimento con un mazzo di 36 carte.

Riso. 4. Illustrazione per un esperimento con un mazzo di 36 carte.

Chiedi a qualcuno di prendere una carta dal mazzo. A noi interessa quale delle 36 carte ha tirato fuori. L'incertezza iniziale, calcolata utilizzando la formula (2), è H=log2(36)5,17 bit. Colui che pesca la carta ci comunica alcune informazioni. Utilizzando la formula (5), determiniamo quante informazioni riceviamo da questi messaggi:

Opzione A: “Questo è un cartellino rosso”.

I=log2(36/18)=log2(2)=1 bit (nel mazzo ci sono mezze carte rosse, l'incertezza è diminuita di 2 volte).

Opzione B: “Questa è una carta del seme di picche”.

I=log2(36/9)=log2(4)=2 bit (le carte di picche costituiscono un quarto del mazzo, l'incertezza è diminuita di 4 volte).

Opzione C. “Questa è una delle carte più alte: jack, regina, re o asso”.

I=log2(36)-log2(16)=5,17-4=1,17 bit (l'incertezza è diminuita di oltre la metà, quindi la quantità di informazioni ricevute è superiore a un bit).

Opzione D. “Questa è una carta dal mazzo”.

I=log2(36/36)=log2(1)=0 bit (l'incertezza non è diminuita - il messaggio non è informativo).

Opzione D. “Questa è la regina di picche”.

I=log2(36/1)=log2(36)=5,17 bit (incertezza completamente rimossa).

Entropia (teoria dell'informazione)

Entropia (informativo)- una misura del caos informativo, l'incertezza dell'aspetto di qualsiasi simbolo dell'alfabeto primario. In assenza di perdite di informazione, è numericamente uguale alla quantità di informazione per simbolo del messaggio trasmesso.

Ad esempio, nella sequenza di lettere che compongono una frase in russo, lettere diverse compaiono con frequenze diverse, quindi l'incertezza di occorrenza per alcune lettere è minore che per altre. Se teniamo conto che alcune combinazioni di lettere (in questo caso si parla di entropia N-esimo ordine, vedi) sono molto rari, allora l'incertezza si riduce ulteriormente.

Per illustrare il concetto di entropia dell'informazione si può anche ricorrere ad un esempio tratto dal campo dell'entropia termodinamica, chiamato demone di Maxwell. I concetti di informazione ed entropia hanno profondi legami tra loro, ma nonostante ciò, lo sviluppo delle teorie della meccanica statistica e della teoria dell'informazione ha richiesto molti anni per renderli coerenti tra loro.

Definizioni formali

| Determinazione utilizzando le proprie informazioni |

|

Puoi anche determinare l'entropia di una variabile casuale introducendo prima il concetto di distribuzione di una variabile casuale X, avente un numero finito di valori: IO(X) = − logaritmo P X (X).Allora l’entropia sarà definita come: L'unità di misura dell'informazione e dell'entropia dipende dalla base del logaritmo: bit, nat o hartley. |

Entropia dell'informazione per eventi casuali indipendenti X Con N stati possibili (da 1 a N) viene calcolato utilizzando la formula:

Questa quantità è anche chiamata entropia media del messaggio. La quantità si chiama entropia privata, solo caratterizzante io-proprietà.

Quindi, l’entropia dell’evento Xè la somma con segno opposto di tutti i prodotti delle relative frequenze di accadimento dell'evento io, moltiplicato per i propri logaritmi binari (la base 2 è stata scelta solo per comodità di lavorare con informazioni presentate in forma binaria). Questa definizione di eventi casuali discreti può essere estesa a una funzione di distribuzione di probabilità.

Generalmente B-entropia aria(Dove B uguale a 2, 3, ...) fonte con l'alfabeto originale e distribuzione di probabilità discreta dove P ioè la probabilità UN io (P io = P(UN io) ) è determinato dalla formula:

La definizione di entropia di Shannon è legata al concetto di entropia termodinamica. Boltzmann e Gibbs lo fecero ottimo lavoro in termodinamica statistica, che contribuì all'adozione della parola "entropia" in teoria dell'informazione. Esiste una connessione tra la termodinamica e l'entropia dell'informazione. Ad esempio, il demone di Maxwell contrappone anche l'entropia termodinamica all'informazione, e guadagnare qualsiasi quantità di informazione equivale a perdere entropia.

Definizione alternativa

Un altro modo per definire la funzione entropia è H ne è la prova Hè determinato univocamente (come affermato in precedenza) se e solo se H soddisfa le condizioni:

Proprietà

È importante ricordare che l'entropia è una quantità definita nel contesto di un modello probabilistico per un'origine dati. Ad esempio, lanciare una moneta ha entropia − 2 (0,5 log 2 0,5) = 1 bit per lancio (assumendo che sia indipendente). Una sorgente che genera una stringa composta solo dalle lettere “A” ha entropia zero: ![]() . Quindi, ad esempio, si può stabilire sperimentalmente che l'entropia Testo ingleseè 1,5 bit per simbolo, che ovviamente varierà per testi diversi. Il grado di entropia di una fonte di dati indica il numero medio di bit per elemento di dati richiesto per crittografarlo senza perdita di informazioni, con una codifica ottimale.

. Quindi, ad esempio, si può stabilire sperimentalmente che l'entropia Testo ingleseè 1,5 bit per simbolo, che ovviamente varierà per testi diversi. Il grado di entropia di una fonte di dati indica il numero medio di bit per elemento di dati richiesto per crittografarlo senza perdita di informazioni, con una codifica ottimale.

- Alcuni bit di dati potrebbero non contenere informazioni. Ad esempio, le strutture dati spesso memorizzano informazioni ridondanti o hanno sezioni identiche indipendentemente dalle informazioni nella struttura dati.

- La quantità di entropia non è sempre espressa come numero intero di bit.

Proprietà matematiche

Efficienza

L'alfabeto originale riscontrato nella pratica ha una distribuzione di probabilità tutt'altro che ottimale. Se l'alfabeto originale avesse N caratteri, allora può essere paragonato ad un “alfabeto ottimizzato” la cui distribuzione di probabilità è uniforme. Il rapporto entropico dell'alfabeto originale e ottimizzato è l'efficienza dell'alfabeto originale, che può essere espressa in percentuale.

Ne consegue che l'efficacia dell'alfabeto originale con N i simboli possono essere definiti semplicemente come uguali ai suoi N-entropia aria.

L'entropia limita il massimo possibile compressione senza perdita (o quasi), che può essere implementato utilizzando un insieme teoricamente tipico o, in pratica, la codifica Huffman, la codifica Lempel-Ziv-Welch o la codifica aritmetica.

Variazioni e generalizzazioni

Entropia condizionata

Se la sequenza dei caratteri dell’alfabeto non è indipendente (ad esempio, in francese la lettera “q” è quasi sempre seguita da “u”, e la parola “editoriale” nei giornali sovietici era solitamente seguita dalla parola “produzione” o “lavoro ”), la quantità di informazione trasportata dalla sequenza di tali simboli (e quindi l’entropia) è ovviamente minore. Per tenere conto di tali fatti, viene utilizzata l'entropia condizionale.

L'entropia condizionale del primo ordine (simile al modello di Markov del primo ordine) è l'entropia di un alfabeto in cui sono note le probabilità che una lettera appaia dopo l'altra (ovvero, le probabilità delle combinazioni di due lettere):

Dove ioè uno stato dipendente dal carattere precedente, e P io (J) - questa è la probabilità J, purché io era il personaggio precedente.

Quindi, per la lingua russa senza la lettera "".

Le perdite di informazione durante la trasmissione dei dati in un canale rumoroso sono completamente descritte attraverso entropie condizionali parziali e generali. A questo scopo, il cosiddetto matrici di canali. Quindi, per descrivere le perdite da parte della sorgente (cioè il segnale inviato è noto), viene considerata la probabilità condizionata di ricevere il simbolo da parte del ricevitore B J a condizione che il carattere sia stato inviato UN io. In questo caso la matrice dei canali ha la seguente forma:

| B 1 | B 2 | … | B J | … | B M | |

|---|---|---|---|---|---|---|

| UN 1 | … | … | ||||

| UN 2 | … | … | ||||

| … | … | … | … | … | … | … |

| UN io | … | … | ||||

| … | … | … | … | … | … | … |

| UN M | … | … |

Ovviamente, le probabilità situate sulla diagonale descrivono la probabilità ricezione corretta, e la somma di tutti gli elementi della colonna darà la probabilità che il simbolo corrispondente appaia sul lato ricevente - P(B J) . Perdite attribuibili a segnale trasmesso UN io, sono descritti attraverso l’entropia condizionata parziale:

Per calcolare le perdite di trasmissione di tutti i segnali, viene utilizzata l'entropia condizionale generale:

Significa entropia dal lato sorgente; l'entropia dal lato ricevente si considera in modo simile: invece che ovunque viene indicata (sommando gli elementi della retta si ottiene P(UN io) , e gli elementi diagonali indicano la probabilità che sia stato inviato esattamente il carattere ricevuto, cioè la probabilità di una trasmissione corretta).

Entropia reciproca

Entropia reciproca, o entropia sindacale, è destinato al calcolo dell'entropia dei sistemi interconnessi (l'entropia della occorrenza congiunta di messaggi statisticamente dipendenti) ed è indicato H(UNB) , Dove UN, come sempre, caratterizza il trasmettitore, e B- ricevitore.

La relazione tra i segnali trasmessi e ricevuti è descritta dalle probabilità di eventi congiunti P(UN io B J) , e per descrizione completa caratteristiche del canale, è richiesta una sola matrice:

| P(UN 1 B 1) | P(UN 1 B 2) | … | P(UN 1 B J) | … | P(UN 1 B M) |

| P(UN 2 B 1) | P(UN 2 B 2) | … | P(UN 2 B J) | … | P(UN 2 B M) |

| … | … | … | … | … | … |

| P(UN io B 1) | P(UN io B 2) | … | P(UN io B J) | … | P(UN io B M) |

| … | … | … | … | … | … |

| P(UN M B 1) | P(UN M B 2) | … | P(UN M B J) | … | P(UN M B M) |

Per più caso generale, quando non si tratta di un canale che viene descritto, ma semplicemente di sistemi interagenti, la matrice non deve essere quadrata. Ovviamente, la somma di tutti gli elementi della colonna con numero J darà P(B J) , la somma del numero di riga io C'è P(UN io) e la somma di tutti gli elementi della matrice è uguale a 1. Probabilità congiunta P(UN io B J) eventi UN io E B Jè calcolato come il prodotto della probabilità originaria e condizionata,

Le probabilità condizionate vengono prodotte utilizzando la formula di Bayes. Quindi, ci sono tutti i dati per calcolare le entropie della sorgente e del ricevitore:

L'entropia reciproca viene calcolata sommando sequenzialmente su righe (o colonne) tutte le probabilità della matrice, moltiplicate per il loro logaritmo:

| H(UNB) = − | ∑ | ∑ | P(UN io B J)tronco d'albero P(UN io B J). |

| io | J |

L'unità di misura è bit/due simboli, ciò è spiegato dal fatto che l'entropia reciproca descrive l'incertezza per coppia di simboli - inviati e ricevuti. Con semplici trasformazioni otteniamo anche

L'entropia reciproca ha la proprietà completezza delle informazioni- da esso si possono ricavare tutte le quantità in esame.

Storia

Appunti

Guarda anche

Collegamenti

- Claude E. Shannon. Una teoria matematica di comunicazione

- S. M. Korotaev.

1) Approccio sistematico allo studio della medicina. Il concetto di sistema. Proprietà del sistema. Esempi di sistemi medici.

Un approccio sistemico, una direzione nella metodologia della conoscenza scientifica speciale e della pratica sociale, che si basa sullo studio degli oggetti come sistemi.

Sistema- un insieme di elementi che sono in relazione e connessione tra loro, che forma una certa integrità, unità.

proprietà comuni a tutti i sistemi:

Integrità- un sistema è un'entità astratta che ha integrità ed è definita entro i suoi confini. L'integrità del sistema implica che in qualche aspetto essenziale la "forza" o il "valore" delle connessioni degli elementi all'interno del sistema superiore alla forza o al valore delle connessioni tra elementi ed elementi del sistema sistemi esterni O ambiente.

Sinergia, emergenza, olismo, effetto di sistema- la comparsa di proprietà nel sistema che non sono inerenti agli elementi del sistema; l'irriducibilità fondamentale delle proprietà di un sistema alla somma delle proprietà dei suoi componenti costitutivi. Le capacità del sistema superano la somma delle capacità delle sue parti costituenti; la prestazione complessiva o la funzionalità di un sistema è migliore della semplice somma dei suoi elementi.

Gerarchia- ogni elemento del sistema può essere considerato come un sistema; il sistema stesso può anche essere considerato un elemento di un supersistema (supersistema).

I sistemi esperti sono una descrizione logica della struttura e del contenuto della conoscenza medica utilizzando un sistema di regole di produzione (regole logiche di inferenza).

Consulenze in un'area specifica ad un livello di conoscenza superiore a quello dell'utente; - applicazione delle tecnologie informatiche" intelligenza artificiale"; - formazione di una base di conoscenza sotto forma di sistemi di regole euristiche; - spiegazione della motivazione nel processo di acquisizione di una decisione.

Sistemi informativi medici (MIS). In base al loro scopo, questi sistemi si dividono in tre gruppi: 1) sistemi la cui funzione principale è l'accumulo di dati e informazioni

2) sistemi di diagnosi e consulenza

3) sistemi che forniscono assistenza medica

Sistema informativo medico (MIS) - un insieme di strumenti informativi, organizzativi, software e tecnici progettati per automatizzare i processi e (o) le organizzazioni mediche

Obiettivi dei sistemi informativi medici

Raccolta dati

Registrazione e documentazione dei dati

Garantire lo scambio di informazioni

Monitoraggio del decorso della malattia (controllo medico)

Monitoraggio dell'implementazione della tecnologia per il processo diagnostico e terapeutico (controllo tecnologico)

Archiviazione e recupero delle informazioni (archiviazione)

Analisi dei dati

Supporto decisionale

Formazione

2. Sistema medico come sistema di controllo. Il principio del feedback nei sistemi di controllo. Il posto dei metodi e degli strumenti informatici in un sistema di gestione medica.

Teoria del controllo- la scienza dei principi e dei metodi di gestione di vari sistemi, processi e oggetti. I fondamenti della teoria del controllo sono la cibernetica (la scienza delle leggi generali dei processi di controllo e del trasferimento di informazioni in vari sistemi, siano essi macchine, organismi viventi o società) e la teoria dell'informazione.

Il processo di gestione può essere suddiviso in più fasi:

1. Raccolta ed elaborazione delle informazioni.

2. Analisi, sistematizzazione, sintesi.

3. Stabilire gli obiettivi su questa base. Scelta del metodo di gestione, previsione.

4. Attuazione del metodo di gestione selezionato.

5. Valutazione dell'efficacia del metodo di gestione selezionato (feedback).

Lo scopo ultimo della teoria del controllo è l’universalizzazione, e quindi la coerenza, l’ottimizzazione e la massima efficienza nel funzionamento dei sistemi.

Metodi di gestione considerati dalla teoria del management sistemi tecnici e altri oggetti si basano su tre principi fondamentali:

1. Il principio del controllo (software) ad anello aperto,

2. Principio di compensazione (controllo dei disturbi)

3. Principio del feedback.

La gestione può essere divisa in due tipologie:

spontaneo: l'impatto avviene come risultato dell'interazione dei soggetti (gestione sinergica);

cosciente: influenza sistematica dell'oggetto (controllo gerarchico).

Con il controllo gerarchico, l’obiettivo del funzionamento del sistema è fissato dal suo supersistema.

La cibernetica medica è un campo scientifico associato all'uso di idee, metodi e mezzi tecnici cibernetica in medicina e sanità.

Convenzionalmente, la cibernetica medica può essere rappresentata dai seguenti gruppi:

Diagnosi computazionale delle malattie

Questa parte è legata all'uso della tecnologia informatica nell'elaborazione delle informazioni provenienti da un oggetto biologico allo scopo di fare una diagnosi. Il primo passo è sviluppare metodi per descrivere formalmente lo stato di salute del paziente, conducendo un'analisi approfondita per chiarire i parametri clinici e i segni utilizzati nella diagnosi. Qui, le caratteristiche più importanti sono quelle che portano valutazioni quantitative. Oltre all'espressione quantitativa delle caratteristiche fisiologiche, biochimiche e di altro tipo del paziente, la diagnostica computazionale richiede informazioni sulla frequenza delle sindromi cliniche (da dati a priori) e segni diagnostici sulla loro classificazione, valutazione dell'efficacia diagnostica, ecc.

Sistemi di controllo automatizzato e possibilità di utilizzarli per l'organizzazione dell'assistenza sanitaria e io.

L’obiettivo qui è creare sistemi automatizzati industriali (OSAU). Tali sistemi sono creati per un settore così importante come l'assistenza sanitaria. La particolarità dell'OSAU in ambito sanitario è che deve comprendere sia un'unità di controllo che altri elementi: prevenzione, cura (con diagnostica), scienza medica, personale e supporto materiale. I compiti principali dell'OSAU “Sanità” comprendono l'automazione dei processi di raccolta e analisi delle informazioni statistiche nelle principali aree dell'attività medica e l'ottimizzazione di alcuni processi di gestione.

3. Il concetto di entropia dell'informazione.

Entropia (informazione) - una misura del caos dell'informazione, dell'incertezza dell'aspetto di qualsiasi simbolo dell'alfabeto primario. In assenza di perdite di informazione, è numericamente uguale alla quantità di informazione per simbolo del messaggio trasmesso.

Prendiamo quindi ad esempio una sequenza di caratteri che compongono una frase in russo. Ogni personaggio appare con una frequenza diversa, quindi l'incertezza della comparsa di alcuni personaggi è maggiore che di altri. Se si tiene conto che alcune combinazioni di simboli sono molto rare, l’incertezza si riduce ulteriormente.

I concetti di informazione ed entropia hanno profondi legami tra loro, ma nonostante ciò, lo sviluppo delle teorie della meccanica statistica e della teoria dell'informazione ha richiesto molti anni per renderli coerenti tra loro.

L'introduzione del concetto di entropia si basa sull'uso di una misura di probabilità varie esperienze. Per ottenere la formula dell'entropia dell'informazione, è possibile utilizzare la seguente tecnica. Sia una sequenza di N eventi (ad esempio, un testo di N lettere), ciascuno dei quali occupa uno degli M stati (M ¾ il numero di lettere dell'alfabeto). Poi . Troviamo la probabilità di manifestazione di questo stato per una catena di eventi sufficientemente lunga come, i=1, ¼ , M. Numero totale diverse sequenze di N lettere dell'alfabeto delle lettere M ![]() . Formalmente, il verificarsi di ciascuna delle sequenze R è ugualmente probabile, pertanto, per determinare la quantità di informazioni in tale catena di eventi, utilizziamo la formula di Hartley per risultati ugualmente probabili (1). Nel nostro caso, tutti gli N e tutti gli N i sono sufficientemente grandi, poiché solo allora tutti i pi come probabilità hanno senso. Pertanto, applichiamo la trasformata di Stirling in modo simile a come viene eseguita nella fisica statistica. Utilizzando tutte le premesse indicate e riducendo il logaritmo (1) a base naturale, otteniamo la formula di Shannon

. Formalmente, il verificarsi di ciascuna delle sequenze R è ugualmente probabile, pertanto, per determinare la quantità di informazioni in tale catena di eventi, utilizziamo la formula di Hartley per risultati ugualmente probabili (1). Nel nostro caso, tutti gli N e tutti gli N i sono sufficientemente grandi, poiché solo allora tutti i pi come probabilità hanno senso. Pertanto, applichiamo la trasformata di Stirling in modo simile a come viene eseguita nella fisica statistica. Utilizzando tutte le premesse indicate e riducendo il logaritmo (1) a base naturale, otteniamo la formula di Shannon ![]() ¾ entropia dell'informazione per ciascuno degli M stati possibili.

¾ entropia dell'informazione per ciascuno degli M stati possibili.

In futuro, il concetto di entropia potrà essere applicato per risolvere problemi di calcolo dell'incertezza (e quindi del carico di informazioni) di vari esperimenti. Se l'informazione ricevuta rimuove completamente l'incertezza dell'esperienza, la sua quantità è considerata pari all'entropia dell'esperienza data. Pertanto, l'uso del concetto di entropia può servire a determinare il valore di varie previsioni. E ancora più interessante e utile è l'utilizzo del concetto di entropia (da un punto di vista pratico) per stabilire un criterio per valutare l'efficienza del codice reale e come strumento per sviluppare codici economici.

5. Concetti fondamentali dei processi informativi di base: memorizzazione, trasmissione, elaborazione dell'informazione.

Processo informativo: il processo di ricezione, creazione, raccolta, in lavorazione, accumuli, magazzinaggio, ricerca, trasferimenti e uso delle informazioni.

Qualunque sia attività informative le persone non sono state coinvolte, tutto si riduce all'implementazione di tre processi: archiviazione, trasmissione ed elaborazione delle informazioni. Questi processi sono chiamati di base.

Magazzinaggio

La memorizzazione delle informazioni dovrebbe essere intesa come il contenuto delle informazioni in memoria esterna computer.

L'archiviazione delle informazioni è associata a concetti come supporto di archiviazione delle informazioni, memoria interna, memoria esterna e archiviazione delle informazioni. Il vettore delle informazioni è ambiente fisico, che memorizza direttamente le informazioni. Il principale vettore di informazioni per una persona è la sua memoria biologica (il cervello umano). Può essere chiamata memoria interna. Tutti gli altri tipi di portatori di informazioni possono essere definiti esterni (in relazione a una persona).

Un magazzino di informazioni è una raccolta di dati organizzati in un certo modo su supporti esterni, destinati alla conservazione a lungo termine e all'uso costante. Esempi di strutture di stoccaggio sono archivi di documenti, biblioteche, libri di consultazione e schedari. L'unità informativa principale del repository è un documento fisico specifico: un questionario, un libro, un file, un dossier, un rapporto, ecc. L'organizzazione del repository implica la presenza di una determinata struttura, ad es. ordine, classificazione dei documenti archiviati. Tale organizzazione è necessaria per la comodità di mantenere il repository: riempirlo con nuovi documenti, eliminare documenti non necessari, cercare informazioni, ecc.

Le proprietà principali di un repository di informazioni sono il volume delle informazioni archiviate, l'affidabilità dell'archiviazione, il tempo di accesso e la disponibilità della protezione delle informazioni.

Le informazioni archiviate sui dispositivi di memoria del computer vengono comunemente chiamate dati. L'archiviazione organizzata dei dati sui dispositivi di memoria esterni del computer è solitamente chiamata database.

Nei computer moderni, i principali supporti di memorizzazione per la memoria esterna sono i dischi magnetici e ottici.

Unità di archiviazione dati. Quando si archiviano i dati, vengono risolti due problemi: come archiviare i dati nella forma più compatta e come fornirne un accesso comodo e rapido. Per garantire l'accesso, è necessario che i dati abbiano una struttura ordinata e allo stesso tempo è necessario registrare ulteriormente i dati dell'indirizzo. Senza di essi è impossibile accedere ai dati necessari inclusi nella struttura.

Poiché anche i dati degli indirizzi hanno una dimensione e devono essere memorizzati, la memorizzazione dei dati in unità piccole come i byte è scomoda. È anche scomodo archiviarli in unità più grandi (kilobyte, megabyte, ecc.), poiché il riempimento incompleto di un'unità di archiviazione porta a un'inefficienza di archiviazione.

Un oggetto viene considerato un'unità di memorizzazione dei dati lunghezza variabile chiamato file. Un file è una sequenza di un numero arbitrario di byte con un nome univoco. Di solito dentro fascicolo separato memorizzare dati appartenenti allo stesso tipo. In questo caso, il tipo di dati determina il tipo di file.

Trasmissione

Il processo di trasporto delle informazioni è considerato nel quadro di un modello di riferimento a sette livelli noto come Modello OSI(Interconnessione di sistemi aperti: comunicazione sistemi aperti). Molta attenzione viene prestata ai protocolli a vari livelli, fornendo il necessario livello di standardizzazione:

1. Livello inferiore (canale e fisico Livelli OSI ad esempio NDIS, ODI)

2. Strato intermedio (strati di rete, trasporto e sessione OSI, come protocolli di sessione e datagramma)

3. Livello superiore (livello di presentazione e livello di applicazione OSI)

Lo strato fisico implementa il controllo fisico e si riferisce al circuito fisico, come il circuito telefonico, su cui vengono trasmesse le informazioni. A questo livello, il modello OSI definisce le caratteristiche fisiche, elettriche, funzionali e procedurali dei circuiti di comunicazione, nonché i requisiti per adattatori di rete e modem.

Livello di collegamento dati. A questo livello, il collegamento di rete (canale) viene controllato e viene implementato il trasferimento di blocchi (insiemi di bit) di informazioni lungo il collegamento fisico. Esegue procedure di controllo come la determinazione dell'inizio e della fine di un blocco, il rilevamento di errori di trasmissione, l'indirizzamento di messaggi, ecc.

Lo strato di rete si riferisce a un circuito virtuale (immaginario) che non deve necessariamente esistere fisicamente. Gli strumenti software a questo livello forniscono la determinazione del percorso per la trasmissione dei pacchetti nella rete. I router che cercano il percorso ottimale in base all'analisi delle informazioni sugli indirizzi operano a livello di rete del modello OSI, chiamato bridge.

Strato di trasporto. A livello di trasporto viene controllato l'ordine dei pacchetti di messaggi e la loro identità. Pertanto, nel processo di scambio tra computer, viene mantenuta una connessione virtuale, simile alla commutazione telefonica.

Livello di sessione. SU questo livello i processi di instaurazione di una sessione, di gestione della trasmissione e ricezione dei pacchetti di messaggi e di conclusione della sessione sono coordinati e standardizzati. Software Questo livello esegue le conversioni dei dati dal formato interno del computer mittente al formato interno del computer ricevente, se questi formati differiscono tra loro. Oltre alla conversione dei formati, a questo livello i dati trasmessi vengono compressi e decompressi.

Il livello applicativo si riferisce a funzioni che forniscono supporto all'utente a livelli applicativi e di sistema più elevati, ad esempio: organizzazione dell'accesso al comune risorse di rete: informazione, memoria del disco, applicazioni software, dispositivi esterni (stampanti, streamer, ecc.); gestione generale rete (gestione della configurazione, controllo degli accessi risorse condivise reti, ripristino dopo guasti e guasti, gestione delle prestazioni); trasmissione di messaggi elettronici.

Trattamento

L'elaborazione dell'informazione si riferisce alla sua trasformazione al fine di prepararla per l'uso pratico. Talvolta il trattamento delle informazioni viene definito come dati operativi secondo determinate regole.

Nel processo di elaborazione delle informazioni, viene sempre risolto qualche compito informativo, che consiste nell'ottenere informazioni finali sulla base dei dati iniziali. Il processo di transizione dai dati iniziali al risultato è l'elaborazione delle informazioni. Il soggetto che effettua il trattamento è l'esecutore del trattamento. L'esecutore può essere una persona o un dispositivo tecnico speciale, compreso un computer.

In genere, l'elaborazione delle informazioni è un processo diretto agli obiettivi. Per eseguire con successo l'elaborazione delle informazioni, l'esecutore deve conoscere il metodo di elaborazione, ad es. la sequenza di azioni che devono essere eseguite per ottenere il risultato desiderato. La descrizione di tale sequenza di azioni in informatica è solitamente chiamata algoritmo di elaborazione.

In genere, esistono due tipi di situazioni di elaborazione delle informazioni.

Il primo tipo è l'elaborazione associata all'ottenimento di nuovi contenuti di conoscenza. Questo tipo di elaborazione include la risoluzione di problemi matematici. Metodo di elaborazione, ad es. l'algoritmo per risolvere il problema è determinato da formule matematiche note all'esecutore. Questo tipo di elaborazione delle informazioni include la risoluzione di vari problemi attraverso l'uso del ragionamento logico.

Il secondo tipo è l'elaborazione associata alla modifica del modulo, ma non alla modifica del contenuto. Questo tipo di trattamento delle informazioni comprende, ad esempio, la traduzione di testi da una lingua all'altra. La forma cambia, ma il contenuto deve restare lo stesso. Un tipo di elaborazione importante per l'informatica è codifica. La codifica è la trasformazione delle informazioni in una forma simbolica conveniente per la loro memorizzazione, trasmissione ed elaborazione. La codifica viene utilizzata attivamente nei mezzi tecnici per lavorare con le informazioni (telegrafo, radio, computer).

L'elaborazione delle informazioni include la strutturazione dei dati. La strutturazione è associata all'introduzione di un determinato ordine, di una determinata organizzazione nel repository di informazioni. Esempi di strutturazione includono la disposizione dei dati in ordine alfabetico, il raggruppamento secondo determinati criteri di classificazione e l'utilizzo di una presentazione tabellare.

Un altro vista importante elaborazione delle informazioni - ricerca. L'attività di ricerca consiste nel selezionare le informazioni necessarie che soddisfano determinate condizioni di ricerca nel repository di informazioni esistente. L'algoritmo di ricerca dipende dal modo in cui sono organizzate le informazioni. Se l'informazione è strutturata, la ricerca è più veloce ed è possibile costruire un algoritmo ottimale.

Pertanto, a seconda dello scopo del trattamento delle informazioni, la forma della loro presentazione o il loro contenuto possono cambiare. I processi di modifica della forma di presentazione delle informazioni spesso si riducono ai processi di codifica e decodifica e si svolgono contemporaneamente ai processi di raccolta e trasmissione delle informazioni. Il processo di modifica del contenuto delle informazioni include procedure come calcoli numerici, modifica, ordinamento, generalizzazione, sistematizzazione, ecc. Se le regole per la conversione delle informazioni sono rigorosamente formalizzate e esiste un algoritmo per la loro implementazione, è possibile costruire un dispositivo per l'elaborazione automatizzata delle informazioni.

Vale la pena menzionare l'eterogeneità delle risorse informative, caratteristica di molte aree tematiche. Un modo per risolvere questo problema è approccio orientato agli oggetti, il più comune attualmente. Consideriamo brevemente le sue principali disposizioni. Basato sulla decomposizione approccio orientato agli oggetti si basa sull'identificazione dei seguenti concetti base: oggetto, classe, istanza.

Un oggettoè un'astrazione di molti oggetti nel mondo reale che hanno le stesse caratteristiche e leggi di comportamento. L'oggetto caratterizza un tipico elemento indefinito di tale insieme. La caratteristica principale di un oggetto è la composizione dei suoi attributi (proprietà).

Attributi- si tratta di oggetti speciali attraverso i quali è possibile impostare regole per descrivere le proprietà di altri oggetti.

Istanza dell'oggettoè un elemento specifico di un insieme. Ad esempio, un oggetto potrebbe essere la targa di un'auto e un'istanza di questo oggetto potrebbe essere un numero specifico K 173 PA.

Classe- questo è un insieme di oggetti del mondo reale, collegati da una struttura e un comportamento comuni. Elemento di classeè un elemento specifico di un dato insieme. Ad esempio, una classe di targhe automobilistiche.

Le informazioni vengono trasmesse sotto forma di segnali. Un segnale è un processo fisico che trasporta informazioni. Il segnale può essere sonoro, luminoso, sotto forma di invio postale, ecc.

Per tipi (tipi) di segnali si distinguono:

analogico

digitale

discreto

Segnale analogico:

Il segnale analogico è naturale. Può essere risolto utilizzando vari tipi sensori Ad esempio, sensori ambientali (pressione, umidità) o sensori meccanici (accelerazione, velocità)

Segnale digitale:

I segnali digitali sono artificiali, cioè possono essere ottenuti solo convertendo un segnale elettrico analogico.

Segnale discreto:

Un segnale discreto è lo stesso segnale analogico convertito, solo che non è necessariamente quantizzato in livello.

Campionamento- trasformazione del continuo funzioni V discreto.

Usato in sistemi informatici ibridi e dispositivi digitali con codice a impulsi modulazione segnali nei sistemi di trasmissione dati . Quando si trasmettono immagini, vengono utilizzate per trasformare un continuo segnale analogico in un segnale discreto o discreto-continuo.

7. Codificazione delle informazioni. Alfabeto. Parola. Dizionario. Codifica binaria.

1. La codifica delle informazioni viene solitamente utilizzata per trasformare i messaggi da una forma conveniente per l'uso immediato in una forma conveniente per la trasmissione, l'archiviazione o l'elaborazione automatica

Qualsiasi informazione con cui funziona la moderna tecnologia informatica viene convertita in numeri sistema binario Resa dei conti.

Il fatto è che i dispositivi fisici (registri, celle di memoria) possono trovarsi in due stati, che sono associati a 0 o 1. Utilizzando un numero di simili dispositivi fisici, puoi memorizzare quasi tutti i numeri del sistema di numerazione binario nella memoria del tuo computer. La codifica computerizzata di numeri interi, numeri frazionari e negativi, nonché simboli (lettere, ecc.) ha le proprie caratteristiche per ciascun tipo. Tuttavia, dovresti sempre ricordare che qualsiasi informazione (numerica, testo, grafica, suono, ecc.) nella memoria del computer è rappresentata come numeri nel sistema di numerazione binario (quasi sempre). IN in senso generale La codifica dell'informazione può essere definita come la traduzione dell'informazione rappresentata da un messaggio dell'alfabeto primario in una sequenza di codici.

In genere, i messaggi vengono trasmessi e registrati utilizzando una determinata sequenza di simboli: segni.