ارسال کار خوب خود در پایگاه دانش ساده است. از فرم زیر استفاده کنید

دانشجویان، دانشجویان تحصیلات تکمیلی، دانشمندان جوانی که از دانش پایه در تحصیل و کار خود استفاده می کنند از شما بسیار سپاسگزار خواهند بود.

در توجیه معیار لگاریتمی اطلاعات

نظریه اطلاعات اکنون از چارچوب محدود سیستم های ارتباطی فراتر رفته است، جایی که در ابتدا مورد استفاده قرار می گرفت، و به طور گسترده در زمینه های غیر سنتی مانند فیزیک، نظریه سیستم ها، نظریه کنترل، زیست شناسی و ریاضیات استفاده می شود. کاربرد بسیار گستردهای در زمینههای نسبتاً جدید علوم مانند علوم رایانه، تئوری خودکار و حفاظت از دادهها پیدا کرده است.

بنابراین، تجزیه و تحلیل بیشتر مبانی نظریه اطلاعات به منظور نفوذ به ماهیت آن، که امروزه هنوز تا حد زیادی مرموز باقی مانده است، و شناسایی احتمالات جدید برای کاربرد آن برای حل مسائل عملی ضروری است.

مهمترین مسئله ای که این یا آن نظریه اطلاعات بر اساس آن ساخته می شود، انتخاب معیار اطلاعات است.

تا حد زیادی توسط اشیایی تعیین می شود که تئوری در حال توسعه برای تجزیه و تحلیل هدف قرار می گیرد.

در حال حاضر، در تئوری اطلاعات، معیارهای هارتلی و شانون بسیار گسترده هستند و در برخی موارد معیار هارتلی به صورت مورد خاصشانون اقداماتی انجام می دهد.

با این حال، معیار هارتلی از نظر هدف، تفاوت قابل توجهی با معیار شانون دارد، زیرا هدف اول مطالعه فرآیندهای قطعی (غیر احتمالی) با طول محدود است و دومی با هدف تجزیه و تحلیل است. فرآیندهای احتمالیبا هر مدت زمانی که برای تجزیه و تحلیل آن از روش های آماری استفاده می شود.

بر این اساس، نظریه اطلاعاتی که از یکی از این معیارها استفاده می کند، نظریه اطلاعات ساختاری یا آماری نامیده می شود.

محدود بودن طول آرایه های داده های تجزیه و تحلیل شده، بر این اساس، به امکان محاسبه تعداد آنها با جستجوی ساده یا استفاده از هر یک منجر می شود. روش های ریاضیو همچنین استفاده از روش های غیر احتمالی شناخته شده برای تجزیه و تحلیل اطلاعات، به عنوان مثال، نظریه محمولات محدود یا نظریه گروه. در نتیجه، نظریه اطلاعات ساختاری امروزی روشهای کدگذاری را توسعه داده است که نمیتوان آنها را بر اساس نظریه اطلاعات آماری توسعه داد.

در عین حال، نظریه آماری به دست آوردن قضایای حدی و رفتار را ممکن میسازد تجزیه و تحلیل اطلاعاتپیام ها بر اساس مجموعه داده های آماری، به جای تجزیه و تحلیل هر پیام به طور جداگانه، همانطور که در نظریه اطلاعات ساختاری اتفاق می افتد.

اندازهگیری لگاریتمی زیربنای نظریه ساختاری اطلاعات، کجا و در کجا وجود دارد اعداد مثبتبا طول محدود، نه برابر با 0، و نه برابر با 1، که توسط هارتلی در سال 1928 پیشنهاد شد، از نظر منطقی توسط او توجیه نشد، اما بر اساس ملاحظات شهودی معرفی شد. علاوه بر این، آنچه که قابل توجه است، در این شکل می تواند هر دو ارزش مثبت، در، و منفی، در، را داشته باشد.

در حال حاضر، با خاصیت افزودنی آن توجیه می شود که در این واقعیت آشکار می شود اطلاعات کلی، به طور مشترک توسط دو منبع اطلاعات تولید می شود و برابر است با مجموع اطلاعات فردی و از هر یک از آنها، به عنوان مثال، در.

در واقع، اگر هر یک از دو منبع به ترتیب پیامهایی تولید کنند، تعداد کل آنها خواهد بود

با گرفتن لگاریتم بیان (1)، برابری را بدست می آوریم

که خاصیت افزایشی معیار اطلاعات هارتلی را ثابت می کند.

بیایید توجیه دیگری برای معیار هارتلی در رابطه با مشکلات جستجو (پیوسته و گسسته) در نظر بگیریم.

یکی از ویژگیهای مسائل جستجوی گسسته، محدود بودن مجموعه اولیه اشیاء است که با احتمال مساوی نشان میدهند. راه حل های امکان پذیرمشکلات جستجوی گسسته، که یکی از آنها قرار است یکی از آنها باشد. جستجوی آن در فرآیند حل یک مشکل گسسته انجام می شود، به عنوان مثال، در مسئله معروف فروشنده دوره گرد اتفاق می افتد.

در این مسئله، شی مورد نیاز مسیری با حداقل طول است که از تعدادی محدود اولیه مسیرهای ممکن انتخاب شده است.

راه حل این مشکلات به یک روش یا روش دیگر در فرآیند پارتیشن بندی متوالی مجموعه اصلی اشیاء ممکن است - راه حل ها به کلاس های هم ارزی و آزمایش هر یک از آنها برای وجود شی مورد نظر در آن. در طول فرآیند آزمایش، عدم قطعیت در مورد وجود شی مورد نظر حذف می شود، همراه با تولید مقدار مناسبی از اطلاعات.

یک مورد خاص از پارتیشن بندی زمانی خواهد بود که اشیاء ممکن اولیه به کلاس های هم ارزی تقسیم شوند به طوری که دارای تعداد کاملاً مساوی از اشیاء کامل باشند.

بدیهی است که چنین پارتیشن هایی فقط در صورتی امکان پذیر است که

که در آن حداکثر تعداد تقسیمات قبل از ظاهر شدن یک کلاس با یک شی است.

اگر اندازه اطلاعات را در این مورد بگیریم، آنگاه دقیقاً با معیار لگاریتمی هارتلی که در پایه گرفته شده است، مطابقت دارد:

بنابراین، تعداد پارتیشن ها در طول یک جستجوی گسسته به همان اندازه محتمل برای یک شی در میان موارد ممکن، معیار لگاریتمی اطلاعات هارتلی است و برعکس، معیار هارتلی برای مورد مورد بررسی تعداد پارتیشن های یکنواخت مجموعه ای از اشیاء را به صورت معادل نشان می دهد. کلاس ها تا زمانی که یک شی مورد جستجو ظاهر شود.

که در مورد کلیهنگام تقسیم مجموعه اصلی متشکل از اشیاء به کلاس های معادل، هر یک از آنها ممکن است شامل اشیاء باشد و بر این اساس، احتمال یافتن شی مورد نظر در یک کلاس یا کلاس دیگر برابر است با

که در آن.

فرمول شانون برای آنتروپی، که اندازه گیری عدم قطعیت یافتن شی مورد نظر در یک کلاس هم ارزی خاص را قبل از آزمایش، در طول اولین پارتیشن تعیین می کند.

جایی که بیان می کند که مقدار آنتروپی برای اولین پارتیشن به حداکثر می رسد

زمانی که شی مورد نظر در کلاس های هم ارزی با احتمالات مساوی یافت می شود

در این مورد.

به ترتیب بیشترین مقداراطلاعات تولید شده توسط آزمون در فرآیند حذف آنتروپی نیز برابر با این مقدار خواهد بود

به همین ترتیب، در پارتیشن های باقی مانده، اگر احتمالات یافتن شی مورد نظر در کلاس های هم ارزی جدید برابر باشد، حداکثر مقدار اطلاعات برابر با 1 به دست می آید.

از این نتیجه می شود که برای دستیابی به حداکثر اطلاعات تولید شده توسط آزمون، لازم است، در فرآیند پارتیشن بندی مجموعه ای از اشیاء، آنها را به کلاس های هم ارزی با تعداد مساوی از اشیاء در هر یک از آنها تقسیم کنیم.

از آنجایی که معیار هارتلی، در رابطه با مسئله مورد بررسی، دقیقاً از چنین پارتیشنهایی استفاده میکند، به این معنی است که حداکثر مقدار ممکن اطلاعات بهدستآمده در فرآیند جستجوی یک شی گسسته را تعیین میکند، و از آنجایی که چنین است، پس تعداد پارتیشن ها و بر این اساس، زمان جستجو باید در مقایسه با سایر پارتیشن های ممکن حداقل باشد. این دقیقاً ویژگی اساسی معیار اطلاعات هارتلی است.

در شکل شکل 1 درختی را با 3 پارتیشن یکنواخت در 2 کلاس هم ارزی از اشیاء اصلی نشان می دهد. در رئوس آن تعداد اشیاء موجود در طبقات هم ارزی حاصل نشان داده شده است. در این حالت، حداکثر مقدار اطلاعات در هر راس تولید می شود

در مجموع تمام پارتیشن ها جزء بیت.

شکل 1 - درخت پارتیشن های یکنواخت با

بدیهی است که تعداد پارتیشن های یکنواخت برای این مورد حداقل است.

درخت پارتیشن دیگری در شکل. 2 برای پارتیشن های ناهموار اشیاء در 2 کلاس هم ارزی دارای میانگین تعداد پارتیشن ها در همه است. راه های ممکنپارتیشن ها

که از میانگین تعداد پارتیشن ها برابر با نمونه قبلی بیشتر است.

این به دلیل این واقعیت است که مقدار اطلاعات تولید شده در هر پارتیشن مطابق با فرمول شانون (6) کمتر از 1 بیت است، یعنی زمان جستجو برای شی مورد نظر حداقل نیست.

در این مورد، قانون اساسی باید رعایت شود بازیابی اطلاعات، که به صورت زیر فرموله می کنیم.

مقدار اطلاعات مورد نیاز برای جستجوی یک شی مورد نظر کامل به روش تقسیم مجموعه اصلی اشیاء به کلاس های هم ارزی بستگی ندارد و ثابت و مساوی می ماند.

این بدان معنی است که مهم نیست درخت پارتیشن های مجموعه اصلی اشیاء چیست، مقدار اطلاعات مورد نیاز برای یافتن یکی از آنها همیشه یکسان خواهد بود - .

شکل 2 - درخت پارتیشن های ناهموار برای، و

تقسیم بندی به کلاس های هم ارزی در عمل گسترده است. بنابراین، آنها بر اساس کدگذاری موقعیتی کلمات و اعداد هستند، که در فرآیند تقسیمبندی متوالی مجموعههای اصلی آنها به کلاسهای معادل با استفاده از حروف و اعدادی که ویژگیهای این کلاسها را نشان میدهند، رخ میدهد. در مجموع، این حروف و اعداد الفبا را تشکیل می دهند و عددی که مجموعه های اولیه کلمات و اعداد به آن تقسیم می شوند نشان دهنده قدرت این حروف الفبا است. تعداد تقسیم ها طول کلمات و اعداد را تعیین می کند.

در نتیجه، هر حرف یا رقم یک کلمه یا عدد نشان دهنده کلاس معادلی است که در یک پارتیشن خاص به آن تعلق دارد.

عبارت اصلی برای نظریه اطلاعات ارائه شده توسط شانون است

در رابطه با مسئله جستجو بیان می کند که مقدار اطلاعات تولید شده در فرآیند آن برابر با تفاوت بین آنتروپی اولیه است.

شی مورد نظر و باقیمانده

تعداد باقیمانده اشیایی که در میان آنها مورد نظر وجود دارد، کجاست.

بدیهی است که در فرآیند تقسیم و آزمایش، تعداد کاهش می یابد و در نهایت چه زمانی

آخرین عبارت بیانگر یک شرط مهم است که به عنوان اصل وحدت فرموله شده است.

ماهیت آن به این خلاصه می شود که اطلاعات کاملاطلاعات در مورد یک شی به دست می آید اگر و تنها در صورتی که یک شی کامل در طول فرآیند جستجو پیدا شود.

اگر، پس این نشان می دهد که اطلاعات مربوط به شی تا حدی به گیرنده منتقل شده است.

یک مورد خاص برای آن وجود خواهد داشت. برای او می پذیرد معنی منفی- و به همین ترتیب

این بدان معنی است که در مورد مورد بررسی، زمانی که آزمایش تولید می کند اطلاعات تکمیلیدر مورد جزئیات یک شی که اکنون به کلاس های هم ارزی جدید و قبلا ناشناخته تعلق دارد. این روش برای جزئیات یک شی می تواند به طور نامحدود ادامه یابد. به عنوان مثال، در درخت پارتیشن در شکل. 1 بعد از رأس (کلاس معادل)، که بعد از پارتیشن سوم یک شی را شامل می شود، می تواند رئوس حاوی 0.5 شی (پارتیشن چهارم)، سپس 0.25 و غیره باشد. هر بار مقدار اطلاعات مربوط به شی 1 بیت افزایش می یابد و می تواند به هر مقداری برسد.

این رویه این واقعیت شناخته شده در علم را تأیید می کند که هر شیئی می تواند به طور نامحدود قابل شناخت باشد، با این حال، اصل وحدت نقض می شود، زیرا و بر این اساس، i.e. شی تجزیه و تحلیل شده را نمی توان به عنوان یک سیستم کامل شناسایی کرد.

تمام ملاحظات فوق برای مشکلات جستجو با تعدادی از اشیا نیز اعمال می شود، مشروط بر اینکه اعداد غیر صحیح از اشیاء در کلاس های هم ارزی به دست آمده در فرآیند پارتیشن بندی مجاز باشند.

از نابرابری نتیجه می شود که

و به همین ترتیب

آنتروپی در کجاست.

آنتروپی در.

قضیه 1.اگر پارتیشن امین تعداد اشیا شامل کلاس های هم ارزی با تعداد اشیاء مساوی باشد، نابرابری برقرار است.

اثبات

از شرط و بر این اساس نتیجه می شود که.

قضیه ثابت شده است.

نتیجه 1.آنتروپی پارتیشن با نابرابری محدود می شود

قضیه 2.اگر پارتیشن امین تعداد اشیاء در دارای کلاس های هم ارزی با تعداد اشیاء باشد، آنگاه نابرابری برقرار است.

اثباتاز آنجا که، پس تعداد اشیاء قرار داده شده با توجه به کلاس های هم ارزی پارتیشن کجاست.

از شرط و، بر این اساس، بلافاصله به دنبال آن است.

قضیه ثابت شده است.

نتیجه 1آنتروپی باقیمانده توسط نابرابری محدود می شود

در شکل 3، به عنوان مثال برای قضایای 1، 2، یک درخت برای سه پارتیشن با داده شده است مقدار اصلیاشیاء. نشان می دهد که کلاس های پارتیشن دوم هر کدام شامل 1.5 شی و کلاس های پارتیشن سوم هر کدام شامل 0.75 شی هستند. در امتداد محور مختصات عمودی در شکل اعداد اشیاء اصلی و در امتداد محور افقی مقدار کل اطلاعات بدست آمده پس از تقسیم بعدی 1، 2، 3 و مقدار اطلاعات باقیمانده است. مقدار اطلاعات تولید شده در هر مرحله ثابت و حداکثر باقی می ماند:

قضیه 3.

اثباتاز آن پس کجا. با گرفتن لگاریتم از آخرین عبارت، آن را دریافت می کنیم

قضیه ثابت شده است.

شکل 3 - درخت پارتیشن در.

قضیه 4

اثباتاز آن پس کجا. با گرفتن لگاریتم از آخرین عبارت، به آن می رسیم.

قضیه ثابت شده است.

نتیجه 1

از آنجایی که در طول پارتیشنها، اعداد در کلاسهای بهدستآمده با پارتیشن ith حاوی مقدار بیشتری هستند و کلاسهای پارتیشن ith حاوی کمتر از شی 1 هستند، این بدان معناست که مقدار اطلاعات مربوط به شی بعد از پارتیشن ith

کمتر از مقدار مورد نیاز برای شناسایی شی مورد نظر است، به این معنی که نمی توان آن را به طور کامل تعیین کرد و پس از پارتیشن پنجم مقدار اطلاعات

زیاد می شود و در نتیجه نه تنها خود شی مشخص می شود، بلکه برخی از جزئیات آن نیز مشخص می شود که برای حل مشکل جستجو غیر ضروری است.

در این صورت، تنها در مورد اول نقض اصل وحدت وجود دارد و در مورد دوم این اصل با قابلیت اطمینان بیشتری حفظ و حتی تضمین می شود. بنابراین، در عمل، اگر مجموعه ای از اشیاء در حال تجزیه و تحلیل باشد، با نزدیکترین مجموعه حاوی اشیاء جایگزین می شود و جستجوی شی مورد نظر در میان اشیاء این مجموعه انجام می شود.

بنابراین، میتوان در مورد اندازهگیری گسسته (عدد صحیح) اطلاعات صحبت کرد، که یک نوع اندازهگیری لگاریتمی لگاریتمی است که میانگین تعداد پارتیشنها را در کلاسهای هم ارزی نشان میدهد که با احتمال مساوی، تعداد اشیاء یکسانی را تا اندازه مورد نظر نشان میدهد. به دست آمده است. این اندازه گیری می تواند به طور موثر در مسائل ریاضیات گسسته و ترکیبیات، که در آن راه حل ها اشیاء عدد صحیح هستند استفاده شود.

با این حال، پارتیشنها را میتوان به تعداد غیرصحیح کلاسهای هم ارزی نیز تبدیل کرد. در این صورت می توان به اصل وحدت برای هر کسی دست یافت ارزش واقعی، حل معادله

به طور نسبی.

به عنوان مثال، زمانی که مقدار باید تقریباً برابر انتخاب شود. سپس.

بدین معنی که بر این اساس میزان اطلاعات به دست آمده در 3 بخش برابر خواهد بود

که در آثار نظریغالباً برابر انتخاب می شود و در عمل از مقدار پایه لگاریتم بیشتر استفاده می شود که بر اساس آن چنین اندازه گیری مدرن اطلاعات به عنوان یک بیت به دست می آید - ، یعنی مجموعه اولیه اشیاء برای این اندازه شامل، و شی مورد نظر در یک پارتیشن به 2 کلاس معادل پیدا می شود که هر کدام شامل 1 شی است. آنتروپی باقیمانده در این حالت برابر با 0 است و بر این اساس، اصل واحدی برای بیت رعایت می شود.

مقدار به دست آمده در بالا برای تعداد صحیح پارتیشن برای مجموعه اصلی اشیاء نیز می تواند بر اساس ملاحظات زیر بدست آید.

پایه لگاریتمی که در آن

تعداد صحیح پارتیشن هایی که از عبارت پیدا می شود کجاست

به ترتیب

از (25) چنین بر می آید که

به عنوان مثال، برای

این بدان معنی است که اگر مجموعه اصلی اشیاء به کلاس های معادل تقسیم شود تا یک عدد صحیح به دست آید، آنگاه شی مورد نظر در پارتیشن های عدد صحیح که حداقل تعداد ممکن آنها را نشان می دهد، پیدا می شود. علاوه بر این، در طول هر تقسیم حداکثر مقدار اطلاعات تولید می شود - یک و برای تقسیم - واحد.

اجازه دهید رابطه (25) را به عنوان چگالی اطلاعات اولیه قبل از پارتیشن اول تعریف کنیم:

واضح است که چگالی اطلاعات با تغییر از 1 به محدوده 0 به 1 تغییر می کند.

بنابراین برای، چگالی اطلاعات اولیه

پس از هر پارتیشن، چگالی اطلاعات مطابق با عبارت تعیین می شود

بنابراین، برای مثال در نظر گرفته شده در بالا، پس از پارتیشن اول به دو کلاس هم ارزی

و بعد از دوم

از عبارت (28) چنین برمیآید که پس از هر پارتیشن، چگالی اطلاعات کاهش مییابد و تنها زمانی که برای همه پارتیشنها ثابت بماند و برابر با حداکثر - 1 باشد.

از (26) چنین بر می آید که

و بر این اساس در

بنابراین، با دانستن این موضوع، میتوانیم تعداد مورد نیاز کلاسهای هم ارزی را تعیین کنیم که تعداد اولیه اشیاء باید به ترتیب به آنها تقسیم شود تا تعداد پارتیشنها به دست آید. از آنجایی که این حداکثر مقدار اطلاعات ممکن را تولید می کند، این حداقل تعداد تقسیمات تحت این شرایط خواهد بود.

نتیجه 1 قضیه 4 نشان می دهد که مقدار اطلاعات تولید شده در آخرین پارتیشن

ضمناً مطابق با (16) برابر 0 نیست.

برای به دست آوردن اطلاعات کامل در مورد یک شی کافی است: سپس عبارت (31) شکل خواهد گرفت

از آنجایی که از (17) نتیجه می شود که

سپس برابری (32) را می توان بر اساس بیان بدست آورد

که با توجه به یک داده، تحت توزیع احتمال مربوطه برآورده می شود.

بنابراین، برای مثال، برای

و به همین ترتیب

برای دستیابی به آخرین برابری، احتمالات و باید به ترتیب برابر با 0.15 باشد. 0.85 یا 0.85; 0.15.

این به این معنی است که عدد به دست آمده در پارتیشن دوم در اندازه شی در طول پارتیشن سوم به دو قسمت متناسب با احتمالات (225/0 و 275/1) تقسیم می شود که سپس با آزمونی برای تعیین رابطه یکی از آنها با احتمالات تجزیه و تحلیل می شود. مورد نظر احتمال یافتن آنها برابر است یا بسته به اندازه آنها.

در نتیجه اطلاعات کاملی در مورد یکی از آبجکت ها به دست خواهد آمد، البته علاوه بر پارتیشن های یکنواخت، از پارتیشن های ناهموار نیز استفاده شده است.

در مورد معیار لگاریتمی صرفاً اطلاعات، با توجه به تعداد اشیاء اولیه که باید به دست آیند، مقدار باید نشان دهنده اطلاعاتی باشد که از تقسیم ناقص اشیاء به دو قسمت مساوی به دست می آید به طوری که هر یک از آنها حاوی عناصر دو شیء باشد. در این حالت، آنتروپی برابر با 0 خواهد بود زیرا اطلاعات به دست آمده در طول آخرین پارتیشن عدد صحیح تا حدی برای حذف تداخل در طول آزمایش ایجاد شده توسط عناصر یک شی دیگر استفاده می شود.

از آنچه در بالا مورد بحث قرار گرفت، نتیجه می شود که اطلاعات با تعداد پارتیشن های مجموعه ای از اشیاء ممکن اندازه گیری می شود تا زمانی که فرد کل مورد نظر را به دست آورد. منبع اطلاعات در این مورد تستی است که کلاس هم ارزی که شی مورد نظر در آن قرار دارد را نشان می دهد. در عین حال، اطلاعات به عنوان یک موجودیت مستقل به طور مستقیم در طول پارتیشن ها ظاهر نمی شود و خارج از چارچوب روش اندازه گیری (شمارش تعداد پارتیشن ها) باقی می ماند. در آزمون با نشان دادن نتایج مقایسه خود را نشان می دهد که در همزمانی یا عدم تطابق ویژگی های طبقات هم ارزی با ویژگی های متناظر موجود در آزمون آشکار می شود. این به این معنی است که آزمون باید اطلاعات پیشرفته ای در مورد ویژگی های کلاس های هم ارزی تحلیل شده داشته باشد. عملکرد نهایی آن رمزگشایی ویژگی های این کلاس ها و توسعه اقدامات کنترلی است که نشان می دهد کدام یک از کلاس های تجزیه و تحلیل شده باید به زیر کلاس ها تقسیم شوند. گام بعدیپارتیشن ها، یا اینکه شی پیدا شده است و روند جستجو باید خاتمه یابد.

ضروری برای جستجوی یک شی این است که تنها پس از به دست آوردن تمام اطلاعات در مورد آن، می توان آن را بدون ابهام شناسایی کرد، که تنها زمانی اتفاق می افتد که آنتروپی باقیمانده وجود داشته باشد. این تنها در صورتی امکان پذیر است که فرآیند پارتیشن بندی یک کلاس معادل تولید کند که حاوی یک شی واحد باشد. در این صورت، آنتروپی و در نتیجه اصل یکپارچگی برآورده می شود.

چنین موردی زمانی رخ خواهد داد که تعداد اولیه اشیاء. اگر با پارتیشن بندی یکنواخت، آخرین کلاس هم ارزی دارای کمتر از یک شی خواهد بود و در نتیجه، اطلاعات اضافی به دست می آید که جزئیات شی را نشان می دهد و هنگام جستجو برای آن استفاده نمی شود.

در عمل، در مسائل کدنویسی، جایگزینی تعداد اولیه اشیاء با یک عدد بسیار مورد استفاده قرار می گیرد که از یک سو منجر به ارضای اصل واحد و از سوی دیگر به افزایش مقدار می شود. اطلاعات اضافی تولید شده توسط آزمون

اسناد مشابه

مفهوم و اهداف روش شی کانونی، جستجوی ایده های جدید با الصاق خواص یا ویژگی های اشیاء تصادفی به شی اصلی است. فعال سازی تفکر انجمنی به عنوان یکی از روش های تحقیق اکتشافی در نظریه تصمیم گیری.

تست، اضافه شده در 2012/12/24

مبانی نظریپردازش اولیه اطلاعات آماری. ویژگی های تعیین حداقل تعداد اشیاء مشاهده هنگام ارزیابی شاخص های قابلیت اطمینان. تجزیه و تحلیل مقاله احتمال قوانین توزیع نرمال و توزیع وایبول.

کار دوره، اضافه شده در 2010/03/22

مفاهیم و روش های اساسی کدگذاری اطلاعات. ویژگی های فرآیند رمزگشایی بارکد. فناوری و تجهیزات بارکدینگ استفاده از فناوری شناسایی خودکار بارکد در سیستم های لجستیکی.

کار دوره، اضافه شده 05/09/2013

مفهوم آنتروپی آنتروپی به عنوان معیار درجه عدم قطعیت. مفهوم اطلاعات. اندازه گیری اطلاعات قضیه شانون در مورد کدگذاری در حضور تداخل. نمونه ای از کاربرد آنتروپی در پیش بینی و اهمیت آن برای پیش بینی.

چکیده، اضافه شده در 1387/12/14

توسعه اقتصادی مدل ریاضیو حل مشکل برنامه ریزی خطیبا استفاده از روش های ریاضی وظیفه حمل و نقلدر فرمول ماتریس و خواص آن ساخت طرح قابل اجرا اولیه. معیار بهینه بودن

کار دوره، اضافه شده در 2011/01/16

مبانی مدل سازی ریاضیاشیاء قطعی و تصادفی شناسایی اشیاء کنترلی با پاسخ گذرا. به دست آوردن مدل با استفاده از روش چندگانه رگرسیون خطیو بررسی کفایت آن با استفاده از معیار فیشر.

کار دوره، اضافه شده در 10/14/2014

ساده ترین الگوریتم ها برای جستجوی تصادفی جهت دار. بهترین الگوریتم آزمایشی با ابر مربع راهنما. بهینه ساز آماری چند کاناله با جستجوی تصادفی. روش گرادیان آماری. جستجوی تصادفی محلی با استفاده از بهترین نمونه.

کار دوره، اضافه شده در 2015/02/08

مفاهیم و تعاریف نظریه الگوریتم های ژنتیک. مبانی ریاضی فیزیک اختراعی. الگوریتم ژنتیک برای مسئله اختراعی شرح عملگرهای الگوریتم ژنتیک سیستم جستجو و ردیابی ذهنی در ذهن مخترع.

کار دوره، اضافه شده در 2012/05/22

ساخت یک مدل ریاضی مشکل دوگانه(سیستم های محدودیت در سود واحد و تابع هدف کل هزینه های مواد اولیه. تعیین مجموعه بهینه قیمت مواد اولیه، تضمین حداقل هزینه کل مواد اولیه. تجزیه و تحلیل متغیرها.

تست، اضافه شده در 2015/05/18

برنامه ریزی تجربی به عنوان یک رشته ریاضی و آماری. جستجو برای شرایط و قوانین بهینه برای انجام آزمایش ها به منظور به دست آوردن اطلاعات در مورد یک شی با کمترین میزان کار. تئوری تحقیق همبستگی، معیارهای همبستگی.

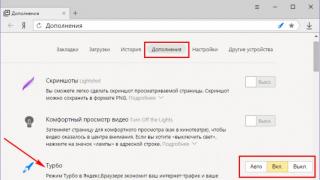

اندازه گیری ترکیبی

برای درک بهتر، اجازه دهید به چند مثال ساده نگاه کنیم.

مثال 1. بیایید یک آزمایش انجام دهیم. بیایید یک تاس برداریم. دارای شش ضلع است که هر کدام دارای اعداد از یک تا شش هستند.

بیایید او را پیاده کنیم. هنگام پرتاب قالب یکی از اعداد کناره های قالب ظاهر می شود. عددی که به این ترتیب به دست میآید، نتیجه تجربه ماست.

با پرتاب تاس به تعداد دفعاتی که دوست داریم، تنها می توانیم شش عدد ممکن را بدست آوریم. بیایید این را با N = 6 نشان دهیم.

این مثال به ما اجازه می دهد تا به مفهوم اندازه گیری ترکیبی اطلاعات برویم و تعریف زیر را ارائه دهیم:

اندازه گیری اطلاعات ترکیبی N روشی برای اندازه گیری مقدار اطلاعات با تخمین تعداد ترکیب های ممکن است. عناصر اطلاعاتی.

از آنجایی که در مثال با تاس تنها شش نتیجه ممکن از آزمایش وجود دارد، به عبارت دیگر، شش ترکیب، بنابراین مقدار اطلاعات مطابق با معیار ترکیبی N = 6 ترکیب است.

مثال زیر را در نظر بگیرید.

مثال 2.بگذارید یکی از ارقام اعشاری داده شود، به عنوان مثال، عدد 8، و یکی از اعداد هگزادسیمال - به عنوان مثال، عدد 6 (شما می توانید هر هگزادسیمال دیگری را انتخاب کنید - 8، B، F، و غیره). حال با توجه به تعریف یک معیار ترکیبی، مقدار اطلاعات موجود در هر یک از این اعداد را تعیین می کنیم. از آنجایی که عدد 8 یک عدد اعشاری است، به این معنی که یک کاراکتر از ده را نشان می دهد، پس N 8 = 10 ترکیب است. به همین ترتیب، عدد 6 یکی از شانزده نماد را نشان می دهد و بنابراین N 6 = 16 ترکیب. بنابراین، رقم هگزادسیمال شامل اطلاعات بیشتراز اعشار

از مثال در نظر گرفته شده، میتوان نتیجه گرفت که هرچه ارقام کمتری در پایه سیستم اعداد باشد، اطلاعات کمتری را یکی از عناصر آن حمل میکند.

مهندس انگلیسی آر. هارتلی اندازه گیری مقدار اطلاعات را با یک اندازه گیری لگاریتمی باینری پیشنهاد کرد:

که در آن N کمیت است ترکیبات مختلفعناصر اطلاعاتی واحد اطلاعات در این اندازه گیری کمی است.

از آنجایی که فرمول به دست آمده توسط R. Hartley تعداد ترکیب های ممکن N را در نظر می گیرد، جالب است بدانیم که اندازه گیری لگاریتمی باینری چه تخمینی از مقدار اطلاعات را برای مثال های مطرح شده در بالا می دهد.

محاسبه نتایج زیر را به دست می دهد:

در مثال مکعب I = log 2 6 = 2.585 بیت.

در مثال با سیستم اعداد اعشاری I = log 2 10 = 3.322 بیت.

در مثال با سیستم هگزادسیمالریشه I = log 2 16 = 4 بیت.

در مثال با سیستم اعداد باینری I = log 2 2 = 1 بیت.

رقم آخر نشان می دهد که هر رقم از سیستم اعداد باینری حاوی یک بیت اطلاعات است. به طور کلی در سیستم های فنی سیستم دودویی radix برای رمزگذاری دو حالت ممکن استفاده می شود، به عنوان مثال 1 نشان دهنده حضور است جریان الکتریسیتهدر شبکه، 0 - عدم وجود آن.

در تمام مثالهای مورد بحث در بالا، نتایج آزمایشها به همان اندازه محتمل و مستقل از یکدیگر بودند. این بدان معنی است که هنگام پرتاب یک قالب، هر یک از شش طرف احتمال یکسانی برای نتیجه موفقیت آمیز دارند. و همچنین اینکه نتیجه پرتاب بعدی به هیچ وجه به نتیجه قبلی بستگی ندارد.

رویدادهای متوازن و مستقل از یکدیگر در زندگی واقعیکاملا نادر هستند. اگر به زبان های گفتاری مانند روسی توجه کنید، می توانید نتایج جالبی بگیرید. برای ساده سازی تحقیقات نظری در علوم کامپیوتر، به طور کلی پذیرفته شده است که الفبای روسی از 32 کاراکتر تشکیل شده است (e و ё و همچنین ь و ъ با یکدیگر تفاوتی ندارند، اما یک کاراکتر فاصله بین کلمات اضافه می شود). اگر فرض کنیم که هر حرف از زبان روسی به طور مساوی در یک پیام ظاهر می شود و هر حرف می تواند با هر علامت دیگری دنبال شود، می توانیم مقدار اطلاعات در هر کاراکتر زبان روسی را به صورت زیر تعیین کنیم:

I = log 2 32 = 5.

با این حال، در واقعیت این مورد نیست. در همه زبان های گفتاری، برخی از حروف رایج تر و برخی دیگر بسیار کمتر رایج هستند. تحقیقات نشان می دهد که تعداد تکرارها در هر 1000 حرف به شرح زیر است:

علاوه بر این، احتمال ظاهر شدن حروف جداگانه بستگی به این دارد که کدام حروف قبل از آنها باشد. بنابراین، در زبان روسی، یک مصوت نمی تواند با یک علامت نرم دنبال شود، چهار مصوت در یک ردیف نمی توانند ظاهر شوند و غیره. هر زبان گفتاری ویژگی ها و الگوهای خاص خود را دارد. بنابراین، مقدار اطلاعات در پیام های ساخته شده از نمادهای هر زبان گفتاری را نمی توان با معیارهای لگاریتمی ترکیبی یا باینری تخمین زد.

1در این مقاله مدلی برای تعیین اندازه لگاریتمی اطلاعات ارائه شده است. از ساختار سیستم فنییک شی شناسایی می شود و حالت های احتمالی خرابی و عملکرد آن در نظر گرفته می شود. زمانی که حالت ها به یک اندازه محتمل هستند، پیشنهاد می شود از معیار هارتلی و برای حالت های غیرمحتمل، معیار شانون برای یک یا چند شیء در صورتی که متقابل مستقل باشند، استفاده شود. این مدل امکان تعیین اندازه ای از اطلاعات را برای تنها یک شی در نظر می گیرد. تمام حالت های شی به دو کلاس تقسیم می شوند. هر یک از کلاس های انتخاب شده بر اساس داده های مربوط به جریان رویدادهای نابرابر احتمالی تشکیل شده است. برای هر کلاس از حالت های شی، احتمالات کل و تعمیم یافته عملکرد و شکست تعیین می شود. این احتمالات در به دست آمده کاربرد پیدا کرده اند عبارات ریاضیبرای تعیین اندازه گیری عدم قطعیت اطلاعات. نشان داده شده است که فرمول های به دست آمده هم در هنگام استفاده از احتمال کل و هم از احتمال تعمیم یکسان و قابل استفاده هستند.

اندازه گیری لگاریتمی اطلاعات وضعیت شیء فنی

دولسوف A.S. 1 Kabaeva E.V. 11 دانشگاه دولتی خاکاس n.a. N.F. کاتانوف

خلاصه:

در این مقاله اصلاحکننده اندازهگیری لگاریتمی مدل اطلاعات ارائه میشود. یک شی از سیستم فنی انتخاب می شود و حالت های احتمالی خرابی و کار آن تحلیل می شود. زمانی که حالتها هماحتمالاند، توصیه میشود از اندازهگیری هارتلی استفاده شود، و وقتی هماحتمالاند، معیار شانون برای یک یا چند شیء مستقل ارجح است. این مدل قابلیت تغییر اندازه اطلاعات را فقط برای یک شی در نظر می گیرد. تمام حالات جسم به دو دسته تقسیم می شوند. هر کلاس بر اساس داده های جریان رویدادهای نامتعادل است. احتمالات کلی و تعمیم یافته بازده و شکست برای حالت های شی از هر کلاس تعیین می شود. از احتمالات مورد مطالعه در فرمول های ریاضی برای اصلاح معیار عدم قطعیت اطلاعات استفاده می شود. نشان داده شده است که فرمول ها یکسان هستند و ممکن است هم برای احتمال کل و هم برای احتمال تعمیم استفاده شوند.

کلید واژه ها:

پیوند کتابشناختی

دولسوف A.S.، Kabaeva E.V. اندازه گیری لگاریتمی اطلاعات وضعیت یک شی فنی // بررسی علمی. علوم فنی. – 1393. – شماره 1. – ص 146-146;URL: http://science-engineering.ru/ru/article/view?id=204 (تاریخ دسترسی: 04/06/2019). مجلات منتشر شده توسط انتشارات "آکادمی علوم طبیعی" را مورد توجه شما قرار می دهیم.

این معیار سودمندی اطلاعات (ارزش) را برای کاربر برای رسیدن به هدف خود تعیین می کند.

اساس تمام تئوری اطلاعات، کشفی است که آر. هارتلی در سال 1928 انجام داد، یعنی اطلاعات را می توان کمی سازی کرد.

رویکرد هارتلی مبتنی بر نظریهی مجموعههای بنیادی، اساساً مبانی ترکیبی، و همچنین چندین فرض شهودی و کاملاً آشکار است.

اگر عناصر زیادی وجود داشته باشد و یکی از آنها انتخاب شود، مقدار مشخصی از اطلاعات مخابره یا تولید می شود. این اطلاعات بدین صورت است که اگر قبل از انتخاب مشخص نبود کدام عنصر انتخاب می شود، پس از انتخاب مشخص می شود. لازم است نوع تابعی را پیدا کنید که مقدار اطلاعات به دست آمده هنگام انتخاب یک عنصر از یک مجموعه را با تعداد عناصر موجود در این مجموعه، یعنی با اصلی بودن آن، مرتبط می کند. بایت عملی الگوریتمی اندازه گیری

اگر مجموعه عناصری که از آنها انتخاب می شود از یک عنصر تشکیل شده باشد، مشخص است که انتخاب آن از پیش تعیین شده است، یعنی عدم قطعیت انتخاب وجود ندارد - مقدار اطلاعات صفر.

اگر مجموعه از دو عنصر تشکیل شده باشد، عدم قطعیت انتخاب حداقل است. در این مورد، حجم اطلاعات حداقل است.

هر چه تعداد عناصر موجود در مجموعه بیشتر باشد، عدم قطعیت انتخاب بیشتر است، اطلاعات بیشتر می شود.

تعداد این اعداد (عناصر) در مجموعه برابر است با: N=2i

از این ملاحظات بدیهی اولین نیاز به دست می آید: اطلاعات تابعی یکنواخت از توان مجموعه اصلی است.

انتخاب یک عدد اطلاعات زیر را به ما می دهد: i=Log 2 (N)

بنابراین، مقدار اطلاعات موجود در عدد باینری، برابر است با تعداد ارقام باینری در این عدد.

این عبارت فرمول هارتلی برای مقدار اطلاعات است.

هنگامی که طول یک عدد دو برابر می شود، مقدار اطلاعات موجود در آن نیز باید دو برابر شود، با وجود اینکه تعداد اعداد در مجموعه بر اساس قانون نمایی افزایش می یابد (اگر اعداد باینری باشند مجذور می شود)، یعنی اگر N2 = (N1)2، سپس I2=2*I1،

F(N1*N1)=F(N1)+F(N1).

این غیر ممکن است اگر مقدار اطلاعات بیان شود تابع خطیبر روی تعداد عناصر موجود در مجموعه اما یک تابع شناخته شده وجود دارد که دقیقاً این ویژگی را دارد: Log:

Log 2 (N2)=Log 2 (N1)2=2*Log 2 (N1)

این نیاز دوم، نیاز افزایشی نامیده می شود.

بنابراین، معیار لگاریتمی اطلاعات ارائه شده توسط هارتلی به طور همزمان شرایط یکنواختی و افزایشی را برآورده می کند. خود هارتلی بر اساس ملاحظات اکتشافی مشابه آنچه که قبلاً ذکر شد به اندازه گیری خود رسید، اما اکنون به طور جدی ثابت شده است که معیار لگاریتمی برای مقدار اطلاعات به طور واضح از این دو شرطی که او فرض کرده است، پیروی می کند.

مثال. 192 سکه وجود دارد. مشخص است که یکی از آنها تقلبی است، به عنوان مثال، وزن سبک تر است. بیایید تعیین کنیم که برای شناسایی آن چند توزین باید انجام شود. اگر آن را روی ترازو بگذارید مقادیر مختلفسکه ها، سپس سه احتمال مستقل به دست می آوریم: الف) فنجان سمت چپ پایین تر است. ب) فنجان سمت راست پایین تر است. ج) فنجان ها متعادل باشند. بنابراین، هر توزین مقداری از اطلاعات I=log23 را می دهد، بنابراین، برای تعیین یک سکه تقلبی، باید حداقل k توزین انجام دهید، که در آن کوچکترین k شرط log23k log2192 را برآورده می کند. از این رو، k 5or، k=4 (یا k=5 - اگر به عنوان یک وزن و آخرین مورد محاسبه شود، برای تعیین سکه مشخص است). بنابراین، شما باید حداقل پنج وزن را انجام دهید (5 وزن کافی است).

دستورالعمل برای ارزیابی میزان اطلاعات

در نظریه اطلاعات سه جهت اصلی وجود دارد: ساختاری، آماری، معنایی.

ساختاری- ساختار گسسته آرایه های اطلاعاتی و اندازه گیری آنها را با شمارش ساده عناصر اطلاعاتی در نظر می گیرد. (ساده ترین کدگذاری آرایه، روش ترکیبی است.)

آماریجهت با مفهوم آنتروپی به عنوان معیار عدم قطعیت عمل می کند، یعنی در اینجا احتمال ظهور پیام های خاص در نظر گرفته می شود.

معناییجهت، مناسب بودن، ارزش یا اهمیت اطلاعات را در نظر می گیرد.

این سه حوزه حوزه های کاربردی خاص خود را دارند. ساختاریبرای ارزیابی قابلیت های ابزار فنی استفاده می شود سیستم های مختلفپردازش اطلاعات، صرف نظر از شرایط خاص کاربرد آنها. آماریارزیابی ها هنگام در نظر گرفتن مسائل مربوط به انتقال داده ها، تعیین می شود پهنای باندکانالهای ارتباطی. معناییدر حل مشکلات ساخت سیستم های انتقال اطلاعات، توسعه دستگاه های رمزگذاری و در ارزیابی اثربخشی دستگاه های مختلف استفاده می شود.

معیارهای ساختاری اطلاعات

اقدامات ساختاری فقط ساختار گسسته اطلاعات را در نظر می گیرد. عناصر مجموعه اطلاعاتی قسمت های کوانتومی - تقسیم ناپذیر اطلاعات هستند. تمیز دادن هندسی, ترکیبیو افزودنیمعیارهای.

تعریف اطلاعات هندسیروش اندازه گیری طول خط، مساحت یا حجم است مدل هندسیمجموعه اطلاعات در تعداد کوانتوم حداکثر تعداد کوانتوم های ممکن در ابعاد ساختاری معین تعیین می کند ظرفیت اطلاعاتی سیستم. ظرفیت اطلاعات عددی است که تعداد کوانتوم ها را در آرایه کامل اطلاعات نشان می دهد. با توجه به شکل. 1.2، جی، مقدار اطلاعات مدر مجتمع ایکس(تی، ن)، تعریف شده است روش هندسی، برابر است

ایکس، تی،N-فواصل زمانی که از طریق آنها خوانش های گسسته انجام می شود.

که در ترکیبیحداقل مقدار اطلاعات به عنوان تعداد ترکیب عناصر محاسبه می شود. ترکیبات ممکن یا تحقق یافته در اینجا در نظر گرفته می شوند.

در بسیاری از موارد پیام گسستهرا می توان کلمه ای متشکل از تعدادی عنصر در نظر گرفت nداده شده توسط الفبای متشکل از تیعناصر حرف اجازه دهید تعداد پیامهای مختلفی را که میتوان از یک الفبای مشخص تشکیل داد، تعیین کنیم. اگر پیام از دو عنصر تشکیل شده باشد ( n= 2)، سپس ممکن است پیام های مختلفی وجود داشته باشد. مثلاً از ده رقم (0، 1، 2،...، 9) می توان صد عدد را تشکیل داد. اعداد مختلفاز 0 تا 99. اگر تعداد عناصر سه باشد، تعداد پیام های مختلف برابر است و غیره.

بنابراین شماره پیام های احتمالیتعریف شده است:

جایی که L- تعداد پیام ها؛ پ- تعداد عناصر در یک کلمه؛ تی- الفبا.

بیشتر L، هر چه هر پیام می تواند متفاوت تر از پیام های دیگر باشد. اندازه Lرا می توان به عنوان معیاری برای میزان اطلاعات در نظر گرفت. با این حال، انتخاب Lبه عنوان معیاری برای میزان اطلاعات با ناراحتی همراه است: اولاً، زمانی که L=1 اطلاعات صفر است، زیرا ماهیت پیام از قبل مشخص است (یعنی یک پیام وجود دارد، اما اطلاعات صفر است). ثانیاً شرط اضافه خطی مقدار اطلاعات برآورده نمی شود، یعنی. شرایط افزایشی اگر، برای مثال، منبع اول با پیام های مختلف مشخص می شود، و دوم - پس تعداد کلپیام های مختلف برای دو منبع توسط محصول تعیین می شود

L= ![]() .

.

برای کمنابع، تعداد کل پیام های مختلف ممکن است

بنابراین، هارتلی یک معیار لگاریتمی (افزودنی) از مقدار اطلاعات را معرفی کرد که به فرد اجازه میدهد تا مقدار اطلاعات موجود در یک پیام را با لگاریتم تعداد پیامهای ممکن تخمین بزند.

من = ![]() .

.

سپس در L= 1من = 0، یعنی اطلاعات وجود ندارد

برای کمنبع اطلاعات

آن ها من = ![]() .

.

معیارهای آماری اطلاعات

در رویکرد احتمالی ایستا، به دست آوردن مقدار مشخصی از اطلاعات، نتیجه انتخاب معینی از میان پیام های ممکن در نظر گرفته می شود. گیرنده اطلاعات ممکن است از قبل بخشی از آن را بداند یا حدس بزند. هنگامی که پیامی در مورد رویدادهای مکرر رخ می دهد که احتمال وقوع آنها وجود دارد آرگرایش به وحدت دارد، پس چنین پیامی بی اطلاع است. به طور متوسط پیام هایی در مورد رویدادهایی که احتمالات آنها به صفر می رسد، غیر اطلاعاتی هستند، یعنی. در مورد رویدادهای تقریباً غیرممکن، زیرا چنین رویدادهایی بسیار نادر گزارش می شوند.

رویدادها را می توان به عنوان نتایج احتمالی برخی از تجربه ها در نظر گرفت. همه نتایج هستند گروه کاملرویدادها یا گروه

این مجموعه با این واقعیت مشخص می شود که مجموع احتمالات همه پیام ها در آن برابر با یک است، یعنی

.

.

پیام های پیچیده ای را در نظر بگیرید که از پعناصری که هر کدام مستقل هستند و از یک الفبای حاوی انتخاب شده اند تیحروف، با احتمال انتخاب عنصر ![]() به ترتیب. بیایید فرض کنیم که برخی از پیام ها شامل عناصر الفبا، عناصر و غیره است. این پیام با یک جدول مشخص می شود (جدول 1.1).

به ترتیب. بیایید فرض کنیم که برخی از پیام ها شامل عناصر الفبا، عناصر و غیره است. این پیام با یک جدول مشخص می شود (جدول 1.1).

جدول 1.1

| نوع آیتم | ... | ... | |||||

| تعداد عناصر | ... | ... | |||||

|

احتمالات انتخاب عناصر |

احتمال اینکه پیام حاوی عناصر باشد برابر است و احتمال تشکیل پیام از عناصر،،،...،،... برابر است با

P= ![]() . (1.1)

. (1.1)

برای طول های طولانی پمنبع پیام های معمولی را تولید می کند که در آن فراوانی نسبی رخ می دهد عناصر فردیبه احتمال ظهور این عناصر تمایل دارد، یعنی

, (1.2)

, (1.2)

و احتمال وقوع پیام های معمولی آریکسان خواهد بود و می توان از (1.1)، (1.2) پیدا کرد:

P=. (1.3)

بیایید تعداد پیام های معمولی را تعیین کنیم:

از آنجایی که با افزایش طول پیام، احتمال کل همه پیامهای معمولی به یک میرسد.

اگر چه تعداد پیام های ممکن، منبع عملا فقط تولید می کند Lپیام های معمولی و احتمال ظاهر شدن سایر پیام ها به صفر می رسد.

بیایید مقدار اطلاعات را پیدا کنیم منموجود در یک پیام:

من =ورود به سیستم L= -ورود به سیستم  . (1.5)

. (1.5)

این عبارت (فرمول شانون) تصویر کامل تری از منبع اطلاعات به دست می دهد اندازه گیری افزایشی(میزان اندازه گیری هارتلی). بیایید در این مورد توضیح دهیم مثال زیر. اگر سکه ای پرتاب کنیم، پیامی از دو حالت ممکن (سر یا دم) دریافت می کنیم، یعنی الفبای پیام هایی از دو حرف. اگر مکعبی را که یک طرف آن آبی و بقیه اضلاع رنگی است پرتاب کنیم رنگ صورتی، سپس در اینجا الفبای دو حرفی (آبی یا صورتی) نیز داریم. برای ضبط متن (پیام) دریافتی، در هر دو حالت یک رقم باینریشروع با حرف ( n= 1، t= 2).

به گفته هارتلی در اینجا در هر دو مورد

اما می دانیم که در حالت اول احتمال هر نتیجه آزمایش 0.5 (=0.5) است. و در مورد دوم و بر این اساس. معیار هارتلی این را در نظر نمی گیرد.

هنگامی که نمادها برابر هستند (یک مورد خاص)، فرمول شانون به فرمول هارتلی تبدیل می شود:

من = -

n  .

.

برای مورد یک سکه:

من = - 1 .

.

برای مورد با یک مکعب:

من = - 1 .

.

مقدار اطلاعات در هر عنصر پیام نامیده می شود محتوای اطلاعاتی خاصیا آنتروپی.

N= . (1.6)

. (1.6)

مقدار اطلاعات و آنتروپی معیارهای لگاریتمی هستند و در واحدهای مشابه اندازه گیری می شوند. پایه لگاریتم واحد اندازه گیری مقدار اطلاعات و آنتروپی را تعریف می کند. یک باینری مربوط به پایه لگاریتمی دو است و بیت نامیده می شود. یک بیت، مقدار اطلاعات موجود در یک پیام در یکی از دو نتیجه احتمالی یک آزمایش است. لگاریتم های طبیعی (NIT) و اعشاری (DIT) نیز استفاده می شود. واحدهای مشابهی برای ارزیابی میزان اطلاعات با استفاده از معیار هارتلی استفاده می شود.

از فرمول شانون چنین بر می آید که مقدار اطلاعات موجود در یک پیام به تعداد عناصر پیام بستگی دارد. پ، الفبا تیو احتمالات انتخاب عنصر اعتیاد مناز جانب پاست خطی.

اجازه دهید به برخی از ویژگی های آنتروپی توجه کنیم.

1. آنتروپی یک کمیت واقعی، محدود و غیر منفی است، یعنی N> 0. این ویژگی از عبارت (1.6) ناشی می شود.

2. اگر پیام از قبل شناخته شده باشد، آنتروپی حداقل و برابر با صفر است، یعنی اگر =1، و

3. اگر همه حالات عناصر پیام به یک اندازه محتمل باشند، آنتروپی حداکثر است.

H=،اگر . (1.7)

مقدار حداکثر آنتروپی را با استفاده از (1.6) و (1.7) پیدا می کنیم:

مصلحت و مفید بودن اطلاعات برای حل یک مشکل را می توان با تأثیری که اطلاعات دریافتی در حل مسئله می گذارد ارزیابی کرد. اگر احتمال دستیابی به یک هدف افزایش یابد، باید اطلاعات را مفید دانست.