Pentru a măsura conținutul semantic al informațiilor, i.e. cantitatea sa la nivel semantic, măsura tezaurului, care leagă proprietățile semantice ale informațiilor cu capacitatea utilizatorului de a accepta mesajul primit, a primit cea mai mare recunoaștere. În acest scop este folosit conceptul tezaurul utilizatorului.

Tezaur este o colecție de informații disponibile unui utilizator sau unui sistem.

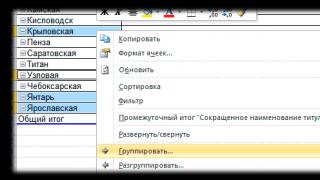

În funcţie de relaţia dintre conţinutul semantic al informaţiei Sși tezaurul utilizatorului S p cantitatea de informații semantice se modifică IC, perceput de utilizator și inclus ulterior de acesta în tezaurul său. Natura acestei dependențe este prezentată în Fig. 2.2. Să luăm în considerare două cazuri limitative când cantitatea de informații semantice IC este egal cu 0:

la S p 0 utilizatorul nu percepe sau înțelege informațiile primite;

la Sp; utilizatorul știe totul, dar nu are nevoie de informațiile primite.

Orez. 2.2. Dependența cantității de informații semantice. perceput de consumator, din tezaurul său Ic=f(Sp)

Cantitatea maximă de informații semantice IC consumatorul dobândeşte prin acordul asupra conţinutului său semantic S cu tezaurul tău S p (S p = S p opt), atunci când informațiile primite sunt de înțeles utilizatorului și îi oferă acestuia informații necunoscute anterior (nu în tezaurul său).

În consecință, cantitatea de informații semantice dintr-un mesaj, cantitatea de cunoștințe noi primite de utilizator, este o valoare relativă. Același mesaj poate avea conținut semnificativ pentru un utilizator competent și poate fi lipsit de sens (zgomot semantic) pentru un utilizator incompetent.

Atunci când se evaluează aspectul semantic (conținut) al informațiilor, este necesar să se depună eforturi pentru armonizarea valorilor SȘi Sp.

O măsură relativă a cantității de informații semantice poate fi coeficientul de conținut CU, care este definit ca raportul dintre cantitatea de informații semantice și volumul acesteia:

Măsură pragmatică informație

Această măsură determină utilitatea informațiilor (valorii) pentru ca utilizatorul să își atingă scopul. Această măsură este, de asemenea, o valoare relativă, determinată de particularitățile utilizării acestor informații într-un anumit sistem. Este indicat să se măsoare valoarea informației în aceleași unități (sau aproape de acestea) în care se măsoară funcția obiectiv.

Exemplul 2.5.ÎN sistem economic proprietăți pragmatice(valoarea) informațiilor poate fi determinată de creșterea efectului economic al operațiunii realizată prin utilizarea acestor informații pentru gestionarea sistemului:

Inb(g)=P(g/b)-P(g),

Unde Inb(g)-valoare mesaj informativ b pentru sistemul de control g,

P(g)- efectul economic așteptat a priori al funcționării sistemului de control g ,

P(g/b)- efectul așteptat al funcționării sistemului g, cu condiția ca informațiile conținute în mesajul b să fie utilizate pentru control.

Pentru comparație, prezentăm măsurile de informare introduse în Tabelul 2.1.

Tabelul 2.1. Unități de informare și exemple

CALITATEA INFORMAȚIILOR

Posibilitatea și eficacitatea utilizării informațiilor sunt determinate de nevoile de bază ale consumatorilor: indicatori de calitate, ca reprezentativitate, semnificație, suficiență, accesibilitate, relevanță, actualitate, acuratețe, fiabilitate, durabilitate.

- Reprezentativitatea informația este asociată cu corectitudinea selecției și formării sale pentru a reflecta în mod adecvat proprietățile obiectului. Cele mai importante lucruri aici sunt:

- corectitudinea conceptului pe baza căruia este formulat conceptul inițial;

- validitatea selecției trăsăturilor și conexiunilor esențiale ale fenomenului afișat.

- Încălcarea reprezentativității informațiilor duce adesea la erori semnificative.

- Conţinut informația reflectă capacitatea semantică, egal cu raportul cantitatea de informații semantice din mesaj la volumul de date prelucrate, adică C=Ic/Vd.

Pe măsură ce crește conținutul informației, crește valoarea semantică debitului sistem informatic, deoarece pentru a obține aceleași informații este nevoie de conversia unei cantități mai mici de date.

Alături de coeficientul de conținut C, care reflectă aspectul semantic, se poate folosi și coeficientul de conținut informațional, caracterizat prin raportul dintre numărul informații sintactice(conform lui Shannon) la volumul de date Y=I/Vd.

- Suficiență (completitudine) informația înseamnă că conține minim, dar suficient pentru acceptare decizia corectă compoziția (set de indicatori). Conceptul de completitudine a informațiilor este asociat cu conținutul ei semantic (semantica) și pragmatica. Ca incomplet, i.e. Informațiile insuficiente pentru a lua decizia corectă, iar informațiile redundante reduc eficacitatea deciziilor luate de utilizator.

- Disponibilitate informarea la percepția utilizatorului este asigurată prin implementarea unor proceduri adecvate pentru achiziția și transformarea acesteia. De exemplu, într-un sistem informațional, informația este transformată într-o formă accesibilă și ușor de utilizat. Acest lucru se realizează, în special, prin coordonarea formei sale semantice cu tezaurul utilizatorului.

- Relevanţă informaţia este determinată de gradul de păstrare a valorii informaţiei pentru management în momentul utilizării acesteia şi depinde de dinamica modificărilor caracteristicilor acesteia şi de intervalul de timp care a trecut de la apariţia acestor informaţii.

- Promptitudine informația înseamnă sosirea acesteia cel târziu într-un moment predeterminat în timp, în concordanță cu momentul rezolvării sarcinii.

- Precizie informaţia este determinată de gradul de apropiere a informaţiei primite de starea reală a obiectului, procesului, fenomenului etc. Pentru informațiile afișate cod digital, sunt cunoscute patru concepte de clasificare a preciziei:

- precizie formală, măsurată prin valoarea unitară a cifrei celei mai puțin semnificative a unui număr;

- acuratețea reală, determinată de valoarea unității ultimei cifre a numărului, a cărei acuratețe este garantată;

- precizia maximă care poate fi obținută în condițiile specifice de funcționare ale sistemului;

- exactitatea necesară determinată scop functional indicator.

Credibilitate informaţia este determinată de capacitatea sa de a reflecta realist dotările existente cu precizia cerută. Fiabilitatea informațiilor este măsurată prin probabilitatea de încredere a acurateței cerute, adică probabilitatea ca valoarea parametrului afișată de informații să difere de sens adevărat acest parametru cu precizia cerută.

Durabilitate informația reflectă capacitatea sa de a răspunde la modificările datelor sursă fără a încălca acuratețea necesară. Stabilitatea informației, precum și reprezentativitatea, este determinată de metodologia aleasă pentru selecția și formarea acesteia.

În concluzie, trebuie remarcat că asemenea parametri ai calității informației precum reprezentativitatea, conținutul, suficiența, accesibilitatea, sustenabilitatea sunt în întregime determinați la nivelul metodologic al dezvoltării sistemelor informaționale. Parametrii de relevanță, promptitudine, acuratețe și fiabilitate sunt, de asemenea, determinați într-o mai mare măsură la nivel metodologic, dar valoarea lor este influențată semnificativ de natura funcționării sistemului, în primul rând de fiabilitatea acestuia. În același timp, parametrii de relevanță și acuratețe sunt strict legați de parametrii de actualitate și, respectiv, de fiabilitate.

Măsura sintactică a informațiilor

La fel de măsură sintactică cantitatea de informații reprezintă volumul de date.

DESPRE volumul de date V d într-un mesaj „în” este măsurat prin numărul de caractere (cifre) din acest mesaj. După cum am menționat, în sistem binar unitatea de măsură de notație este bit. În practică, împreună cu această „cea mai mică” unitate de măsură a datelor, este adesea folosită o unitate mai mare - octet egal cu 8 biți. Pentru comoditate, sunt folosiți ca contoare kilo (10 3), mega (10 6), giga (10 9) și tera (10 12) octeți etc. Volumul mesajelor scurte este măsurat în octeți familiari. mesaje scrise, cărți groase, opere muzicale, imagini și produse software. Este clar că această măsură nu poate caracteriza în niciun fel ce și de ce poartă aceste unități de informație. Măsurați romanul lui L.N. „Războiul și pacea” lui Tolstoi este util, de exemplu, pentru a înțelege dacă se potrivește spatiu liber hard disk. Acest lucru este la fel de util ca măsurarea dimensiunii unei cărți - înălțimea, grosimea și lățimea acesteia - pentru a decide dacă se va potrivi pe un raft sau cântărirea ei pentru a vedea dacă o servietă poate suporta greutatea combinată.

Asa de. o măsură sintactică a informațiilor nu este în mod clar suficientă pentru a caracteriza un mesaj: în exemplul nostru, cu vremea înăuntru acest din urmă caz Mesajul prietenului conținea o cantitate de date diferită de zero, dar nu conținea informațiile de care aveam nevoie. Concluzia despre utilitatea informațiilor rezultă din luarea în considerare a conținutului mesajului. Pentru a măsura conținutul semantic al informațiilor, de ex. cantitatea sa la nivel semantic, introducem conceptul de „tezaur al destinatarului informației”.

Un tezaur este o colecție de informații și conexiuni între ele pe care le are destinatarul informațiilor. Putem spune că un tezaur este cunoștințele acumulate ale destinatarului.

Foarte caz simplu când destinatarul este dispozitiv tehnic - Calculator personal, tezaurul este format din „armamentul” unui computer - programele și dispozitivele încorporate în acesta care îi permit să primească, să proceseze și să prezinte mesaje text pe limbi diferite, folosind diferite alfabete, fonturi, precum și informații audio și video din local sau rețea mondială. Dacă computerul dumneavoastră nu este echipat card de retea, nu vă puteți aștepta să primiți mesaje pe acesta de la alți utilizatori ai rețelei sub nicio formă. Lipsa driverelor cu fonturi rusești nu vă va permite să lucrați cu mesaje în rusă etc.

Dacă destinatarul este o persoană, tezaurul său este și un fel de armament intelectual al unei persoane, un arsenal al cunoștințelor sale. De asemenea, formează un fel de filtru pentru mesajele primite. Mesajul primit este procesat folosind cunoștințele existente pentru a obține informații. Dacă tezaurul este foarte bogat, atunci arsenalul de cunoștințe este profund și divers, vă va permite să extrageți informații din aproape orice mesaj. Un mic tezaur care conține puține cunoștințe poate fi o barieră în înțelegerea mesajelor care necesită o pregătire mai bună.

Să remarcăm, totuși, că înțelegerea mesajului în sine nu este suficientă pentru a influența luarea deciziilor - trebuie să conțină informațiile necesare pentru aceasta, care nu se află în tezaurul nostru și pe care dorim să le includem în acesta. În cazul vremii, tezaurul nostru nu avea cele mai recente, „actuale” informații despre vreme pentru zona universitară. Dacă un mesaj pe care îl primim ne modifică tezaurul, alegerea noastră de soluție se poate schimba și ea. Această modificare a tezaurului servește ca măsură semantică a cantității de informații și o măsură unică a utilității mesajului primit.

Formal, cantitatea de informații semantice Este, inclus ulterior în tezaur este determinat de raportul dintre tezaurul destinatarului S i, și conținutul informațiilor transmise în mesajul „către” S. O vedere grafică a acestei dependențe este prezentată în Fig. 1.

Să luăm în considerare cazurile în care cantitatea de informații semantice Este egal sau aproape de zero:

La S i= 0 destinatarul nu percepe informațiile primite;

La 0< Si< S 0 получатель воспринимает, но не понимает поступившую в сообщении информацию;

La S i-» ∞destinatarul are cunoștințe exhaustive și informațiile primite nu își pot completa tezaurul.

Orez. Dependența cantității de informații semantice de tezaurul destinatarului

Cu tezaur S i> S 0 cantitatea de informații semantice Este, primit dintr-un mesaj atașat β informație Screște rapid la început cu creșterea propriului tezaur al destinatarului și apoi - pornind de la o anumită valoare S i - scade . Scăderea cantității de informații utile destinatarului se produce deoarece baza de cunoștințe a destinatarului a devenit destul de solidă și devine din ce în ce mai dificil să-l surprinzi cu ceva nou.

Acest lucru poate fi ilustrat prin exemplul studenților care studiază informatica economică și materiale de citire de pe site-uri web despre IP corporativă . Inițial, la formarea primelor cunoștințe despre sisteme de informare lectura dă puțin – mult termeni neclari, abrevieri, chiar și titlurile nu sunt toate clare. Persistența în citirea cărților, participarea la prelegeri și seminarii și comunicarea cu profesioniști ajută la completarea tezaurului. În timp, citirea materialelor site-ului devine plăcută și utilă, iar până la sfârșitul carierei tale profesionale - după ce ai scris multe articole și cărți - obținerea de noi informații utile de pe un site popular se va întâmpla mult mai rar.

Putem vorbi despre ceea ce este optim pentru informațiile date. S tezaurul destinatarului, sub care acesta va primi informatii maxime Este, precum și informațiile optime din mesajul „în” pentru un anumit tezaur Sj.În exemplul nostru, atunci când destinatarul este un computer, tezaurul optim înseamnă că hardware-ul său este instalat software percepe și interpretează corect pentru utilizator toate simbolurile conținute în mesajul „în”, transmițând sensul informațiilor S. Dacă mesajul conține caractere care nu corespund conținutului tezaurului, o parte din informații se vor pierde și valoarea Este va scadea.

Pe de altă parte, dacă știm că destinatarul nu are capacitatea de a primi texte în rusă (calculatorul său nu are driverele necesare), A limbi straine, pe care mesajul nostru poate fi trimis, nici el, nici noi nu am studiat, pentru a transmite informațiile necesare putem recurge la transliterare - scrierea textelor rusești folosind litere dintr-un alfabet străin care este bine perceput de computerul destinatarului. În acest fel, vom potrivi informațiile noastre cu tezaurul computerizat disponibil destinatarului. Mesajul va arăta urât, dar întregul informatie necesara destinatarul o va putea citi.

Prin urmare, suma maxima informația semantică este din mesaj β destinatarul dobândește prin acordul asupra conținutului său semantic S c tezaur Si,(la Si = Sj opt). Informațiile din același mesaj pot avea conținut semnificativ pentru un utilizator competent, dar pot fi lipsite de sens pentru un utilizator incompetent. Cantitatea de informații semantice dintr-un mesaj primit de utilizator este o cantitate individuală, personalizată - în contrast cu informațiile sintactice. Cu toate acestea, informația semantică este măsurată în același mod ca și informația sintactică - în biți și octeți.

O măsură relativă a cantității de informații semantice este coeficientul de conținut C, care este definit ca raportul dintre cantitatea de informații semantice și volumul de date. Vd, cuprinse în mesaj β:

C = Is / Vd

Cursul 2 la disciplina „Informatică și TIC”

Măsura sintactică a informațiilor.

Această măsură a cantității de informații operează cu informații impersonale care nu exprimă o relație semantică cu obiectul. Volumul de date Vdîn acest caz, mesajul este măsurat prin numărul de caractere (biți) din mesaj. ÎN diverse sistemeÎn notație, o cifră are o greutate diferită și unitatea de măsură a datelor se modifică în consecință.

De exemplu, în sistemul numeric binar unitatea de măsură este bitul (cifră binară de biți - Cifră binară). Un bit este răspunsul la o singură întrebare binară („da” sau „nu”; „0” sau „1”), transmisă prin canale de comunicație folosind un semnal. Astfel, cantitatea de informație conținută în mesaj în biți este determinată de număr cuvinte binare limbajul natural, numărul de caractere din fiecare cuvânt, numărul semnale binare, necesar pentru a exprima fiecare semn.

ÎN calculatoare moderne Alături de unitatea minimă de măsură a datelor „bit”, unitatea de măsură mărită „byte”, egală cu 8 biți, este utilizată pe scară largă. ÎN sistem zecimal unitatea de măsură de notație este „bit” (locul zecimal).

Cantitatea de informații I la nivel sintactic este imposibil de determinat fără a lua în considerare conceptul de incertitudine a stării sistemului (entropia sistemului). Într-adevăr, obținerea de informații despre un sistem este întotdeauna asociată cu o modificare a gradului de ignoranță a destinatarului cu privire la starea acestui sistem, i.e. cantitatea de informaţie este măsurată printr-o modificare (reducere) a incertitudinii stării sistemului.

Coeficientul (gradul) conținutului informațional(concizia) unui mesaj este determinată de raportul dintre cantitatea de informații și cantitatea de date, adică

Y= I / Vd, cu 0 Cu crestere Y cantitatea de muncă pentru transformarea informațiilor (datelor) din sistem este redusă. Prin urmare, se străduiesc să crească conținutul informațional, pentru care se dezvoltă metode speciale de codificare optimă a informațiilor. Măsura semantică a informațiilor Pentru a măsura conținutul semantic al informațiilor, i.e. cantitatea sa la nivel semantic, măsura tezaurului, care leagă proprietățile semantice ale informațiilor cu capacitatea utilizatorului de a accepta mesajul primit, a primit cea mai mare recunoaștere. În acest scop este folosit conceptul tezaurul utilizatorului. Tezaur este o colecție de informații disponibile unui utilizator sau unui sistem. În funcţie de relaţia dintre conţinutul semantic al informaţiei Sși tezaurul utilizatorului Sp cantitatea de informații semantice se modifică eu, perceput de utilizator și inclus ulterior de acesta în tezaurul său. Natura acestei dependențe este prezentată în Fig. 1. Luați în considerare două cazuri limitative când cantitatea de informații semantice Iс este egal cu 0: la Sp= 0 utilizatorul nu percepe sau înțelege informațiile primite; La Sp utilizatorul știe totul și nu are nevoie de informațiile primite. Tema 2. Bazele reprezentării și procesării informațiilor într-un computer Literatură 1. Informatica în economie: manual/Ed. FI. Odintsova, A.N. Romanova. – M.: Manual universitar, 2008. 2. Informatică: Curs de bază: Manual/Ed. S.V. Simonovici. – Sankt Petersburg: Peter, 2009. 3. Informatica. Curs general: Manual/Coautor: A.N. Guda, M.A. Butakova, N.M. Nechitailo, A.V. Cernov; Sub general ed. IN SI. Kolesnikova. – M.: Dashkov și K, 2009. 4. Informatică pentru economiști: Manual/Ed. Matyushka V.M. - M.: Infra-M, 2006. 5. Informatica economica: Introducere in analiza economica a sistemelor informatice - M.: INFRA-M, 2005. Măsuri ale informațiilor (sintactice, semantice, pragmatice) Pentru măsurarea informațiilor pot fi utilizate diverse abordări, dar cele mai utilizate sunt statistic(probabilistic), semanticși p pragmatic metode. Statistic Metoda (probabilistă) de măsurare a informațiilor a fost dezvoltată de K. Shannon în 1948, care a propus să se considere cantitatea de informații ca o măsură a incertitudinii stării sistemului, care este eliminată ca urmare a primirii informațiilor. Expresia cantitativă a incertitudinii se numește entropie. Dacă, după primirea unui anumit mesaj, observatorul a dobândit informații suplimentare despre sistem X, atunci incertitudinea a scăzut. Cantitatea suplimentară de informații primite este definită ca: unde este cantitatea suplimentară de informații despre sistem X, primit sub forma unui mesaj; Incertitudinea inițială (entropia) a sistemului X; Incertitudine finită (entropie) a sistemului X, care apar după primirea mesajului. Dacă sistemul X poate fi într-una dintre stările discrete, al căror număr n, iar probabilitatea de a găsi sistemul în fiecare dintre ele este egală și suma probabilităților tuturor stărilor este egală cu unu, apoi entropia este calculată folosind formula lui Shannon: unde este entropia sistemului X; A- baza logaritmului, care determină unitatea de măsură a informaţiei; n– numărul de stări (valori) în care se poate afla sistemul. Entropia este o mărime pozitivă și, deoarece probabilitățile sunt întotdeauna mai mici decât unu, iar logaritmul lor este negativ, prin urmare semnul minus din formula lui K. Shannon face ca entropia să fie pozitivă. Astfel, aceeași entropie, dar cu semnul opus, este luată ca măsură a cantității de informații. Relația dintre informație și entropie poate fi înțeleasă astfel: obținerea de informații (creșterea acesteia) simultan înseamnă reducerea ignoranței sau a incertitudinii informaționale (entropie) Astfel, abordarea statistică ține cont de probabilitatea apariției mesajelor: mesajul care este mai puțin probabil este considerat mai informativ, i.e. cel mai putin asteptat. Cantitatea de informații atinge valoarea maximă dacă evenimentele sunt la fel de probabile. R. Hartley a propus următoarea formulă pentru măsurarea informațiilor: I=log2n , Unde n- numărul de evenimente la fel de probabile; eu– o măsură a informațiilor dintr-un mesaj despre apariția unuia dintre n evenimente Măsurarea informației este exprimată în volumul acesteia. Cel mai adesea, aceasta se referă la cantitatea de memorie a computerului și cantitatea de date transmise prin canalele de comunicare. O unitate este considerată cantitatea de informație la care incertitudinea este redusă la jumătate; pic

.

Dacă logaritmul natural () este folosit ca bază a logaritmului în formula lui Hartley, atunci unitatea de măsură a informației este nat ( 1 bit = ln2 ≈ 0,693 nat). Dacă numărul 3 este folosit ca bază a logaritmului, atunci - trata, dacă 10, atunci - dit (Hartley). În practică, o unitate mai mare este folosită mai des - octet(octet) egal cu opt biți. Această unitate a fost aleasă deoarece poate fi folosită pentru a codifica oricare dintre cele 256 de caractere ale alfabetului tastaturii computerului (256=28). Pe lângă octeți, informațiile sunt măsurate în jumătate de cuvinte (2 octeți), cuvinte (4 octeți) și cuvinte duble (8 octeți). Unități de măsură și mai mari de informații sunt, de asemenea, utilizate pe scară largă: 1 kilooctet (KB - kilobyte) = 1024 octeți = 210 octeți, 1 Megaoctet (MB - megaoctet) = 1024 KB = 220 de octeți, 1 gigaoctet (GB - gigabyte) = 1024 MB = 230 de octeți. 1 Teraoctet (TB - terabyte) = 1024 GB = 240 octeți, 1 petabyte (Pbyte - petabyte) = 1024 TB = 250 de octeți. În 1980, matematicianul rus Yu Manin a propus ideea de a construi un computer cuantic, în legătură cu care a apărut o astfel de unitate de informație. qubit ( bit cuantic, qubit )

– „bit cuantic” este o măsură a cantității de memorie într-o formă posibilă teoretic de computer care utilizează medii cuantice, de exemplu, spinurile electronilor. Un qubit poate lua nu două valori diferite („0” și „1”), ci mai multe, corespunzătoare combinațiilor normalizate a două stări de rotație la sol, ceea ce oferă un număr mai mare de combinații posibile. Astfel, 32 de qubiți pot codifica aproximativ 4 miliarde de stări. Abordare semantică. O măsură sintactică nu este suficientă dacă trebuie să determinați nu volumul de date, ci cantitatea de informații necesare în mesaj. În acest caz, se ia în considerare aspectul semantic, care ne permite să determinăm conținutul informației. Pentru a măsura conținutul semantic al informațiilor, puteți utiliza tezaurul destinatarului acesteia (consumator). Ideea metodei tezaurului a fost propusă de N. Wiener și dezvoltată de omul nostru de știință A.Yu. Schrader. Tezaur numit corpul de informații pe care le are destinatarul informaţiei. Corelarea tezaurului cu conținutul mesajului primit vă permite să aflați cât de mult reduce incertitudinea. Dependența volumului de informații semantice a unui mesaj de tezaurul destinatarului În funcție de dependența prezentată de grafic, dacă utilizatorul nu deține niciun tezaur (cunoștințe despre esența mesajului primit, adică =0), sau prezența unui astfel de tezaur care nu s-a schimbat ca urmare a sosirii a mesajului (), atunci cantitatea de informații semantice din acesta este egală cu zero. Tezaurul optim () va fi unul în care volumul de informații semantice va fi maxim (). De exemplu, informații semantice dintr-un mesaj primit într-o limbă străină necunoscută va fi zero, dar aceeași situație va fi și în cazul respectiv dacă mesajul nu mai este o știre, deoarece utilizatorul știe deja totul. Măsură pragmatică informație determină utilitatea acestuiaîn atingerea obiectivelor consumatorului. Pentru a face acest lucru, este suficient să determinați probabilitatea de a atinge obiectivul înainte și după primirea mesajului și să le comparați. Valoarea informațiilor (conform lui A.A. Kharkevich) se calculează folosind formula: unde este probabilitatea de a atinge scopul înainte de a primi mesajul; Probabilitatea atingerii scopului este domeniul de receptare a mesajului; Cantitatea și calitatea informațiilor Nivelurile problemelor de transmitere a informațiilor La implementarea proceselor informaționale, informația este întotdeauna transferată în spațiu și timp de la sursa de informații la receptor (destinatar) folosind semnale. Semnal

- un proces fizic (fenomen) care poartă un mesaj (informații) despre un eveniment sau starea unui obiect de observație. Mesaj-

o formă de reprezentare a informațiilor sub forma unui set de semne (simboluri) utilizate pentru transmitere. Un mesaj ca ansamblu de semne din punctul de vedere al semioticii - o știință care studiază proprietățile semnelor și sistemelor de semne - poate fi studiat la trei niveluri: 1) sintactic, unde sunt luate în considerare proprietățile interne ale mesajelor, adică relațiile dintre semne, reflectând structura unui sistem de semne dat. 2) semantic, unde se analizează relațiile dintre semne și obiectele, acțiunile, calitățile pe care le denotă, adică conținutul semantic al mesajului, relația acestuia cu sursa informației; 3) pragmatic, unde se ia în considerare relația dintre mesaj și destinatar, adică conținutul de consum al mesajului, relația acestuia cu destinatarul. Probleme nivel sintactic privesc crearea fundamentelor teoretice pentru construirea sistemelor informatice. La acest nivel, ei consideră problemele livrării mesajelor către destinatar ca un set de caractere, ținând cont de tipul de suport și metoda de prezentare a informațiilor, viteza de transmitere și procesare, dimensiunea codurilor de prezentare a informațiilor, fiabilitatea și acuratețea conversiei acestor coduri etc., făcând abstracție completă de conținutul semantic al mesajelor și de scopul lor vizat. La acest nivel, informația considerată doar din perspectivă sintactică se numește de obicei date, deoarece latura semantică nu contează. Probleme nivel semantic sunt asociate cu formalizarea și luarea în considerare a sensului informațiilor transmise, determinarea gradului de corespondență dintre imaginea obiectului și obiectul însuși. La acest nivel se analizează informația pe care o reflectă informația, se iau în considerare conexiunile semantice, se formează concepte și idei, se dezvăluie sensul și conținutul informației și se realizează generalizarea acesteia. La nivel pragmatic interesat de consecințele primirii și utilizării acestor informații de către consumator. Problemele de la acest nivel sunt asociate cu determinarea valorii și utilității utilizării informațiilor atunci când consumatorul dezvoltă o soluție pentru a-și atinge scopul. Principala dificultate aici este că valoarea și utilitatea informațiilor pot fi complet diferite pentru diferiți destinatari și, în plus, depinde de o serie de factori, cum ar fi, de exemplu, oportunitatea livrării și utilizării acesteia. Măsuri de informare Măsuri ale informației la nivel sintactic Pentru măsurarea informației la nivel sintactic se introduc doi parametri: cantitatea de informații (date) - V D(abordarea volumului) și cantitatea de informații - eu(abordare entropie). Volumul de informații V D. La implementarea proceselor informaționale, informațiile sunt transmise sub forma unui mesaj, care este un set de simboluri ale unui alfabet. Dacă cantitatea de informații conținută într-un mesaj cu un caracter este luată ca una, atunci volumul de informații (date) V Dîn orice alt mesaj va fi egal cu numărul de caractere (cifre) din acest mesaj. Astfel, în sistemul numeric zecimal, o cifră are o pondere egală cu 10 și, în consecință, unitatea de măsură a informațiilor va fi dit (locul zecimal). În acest caz, un mesaj în formular n V D= P dit. De exemplu, numărul din patru cifre 2003 are un volum de date V D = 4 dit. În sistemul de numere binar, o cifră are o pondere egală cu 2 și, în consecință, unitatea de măsură a informațiilor va fi bitul (bit (cifră binară)- Cifră binară). În acest caz, un mesaj în formular n-numarul digital are volum de date V D = n pic. De exemplu, codul binar de opt biți 11001011 are un volum de date V D= 8 biți. În calculul modern, împreună cu unitatea minimă de date de biți, unitatea de octeți mărită, egală cu 8 biți, este utilizată pe scară largă. Când lucrați cu volume mari de informații, pentru a calcula cantitatea acesteia sunt utilizate unități de măsură mai mari, cum ar fi kilobyte (KB), megabyte (MB), gigabyte (GB), terabyte (TB): 1 kbyte = 1024 bytes = 2 10 bytes; 1 MB = 1024 KB = 2 20 octeți = 1.048.576 octeți; 1 GB = 1024 MB = 2 30 octeți = 1.073.741.824 octeți; . 1 TB = 1024 GB = 2 40 de octeți = 1.099.511.627.776 de octeți. Cantitatea de informație I (abordare entropie).În teoria informației și a codificării, este adoptată o abordare a entropiei pentru măsurarea informațiilor. Această abordare se bazează pe faptul că faptul de a obține informații este întotdeauna asociat cu o scădere a diversității sau a incertitudinii (entropiei) sistemului. Pe baza acestui fapt, cantitatea de informații dintr-un mesaj este determinată ca măsură de reducere a incertitudinii stării unui anumit sistem după primirea mesajului. Odată ce un observator a identificat ceva într-un sistem fizic, entropia sistemului scade deoarece, pentru observator, sistemul a devenit mai ordonat. Astfel, prin abordarea entropiei, informația este înțeleasă ca valoarea cantitativă a incertitudinii care a dispărut în timpul unui proces (testare, măsurare etc.). În acest caz, entropia este introdusă ca măsură a incertitudinii N, iar cantitatea de informații este: Unde H apr

- entropia a priori despre starea sistemului studiat; Haps- entropia posterioară. A posteriori- provenite din experienţă (teste, măsurători). A priori- un concept care caracterizează cunoștințele care precede experiența (testarea) și este independent de aceasta. În cazul în care în timpul testului incertitudinea existentă este eliminată (se obține un rezultat specific, de ex. Haps

= 0), cantitatea de informație primită coincide cu entropia inițială Să considerăm ca sistem studiat o sursă discretă de informație (o sursă de mesaje discrete), prin care înțelegem un sistem fizic care are un set finit de stări posibile. Aceasta este mult A= (A 1, A 2 , ..., a p) stările unui sistem în teoria informației sunt numite alfabet abstract sau alfabet al unei surse de mesaje. Stări individuale a 1, a 2,..., a„ se numesc litere sau simboluri ale alfabetului. Un astfel de sistem poate prelua aleatoriu una dintr-un set finit de stări posibile în orice moment dat. și eu. Deoarece unele stări sunt selectate de sursă mai des, iar altele mai rar, atunci în cazul general se caracterizează printr-un ansamblu A, adică un set complet de stări cu probabilități de apariție care se adună la una: Să introducem o măsură a incertitudinii în alegerea stării sursei. De asemenea, poate fi considerată o măsură a cantității de informații obținute cu eliminarea completă a incertitudinii privind stările la fel de probabile ale sursei. Apoi la N=1 primim PE)= 0. Această măsură a fost propusă de omul de știință american R. Hartley în 1928. Baza logaritmului din formula (2.3) nu are o importanță fundamentală și determină doar scara sau unitatea de măsură În funcție de baza logaritmului, următoarele unități de măsurare sunt utilizate. 1. Biți - în acest caz baza logaritmului este egală cu 2: 2. Nits - în acest caz baza logaritmului este egală cu e: 3. Dits - în acest caz baza logaritmului este egală cu 10: În informatică, formula (2.4) este de obicei folosită ca măsură a incertitudinii. În acest caz, unitatea de incertitudine se numește unitate binară, sau bit, și reprezintă incertitudinea alegerii dintre două evenimente la fel de probabile. Formula (2.4) poate fi obținută empiric: pentru a elimina incertitudinea într-o situație de două evenimente la fel de probabile, sunt necesare o experiență și, în consecință, un bit de informație în cazul incertitudinii constând din patru evenimente la fel de probabile, 2 biți de informație; sunt suficiente pentru a ghici faptul dorit. Pentru a identifica o carte dintr-un pachet de 32 de cărți, sunt suficiente 5 biți de informații, adică este suficient să pui cinci întrebări cu răspunsuri „da” sau „nu” pentru a determina cartea pe care o cauți. Măsura propusă permite rezolvarea anumitor probleme practice atunci când toate stările posibile ale sursei informaționale au aceeași probabilitate. În general, gradul de incertitudine în implementarea stării sursei de informații depinde nu numai de numărul de stări, ci și de probabilitățile acestor stări. Dacă o sursă de informație are, de exemplu, două stări posibile cu probabilități de 0,99 și 0,01, atunci incertitudinea alegerii este semnificativ mai mică decât cea a unei surse care are două stări la fel de probabile, deoarece în acest caz rezultatul este practic predeterminat ( realizarea stării, probabilitate care este egală cu 0,99). Omul de știință american K. Shannon a generalizat conceptul de măsură a incertitudinii de alegere Hîn cazul în care H depinde nu numai de numărul de stări, ci și de probabilitățile acestor stări (probabilități p i selecția caracterelor și eu, alfabetul A). Această măsură, care reprezintă incertitudinea pe stare în medie, se numește entropia unei surse discrete de informații: Dacă ne concentrăm din nou pe măsurarea incertitudinii în unități binare, atunci baza logaritmului ar trebui luată egală cu doi: În alegerile equiprobabile, probabilitatea p i = 1/N formula (2.6) se transformă în formula lui R. Hartley (2.3): Măsura propusă a fost numită entropie nu întâmplător. Faptul este că structura formală a expresiei (2.5) coincide cu entropia sistemului fizic, definită anterior de Boltzmann. Folosind formulele (2.4) și (2.6), putem determina redundanța D alfabetul sursei mesajului A, care arată cât de rațional sunt folosite simbolurile unui anumit alfabet: Unde N max (A) - entropia maximă posibilă, determinată de formula (2.4); PE) - entropia sursei, determinată prin formula (2.6). Esența acestei măsuri este că, cu o alegere la fel de probabilă, aceeași încărcare informațională pe un semn poate fi asigurată prin utilizarea unui alfabet mai mic decât în cazul unei alegeri inegale. și (2.2)

și (2.2)![]() (2.4)

(2.4)![]()

![]()

(2.5)

(2.5) (2.6)

(2.6)