1928 Inxhinieri amerikan Ralph Hartley e konsideron procesin e marrjes së informacionit si zgjedhjen e një mesazhi nga një grup i caktuar i caktuar ngjarjesh N ekuiprobabile.

Formula e Hartley:

ku K është sasia e informacionit, N është numri i ngjarjeve ekuiprobabile.

Formula e Hartley-t mund të shkruhet edhe kështu: N=2k

Meqenëse ndodhja e secilës prej N ngjarjeve ka të njëjtin probabilitet P, atëherë:

ku P është probabiliteti i ndodhjes së ngjarjes.

Atëherë formula mund të shkruhet ndryshe:

Në vitin 1948, shkencëtari amerikan Claude Shannon propozoi një formulë të ndryshme për përcaktimin e sasisë së informacionit, duke marrë parasysh probabilitetin e mundshëm të pabarabartë të ngjarjeve në grup.

Formula Shannon:

K = - (p1 *log2 p1+ p2 *log 2p 2 + p 3 *log 2p 3 +…+ pi * log2 pi),

ku pi është probabiliteti që saktësisht mesazhi i është zgjedhur në grupin e N mesazheve.

Kjo formulë shkruhet gjithashtu:

Shkenca moderne e vetive të informacionit dhe modeleve të proceseve të informacionit quhet teoria e informacionit. Përmbajtja e konceptit të "informacionit" mund të zbulohet në shembullin e dy qasjeve të para historikisht për matjen e sasisë së informacionit: qasjet e Hartley dhe Shannon: e para prej tyre bazohet në teorinë e grupeve dhe kombinatorikë, dhe e dyta - mbi teorinë e probabilitetit.

Informacioni mund të kuptohet dhe interpretohet në probleme të ndryshme, fusha lëndore në mënyra të ndryshme. Si rezultat, ekzistojnë qasje të ndryshme për përcaktimin e matjes së informacionit dhe mënyra të ndryshme për të futur një masë të sasisë së informacionit.

Sasia e informacionit është një vlerë numerike që karakterizon në mënyrë adekuate informacionin e përditësuar në aspektin e diversitetit, kompleksitetit, strukturimit (rregullësisë), sigurisë dhe zgjedhjes së gjendjeve të sistemit të shfaqur.

Nëse konsiderohet një sistem që mund të marrë një nga n gjendjet e mundshme, atëherë detyra aktuale është detyra e vlerësimit të kësaj zgjedhjeje, rezultati. Një vlerësim i tillë mund të jetë një masë e informacionit (ngjarjeve).

Një masë është një funksion real jo-negativ i vazhdueshëm i përcaktuar në një grup ngjarjesh dhe është shtesë.

Masat mund të jenë statike dhe dinamike, në varësi të informacionit që lejojnë të vlerësohen: statike (jo të përditësuara; në fakt, mesazhet vlerësohen pa marrë parasysh burimet dhe formën e përditësimit) ose dinamike (të përditësuara, d.m.th., kostot e burimeve për përditësimin janë gjithashtu informacion i vlerësuar).

Ka mënyra të ndryshme për të përcaktuar sasinë e informacionit. Më të përdorurat janë vëllimet dhe probabilistikët e mëposhtëm.

qasje vëllimore.

Përdoret sistemi binar i numrave, sepse në një pajisje teknike është më e thjeshtë të zbatohen dy gjendje fizike të kundërta: të magnetizuara / jo të magnetizuara, të ndezura / fikur, të ngarkuara / jo të ngarkuara dhe më shumë.

Sasia e informacionit të regjistruar me karaktere binare në kujtesën e kompjuterit ose në një medium të jashtëm ruajtjeje llogaritet thjesht nga numri i karaktereve binare të kërkuara për një regjistrim të tillë. Në këtë rast, një numër jo i plotë i biteve është i pamundur.

Për lehtësinë e përdorimit, janë futur gjithashtu njësi më të mëdha të sasisë së informacionit sesa bit. Pra, një fjalë binare prej tetë karakteresh përmban një bajt informacioni, 1024 bajt formojnë një kilobajt (kbajt), 1024 kilobajt nga një megabajt (MB) dhe 1024 megabajt formojnë një gigabajt (GB).

Qasja e entropisë (probabiliste).

Kjo qasje pranohet në teorinë e informacionit dhe kodimit. Kjo metodë e matjes vjen nga modeli i mëposhtëm: marrësi i mesazhit ka një ide të caktuar për ndodhjen e mundshme të ngjarjeve të caktuara. Këto paraqitje janë përgjithësisht jo të besueshme dhe shprehen me probabilitetet me të cilat ai pret këtë apo atë ngjarje. Masa totale e pasigurisë quhet entropi. Entropia karakterizohet nga njëfarë varësie matematikore nga tërësia e probabilitetit të ndodhjes së këtyre ngjarjeve.

Sasia e informacionit në mesazh përcaktohet nga sa është zvogëluar kjo masë pas marrjes së mesazhit: sa më e madhe të jetë entropia e sistemit, aq më e madhe është shkalla e pasigurisë së tij. Mesazhi në hyrje e largon plotësisht ose pjesërisht këtë pasiguri, prandaj sasia e informacionit mund të matet me atë se sa është ulur entropia e sistemit pas marrjes së mesazhit. E njëjta entropi merret si masë e sasisë së informacionit, por me shenjën e kundërt.

Qasja e R. Hartley-t bazohet në bazat themelore teorike të grupeve, në thelb kombinuese, si dhe në disa supozime intuitive të qarta dhe mjaft të dukshme.

Nëse ka shumë elementë dhe një prej tyre zgjidhet, atëherë një sasi e caktuar informacioni raportohet ose gjenerohet nga kjo. Ky informacion është se nëse para seleksionimit nuk dihej se cili element do të zgjidhet, atëherë pas përzgjedhjes bëhet i ditur. Është e nevojshme të gjendet lloji i funksionit që lidh sasinë e informacionit të marrë kur zgjedh një element nga grupi me numrin e elementeve në këtë grup, d.m.th. me fuqinë e tij.

Nëse grupi i elementeve nga i cili bëhet zgjedhja përbëhet nga një element i vetëm, atëherë është e qartë se zgjedhja e tij është e paracaktuar, d.m.th. nuk ka pasiguri zgjedhjeje - sasi zero informacioni.

Nëse grupi përbëhet nga dy elementë, atëherë pasiguria e zgjedhjes është minimale. Në këtë rast, sasia e informacionit është gjithashtu minimale.

Sa më shumë elementë në grup, aq më e madhe është pasiguria e zgjedhjes, aq më shumë informacion.

Kështu, masa logaritmike e informacionit e propozuar nga Hartley përmbush njëkohësisht kushtet e monotonitetit dhe aditivitetit. Vetë Hartley arriti në masën e tij në bazë të konsideratave heuristike të ngjashme me ato të përshkruara sapo, por tani është vërtetuar me rigorozitet se masa logaritmike për sasinë e informacionit rrjedh pa mëdyshje nga këto dy kushte që ai postuloi.

Në vitin 1948, ndërsa hetonte problemin e transmetimit racional të informacionit përmes një kanali komunikimi të zhurmshëm, Claude Shannon propozoi një qasje revolucionare probabiliste për të kuptuar komunikimet dhe krijoi teorinë e parë të vërtetë matematikore të entropisë. Idetë e tij sensacionale çuan shpejt në zhvillimin e dy rrymave kryesore: teoria e informacionit, e cila përdor konceptin e probabilitetit dhe teorinë ergodike për të studiuar karakteristikat statistikore të të dhënave dhe sistemeve të komunikimit, dhe teoria e kodimit, e cila përdor kryesisht mjete algjebrike dhe gjeometrike për të zhvilluar efikasitet. kodet.

Claude Shannon sugjeroi që fitimi i informacionit është i barabartë me pasigurinë e humbur dhe vendosi kërkesat për matjen e tij:

- 1. masa duhet të jetë e vazhdueshme; domethënë, një ndryshim në vlerën e vlerës së probabilitetit me një sasi të vogël duhet të shkaktojë një ndryshim të vogël neto në funksion;

- 2. në rastin kur të gjitha opsionet (shkronjat në shembullin e mësipërm) janë njësoj të mundshme, një rritje në numrin e opsioneve (gërmave) duhet të rrisë gjithmonë vlerën e funksionit;

- 3. Duhet të jetë e mundur të bëhet një zgjedhje (shkronjat në shembullin tonë) në dy hapa, në të cilat vlera e funksionit të rezultatit përfundimtar duhet të jetë shuma e funksioneve të rezultatit të ndërmjetëm.

Prandaj, funksioni i entropisë duhet të plotësojë kushtet:

të përcaktuara dhe të vazhdueshme për të gjithë,

ku për të gjithë i. (Është e lehtë të shihet se ky funksion varet vetëm nga shpërndarja e probabilitetit, jo nga alfabeti).

Për numrat e plotë pozitivë, pabarazia e mëposhtme duhet të jetë:

Për numrat e plotë pozitivë, ku barazia duhet të jetë:

entropia e gjerësisë së brezit të informacionit

Shannon përcaktoi se matja e entropisë e aplikuar në një burim informacioni mund të përcaktojë kërkesat për gjerësinë minimale të brezit të kërkuar për transmetimin e besueshëm të informacionit në formën e numrave binarë të koduar. Për të nxjerrë formulën Shannon, është e nevojshme të llogaritet pritshmëria matematikore e "sasës së informacionit" që gjendet në figurë nga burimi i informacionit. Masa e entropisë Shannon shpreh pasigurinë e realizimit të një ndryshoreje të rastësishme. Kështu, entropia është ndryshimi midis informacionit që përmban një mesazh dhe asaj pjese të informacionit që njihet saktësisht (ose shumë e parashikueshme) në mesazh. Një shembull i kësaj është teprica e gjuhës -- ka modele të qarta statistikore në paraqitjen e shkronjave, çifte shkronjash të njëpasnjëshme, treshe, e kështu me radhë.

Formulat e Hartley, Shannon.

Në vitin 1928, inxhinieri amerikan R. Hartley propozoi një qasje shkencore për vlerësimin e mesazheve. Formula që ai propozoi ishte si më poshtë:

I = log 2 K

ku K është numri i ngjarjeve ekuiprobabile; I është numri i biteve në mesazh, i tillë që ka ndodhur ndonjë nga ngjarjet K. PastajK=2 I .

Ndonjëherë formula e Hartley shkruhet si kjo:

I = log 2 K = log 2 (1 / R) = - log 2 R

meqenëse secila prej ngjarjeve K ka një rezultat të barabartë p = 1 / K, atëherë K = 1 / p.

Një detyrë.

Topi është në njërën nga tre urnat: A, B ose C. Përcaktoni sa pjesë informacioni përmban mesazhi që ndodhet në urnën B.

Zgjidhje.

Një mesazh i tillë përmban I = log 2 3 = 1.585 bit informacion.

Por jo të gjitha situatat kanë të njëjtat probabilitete realizimi. Ka shumë situata të tilla në të cilat gjasat e realizimit ndryshojnë. Për shembull, nëse hidhet një monedhë asimetrike ose "rregulli i sanduiçit".

"Një herë, kur isha fëmijë, më ra një sanduiç. Duke më parë duke fshirë me faj njollën e vajit të mbetur në dysheme, vëllai im i madh më siguroi:

- mos u shqetëso, funksionoi ligji i sanduiçit.

- Çfarë ligji është ky? Unë pyeta.

- Ligji që thotë: "Një sanduiç i bie gjithmonë gjalpi anash". Megjithatë, kjo është një shaka, - vazhdoi vëllai. - Nuk ka ligj. Thjesht, sanduiçi me të vërtetë sillet mjaft çuditshëm: pjesa më e madhe e gjalpit është në fund.

"Le ta hedhim sanduiçin edhe disa herë, ta kontrollojmë," sugjerova. - Do të duhet ta hedhësh gjithsesi.

Kontrolluar. Nga dhjetë herë tetë, sanduiçi ra me gjalpë poshtë.

Dhe pastaj mendova: a është e mundur të dimë paraprakisht se si do të bjerë sanduiçi me gjalpë poshtë apo lart?

Eksperimentet tona u ndërprenë nga nëna ... "

(Fragment nga libri “Sekreti i gjeneralëve të mëdhenj”, V. Abchuk).

Në vitin 1948, inxhinieri dhe matematikani amerikan K. Shannon propozoi një formulë për llogaritjen e sasisë së informacionit për ngjarje me probabilitete të ndryshme.

Nëse unë jam sasia e informacionit,

K është numri i ngjarjeve të mundshme,

R i - probabilitetet e ngjarjeve individuale,

atëherë sasia e informacionit për ngjarjet me probabilitete të ndryshme mund të përcaktohet me formulën:

I = - ShumaR i log 2 R i ,

ku marr vlerat nga 1 në K.

Formula e Hartley tani mund të shihet si një rast i veçantë i formulës së Shannon:

I = - Shuma 1 /telog 2 (1 / te) = I = log 2 te.

Për ngjarje po aq të mundshme, sasia e informacionit të marrë është maksimale.

Fiziologët dhe psikologët kanë mësuar të përcaktojnë sasinë e informacionit që një person mund të perceptojë me ndihmën e shqisave, të mbajë në kujtesë dhe të përpunojë. Informacioni mund të paraqitet në forma të ndryshme: zë, shenjë, etj. Metoda e diskutuar më sipër për përcaktimin e sasisë së informacionit të marrë në mesazhe që zvogëlojnë pasigurinë e njohurive tona, e konsideron informacionin nga këndvështrimi i përmbajtjes së tij, risia dhe kuptueshmëria për një person. Nga ky këndvështrim, në përvojën e hedhjes së një zari, të njëjtën sasi informacioni përmbajnë mesazhet "dy", "fytyra ra lart, mbi të cilën ranë dy pika" dhe në imazhin vizual të zarit të rënë.

Gjatë transmetimit dhe ruajtjes së informacionit duke përdorur pajisje të ndryshme teknike, informacioni duhet të konsiderohet si një sekuencë karakteresh (numra, shkronja, kode ngjyrash të pikave të imazhit), pa marrë parasysh përmbajtjen e tij.

Duke marrë parasysh që alfabeti (një grup simbolesh të një sistemi shenjash) është një ngjarje, atëherë shfaqja e njërit prej simboleve në mesazh mund të konsiderohet si një nga gjendjet e ngjarjes. Nëse shfaqja e karaktereve është po aq e mundshme, atëherë mund të llogarisni sa pjesë informacioni mbart çdo karakter. Kapaciteti informativ i karaktereve përcaktohet nga numri i tyre në alfabet. Sa më shumë karaktere të përbëhet nga alfabeti, aq më shumë informacion mbart një personazh. Numri i përgjithshëm i simboleve në një alfabet quhet kardinaliteti i alfabetit.

Molekulat e ADN-së (acidi deoksiribonukleik) përbëhen nga katër përbërës të ndryshëm (nukleotide) që formojnë alfabetin gjenetik. Kapaciteti informativ i shenjës së këtij alfabeti është:

4 = 2 I , d.m.th. I = 2 bit.

Çdo shkronjë e alfabetit rus (duke supozuar se e = e) mbart informacion prej 5 bit (32 = 2 I ).

Me këtë qasje, si rezultat i mesazhit për rezultatin e hedhjes së zarit, marrim një sasi të ndryshme informacioni. Për ta llogaritur atë, duhet të shumëzoni numrin e karaktereve me sasinë e informacionit që mbart një personazh.

Sasia e informacionit që përmban një mesazh i koduar me një sistem shenjash është i barabartë me sasinë e informacionit që mbart një karakter, shumëzuar me numrin e karaktereve në mesazh.

Shembulli 1 Përdorimi i formulës Hartley për të llogaritur sasinë e informacionit. Sa pjesë informacioni përmban mesazhi?

a mbërrin treni në një nga 8 shinat?

Formula Hartley:I = log 2 N ,

ku N është numri i rezultateve të barabarta të ngjarjes së përmendur në mesazh,

Unë është sasia e informacionit në mesazh.

I = log 2 8 = 3 (bit) Përgjigje: 3 bit.

Modifikuar formulën e Hartley-t për ngjarjet jo uniforme. Meqenëse ndodhja e secilës prej N ngjarjeve të mundshme ka të njëjtin probabilitet

p = 1 / N , pastajN=1/p dhe formula duket si

I = log 2 N=log 2 (1/p) = -log 2 fq

Marrëdhënia sasiore midis probabilitetit të një ngjarjeje (p) dhe sasisë së informacionit në mesazhin për të (I) shprehet me formulën:

I = log 2 (1/p)

Probabiliteti i një ngjarjeje llogaritet me formulënp=K/N , K është një vlerë që tregon se sa herë ka ndodhur ngjarja me interes për ne; N është numri i përgjithshëm i rezultateve, ngjarjeve të mundshme. Nëse probabiliteti zvogëlohet, atëherë sasia e informacionit rritet.

Shembulli 2 Në klasë janë 30 veta. Për punën e kontrollit në matematikë janë marrë 6 pesëshe, 15 katërshe, 8 treshe dhe 1 dy. Sa pjesë të informacionit përmban mesazhi se Ivanov mori një katërshe?

Marrëdhënia sasiore midis probabilitetit të një ngjarjeje (p) dhe sasisë së informacionit të raportuar për të (I)I = log 2 (1/p) = -log 2 fq

probabiliteti i ngjarjes 15/30

sasia e informacionit në mesazh = log 2 (30/15)=log 2 2=1.

Përgjigje: 1 bit.

Duke përdorur formulën Shannon. Rasti i përgjithshëm i llogaritjes së sasisë së informacionit në një mesazh për një nga N, por jo njësoj të mundshme ngjarje. Kjo qasje u propozua nga K. Shannon në 1948.

Njësitë bazë të informacionit:

Iav - mesatarisht numri i pjesëve të informacionit për shkronjë;M - numri i karaktereve në mesazh

I - vëllimi i informacionit të mesazhit

fq i -probabiliteti i shfaqjes së karakterit i në mesazh; i - numri i simbolit;

I

e mërkurë

= -

KuptimiI e mërkurë i fq i = 1/N.

Shembulli 3 Sa pjesë informacioni mbart një mesazh "fener" i gjeneruar rastësisht nëse, mesatarisht, për çdo mijë shkronja në tekstet ruse, shkronja "a" shfaqet 200 herë, shkronja "f" - 2 herë, shkronja "r" - 40 herë.

Do të supozojmë se probabiliteti i shfaqjes së një karakteri në një mesazh përkon me shpeshtësinë e shfaqjes së tij në tekste. Prandaj shkronja “a” paraqitet me frekuencë mesatare 200/1000=0,2; Probabiliteti i shfaqjes së shkronjës "a" në tekst (f a ) mund të konsiderohet afërsisht i barabartë me 0,2;

shkronja “f” paraqitet me frekuencë 2/1000=0,002; shkronja "p" - me një frekuencë prej 40/1000=0.04;

Po kështu, f R = 0,04, f f = 0,002. Më pas vazhdojmë sipas K. Shannon. Marrim logaritmin binar të vlerës 0.2 dhe e quajmë atë që morëm sasinë e informacionit që mbart një shkronjë e vetme "a" në tekstin në shqyrtim. Ne do të bëjmë të njëjtin veprim për secilën shkronjë. Atëherë sasia e informacionit të duhur të bartur nga një shkronjë është e barabartë melog 2 1/fq i = -log 2 fq i , Është më i përshtatshëm të përdoret vlera mesatare e sasisë së informacionit për një karakter të alfabetit si masë e sasisë së informacionit.

I e mërkurë = -

KuptimiI e mërkurë arrin një maksimum për ngjarje po aq të mundshme, pra kur të gjitha p i

fq i = 1/N.

Në këtë rast, formula e Shannon-it kthehet në formulën e Hartley-t.

I = M*I e mërkurë =4*(-(0,002*log 2 0,002+0,2*log 2 0.2+0.04*log 2 0.04+0.2*log 2 0,2))=4*(-(0,002*(-8,967)+0,2*(-2,322)+0,04*(-4,644)+0,2*(-2,322)))=4*(-(-0,018-0,46-0,19-0,46))=4*1,1325=4,53

Përgjigje: 4.53 bit

Gjatë përpilimit të tabelës duhet të kemi parasysh:

Futja e të dhënave (ajo që jepet në kusht).

Duke numëruar numrin total të rezultateve të mundshme (formula N=K 1 +K 2 +…+K i).

Llogaritja e probabilitetit të secilës ngjarje (formula f i= K i/N).

Numërimi i sasisë së informacionit për çdo ngjarje që ndodh (Formula I i= log 2 (1/fq i)).

Llogaritja e sasisë së informacionit për ngjarje me probabilitete të ndryshme (formula e Shanonit).

Progresi:

1 . Bëni një model tabelor për të llogaritur sasinë e informacionit.

2 . Duke përdorur një model tabelor, bëni llogaritjet për detyrën nr. 2 (Fig. 3), vendosni rezultatin e llogaritjes në një fletore.

Detyra numër 3

Kutia përmban zare: 10 të kuq, 8 jeshil, 5 të verdhë, 12 blu. Llogaritni probabilitetin e vizatimit të një kubi të secilës ngjyrë dhe sasinë e informacionit që do të merret në këtë rast.

Detyra numër 4

Një qese opake përmban 10 mermere të bardha, 20 të kuqe, 30 blu dhe 40 mermere jeshile. Sa informacion do të përmbajë mesazhi vizual për ngjyrën e topit të tërhequr?

Në vitin 1928, inxhinieri amerikan R. Hartley propozoi një qasje shkencore për vlerësimin e mesazheve. Formula që ai propozoi ishte si më poshtë:

I = log 2 K,

Ku K është numri i ngjarjeve ekuiprobabile; I është numri i biteve në mesazh, i tillë që ka ndodhur ndonjë nga ngjarjet K. Atëherë K=2 I .

Ndonjëherë formula e Hartley shkruhet si kjo:

I \u003d log 2 K \u003d log 2 (1 / p) \u003d - log 2 p,

meqenëse secila prej ngjarjeve K ka një rezultat të barabartë p = 1 / K, atëherë K = 1 / p.

Një detyrë.

Topi është në njërën nga tre urnat: A, B ose C. Përcaktoni sa pjesë informacioni përmban mesazhi që ndodhet në urnën B.

Një mesazh i tillë përmban I = log 2 3 = 1.585 bit informacion.

Por jo të gjitha situatat kanë të njëjtat probabilitete realizimi. Ka shumë situata të tilla në të cilat gjasat e realizimit ndryshojnë. Për shembull, nëse hidhet një monedhë asimetrike ose "rregulli i sanduiçit".

"Një herë, kur isha fëmijë, më ra një sanduiç. Duke më parë duke fshirë me faj njollën e vajit të mbetur në dysheme, vëllai im i madh më siguroi:

Mos u shqetësoni, është ligji i sanduiçit që funksionoi.

Çfarë lloj ligji është ky? Unë pyeta.

Ligji që thotë: “Një sanduiç bie gjithmonë gjalpi anash”. Megjithatë, kjo është shaka, - vazhdoi vëllai.- Nuk ka ligj. Vetëm një sanduiç sillet vërtet çuditërisht: pjesa më e madhe e gjalpit është në fund.

Le ta hedhim sanduiçin edhe nja dy herë, kontrollo, - i sugjerova. - Do të duhet ta hedhësh gjithsesi.

Kontrolluar. Nga dhjetë herë tetë, sanduiçi ra me gjalpë poshtë.

Dhe pastaj mendova: a është e mundur të dimë paraprakisht se si do të bjerë sanduiçi me gjalpë poshtë apo lart?

Eksperimentet tona u ndërprenë nga nëna ... "

(Fragment nga libri “Sekreti i gjeneralëve të mëdhenj”, V. Abchuk).

Në vitin 1948, inxhinieri dhe matematikani amerikan K Shannon propozoi një formulë për llogaritjen e sasisë së informacionit për ngjarje me probabilitete të ndryshme.

Nëse unë jam sasia e informacionit,

K është numri i ngjarjeve të mundshme,

pi - probabilitetet e ngjarjeve individuale,

atëherë sasia e informacionit për ngjarjet me probabilitete të ndryshme mund të përcaktohet me formulën:

I = - Shuma p i log 2 p i ,

ku marr vlerat nga 1 në K.

Formula e Hartley tani mund të shihet si një rast i veçantë i formulës së Shannon:

I = - Shuma 1 / K log 2 (1 / K) = I = log 2 K.

Për ngjarje po aq të mundshme, sasia e informacionit të marrë është maksimale.

Detyrat.

1. Përcaktoni sasinë e informacionit të marrë gjatë zbatimit të një prej ngjarjeve, nëse ato hedhin

a) piramida asimetrike tetraedrale;

b) piramidë tetraedrale simetrike dhe uniforme.

Zgjidhje.

a) Do të hedhim një piramidë asimetrike tetraedrale.

Probabiliteti i ngjarjeve individuale do të jetë si më poshtë:

p1 = 1/2,

p2 = 1/4,

p3 = 1/8,

p4 = 1/8,

atëherë sasia e informacionit të marrë pas zbatimit të një prej këtyre ngjarjeve llogaritet me formulën:

I = -(1/2 log 2 1/2 + 1/4 log 2 1/4 + 1/8 log 2 1/8 + 1/8 log 2 1/8) = 1/2 + 2/4 + + 3/8 + 3/8 = 14/8 = 1,75 (bit).

b) Tani le të llogarisim sasinë e informacionit që do të merret kur hedhim një piramidë tetraedrale simetrike dhe uniforme:

I = log 2 4 = 2 (bit).

2. Probabiliteti i ngjarjes së parë është 0,5, dhe i dytë dhe i tretë 0,25. Sa informacion do të marrim pas zbatimit të njërës prej tyre?

3. Sa informacion do të merret kur luani ruletë me 32 sektorë?

4. Sa numra të ndryshëm mund të kodohen duke përdorur 8 bit?

Zgjidhje: I=8 bit, K=2 I =2 8 =256 numra të ndryshëm.

Fiziologët dhe psikologët kanë mësuar të përcaktojnë sasinë e informacionit që një person mund të perceptojë me ndihmën e shqisave, të mbajë në kujtesë dhe të përpunojë. Informacioni mund të paraqitet në forma të ndryshme: zë, shenjë, etj. Metoda e diskutuar më sipër për përcaktimin e sasisë së informacionit të marrë në mesazhe që zvogëlojnë pasigurinë e njohurive tona, e konsideron informacionin nga këndvështrimi i përmbajtjes së tij, risia dhe kuptueshmëria për një person. Nga ky këndvështrim, në përvojën e hedhjes së një zari, të njëjtën sasi informacioni përmbajnë mesazhet "dy", "fytyra ra lart, mbi të cilën ranë dy pika" dhe në imazhin vizual të zarit të rënë.

Gjatë transmetimit dhe ruajtjes së informacionit duke përdorur pajisje të ndryshme teknike, informacioni duhet të konsiderohet si një sekuencë karakteresh (numra, shkronja, kode ngjyrash të pikave të imazhit), pa marrë parasysh përmbajtjen e tij.

Duke marrë parasysh që alfabeti (një grup simbolesh të një sistemi shenjash) është një ngjarje, atëherë shfaqja e njërit prej simboleve në mesazh mund të konsiderohet si një nga gjendjet e ngjarjes. Nëse shfaqja e karaktereve është po aq e mundshme, atëherë mund të llogarisni sa pjesë informacioni mbart çdo karakter. Kapaciteti informativ i karaktereve përcaktohet nga numri i tyre në alfabet. Sa më shumë karaktere të përbëhet nga alfabeti, aq më shumë informacion mbart një personazh. Numri i përgjithshëm i simboleve në një alfabet quhet kardinaliteti i alfabetit.

Molekulat e ADN-së (acidi deoksiribonukleik) përbëhen nga katër përbërës të ndryshëm (nukleotide) që formojnë alfabetin gjenetik. Kapaciteti informativ i shenjës së këtij alfabeti është:

4 = 2 I , d.m.th. I = 2 bit.

Me këtë qasje, si rezultat i mesazhit për rezultatin e hedhjes së zarit, marrim një sasi të ndryshme informacioni. Për ta llogaritur atë, duhet të shumëzoni numrin e karaktereve me sasinë e informacionit që mbart një personazh.

Sasia e informacionit që përmban një mesazh i koduar me një sistem shenjash është i barabartë me sasinë e informacionit që mbart një karakter, shumëzuar me numrin e karaktereve në mesazh.

Sistemet e numrave pozicional

sistemi i numraveështë një grup metodash për emërtimin dhe shkrimin e numrave. Në çdo sistem numrash, simbole të caktuara zgjidhen për të përfaqësuar numrat (ato quhen shifrat), dhe pjesa tjetër e numrave janë marrë si rezultat i çdo operacioni në shifrat e këtij sistemi numrash.

Sistemi quhet pozicionale nëse vlera e secilës shifër (pesha e saj) ndryshon në varësi të pozicionit (pozicionit) të saj në sekuencën e shifrave që përfaqësojnë numrin.

Numri i njësive të çdo kategorie, të kombinuara në një njësi të rendit më të lartë, quhet bazën e sistemit të numrave pozicional. Nëse numri i shifrave të tilla është P, atëherë thirret sistemi i numrave P-ichny. Baza e një sistemi numrash është e njëjtë me numrin e shifrave të përdorura për të shkruar numrat në atë sistem numrash.

Shkrimi i një numri arbitrar x në P-sistemi i numrave pozicional ari bazohet në paraqitjen e këtij numri si polinom

x = a n P n + a n -1 P n -1 + ... + a 1 P 1 + a 0 P 0 + a -1 P -1 + ... + a -m P -m

Veprimet aritmetike mbi numrat në çdo sistem numrash pozicional kryhen sipas të njëjtave rregulla si në sistemin dhjetor, pasi të gjitha ato bazohen në rregullat për kryerjen e veprimeve në polinomet përkatëse. Në këtë rast, ju duhet vetëm të përdorni ato tabela të mbledhjes dhe shumëzimit që korrespondojnë me këtë bazë. P sistemet e numrave.

Gjatë konvertimit të numrave nga një sistem numrash dhjetorë në një sistem me bazë P> 1 zakonisht përdorin algoritmin e mëposhtëm:

1) nëse pjesa e plotë e numrit përkthehet, atëherë pjesëtohet me P, pas së cilës ruhet pjesa e mbetur e ndarjes. Koeficienti që rezulton përsëri pjesëtohet me P, pjesa e mbetur mbahet mend. Procedura vazhdon derisa herësi të bëhet zero. Mbetjet pas pjesëtimit me P lëshohen në rendin e kundërt të marrjes së tyre;

2) nëse pjesa thyesore e numrit përkthehet, atëherë shumëzohet me P, pas së cilës pjesa e plotë ruhet dhe hidhet. Pjesa thyesore e sapo përftuar shumëzohet me P etj. Procedura vazhdon derisa pjesa e pjesshme të bëhet zero. Pjesët e plota shkruhen pas presjes sipas renditjes që janë marrë. Rezultati mund të jetë ose një thyesë e fundme ose periodike në një sistem numrash me një bazë P. Prandaj, kur thyesa është periodike, duhet të ndërpresni shumëzimin në një hap dhe të jeni të kënaqur me shënimin e përafërt të numrit origjinal në sistemin me bazën. P.

Shembuj

1. Shndërroni këtë numër nga dhjetori në binar:

a) 464 (10); b) 380.1875 (10); c) 115.94 (10) (merrni pesë shifra dhjetore në paraqitjen binar).

Zgjidhje.

464 | 0 380 | 0 |1875 115 | 1 |94

232 | 0 190 | 0 0|375 57 | 1 1|88

116 | 0 95 | 1 0|75 28 | 0 1|76

58 | 0 47 | 1 1|5 14 | 0 1|52

a) 29 | 1 b) 23 | 1 1|0 c) 7 | 1 1|04

14 | 0 11 | 1 3 | 1 0|08

7 | 1 5 | 1 1 | 1 0|16

a) 464 (10) = 111010000 (2); b) 380.1875 (10) = 101111100.0011 (2); c) 115.94 (10) » 1110011.11110 (2) (në këtë rast janë marrë gjashtë shifra dhjetore, pas së cilës rezultati është rrumbullakosur).

Nëse është e nevojshme konverto numrin nga binar sistemi numerik në një sistem numrash baza e të cilit është fuqia e dy, mjafton të kombinohen shifrat e një numri binar në grupe me aq shifra sa edhe eksponenti dhe të përdoret algoritmi më poshtë. Për shembull, nëse përkthimi kryhet në sistemin oktal, atëherë grupet do të përmbajnë tre shifra (8 = 2 3). Pra, në pjesën e plotë do të grupojmë nga e djathta në të majtë, në pjesën e pjesshme - nga e majta në të djathtë. Nëse grupit të fundit i mungojnë shifra, shtoni zero: në pjesën e plotë - në të majtë, në pjesën e pjesshme - në të djathtë. Pastaj secili grup zëvendësohet nga shifra përkatëse e sistemit të ri. Përputhjet janë paraqitur në tabela.

Sistemet më të rëndësishme të numrave.

| Binar (Baza 2) | Oktale (baza 8) | dhjetore (baza 10) | Heksadecimal (baza 16) | ||

| treshe | tetrada | ||||

| 0 1 | 0 1 2 3 4 5 6 7 | 000 001 010 011 100 101 110 111 | 0 1 2 3 4 5 6 7 8 9 | 0 1 2 3 4 5 6 7 8 9 A B C D E F | 0000 0001 0010 0011 0100 0101 0110 0111 1000 1001 1010 1011 1100 1101 1110 1111 |

Kjo formulë, si formula Hartley, përdoret në shkencën kompjuterike për të llogaritur sasinë totale të informacionit për probabilitete të ndryshme.

Një shembull i probabiliteteve të ndryshme të pabarabarta është dalja e njerëzve nga kazermat në një njësi ushtarake. Një ushtar, një oficer, madje edhe një gjeneral mund të largohen nga kazermat. Por shpërndarja e ushtarëve, oficerëve dhe gjeneralëve në kazerma është e ndryshme, gjë që është e dukshme, sepse do të ketë më shumë ushtarë, pastaj oficerët vijnë në numër dhe lloji më i rrallë do të jenë gjeneralët. Meqenëse probabilitetet nuk janë të barabarta për të tre llojet e ushtrisë, për të llogaritur se sa informacion do të marrë dhe përdor një ngjarje e tillë formula e Shannon-it.

Për ngjarje të tjera po aq të mundshme, si për shembull hedhja e monedhës (probabiliteti që kokat ose bishtat të jenë të njëjta - 50%), përdoret formula e Hartley-t.

Tani, le të shohim zbatimin e kësaj formule në një shembull specifik:

Cili mesazh përmban më pak informacion (Numëroni në bit):

- Vasily hëngri 6 ëmbëlsira, 2 prej tyre ishin barberry.

- Ka 10 dosje në kompjuter, skedari i dëshiruar u gjet në dosjen e 9-të.

- Baba Luda bëri 4 byrekë me mish dhe 4 byrekë me lakër. Gregori hëngri 2 byrekë.

- Afrika ka 200 ditë mot të thatë dhe 165 ditë musone. një afrikan gjuante 40 ditë në vit.

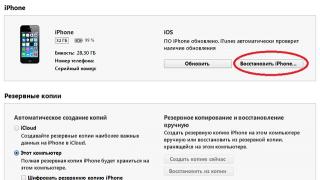

Në këtë problem, ne i kushtojmë vëmendje që opsionet 1, 2 dhe 3, këto opsione janë të lehta për t'u marrë në konsideratë, pasi ngjarjet janë po aq të mundshme. Dhe për këtë ne do të përdorim formulën Hartley I = log 2 N(Fig. 1) Por me pikën 4, ku shihet qartë se shpërndarja e ditëve nuk është e barabartë (mbizotërimi drejt motit të thatë), atëherë çfarë duhet të bëjmë në këtë rast? Për ngjarje të tilla, përdoret formula Shannon ose entropia e informacionit: I = - (p 1 log 2 p 1 + p 2 log 2 p 2 + . . . + p N log 2 p N),(fig.3)

FORMULA PËR SASINË E INFORMACIONIT (FORMULA HARTLEY, Fig. 1)

ku:

- I - sasia e informacionit

- p është probabiliteti që këto ngjarje të ndodhin

Ngjarjet me interes për ne në problemin tonë janë

- Kishte dy barberry nga gjashtë (2/6)

- Kishte një dosje në të cilën u gjet skedari i kërkuar në lidhje me numrin total (1/10)

- Gjithsej ishin tetë byrekë, nga të cilat Gregori hëngri dy (2/8)

- dhe dyzet ditët e fundit të gjuetisë në raport me dyqind ditët e thata, dhe dyzet ditët e gjuetisë deri në njëqind e gjashtëdhjetë e pesë ditë me shi. (40/200) + (40/165)

kështu marrim se:

FORMULA E PROBABILITETIT PËR NJË NGJARJE.

FORMULA E PROBABILITETIT PËR NJË NGJARJE.

Aty ku K është ngjarja me interes për ne, dhe N është numri i përgjithshëm i këtyre ngjarjeve, gjithashtu për të kontrolluar veten, probabiliteti i një ngjarjeje nuk mund të jetë më shumë se një. (sepse ka gjithmonë ngjarje më pak të mundshme)

FORMULA SHANNON PËR NUMËRIMIN E INFORMACIONIT (Fig. 3)

FORMULA SHANNON PËR NUMËRIMIN E INFORMACIONIT (Fig. 3)

Le të kthehemi në detyrën tonë dhe të llogarisim se sa informacion përmban.

Nga rruga, kur llogaritni logaritmin, është i përshtatshëm të përdorni sitin - https://planetcalc.ru/419/#

- Për rastin e parë - 2/6 = 0,33 = dhe më tej Log 2 0,33 = 1,599 bit

- Për rastin e dytë - 1/10 = 0,10 Log 2 0,10 = 3,322 bit

- Për të tretën - 2/8 = 0,25 = Regjistri 2 0,25 = 2 bit

- Për të katërtën - 40/200 + 40/165 = 0,2 dhe 0,24, përkatësisht, atëherë ne llogarisim sipas formulës - (0,2 * log 2 0,2) + - (o,24 * log 2 0,24) = 0,95856 bit

Kështu, përgjigja për problemin tonë doli 4.

Informacioni mund të jetë në formën:

tekste, vizatime, vizatime, fotografi;

sinjale të lehta ose të zërit;

valët e radios;

impulset elektrike dhe nervore;

rekorde magnetike;

gjestet dhe shprehjet e fytyrës;

ndjesi erë dhe shije;

kromozomet, nëpërmjet të cilave trashëgohen shenjat dhe vetitë e organizmave etj.

Objektet, proceset, dukuritë e një vetie materiale ose jomateriale, të konsideruara nga pikëpamja e vetive të tyre informative quhen objekte informacioni.

1.4. Si transmetohet informacioni?

Informacioni transmetohet në formën e mesazheve nga një burim informacioni te marrësi i tij përmes një kanali komunikimi ndërmjet tyre. Burimi dërgon një mesazh transmetues, i cili është i koduar në një sinjal transmetues. Ky sinjal dërgohet përmes një kanali komunikimi. Si rezultat, një sinjal i marrë shfaqet në marrës, i cili deshifrohet dhe bëhet mesazhi i marrë.

Një mesazh që përmban informacion në lidhje me parashikimin e motit i transmetohet marrësit (shikuesit) nga burimi - një meteorolog përmes një kanali komunikimi - pajisje transmetuese televizive dhe një TV.

Një qenie e gjallë me organet e saj shqisore (syri, veshi, lëkura, gjuha, etj.) percepton informacionin nga bota e jashtme, e përpunon atë në një sekuencë të caktuar impulsesh nervore, transmeton impulse përgjatë fibrave nervore, ruan në kujtesë në formën e një gjendja e strukturave nervore të trurit, riprodhohet në formën e sinjaleve zanore, lëvizjeve etj., përdor gjatë jetës së tij.

Transmetimi i informacionit përmes kanaleve të komunikimit shoqërohet shpesh me ndërhyrje që shkaktojnë shtrembërim dhe humbje të informacionit.

1.5. Si matet sasia e informacionit?

Sa informacion përmbajnë veprat e poetëve, shkrimtarëve, poetëve të mëdhenj apo në kodin gjenetik njerëzor? Shkenca nuk u jep përgjigje këtyre pyetjeve dhe, sipas të gjitha gjasave, nuk do t'i japë së shpejti. A është e mundur të matet në mënyrë objektive sasia e informacionit? Rezultati më i rëndësishëm i teorisë së informacionit është përfundimi i mëposhtëm:

Në kushte të caktuara, shumë të gjera, mund të neglizhohen veçoritë cilësore të informacionit, të shprehet sasia e tij si numër dhe gjithashtu të krahasohet sasia e informacionit që përmbahet në grupe të ndryshme të të dhënave.

Aktualisht, qasjet ndaj përkufizimit të konceptit të "sasës së informacionit" janë bërë të përhapura, bazuar në faktin se informacioni që përmban mesazhi mund të interpretohet lirshëm në kuptimin e risisë së tij ose, me fjalë të tjera, duke reduktuar pasigurinë e njohuritë tona për objektin. Këto qasje përdorin koncepte matematikore probabilitetet dhe logaritmi.

Qasjet për përcaktimin e sasisë së informacionit. Formulat e Hartley dhe Shannon.

inxhinier amerikan R. Hartley në vitin 1928, procesi i marrjes së informacionit u konsiderua si zgjedhja e një mesazhi nga një grup i caktuar paraprakisht i caktuar i mesazheve të barazvlefshme, dhe sasia e informacionit që unë përmbaja në mesazhin e zgjedhur u përcaktua si logaritmi binar N .

Formula Hartley: I = log 2 N

Supozoni se ju duhet të merrni me mend një numër nga një grup numrash nga një në njëqind. Duke përdorur formulën Hartley, mund të llogaritni se sa informacion kërkohet për këtë: I \u003d log 2 100 \u003d 6.644. Kështu, një mesazh për një numër të hamendësuar saktë përmban një sasi informacioni afërsisht të barabartë me 6.644 njësi informacioni.

Këtu janë të tjerët shembuj të mesazheve të barabarta:

kur hedh një monedhë: "Ranë bishtat", "Shqiponja ra";

në faqen e librit: "Numri i shkronjave është çift", "numri i shkronjave tek".

Le të përcaktojmë tani nëse mesazhet janë të mundshme “Gruaja do të dalë e para nga dera e ndërtesës” dhe "burri do të jetë i pari që do të largohet nga dera e ndërtesës". Është e pamundur t'i përgjigjemi kësaj pyetjeje pa mëdyshje. E gjitha varet se për çfarë lloj ndërtese po flasim. Nëse kjo është, për shembull, një kinema, atëherë probabiliteti për të dalë së pari nga dera është i njëjtë për një burrë dhe një grua, dhe nëse është një kazermë ushtarake, atëherë për një burrë kjo probabilitet është shumë më e lartë se për një grua. .

Për probleme të këtij lloji, një shkencëtar amerikan Claude Shannon propozoi në vitin 1948 një formulë tjetër për përcaktimin e sasisë së informacionit, duke marrë parasysh probabilitetin e mundshëm të pabarabartë të mesazheve në grup.

Formula Shannon: I = - (f 1 log 2 fq 1 +fq 2 log 2 fq 2 + . . . +fq N log 2 fq N ), ku p i- probabiliteti që i Mesazhi i th zgjidhet në grupin e N mesazheve.

Është e lehtë të shihet se nëse probabilitetet fq 1 , ..., fq N janë të barabarta, atëherë secili prej tyre është 1/N, dhe formula e Shannon-it kthehet në formulën e Hartley-t.

Përveç dy qasjeve të shqyrtuara për përcaktimin e sasisë së informacionit, ka edhe të tjera. Është e rëndësishme të mbani mend se çdo rezultat teorik është i zbatueshëm vetëm për një gamë të caktuar rastesh, të përshkruara nga supozimet fillestare.

Si njësi informacioni, Claude Shannon propozoi të merrte një të tillë pak (anglisht. pak - bi nari digit - shifra binare).

Bitnë teorinë e informacionit- sasia e informacionit që kërkohet për të dalluar dy mesazhe po aq të mundshme (të tilla si "koka" - "bisht", "çift" - "tek", etj.). Në informatikë bit është "pjesa" më e vogël e memories së kompjuterit që kërkohet për të ruajtur një nga dy karakteret "0" dhe "1" të përdorura për paraqitjen intramakine të të dhënave dhe komandave.

Pak është një njësi matëse shumë e vogël. Në praktikë, një njësi më e madhe përdoret më shpesh - bajt e barabartë me tetë bit. Janë tetë bit që kërkohen për të koduar ndonjë nga 256 karakteret e alfabetit të tastierës së kompjuterit (256=28).

Njësi edhe më të mëdha të përftuara informacioni përdoren gjithashtu gjerësisht:

1 Kilobyte (KB) = 1024 bytes = 2 10 bytes,

1 megabajt (MB) = 1024 KB = 2 20 bajt,

1 Gigabajt (GB) = 1024 MB = 230 bajte.

Kohët e fundit, për shkak të rritjes së vëllimit të informacionit të përpunuar, janë nxjerrë njësi të tilla si:

1 Terabajt (TB) = 1024 GB = 2 40 bajt,

1 Petabyte (PB) = 1024 TB = 250 bajt.

Për një njësi informacioni, mund të zgjidhni sasinë e informacionit të nevojshëm për të dalluar, për shembull, dhjetë mesazhe po aq të mundshme. Kjo nuk do të jetë një njësi informacioni binar (bit), por një njësi dhjetore (dit).