Përshëndetje, sot do të flasim se si të krijojmë txt-in e duhur të Robots dhe pse është i nevojshëm fare.

Përmbajtja:

Çfarë është robots txt

Në një nga artikujt tanë të mëparshëm, ne folëm se si funksionojnë robotët e kërkimit. Skedari robots txt jep udhëzime për kërkimin e robotëve se si të indeksoni siç duhet faqen tuaj. Duke përdorur direktivat, mund, për shembull, t'i tregoni robotit se cilat faqe ose direktori duhet të indeksohen dhe cilat jo, të krijoni një grup pasqyrash për faqen tuaj (nëse i keni), të specifikoni shtegun për në skedarin e hartës së faqes, etj. Përdoret kryesisht për të ndaluar indeksimin e faqeve të caktuara të një siti.

Si të krijoni robotët e duhur txt

Në çdo redaktues teksti, krijoni një skedar të quajtur robots txt. Pastaj, duke përdorur direktivat e përshkruara më poshtë, drejtojeni robotin në faqet e faqes që duhet të shtohen ose, anasjelltas, të hiqen nga rezultatet e kërkimit. Pasi të keni krijuar skedarin, kontrolloni atë për gabime duke përdorur Yandex Webmaster ose Google Search Console.

Vendosni skedarin e përfunduar në direktorinë rrënjë të faqes tuaj (ku ndodhet skedari index.html).

Direktiva e agjentit përdorues

Ky është një lloj përshëndetjeje për të kërkuar robotë.

Rreshti "User-agent:*" do t'u thotë të gjithë robotëve të kërkimit që të përdorin udhëzimet e përfshira në këtë skedar. Dhe, për shembull, rreshti "Agjent i përdoruesit: Yandex" do të japë udhëzime vetëm për robotin e kërkimit Yandex. Shembujt e përdorimit janë renditur më poshtë. Motorët e kërkimit kanë gjithashtu robotë ndihmës për kategori të ndryshme. Për shembull, YandexNews dhe Googlebot-News janë robotë për të punuar me lajmet.

Lejo dhe Mos lejo direktivat

Duke përdorur direktivën Disallow, ju specifikoni se cilat faqe ose drejtori të sajtit ndalohen të indeksohen. Dhe duke përdorur direktivën Lejo, në përputhje me rrethanat, është e mundur.

Shembuj:Agjenti përdorues:*

Mos lejo: /

Lejo:/katalog/

Një regjistrim i tillë do t'i informojë të gjithë robotët e kërkimit se nga i gjithë siti ata mund të indeksojnë vetëm drejtorinë e katalogut.

Nga rruga, simboli # ka për qëllim të përshkruajë komentet. Çdo gjë pas këtij karakteri dhe deri në fund të rreshtit nuk merret parasysh.

Ja një shembull robotë txt me udhëzime individuale për motorë të ndryshëm kërkimi:

#lejon robotin të indeksojë të gjithë sitin përveç seksionit të biçikletave

Agjenti përdorues:*

Mos lejo: /biçikleta/

#ndalon robotin të indeksojë sitin, përveç seksionit me varka

Agjenti i përdoruesit: Googlebot

Lejo: /barkat/

Mos lejo:/

#do të ndalojë të gjithë motorët e tjerë të kërkimit të indeksojnë faqen

Agjenti i përdoruesit: *

Mos lejo: /

shënim se nuk mund të ketë linja boshe midis direktivave User-agent, Allow dhe Disallow!

Karaktere speciale * dhe $

Në direktivat lejo dhe mos lejo, mund të përdorësh karakteret speciale * dhe $ për të specifikuar shprehjet e rregullta. *-zgjedh sekuencën e specifikuar

Për shembull: #I ndalon robotët të indeksojnë të gjitha faqet url-ja e të cilave përmban privateAgjenti përdorues:*

Mos lejo: /*privat

Si parazgjedhje, karakteri special * duhet të shtohet në fund të çdo rregulli. Dhe për të anuluar * në fund të rregullit, përdorni simbolin $.

Për shembull: # çaktivizon "/lock"# por nuk çaktivizon "/lock.html"

Agjenti përdorues:*

Mos lejo: /lock$# çaktivizon gjithashtu "/lock".

# dhe "/lock.html"

Agjenti përdorues:*

Mos lejo: /kyç

Karakteri special $ nuk e ndalon * të specifikuar në fund, domethënë:

Agjenti përdorues:*Mos lejo: /lock$# çaktivizon vetëm "/lock"

Mos lejo: /lock*$# njëjtë si "Mos lejo: /kyç"

# çaktivizon të dyja /lock.html dhe /lock

Direktiva e hartës së faqes

Nëse jeni duke përdorur një hartë faqeje, atëherë përdorni direktivën e hartës së faqes dhe specifikoni shtegun për në një (ose disa skedarë).

Agjenti përdorues:*harta e faqes: https://site.com/sitemap.xml

Direktiva e pritësit

Nëse faqja juaj ka pasqyra, atëherë duke përdorur këtë direktivë një robot i veçantë do të formojë një grup pasqyrash të faqes tuaj dhe do të përfshijë vetëm pasqyrën kryesore në kërkim. Kjo direktivë nuk garanton zgjedhjen e vendit të specifikuar në të si pasqyrë kryesore, por i jep prioritet të lartë kur merr një vendim.

Shembull:#tregon pasqyrën kryesore të faqes

Agjenti i përdoruesit: YandexMos lejo:/mg-admin

Pritësi: https://www.zerkalo.ru

shënim. Kjo direktivë përdoret ekskluzivisht për Yandex! + Vetëm një direktivë Host përpunohet për çdo skedar robots.txt. Nëse në skedar specifikohen disa direktiva, roboti përdor të parën.

Direktiva e hostit duhet të përmbajë:

- Protokolli HTTPS nëse pasqyra është e aksesueshme vetëm nëpërmjet një kanali të sigurt. Nëse jeni duke përdorur protokollin HTTP, nuk është e nevojshme ta specifikoni atë.

- Një emër i vlefshëm domeni që përputhet me RFC 952 dhe nuk është një adresë IP.

- Numri i portit, nëse është e nevojshme (Host: myhost.ru: 8080).

A është e mundur të përdoret cirilik në robotët txt?

Jo, nuk mund të përdorni alfabetin cirilik. Për të specifikuar emrat e domeneve në cirilik, përdorni, për shembull, këtë shërbim.

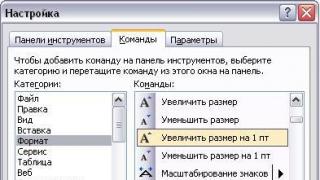

Konfigurimi i robotëve txt MogutaCMS

Në MogutaCMS, nuk keni nevojë të plotësoni robots.txt, sepse ai plotësohet automatikisht kur motori është i instaluar.

Tani ju e dini se si të vendosni robotët e duhur txt, dhe gjithashtu dini se si të përdorni direktiva të ndryshme për të menaxhuar indeksimin e faqes tuaj, dhe nëse keni ende ndonjë pyetje, ne jemi gati t'u përgjigjemi atyre në një diskutim të veçantë në VK ose në komentet më poshtë. Shihemi perseri!

Nëse po lexoni këtë artikull, keni një problem me shkrimin e duhur robots.txt. Ndoshta jeni njohur me bazat, keni parë disa udhëzime të tilla për pajisjet e kërkimit, dini parimin e përpilimit ose madje keni përvojë të gjerë në përpilimin e këtij skedari. Leximi i artikullit do të jetë i dobishëm dhe interesant për të gjithë. Sot do të shikojmë rregullat, gabimet dhe "formën e mirë" të krijimit të robotëve të duhur, si dhe korrigjimin e tij kur përdorni CMS popullore. Ne nuk do të flasim për bazat. Të gjithë duhet të dinë të gjitha rregullat themelore për krijimin dhe rregullimin e robotëve. Dhe nëse nuk i njihni, atëherë së pari duhet të shkoni te Ndihma Yandex, ku do të lexoni në detaje se si të krijoni robots.txt.

Gjithashtu, nëse po kërkoni se si të konfiguroni një skedar robots.txt për të kaluar nga HTTP në HTTPS, atëherë ja ku shkoni - Vendosja e një certifikate SSL

Pra, le të shkojmë!

Robotët mund të ndahen në dy grupe: "merimangat" dhe "qukapikët".

Merimangat ndjekin lidhjet e faqes, përgjatë strukturës së saj, duke mbledhur të gjitha të dhënat për përmbajtjen e sajtit gjithnjë e më thellë. Qukapikët prekin faqet e një faqeje, duke kontrolluar nëse këto faqe funksionojnë, nëse përdoruesit i shohin ato dhe nëse faqja nuk jep një gabim 404. Artikulli do të fokusohet në një robot merimangë, i cili, kur ndjek lidhjet e brendshme, udhëhiqet nga rregullat dhe ndalimet e specifikuara në skedarin robots.txt.Më poshtë do të përshkruaj gabimet e zakonshme të konfigurimit të robots.txt që unë vetë i kam parë dhe do t'ju tregoj se si mund të shmangen.

Gabime në përpilimin e robots.txt për një faqe interneti që kemi hasur

Udhëzime të përziera

Kam pasur nderin të shoh shumë skedarë robotësh në përvojën time, por ka pasur edhe absolutisht fantastikë dhe të pamundur. P.sh.

Agjenti i përdoruesit: /

Mos lejo: Yandex

Shpresoj se të gjithë e dinë se është e saktë të shkruhet kështu:

Agjenti i përdoruesit: Yandex

Mos lejo: /

Specifikimi i rregullave të shumta në një deklaratë

Unë gjithashtu pata fatin të shoh këtë turp në jetën time:

Mos lejo: /wp-admin/ /wp-includes/ /wp-feed/

Në këtë rast, nuk është e qartë se si do të sillet ky apo ai robot i motorit të kërkimit. Dikush mund ta pranojë këtë rregull së bashku - Mos lejo: /wp-admin/wp-includes/wp-feed/, një tjetër mund të marrë rregullin e parë (/wp-admin/) ose të fundit (/wp-feed/), dhe disa nuk do ta pranojë fare këtë linjë. Prandaj, ne nuk rrezikojmë dhe shkruajmë rregullat rresht pas rreshti, në udhëzime të veçanta:

Mos lejo: /wp-admin/

Mos lejo: /wp-includes/

Mos lejo: /wp-feed/

Gabime në emrin e skedarit

Gjatë jetës sime, ka pasur edhe disa raste shumë ekzotike. Doja të shikoja robotët e faqes, kështu që hyra http://site.ru/robots.txt, dhe përgjigja ishte një fik! "Ndoshta nuk ka asnjë dosje," mendova. Por kur hyra në strukturën e faqes u trondita! Kishte drejtshkrime të ndryshme:

- R obots.txt (me shkronja të mëdha);

- robot.txt (pa s);

- ROBOTS.TXT (!CAPSOM!).

Drejtshkrimi i saktë është natyrisht "robots.txt".

Vlera e zbrazët në agjentin e përdoruesit

Shumë shpesh në vendet e papërfunduara u gjet ndërtimi i mëposhtëm:

Agjent përdorues:

Mos lejo:

Per ke eshte? E paqartë. E vetmja gjë që është e qartë nga kjo është se ky mesazh nuk ka arritur në një robot të vetëm. Futni saktë emrin e robotit për të cilin janë caktuar udhëzimet e mëposhtme:

Agjenti i përdoruesit: Googlebot

Mos lejo:

Ndërveprimet ndërmjet udhëzimeve Disallow dhe Lejo

Shumë shpesh shoh shkrim të gabuar të udhëzimeve lejuese dhe ndaluese:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/

Mos lejo: /tools/

Lejo: /kartinki/

Së pari, menjëherë pas agjentit të përdoruesit duhet të ketë rregulla lejuese kalimi te roboti, dhe pas të gjitha udhëzimet Lejo duhet të ndiqen nga Disallow:

Agjenti i përdoruesit: Yandex

Lejo: /kartinki/

Mos lejo: /admin/

Mos lejo: /tools/

Kërkesat për hartimin e direktivës së Pritësit

Disa njerëz kopjojnë URL-në e faqes dhe pa turp, pa e parë, e ngjisin atë në direktivën Host së bashku me http:

Gabim i rëndë! Nuk keni nevojë të specifikoni protokollin HTTP. Por protokolli i sigurt HTTPS në robots.txt është i nevojshëm, sepse... i tregon robotit se si ta pozicionojë saktë burimin:

Gjithashtu, nuk duhet të futni disa direktiva të Host-it në robots.txt. Ai ende do të lexojë dhe perceptojë vetëm të parën. Kështu që ne vendosim Host në seksionin Yandex pas të gjitha rregullave:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/

Mos lejo: /tools/

Pritësi: faqja e internetit

Mbani mend: direktivat në skedarin robots.txt që janë kompozuar gabimisht nuk merren parasysh! Për shembull:

- Pritësi: www.-yourresurs.ru

- Pritësi: www.yourresource-.ru

- Pritësi: www.yourresurs.ru:100000

- Pritësi: www.your_resource.ru

- Pritësi: .your-resource.ru:8000

- Pritësi: your..resource.ru

- Pritësi: your-resource.ru.

- Pritësi: 215.160.195.128

- Pritësi: www.yourresurs.ru:8080/

- Pritësi: www.pervyresurs.ru www.secondresurs.ru

- Pritësi: www.first resource.ru, www.second resource.ru

Është praktikë e mirë të krijoni një skedar robots.txt.

Në këtë seksion do të shikojmë "stilin e keq" të krijimit të robots.txt. Çdo kod ose shënim ka rregullat e veta të pathëna ose të shkruara, të cilat pak njerëz i ndjekin, të cilat mund të çojnë në pasoja katastrofike. Në rastin e një skedari të ndalimit të indeksimit, mund të lindin keqkuptime midis robotit të motorit të kërkimit dhe skedarit, ose programuesi i ri (i ardhshëm) i projektit mund të mos kuptojë ose mund të marrë shumë kohë për të kuptuar atë që është shkruar. Prandaj, ne shmangim keqkuptimet e pakëndshme të mëposhtme.

Koment me një rresht me rregulla dhe udhëzime

Në përgjithësi, një regjistrim i tillë është i mundur, por jo i këshillueshëm:

Mos lejo: /admin/ #prevent robots nga indeksimi i drejtorisë së administratorit

Më parë, disa sisteme nuk i kuptonin vargjet e tilla. Tani, mendoj se motorët e kërkimit janë përshtatur me shumë nga gjërat e këqija me të cilat përballen webmasterët, por është më mirë të mos rrezikoni dhe të shkruani një koment në një linjë të re.

Ridrejtimi i një faqe në një gabim 404:

Ka situata kur, kur zhvillon një projekt të ri, programuesi harron skedarin e robotëve dhe kur një "merimangë" hyn në sit, dhe kjo sigurisht që do të ndodhë pa këtë skedar, burimi e ridrejton atë në një faqe tjetër. Ndodh që një ridrejtim i tillë i veçantë ndodh pa u kthyer 404 Not Found. Për të shmangur këtë, ju këshilloj të vendosni skedarin e duhur robots.txt në rrënjën e faqes. Këshillohet gjithashtu të mos jeni dembel dhe të shkruani në të:

Agjenti i përdoruesit: *

Mos lejo:

Ky është robots.txt i hapur. Nëse keni nevojë të bllokoni një faqe nga indeksimi në kohën e zhvillimit ose situatave aktuale, atëherë natyrisht ne përdorim:

Agjenti i përdoruesit: *

Mos lejo: /

Shkronjat e mëdha në udhëzime

AGJENTI PËRDORUES: YANDEX

MUNDONI: /ADMIN/

Nuk ka komente këtu. Thjesht bëhu njeri! Shkruani saktë:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/

Renditja e të gjithë skedarëve në një direktori

Ndonjëherë kur po bëja optimizimin, hasa në diçka si ndërtimi i mëposhtëm:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/backup/

Mos lejo: /admin/cache/

Mos lejo: /admin/components/

Mos lejo: /admin/modules/

Mos lejo: /admin/themes/

Mos lejo: /admin/wizards/

Dhe kështu programuesi i mëparshëm mbylli të gjitha dosjet e foleve Admin. Edhe pse mjaftonte thjesht të shkruante:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/

Nëse vërtet duhet të hapni disa drejtori brenda një dosjeje të mbyllur, atëherë përdorni këtë metodë:

Agjenti i përdoruesit: Yandex

Lejo: /admin/css/

Lejo: /admin/images/

Mos lejo: /admin/

Shkrimi i direktivave shtesë në seksione

Për disa kohë, kishte debate në kompaninë tonë: ku të vendoset direktiva e Host? Në cilin seksion: në seksionin e përgjithshëm apo pas të gjitha rregullave në fund të skedarit? Punonjësit tanë kanë ndjekur kurse të kualifikuara tek Unibrains, Top Expert etj., duke sjellë njohuri dhe vizione të ndryshme për këtë çështje. Duket sikur askush nuk dinte të kompozonte robots.txt dhe ku ta shkruante saktë këtë direktivë. Në fakt, disa robotë mund të reagojnë gabimisht ndaj përdorimit të direktivave shtesë, që do të thotë se nuk duhet t'i shkruani ato në seksionet * - (për të gjithë). Shkruani Host në seksionin për robotin Yandex:

Agjenti i përdoruesit: Yandex

Mos lejo: /admin/

Pritësi: faqja e internetit

Agjenti i përdoruesit: *

Mos lejo: /admin/

Mungesa e udhëzimit të moslejimit

Ky udhëzim është i detyrueshëm dhe për shkak të mungesës së tij, roboti mund t'ju keqkuptojë.

Agjenti i përdoruesit: Yandex

Pritësi: faqja e internetit

Ne shkruajmë saktë:

Agjenti i përdoruesit: Yandex

Mos lejo: /wp-admin/

Pritësi: faqja e internetit

Nuk ka prerje kur specifikoni një drejtori

Kam kryer një eksperiment për të treguar se mungesa e prerjeve në udhëzime perceptohet nga roboti si një gabim.

Nëse duam të mbyllim diçka, shkruajmë një rregull vetëm me prerje!

Agjenti i përdoruesit: Yandex

Mos lejo: /blog/

Si dhe ku të regjistrohet seksioni i Hartës së Faqes në robotë

Shumë shpesh kam hasur në interpretim të gabuar të linjës Sitemap. Fakti është se ata vazhdimisht përpiqeshin ta lidhnin diku: ose ishte futur për secilin agjent, ose nuk e di si dhe ku ta vendos, por ishte futur vetëm në një agjent pas të gjitha udhëzimeve për bot. Do të ishte e saktë të shkruani Hartën e Faqes në robots.txt pas të gjithë agjentëve në fund të skedarit, duke e ndarë këtë rregull me një rresht bosh pas udhëzimit të fundit për robotin e fundit:

Agjenti i përdoruesit: * ...

Mos lejo: /postednee-pravilo/

Harta e faqes: http://mysite.ru/sitemap.xml

Karakteristikat e robots.txt që shumë nuk i përdorin

Në këtë paragraf, ne do të shikojmë veçoritë dhe komandat shtesë për skedarin robots.txt, të cilat përdoren pak nga webmasterët, optimizuesit dhe programuesit. Nuk do të diskutoj këtu për aftësitë e Crawl-delay, Clean-param dhe direktiva dhe rregulla të tjera që janë tashmë të disponueshme në help.yandex.

Ndërveprimi ndërmjet faqeve të rregullta dhe faqeve për Google AdWords

Nëse dëshironi të vendosni reklama të Google në disa nga faqet tuaja të internetit, por nuk dëshironi që këto faqe të jenë në indeksin e Google, duhet të përdorni agjentin Mediapartners-Google. Për ta bërë këtë, ne bllokojmë faqet në Google dhe i hapim ato (ose të gjithë sitin) për reklamim:

Agjenti i përdoruesit: Googlebot

Mos lejo: /admin/

Mos lejo: /search/

Përdoruesi-agjent: Mediapartners-Google

Lejo: /reklamnaya-stranica/

Por mbani mend se seksioni Mediapartners-Google duhet të vendoset pas të gjithë agjentëve, duke përfshirë "*" - për të gjithë. Përndryshe, do të rezultojë që fillimisht e lejoni botin të kalojë nëpër këto faqe dhe më pas e mohoni dhe në fund nuk do të bëjë asgjë.

Ndërveprimi midis faqeve të rregullta dhe faqeve për Yandex Direct

E njëjta gjë si me Google AdWords. Ne mbyllim atë që nuk na nevojitet dhe hapim atë që na nevojitet për reklamim në agjentin YaDirectBot:

Agjenti i përdoruesit: *

Mos lejo: /admin/

Mos lejo: /search/

Mos lejo: /reklamnaya-stranica/

Agjenti i përdoruesit: YaDirectBot

Lejo: /reklamnaya-stranica/

Përsëri, mos harroni ta vendosni këtë seksion poshtë të gjithë të tjerëve! Ju mund të vendosni YaDirectBot dhe Mediapartners-Google së bashku në fund, përpara udhëzimeve për Hartën e Faqes.

Hapja e imazheve për indeksim në Yandex Images dhe Google Images

Në mënyrë që imazhet tuaja në sit të përfshihen në bazat e të dhënave të imazheve Yandex dhe Google, ne regjistrojmë agjentët e mëposhtëm:

Përdoruesi-agjent: Googlebot-Image

Lejo: /temat/imazhet/

Agjenti i përdoruesit: YandexImages

Lejo: /temat/imazhet/

Mos harroni të përfshini atributin e saktë alt në imazhet tuaja në mënyrë që imazhet tuaja të mund të gjenden në kërkime.

Blloko një pjesë të tekstit nga indeksimi

Për të filluar, unë do të doja të tërhiqja vëmendjen tuaj për faktin se kjo metodë funksionon vetëm në Yandex dhe Rambler! Google kjo etiketë është një punë e madhe! Noindex është një etiketë që bllokon indeksimin e pjesës së nevojshme të përmbajtjes nga roboti. Është i ngjashëm me meta etiketën noindex, por synohet të përdoret vetëm në tekst. Zakonisht ata janë të bllokuar nga numëruesit e indeksimit.

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Phasellus convallis viverra diam sed pretium. Nam ut orci ut arcu ornare pretium ut a diam. Nunc ac tempus ague. Morbi in molestie massa. Në hac habitasse platea dictumst. Në quis maximus libero. Ut varius dolor et justo hendrerit mollis. Vivamus në semper mi, et hendrerit lacus. Pellentesque quis mollis felis. Etiam eu hendrerit libero.

Etiketa noindex nuk është e vlefshme dhe kur kontrollohet nga një validator jep një gabim.Që të kalojë verifikimin e maskojmë si koment... . Kjo metodë funksionon!

Dmitry Semenov

lockki.ru, ekspert i pavarur

Në një mënyrë apo tjetër, robots.txt duhet të përpilohet sipas rregullave. Për të përshpejtuar përpilimin e robots.txt, unë kam përgatitur një koleksion skedarësh për 22 CMS të njohura, të cilat thjesht duhet t'i modifikoni pak për faqen tuaj.

10 rregulla për krijimin e një skedari robots.txt nga Dmitry

- Skedari duhet të quhet robots.txt dhe asgjë tjetër.

- Duhet të jetë në rrënjë të faqes, d.m.th. vashsite.ru/robots.txt

- Mbyllni të gjitha seksionet teknike: shtojcat, paneli i administratorit, etj.

- Rregullat shkruhen veçmas për çdo robot, d.m.th. në direktivën e agjentit të përdoruesit ka vetëm 1 robot dhe asnjë numërim.

- Nëse dëshironi të caktoni rregulla për të gjithë robotët, atëherë agjenti i përdoruesit: *

- Host është shkruar vetëm një herë dhe vetëm për Yandex, ky është agjenti i përdoruesit: Yandex

- 1 direktivë = 1 vlerë, d.m.th. Mos lejo: /admin, dhe jo Mos lejo: /admin /manage, etj. në një rresht.

- Mos lejo hyrjen e bllokon, Lejo lejon hyrjen.

- Mos i bllokoni imazhet nga indeksimi.

- Mbyllni faqet kryesore të kopjuara që janë krijuar nga CMS-ja juaj.

Vitaly Kravchenko

Shef i agjencisë Webline Promotion, optimizues dhe tregtar interneti me përvojë, dashnor i eksperimenteve dhe përvojave

Çfarë duhet t'i kushtoni vëmendje kur krijoni skedarin tuaj robots.txt

Sipas mendimit tim, një nga gabimet më të zakonshme është se shumë optimizues fillestar e perceptojnë skedarin Robots.txt si rregull për robotët e kërkimit, por në fakt ky skedar është vetëm një rekomandim. Para së gjithash, natyrisht, duhet të keni një kuptim të qartë të strukturës - atëherë krijimi i skedarit robots.txt në mënyrë korrekte do të jetë shumë më i lehtë. Drejtimi i gishtit drejt qiellit mund të shkaktojë shumë probleme me indeksimin dhe të shpëtojë sitin nga mundësia për të përmirësuar performancën e tij në kapitujt e motorit të kërkimit. Nëse faqja nuk është më e re dhe është e qëndrueshme në indeksin e motorit të kërkimit, kur përpiloni skedarin, sigurohuni që të analizoni faqet e indeksuara. Nëse jo, duhet të identifikoni faqet dhe skedarët privatë dhe të sistemit që duhet të mbyllen. Dhe sigurisht, është e rëndësishme të kontrolloni nëse motori i kërkimit e percepton vërtet skedarin tuaj apo jo. Shumë shpesh, faktori njerëzor ose mungesa e njohurive të nevojshme ka një ndikim shumë negativ në procesin e promovimit. Nëse jeni duke mbikëqyrur punën e një optimizuesi fillestar, duhet të kontrolloni gjithmonë se çfarë është bërë në këtë skedar përpara se ta publikoni atë.

Nga përvoja ime mund të vërej një algoritëm të caktuar:

- Ne përcaktojmë faqet funksionale statike (paneli i administratorit, karrocat e blerjeve, faqet e hyrjes, faqja e kujtesës së fjalëkalimit, etj.) - krijoni një listë.

- Ne përcaktojmë faqet e mbeturinave dinamike dhe standarde (faqe të printuara, faqe krahasimi, grupe filtrash jo të promovuar, etj.).

- Ne përcaktojmë dosje me skedarë dhe imazhe që nuk duhet të indeksohen.

- Gjenerimi i skedarit Robots.txt

Shumica e robotëve janë të dizajnuar mirë dhe nuk shkaktojnë asnjë problem për pronarët e faqeve të internetit. Por nëse roboti është shkruar nga një amator ose "diçka shkoi keq", atëherë ai mund të krijojë një ngarkesë të konsiderueshme në faqen që zvarritet. Nga rruga, merimangat nuk hyjnë fare në server si viruset - ata thjesht kërkojnë faqet që u nevojiten nga distanca (në fakt, këto janë analoge të shfletuesve, por pa funksionin e shikimit të faqeve).

Robots.txt - direktiva e agjentëve të përdoruesve dhe robotët e motorit të kërkimit

Robots.txt ka një sintaksë shumë të thjeshtë, e cila përshkruhet në detaje, për shembull, në Ndihmë Yandex Dhe Ndihma e Google. Zakonisht tregon se për cilin bot kërkimi synohen direktivat e mëposhtme: emri i botit (" Përdorues-agjent"), duke lejuar (" Lejo") dhe duke ndaluar (" Mos lejo"), dhe "Sitemap" përdoret gjithashtu në mënyrë aktive për t'u treguar motorëve të kërkimit saktësisht se ku ndodhet skedari i hartës.

Standardi u krijua shumë kohë më parë dhe diçka u shtua më vonë. Ka direktiva dhe rregulla projektimi që do të kuptohen vetëm nga robotët e disa motorëve të kërkimit. Në RuNet, vetëm Yandex dhe Google janë me interes, që do të thotë se duhet të njiheni me ndihmën e tyre në përpilimin e robots.txt në detaje të veçanta (kam dhënë lidhjet në paragrafin e mëparshëm).

Për shembull, më parë ishte e dobishme që motori i kërkimit Yandex të tregonte se projekti juaj në internet është kryesori në një direktivë speciale "Host", të cilën vetëm ky motor kërkimi e kupton (epo, gjithashtu Mail.ru, sepse kërkimi i tyre është nga Yandex ). Vërtetë, në fillim të 2018 Yandex ende anuloi Host dhe tani funksionet e tij, si ato të motorëve të tjerë të kërkimit, kryhen nga një ridrejtim 301.

Edhe nëse burimi juaj nuk ka pasqyra, do të jetë e dobishme të tregoni se cili opsion drejtshkrimor është kryesori - .

Tani le të flasim pak për sintaksën e këtij skedari. Direktivat në robots.txt duken kështu:

<поле>:<пробел><значение><пробел> <поле>:<пробел><значение><пробел>

Kodi i saktë duhet të përmbajë të paktën një direktivë “Mos lejo”. pas çdo hyrjeje “Agjent-përdorues”. Një skedar bosh merr leje për të indeksuar të gjithë faqen.

Përdorues-agjent

Direktiva "përdorues-agjent". duhet të përmbajë emrin e robotit të kërkimit. Duke e përdorur atë, mund të vendosni rregulla sjelljeje për çdo motor kërkimi specifik (për shembull, krijoni një ndalim për indeksimin e një dosje të veçantë vetëm për Yandex). Një shembull i shkrimit të "Agjent-përdorues" drejtuar të gjithë robotëve që vizitojnë burimin tuaj duket si ky:

Agjenti i përdoruesit: *

Nëse dëshironi të vendosni kushte të caktuara në "Agjent-përdorues" vetëm për një bot, për shembull, Yandex, atëherë duhet të shkruani këtë:

Agjenti i përdoruesit: Yandex

Emri i robotëve të motorit të kërkimit dhe roli i tyre në skedarin robots.txt

Bot i çdo motori kërkimi ka emrin e vet (për shembull, për një rambler është StackRambler). Këtu do të jap një listë të më të famshmeve prej tyre:

Google http://www.google.com Googlebot Yandex http://www.ya.ru Yandex Bing http://www.bing.com/ bingbot

Motorët e mëdhenj të kërkimit ndonjëherë kanë përveç robotëve kryesorë, ka edhe raste të veçanta për indeksimin e blogjeve, lajmeve, imazheve, etj. Mund të merrni shumë informacione për llojet e robotëve (për Yandex) dhe (për Google).

Si të jesh në këtë rast? Nëse duhet të shkruani një rregull për ndalimin e indeksimit, të cilin duhet të ndjekin të gjitha llojet e robotëve të Google, atëherë përdorni emrin Googlebot dhe të gjitha merimangat e tjera të këtij motori kërkimi do t'i binden gjithashtu. Megjithatë, ju mund të ndaloni, për shembull, indeksimin e fotove vetëm duke specifikuar robotin Googlebot-Image si agjent-përdorues. Tani kjo nuk është shumë e qartë, por me shembuj, mendoj se do të jetë më e lehtë.

Shembuj të përdorimit të direktivave Disallow dhe Allow në robots.txt

Unë do t'ju jap disa të thjeshta. shembuj të përdorimit të direktivave me shpjegimin e veprimeve të tij.

- Kodi më poshtë i lejon të gjithë robotët (të treguar me një yll në agjentin e përdoruesit) të indeksojnë të gjithë përmbajtjen pa asnjë përjashtim. Kjo është dhënë direktiva boshe Mos lejo. Agjenti i përdoruesit: * Mos lejo:

- Kodi i mëposhtëm, përkundrazi, ndalon plotësisht të gjithë motorët e kërkimit të shtojnë faqe të këtij burimi në indeks. E vendos këtë në Disallow me "/" në fushën e vlerës. Agjenti i përdoruesit: * Mos lejo: /

- Në këtë rast, të gjithë robotët do të ndalohen të shikojnë përmbajtjen e drejtorisë /image/ (http://mysite.ru/image/ është rruga absolute për në këtë drejtori) Agjenti i përdoruesit: * Mos lejo: /image/

- Për të bllokuar një skedar, do të mjaftojë të regjistrohet shtegu i tij absolut drejt tij (lexo): Përdoruesi-agjent: * Mos lejo: /katalog1//katalog2/private_file.html

Duke parë pak përpara, do të them se është më e lehtë të përdorësh simbolin yll (*) për të mos shkruar shtegun e plotë:

Mos lejo: /*private_file.html

- Në shembullin e mëposhtëm, drejtoria "image" do të ndalohet, si dhe të gjithë skedarët dhe drejtoritë që fillojnë me karakteret "image", d.m.th. skedarët: "image.htm", "images.htm", drejtoritë: "image", “imazhe1”, “image34”, etj.): Agjent përdorues: * Mos lejo: /image Fakti është se si parazgjedhje në fund të hyrjes ka një yll, i cili zëvendëson çdo karakter, përfshirë mungesën e tyre. Lexoni për të më poshtë.

- Duke përdorur Lejo direktivat ne lejojmë aksesin. Komplementet Mos lejojnë mirë. Për shembull, me këtë kusht, ne e ndalojmë robotin e kërkimit Yandex të shkarkojë (indeksojë) gjithçka, përveç faqeve në internet, adresa e të cilave fillon me /cgi-bin: Agjenti i përdoruesit: Yandex Allow: /cgi-bin Disallow: /

Epo, ose ky shembull i qartë i përdorimit të kombinimit Lejo dhe Mos lejo:

Përdoruesi-agjent: * Mos lejo: /catalog Lejo: /catalog/auto

- Kur përshkruani shtigjet për direktivat Lejo-Mos lejo, mund të përdorni simbolet "*" dhe "$", duke përcaktuar kështu shprehje të caktuara logjike.

- Simboli "*"(yll) nënkupton çdo sekuencë (përfshirë bosh) karakteresh. Shembulli i mëposhtëm ndalon të gjithë motorët e kërkimit të indeksojnë skedarët me shtesën “.php”: Agjenti i përdoruesit: * Mos lejo: *.php$

- Pse është e nevojshme në fund? shenjë $? Fakti është se, sipas logjikës së përpilimit të skedarit robots.txt, një yll i paracaktuar shtohet në fund të çdo direktive (nuk është atje, por duket se është atje). Për shembull, ne shkruajmë: Disallow: /images

Duke nënkuptuar se kjo është e njëjtë si:

Mos lejo: /images*

Ato. ky rregull ndalon indeksimin e të gjithë skedarëve (faqet e internetit, fotografitë dhe llojet e tjera të skedarëve) adresa e të cilëve fillon me /images, dhe më pas çdo gjë vijon (shih shembullin më lart). Kështu që, simboli $ ai thjesht anulon yllin e paracaktuar në fund. Për shembull:

Mos lejo: /images$

Parandalon vetëm indeksimin e skedarit /images, por jo /images.html ose /images/primer.html. Epo, në shembullin e parë, ne ndaluam indeksimin e vetëm skedarëve që mbarojnë me .php (që kanë një shtrirje të tillë), në mënyrë që të mos kapim asgjë të panevojshme:

Mos lejo: *.php$

Ylli pas pikëpyetjes sugjeron vetveten, por, siç zbuluam pak më lart, tashmë nënkuptohet në fund. Kështu, ne do të ndalojmë indeksimin e faqeve të kërkimit dhe faqeve të tjera të shërbimit të krijuara nga motori, të cilat roboti i kërkimit mund të arrijë. Nuk do të jetë e tepërt, sepse pikëpyetja përdoret më shpesh nga CMS si identifikues i sesionit, gjë që mund të çojë në përfshirjen e faqeve të kopjuara në indeks.

Harta e faqes dhe direktivat e hostit (për Yandex) në Robots.txt

Për të shmangur problemet e pakëndshme me pasqyrat e faqes, më parë ishte rekomanduar të shtoni një direktivë Host në robots.txt, e cila e drejtoi botin Yandex në pasqyrën kryesore.

Direktiva e hostit - tregon pasqyrën kryesore të faqes për Yandex

Për shembull, më herët nëse ju nuk kanë kaluar ende në një protokoll të sigurt, ishte e nevojshme të tregohej në Host jo URL-ja e plotë, por emri i domenit (pa http://, d.m.th.ru). Nëse tashmë keni kaluar në https, atëherë do t'ju duhet të tregoni URL-në e plotë (si p.sh. https://myhost.ru).

Një mjet i mrekullueshëm për të luftuar përmbajtjen e kopjuar - motori i kërkimit thjesht nuk do të indeksojë faqen nëse një URL tjetër është regjistruar në Canonical. Për shembull, për një faqe të tillë të blogut tim (faqe me faqezim), Canonical tregon në https://site dhe nuk duhet të ketë probleme me kopjimin e titujve.

Por unë devijoj ...

Nëse projekti juaj është krijuar në bazë të ndonjë motori, atëherë Do të ndodhë përmbajtje e kopjuar me një probabilitet të lartë, që do të thotë se ju duhet ta luftoni atë, duke përfshirë me ndihmën e një ndalimi në robots.txt, dhe veçanërisht në meta etiketën, sepse në rastin e parë Google mund të injorojë ndalimin, por nuk do të jetë më në gjendje për të marrë një mallkim për meta-etiketën (e ngritur në atë mënyrë).

Për shembull, në WordPress, faqet me përmbajtje shumë të ngjashme mund të indeksohen nga motorët e kërkimit nëse lejohet indeksimi i përmbajtjes së kategorive, përmbajtjes së arkivit të etiketave dhe përmbajtjes së përkohshme të arkivit. Por nëse, duke përdorur meta-etiketën Robots të përshkruar më sipër, krijoni një ndalim në arkivin e etiketave dhe arkivin e përkohshëm (mund të lini etiketat dhe të ndaloni indeksimin e përmbajtjes së kategorive), atëherë dyfishimi i përmbajtjes nuk do të ndodhë. Si ta bëni këtë përshkruhet në lidhjen e dhënë pak më lart (në shtojcën OlInSeoPak)

Për ta përmbledhur, do të them se skedari Robots ka për qëllim vendosjen e rregullave globale për të mohuar aksesin në të gjitha drejtoritë e faqeve, ose në skedarë dhe dosje, emrat e të cilëve përmbajnë karaktere të specifikuara (me maskë). Ju mund të shihni shembuj të vendosjes së ndalimeve të tilla vetëm më lart.

Tani le të shohim shembuj specifikë të robotëve të krijuar për motorë të ndryshëm - Joomla, WordPress dhe SMF. Natyrisht, të tre opsionet e krijuara për CMS të ndryshme do të ndryshojnë ndjeshëm (nëse jo rrënjësisht) nga njëra-tjetra. Vërtetë, të gjithë do të kenë një gjë të përbashkët, dhe ky moment është i lidhur me motorin e kërkimit Yandex.

Sepse Në RuNet, Yandex ka mjaft peshë, atëherë duhet të marrim parasysh të gjitha nuancat e punës së tij, dhe këtu ne Direktiva e Pritësit do të ndihmojë. Ai do t'i tregojë në mënyrë eksplicite këtij motori kërkimi pasqyrën kryesore të faqes tuaj.

Për këtë, rekomandohet të përdorni një blog të veçantë të agjentit të përdoruesit, i destinuar vetëm për Yandex (Agjent i përdoruesit: Yandex). Kjo për faktin se motorët e tjerë të kërkimit mund të mos e kuptojnë Host-in dhe, në përputhje me rrethanat, përfshirja e tij në rekordin e agjentit të përdoruesit të destinuar për të gjithë motorët e kërkimit (Agjent përdorues: *) mund të çojë në pasoja negative dhe indeksim të gabuar.

Është e vështirë të thuash se cila është situata në të vërtetë, sepse algoritmet e kërkimit janë një gjë më vete, kështu që është më mirë të bësh siç këshillohet. Por në këtë rast, do të duhet të kopjojmë në direktivën User-agent: Yandex të gjitha rregullat që kemi vendosur User-agent: *. Nëse e lini agjentin e përdoruesit: Yandex me një Disallow bosh:, atëherë në këtë mënyrë do të lejoni Yandex të shkojë kudo dhe të tërhiqni gjithçka në indeks.

Robotët për WordPress

Unë nuk do të jap një shembull të një skedari që rekomandojnë zhvilluesit. Mund ta shikoni vetë. Shumë blogerë nuk i kufizojnë fare bots Yandex dhe Google në shëtitjet e tyre nëpër përmbajtjen e motorit WordPress. Më shpesh në blog mund të gjeni robotë të mbushur automatikisht me një shtesë.

Por, për mendimin tim, ne duhet të ndihmojmë përsëri kërkimin në detyrën e vështirë të shoshitjes së grurit nga byku. Së pari, do të duhet shumë kohë që robotët e Yandex dhe Google të indeksojnë këto mbeturina dhe mund të mos mbetet më kohë për të shtuar faqe në internet me artikujt tuaj të rinj në indeks. Së dyti, robotët që zvarriten nëpër skedarët e motorit të mbeturinave do të krijojnë ngarkesë shtesë në serverin e hostit tuaj, gjë që nuk është e mirë.

Ju mund ta shihni vetë versionin tim të këtij skedari. Është e vjetër dhe nuk është ndryshuar për një kohë të gjatë, por unë përpiqem të ndjek parimin "mos e rregulloni atë që nuk është prishur" dhe ju takon juve të vendosni: përdorni atë, bëni tuajën ose vidhni dikush tjeter. Kam pasur edhe një ndalim të indeksimit të faqeve me faqe deri vonë (Mos lejo: */page/), por së fundmi e hoqa duke u mbështetur në Canonical, për të cilin shkrova më lart.

Por në përgjithësi, i vetmi skedar i saktë për WordPress ndoshta nuk ekziston. Ju, natyrisht, mund të zbatoni çdo parakusht në të, por kush tha që ato do të jenë të sakta. Ka shumë mundësi për robots.txt ideal në internet.

Unë do të jap dy ekstreme:

- mund të gjeni një megafile me shpjegime të hollësishme (simboli # ndan komentet që do të fshiheshin më mirë në një skedar real): Agjenti i përdoruesit: * # rregulla të përgjithshme për robotët, përveç Yandex dhe Google, # sepse për ta rregullat janë më poshtë Mos lejo: /cgi-bin # folder në hosting Mos lejo: /? # të gjithë parametrat e kërkesës në faqen kryesore Mos lejo: /wp- # të gjithë skedarët WP: /wp-json/, /wp-includes, /wp-content/plugins Mos lejo: /wp/ # nëse ka një nëndrejtori /wp/ ku CMS është instaluar (nëse jo, # rregulli mund të fshihet) Mos lejo: *?s= # kërkim Mos lejo: *&s= # kërkim Mos lejo: /search/ # kërko Mos lejo: /autor/ # arkiv autori Mos lejo: /users/ # arkiv autori Mos lejo: */ përcjellje # përcjellje, njoftime në komente rreth shfaqjes së një lidhjeje të hapur # për një artikull Mos lejo: */feed # të gjitha burimet Mos lejo: */rss # rss furnizim Mos lejo: */embed # të gjitha ngulitje Mos lejo : */wlwmanifest.xml # manifest xml file Windows Live Writer (nëse nuk e përdorni, # rregulli mund të fshihet) Mos lejo: /xmlrpc.php # Skedar API WordPress Mos lejo: *utm= # lidhje me etiketa utm Mos lejo : *openstat= # lidhje me etiketa openstat Lejo: */uploads # hap dosjen me ngarkimet e skedarëve Agjenti i përdoruesit: GoogleBot # rregulla për Google (nuk i kopjoj komentet) Mos lejo: /cgi-bin Mos lejo: /? Mos lejo: /wp- Mos lejo: /wp/ Mos lejo: *?s= Mos lejo: *&s= Mos lejo: /search/ Mos lejo: /autor/ Mos lejo: /users/ Mos lejo: */trackback Mos lejo: */feed Mos lejo: */ rss Mos lejo: */embed Mos lejo: */wlwmanifest.xml Mos lejo: /xmlrpc.php Mos lejo: *utm= Mos lejo: *openstat= Lejo: */ngarkime Lejo: /*/*.js # skriptet e hapura js brenda /wp - (/*/ - për prioritet) Lejo: /*/*.css # hap skedarë css brenda /wp- (/*/ - për përparësi) Lejo: /wp-*.png # imazhe në shtojca, dosje memorie etj. Lejo: /wp-*.jpg # imazhe në shtojca, dosje të memories, etj. Lejo: /wp-*.jpeg # imazhe në shtojca, dosje të memories, etj. Lejo: /wp-*.gif # imazhe në shtojca, dosje të memories, etj. Lejo: /wp-admin/admin-ajax.php # të përdoret nga shtojcat për të mos bllokuar JS dhe CSS Agjenti i përdoruesit: Yandex # rregulla për Yandex (Unë nuk kopjoj komente) Mos lejoni: /cgi-bin Mos lejoni: /? Mos lejo: /wp- Mos lejo: /wp/ Mos lejo: *?s= Mos lejo: *&s= Mos lejo: /search/ Mos lejo: /autor/ Mos lejo: /users/ Mos lejo: */trackback Mos lejo: */feed Mos lejo: */ rss Mos lejo: */embed Mos lejo: */wlwmanifest.xml Mos lejo: /xmlrpc.php Lejo: */ngarkime Lejo: /*/*.js Lejo: /*/*.css Lejo: /wp-*.png Lejo: /wp-*.jpg Lejo: /wp-*.jpeg Lejo: /wp-*.gif Lejo: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Yandex rekomandon të mos bllokohet # nga indeksimi, por të fshihet parametrat e etiketës, # Google nuk i mbështet rregulla të tilla Clean-Param: openstat # ngjashëm # Specifikoni një ose më shumë skedarë të hartës së faqes (nuk ka nevojë të kopjoni për çdo agjent përdoruesi #). Google XML Sitemap krijon 2 harta faqesh si shembulli më poshtë. Harta e faqes: http://site.ru/sitemap.xml Harta e faqes: http://site.ru/sitemap.xml.gz # Specifikoni pasqyrën kryesore të faqes, si në shembullin më poshtë (me WWW / pa WWW, nëse HTTPS # pastaj shkruani protokollin, nëse keni nevojë të specifikoni një port, tregoni atë). Komanda Host kuptohet nga # Yandex dhe Mail.RU, Google nuk e merr parasysh atë. Pritësi: www.site.ru

- Por mund të përdorni një shembull të minimalizmit: Agjenti i përdoruesit: * Mos lejo: /wp-admin/ Lejo: /wp-admin/admin-ajax.php Pritësi: https://site.ru Harta e faqes: https://site. ru/sitemap.xml

E vërteta ndoshta qëndron diku në mes. Gjithashtu, mos harroni të shtoni etiketën meta Robots për faqet "shtesë", për shembull, duke përdorur shtojcën e mrekullueshme - . Do t'ju ndihmojë gjithashtu të konfiguroni Canonical.

Korrigjo robots.txt për Joomla

Përdoruesi-agjent: * Mos lejo: /administrator/ Mos lejo: /bin/ Mos lejo: /cache/ Mos lejo: /cli/ Mos lejo: /komponentët/ Mos lejo: /përfshin/ Mos lejo: /instalim/ Mos lejo: /gjuhë/ Mos lejo: /paraqitjet/ Mos lejo: /libraries/ Mos lejo: /logs/ Mos lejo: /modules/ Mos lejo: /plugins/ Mos lejo: /tmp/

Në parim, pothuajse gjithçka merret parasysh këtu dhe funksionon mirë. E vetmja gjë është që duhet të shtoni një agjent të veçantë përdoruesi: rregullin Yandex për të futur direktivën Host, e cila përcakton pasqyrën kryesore për Yandex, dhe gjithashtu specifikoni shtegun për në skedarin e Hartës së Faqes.

Prandaj, në formën e tij përfundimtare, robotët e duhur për Joomla, për mendimin tim, duhet të duken kështu:

Agjenti i përdoruesit: Yandex Mos lejo: /administrator/ Mos lejo: /cache/ Mos lejo: /përfshin/ Mos lejo: /instalim/ Mos lejo: /gjuhë/ Mos lejo: /bibliotekat/ Mos lejo: /modulet/ Mos lejo: /plugins/ Mos lejo: /tmp/ Mos lejo: /layouts/ Mos lejo: /cli/ Mos lejo: /bin/ Mos lejo: /logs/ Mos lejo: /components/ Mos lejo: /component/ Mos lejo: /component/tags* Mos lejo: /*mailto/ Mos lejo: /*.pdf Mos lejo : /*% Mos lejo: /index.php Pritësi: vash_sait.ru (ose www.vash_sait.ru) Agjenti i përdoruesit: * Lejo: /*.css?*$ Lejo: /*.js?*$ Lejo: /* .jpg?*$ Lejo: /*.png?*$ Mos lejo: /administrator/ Mos lejo: /cache/ Mos lejo: /includes/ Mos lejo: /instalim/ Mos lejo: /language/ Mos lejo: /libraries/ Mos lejo: /modules/ Mos lejo : /plugins/ Mos lejo: /tmp/ Mos lejo: /layouts/ Mos lejo: /cli/ Mos lejo: /bin/ Mos lejo: /logs/ Mos lejo: /components/ Mos lejo: /component/ Mos lejo: /*mailto/ Mos lejo: /*. pdf Mos lejo: /*% Mos lejo: /index.php Harta e faqes: http://shtegu drejt hartës suaj të formatit XML

Po, vini re gjithashtu se në opsionin e dytë ka direktiva Lejo, duke lejuar indeksimin e stileve, skripteve dhe imazheve. Kjo është shkruar posaçërisht për Google, sepse Googlebot i tij ndonjëherë ankohet se indeksimi i këtyre skedarëve, për shembull, nga dosja me temën e përdorur, është e ndaluar në robotë. Ai madje kërcënon të ulë renditjen për këtë.

Prandaj, ne lejojmë që e gjithë kjo gjë të indeksohet paraprakisht duke përdorur Lejo. Nga rruga, e njëjta gjë ndodhi në skedarin shembull për WordPress.

Paç fat! Shihemi së shpejti në faqet e faqes së blogut

Mund të shikoni më shumë video duke shkuar te");">Ju mund të jeni të interesuar

Domenet me dhe pa www - historia e paraqitjes së tyre, përdorimi i 301 ridrejtimeve për t'i ngjitur ato së bashku

Pasqyrat, faqet e kopjuara dhe adresat Url - një auditim i faqes suaj ose cili mund të jetë shkaku i dështimit gjatë promovimit të tij SEO

Përshëndetje miq! Artikulli tregon se çfarë është roboti i saktë txt për sitin ku ndodhet, si të krijoni një skedar robotësh, si të përshtatni një skedar robotësh nga një faqe tjetër, si ta ngarkoni atë në blogun tuaj.

Çfarë është një skedarrobotë tekst,pse është e nevojshme dhe për çfarë është përgjegjëse?

Një skedar robots txt është një skedar teksti që përmban udhëzime për robotët e kërkimit. Përpara se të hyjë në faqet e blogut tuaj, roboti fillimisht kërkon skedarin e robotëve, prandaj është kaq i rëndësishëm. Skedari robots txt është një standard për parandalimin e robotëve nga indeksimi i faqeve të caktuara. Skedari robots txt do të përcaktojë nëse të dhënat tuaja konfidenciale do të publikohen. Txt-i i saktë i robotëve për një faqe do të ndihmojë në promovimin e tij, pasi është një mjet i rëndësishëm në ndërveprimin midis faqes suaj dhe robotëve të kërkimit.

Nuk është për asgjë që skedari robots txt quhet mjeti më i rëndësishëm i SEO; ky skedar i vogël ndikon drejtpërdrejt në indeksimin e faqeve të faqes dhe sitit në tërësi. Në të kundërt, robotët e pasaktë txt mund të përjashtojnë disa faqe, seksione ose sitin në tërësi nga rezultatet e kërkimit. Në këtë rast, mund të keni 1000 artikuj në blogun tuaj, por thjesht nuk do të ketë vizitorë në sit, do të ketë kalimtarë thjesht të rastësishëm.

Webmasteri i Yandex ka një video trajnimi në të cilën Yandex krahason një skedar robots txt me një kuti të sendeve tuaja personale që nuk dëshironi t'ia tregoni askujt. Për të parandaluar që të huajt të shikojnë në këtë kuti, ju e mbyllni atë me shirit dhe shkruani mbi të "Mos e hap".

Robotët, si individë të edukuar, nuk e hapin këtë kuti dhe nuk do të jenë në gjendje t'u tregojnë të tjerëve se çfarë ka atje. Nëse nuk ka skedar robots txt, atëherë roboti i motorit të kërkimit beson se të gjithë skedarët janë të disponueshëm, ai do të hapë kutinë, do të shikojë gjithçka dhe do t'u tregojë të tjerëve se çfarë është në kuti. Për të parandaluar që roboti të ngjitet në këtë kuti, duhet ta ndaloni atë të ngjitet atje; kjo bëhet duke përdorur direktivën Disallow, e cila përkthehet nga anglishtja si ndalim dhe Lejo si lejohet.

Ky është një skedar i rregullt txt, i cili përpilohet në një notepad të rregullt ose program NotePad++, një skedar që u sugjeron robotëve të mos indeksojnë faqe të caktuara në sajt. Për çfarë është:

- një skedar robots txt i kompozuar siç duhet nuk i lejon robotët të indeksojnë çdo mbeturinë dhe nuk bllokojnë rezultatet e kërkimit me materiale të panevojshme, si dhe të mos krijojnë faqe të kopjuara, gjë që është një fenomen shumë i dëmshëm;

- nuk i lejon robotët të indeksojnë informacionin që nevojitet për përdorim zyrtar;

- parandalon robotët spiun që të vjedhin të dhëna konfidenciale dhe t'i përdorin ato për të dërguar spam.

Kjo nuk do të thotë që ne duam të fshehim diçka nga motorët e kërkimit, diçka sekrete, vetëm se ky informacion nuk ka asnjë vlerë as për motorët e kërkimit dhe as për vizitorët. Për shembull, faqja e hyrjes, burimet RSS, etj. Përveç kësaj, skedari robots txt specifikon pasqyrën e faqes si dhe hartën e faqes. Si parazgjedhje, një faqe interneti e ndërtuar në WordPress nuk ka një skedar txt robotik. Prandaj, ju duhet të krijoni një skedar robots txt dhe ta ngarkoni atë në dosjen rrënjë të blogut tuaj.Në këtë artikull do të shikojmë robots txt për WordPress, krijimin, rregullimin dhe ngarkimin e tij në faqe. Pra, së pari do të dimë se ku është skedari txt i robotëve?

Ku ështërobotë tekstsi ta shoh?

Unë mendoj se shumë fillestarë i bëjnë vetes pyetjen - ku ndodhet robots txt? Skedari ndodhet në dosjen rrënjë të faqes, në dosjen public_html, mund të shihet mjaft thjesht. Mund të shkoni te hosti juaj, të hapni dosjen e faqes tuaj dhe të shihni nëse ky skedar është atje apo jo. Videoja më poshtë tregon se si ta bëni këtë. Mund ta shikoni skedarin duke përdorur webmasterin Yandex dhe webmasterin e Google, por ne do të flasim për këtë më vonë.

Ekziston një opsion edhe më i thjeshtë, i cili ju lejon të shikoni jo vetëm robotët tuaj txt, por edhe robotët e çdo faqeje, mund të shkarkoni robotë në kompjuterin tuaj dhe më pas t'i përshtatni vetes dhe t'i përdorni në faqen tuaj të internetit (blog). Kjo është bërë kështu - ju hapni faqen (blog) që ju nevojitet dhe shtoni robots.txt duke përdorur një vijë të pjerrët (shih pamjen e ekranit)

dhe shtypni Enter, do të hapet skedari robots txt. Në këtë rast, nuk mund të shihni se ku ndodhet robots txt, por mund ta shikoni dhe shkarkoni.

Si të krijoni të duhurinrobotë tekst

për sitin

Ekzistojnë opsione të ndryshme për krijimin e robotëve txt për një faqe interneti:

- përdorni gjeneratorë në internet që do të krijojnë shpejt një skedar txt robots; ka mjaft site dhe shërbime që mund ta bëjnë këtë;

- përdorni shtojca për WordPress që do të ndihmojnë në zgjidhjen e këtij problemi;

- krijoni një skedar robots txt me duart tuaja me dorë në një notepad të rregullt ose program NotePad++;

- përdorni robotë të gatshëm, korrekt txt nga faqja (blog) e dikujt tjetër, duke zëvendësuar adresën e faqes tuaj në të.

Gjeneratorë

Pra, nuk kam përdorur më parë gjeneratorë për krijimin e skedarëve robotë txt, por para se të shkruaj këtë artikull vendosa të testoj 4 shërbime për gjenerimin e skedarëve robotë txt, kam marrë rezultate të caktuara, do t'ju tregoj për to më vonë. Këto shërbime janë:

- SEOlib ;

- shërbimi PR-CY;

- shërbimi Raskruty.ru;

- seo café mund të shkoni këtu duke përdorur këtë lidhje - info.seocafe.info/tools/robotsgenerator.

Si të përdorni gjeneratorin robots txt në praktikë është treguar në detaje në videon më poshtë. Gjatë procesit të testimit, arrita në përfundimin se ato nuk janë të përshtatshme për fillestarët, dhe ja pse? Gjeneratori ju lejon vetëm të krijoni hyrjen e saktë pa gabime në vetë skedarin, por për të kompozuar robotët e duhur txt duhet të keni ende njohuri, duhet të dini se cilat dosje të mbyllni dhe cilat jo. Për këtë arsye, unë nuk rekomandoj përdorimin e gjeneratorit robots txt për të krijuar një skedar për fillestarët.

PluginsPër

WordPress

Ka shtojca, për shembull, PC Robots.txt për të krijuar skedarin. Kjo shtojcë ju lejon të redaktoni një skedar direkt në panelin e kontrollit të faqes. Një tjetër shtojcë është iRobots.txt SEO - kjo shtojcë ka funksionalitet të ngjashëm. Mund të gjeni një mori shtojcash të ndryshme që ju lejojnë të punoni me skedarin txt të robotëve. Nëse dëshironi, mund të futni frazën robots në fushën "Kërko për shtojca". txt dhe klikoni butonin "Kërko" dhe do t'ju ofrohen disa shtojca. Sigurisht, ju duhet të lexoni për secilën prej tyre dhe të shikoni rishikimet.

Mënyra se si funksionojnë shtojcat e robotëve txt për WordPress është shumë e ngjashme me mënyrën se si funksionojnë gjeneratorët. Për të marrë robotët e duhur txt për një faqe, ju duhet njohuri dhe përvojë, por ku mund ta marrin fillestarët? Për mendimin tim, më shumë dëm sesa dobi mund të vijë nga shërbime të tilla. Dhe nëse instaloni një shtojcë, ai gjithashtu do të ngarkojë hostin. Për këtë arsye, unë nuk rekomandoj instalimin e shtojcës robots txt WordPress.

Krijorobotë tekstme dorë

Ju mund të krijoni robotë txt manualisht duke përdorur një notepad të rregullt ose program NotePad++, por kjo kërkon njohuri dhe përvojë. Ky opsion gjithashtu nuk është i përshtatshëm për fillestarët. Por me kalimin e kohës, kur të fitoni përvojë, do të jeni në gjendje ta bëni këtë, dhe mund të krijoni një skedar txt robots për sitin, të regjistroni direktivat e moslejimit të robotëve, të mbyllni dosjet e nevojshme nga indeksimi, të kryeni një kontroll robotësh dhe ta rregulloni atë vetëm 10 minuta. Pamja e ekranit më poshtë tregon robotët txt në bllokun e shënimeve:

Ne nuk do të shqyrtojmë procedurën për krijimin e një skedari robotik txt këtu; kjo është shkruar në detaje në shumë burime, për shembull, Yandex Webmaster. Para se të përpiloni një skedar robots txt, duhet të shkoni te Yandex Webmaster, ku çdo direktivë përshkruhet në detaje, për çfarë është përgjegjëse dhe të krijoni një skedar bazuar në këtë informacion. (shih pamjen e ekranit).

Nga rruga, webmaster i ri Yandex ofron informacion të detajuar dhe të detajuar, një artikull në lidhje me të mund të gjendet në blog. Më saktë prezantohen dy artikuj që do të kenë një përfitim të madh për blogerët dhe jo vetëm fillestarët, ju këshilloj t'i lexoni.

Nëse nuk jeni fillestar dhe dëshironi të bëni vetë robotë txt, atëherë duhet të ndiqni një sërë rregullash:

- Përdorimi i karaktereve kombëtare në skedarin robots txt nuk lejohet.

- Madhësia e skedarit të robotëve nuk duhet të kalojë 32 KB.

- Emri i skedarit të robotëve nuk mund të shkruhet si Robots ose ROBOTS; skedari duhet të nënshkruhet saktësisht siç tregohet në artikull.

- Çdo direktivë duhet të fillojë në një linjë të re.

- Ju nuk mund të specifikoni më shumë se një direktivë në një linjë.

- Direktiva "Mos lejo" me një rresht bosh është ekuivalente me direktivën "Lejo" - lejo, kjo duhet mbajtur mend.

- Ju nuk mund të vendosni një hapësirë në fillim të një rreshti.

- Nëse nuk bëni një hapësirë midis direktivave të ndryshme të "Agjentit të Përdoruesit", atëherë robotët do të pranojnë vetëm direktivën kryesore - pjesa tjetër do të shpërfillet.

- Vetë parametri i direktivës duhet të shkruhet vetëm në një rresht.

- Ju nuk mund t'i vendosni parametrat e direktivës në thonjëza.

- Ju nuk mund të mbyllni një rresht me pikëpresje pas një direktive.

- Nëse skedari i robotëve nuk zbulohet ose është bosh, atëherë robotët do ta perceptojnë këtë si "Çdo gjë lejohet".

- Ju mund të bëni komente në rreshtin e direktivës (për ta bërë të qartë se çfarë është rreshti), por vetëm pas shenjës hash #.

- Nëse vendosni një hapësirë midis rreshtave, kjo do të thotë fundi i direktivës së agjentit përdorues.

- Direktivat "Mos lejo" dhe "Lejo" duhet të përmbajnë vetëm një parametër.

- Për direktivat që janë një direktori, shtohet një vijë e pjerrët, për shembull – Disallow/ wp-admin.

- Në seksionin "Zvarritje-vonesa", ju duhet t'u rekomandoni robotëve intervalin kohor midis shkarkimit të dokumenteve nga serveri, zakonisht 4-5 sekonda.

- E rëndësishme - nuk duhet të ketë linja boshe midis direktivave. Një direktivë e re fillon me një hapësirë. Kjo nënkupton fundin e rregullave për robotin e kërkimit, siç tregon në detaje videoja e bashkangjitur. Asterisks nënkuptojnë një sekuencë të çdo karakteri.

- Unë ju këshilloj që të përsërisni të gjitha rregullat veçmas për robotin Yandex, domethënë të përsërisni të gjitha direktivat që janë përshkruar për robotët e tjerë veçmas për Yandex. Në fund të informacionit për robotin Yandex, duhet të shkruani direktivën e hostit (Host - mbështetet vetëm nga Yandex) dhe të tregoni blogun tuaj. Pritësi i tregon Yandex se cila pasqyrë e faqes suaj është kryesore, me ose pa www.

- Për më tepër, në një drejtori të veçantë të skedarit robots txt, domethënë të ndarë nga një hapësirë, rekomandohet të tregoni adresën e hartës së faqes suaj. Krijimi i skedarit mund të bëhet brenda pak minutash dhe fillon me frazën "Agjent përdorues:". Nëse dëshironi të bllokoni, për shembull, fotot nga indeksimi, atëherë duhet të vendosni Disallow: /images/.

Përdorni të duhurinrobotë tekst

nga faqja e dikujt tjetër

Nuk ka asnjë skedar ideal; periodikisht duhet të përpiqeni të eksperimentoni dhe të merrni parasysh ndryshimet në funksionimin e motorëve të kërkimit, të merrni parasysh gabimet që mund të shfaqen në blogun tuaj me kalimin e kohës. Prandaj, për të filluar, mund të merrni skedarin txt të verifikuar të robotëve të dikujt tjetër dhe ta instaloni vetë.

Sigurohuni që të ndryshoni hyrjet që pasqyrojnë adresën e blogut tuaj në direktorinë Host (shih pamjen e ekranit, shihni gjithashtu videon), dhe gjithashtu zëvendësoni atë me adresën e faqes tuaj në adresën e hartës së faqes (dy rreshtat e poshtëm). Me kalimin e kohës, ky skedar do të duhet të rregullohet pak. Për shembull, keni vënë re se faqet e kopjuara filluan të shfaqen.

Në seksionin "Ku ndodhet robots txt, si ta shihni atë", i cili ndodhet më lart, ne shikuam se si të shikoni dhe shkarkoni robotët txt. Prandaj, ju duhet të zgjidhni një faqe të mirë besimi që ka tregues të lartë TIC, trafik të lartë, të hapni dhe shkarkoni robotët e duhur txt. Ju duhet të krahasoni disa sajte, të zgjidhni skedarin e dëshiruar të robotëve txt për veten tuaj dhe ta ngarkoni në faqen tuaj.

Si të ngarkoni një skedar në sitrobotë tekst

në dosjen rrënjë të faqes

Siç është shkruar tashmë, pas krijimit të një siti në WordPress, si parazgjedhje, nuk ka asnjë skedar txt robots. Prandaj, duhet të krijohet dhe të ngarkohet në dosjen rrënjë të faqes sonë të internetit (blog) në host. Ngarkimi i skedarit është mjaft i thjeshtë. Në pritjen TimeWeb, në hostet e tjerë mund të ngarkoni ose përmes ose përmes. Videoja më poshtë tregon procesin e ngarkimit të një skedari robotik txt në hostin TimeWeb.

Kontrollimi i skedarit txt të robotëve

Pas shkarkimit të skedarit robots txt, duhet të kontrolloni praninë dhe funksionimin e tij. Për ta bërë këtë, ne mund të shikojmë skedarin nga shfletuesi, siç tregohet më lart në seksionin "Ku ndodhet robots txt, si ta shohim". Ju mund të kontrolloni funksionimin e skedarit duke përdorur webmasterin Yandex dhe webmasterin e Google. Kujtojmë se për këtë duhet të ketë , dhe në .

Për të kontrolluar në Yandex, shkoni te llogaria jonë e webmasterit Yandex, zgjidhni një sit nëse keni disa prej tyre. Zgjidhni "Cilësimet e indeksimit", "Analiza e Robots.txt" dhe më pas ndiqni udhëzimet.

Në webmasterin e Google bëjmë të njëjtën gjë, shkojmë në llogarinë tonë, zgjidhni faqen e dëshiruar (nëse ka disa prej tyre), klikoni butonin "Zvarritje" dhe zgjidhni "Mjet i verifikimit të skedarit Robots.txt". Do të hapet skedari robots txt. Mund ta modifikoni ose kontrolloni.

Në të njëjtën faqe ka udhëzime të shkëlqyera për të punuar me skedarin robots txt, mund t'i lexoni ato. Si përfundim, unë jap një video që tregon se çfarë është një skedar robots txt, si ta gjeni, si ta shikoni dhe shkarkoni, si të punoni me gjeneratorin e skedarëve, si të krijoni një robot txt dhe ta përshtatni atë për veten tuaj, informacione të tjera tregohet:

konkluzioni

Pra, në këtë artikull ne shikuam pyetjen se çfarë është një skedar robotik txt dhe zbuluam se ky skedar është shumë i rëndësishëm për sitin. Mësuam se si të bëjmë robotët e duhur txt, si të përshtatim një skedar robots txt nga faqja e dikujt tjetër në faqen tuaj, si ta ngarkojmë atë në blogun tuaj dhe si ta kontrollojmë atë.

Nga artikulli u bë e qartë se për fillestarët, në fillim, është më mirë të përdorni një robot të gatshëm dhe të saktë txt, por duhet të mbani mend të zëvendësoni domenin në të në drejtorinë Host me tuajin, dhe gjithashtu të futni adresën e blogut tuaj në hartat e faqes. Ju mund të shkarkoni skedarin tim txt robots këtu. Tani, pas korrigjimit, mund ta përdorni skedarin në blogun tuaj.

Ekziston një faqe interneti e veçantë për skedarin robots txt. Mund të shkoni tek ai dhe të gjeni informacione më të detajuara. Shpresoj që gjithçka të funksionojë për ju dhe blogu do të indeksohet mirë. Paç fat!

Përshëndetje, Ivan Kunpan.

P.S. Për të promovuar siç duhet blogun tuaj, duhet të shkruani saktë për optimizimin e artikujve në blogun tuaj, atëherë ai do të ketë trafik dhe vlerësime të larta. Produktet e mia të informacionit, të cilat përfshijnë përvojën time trevjeçare, do t'ju ndihmojnë me këtë. Ju mund të merrni produktet e mëposhtme:

- libër me pagesë;

- harta e inteligjencës;

- kurs video me pagesë "".

Merrni artikuj të rinj në blog direkt në emailin tuaj. Plotësoni formularin, klikoni në butonin "Subscribe".

Udhëzime të përziera

Një nga gabimet më të zakonshme në robots.txt janë udhëzimet konfuze. Për shembull:

Agjenti i përdoruesit: /

Mos lejo: Yandex

Mënyra e duhur për ta shkruar është:

Agjenti i përdoruesit: Yandex

Mos lejo: /

Specifikimi i shumë drejtorive në një deklaratë Disallow

Shumë pronarë të faqeve përpiqen të vendosin të gjitha drejtoritë që janë të ndaluara të indeksohen në një deklaratë Disallow.

Mos lejo: /css/ /cgi-bin/ /images/

Një regjistrim i tillë shkel standardin dhe është e pamundur të merret me mend se si robotë të ndryshëm do ta përpunojnë atë. Disa mund të "heqin" hapësirën e bardhë dhe ta interpretojnë këtë hyrje si "Mos lejo: /css/cgi-bin/images/". Disa mund të përdorin vetëm dosjen e parë ose të fundit (/css/ ose /images/ respektivisht). Disa thjesht mund t'i heqin plotësisht udhëzimet e paqarta.

Natyrisht, disa robotë mund ta përpunojnë këtë dizajn pikërisht ashtu siç synoi webmaster, por ju ende nuk duhet të mbështeteni në të. Mënyra e duhur për ta shkruar është:

Mos lejo: /css/

Mos lejo: /cgi-bin/

Mos lejo: /images/

Emri i skedarit përmban shkronja të mëdha

Skedari duhet të quhet robots.txt, jo Robots.txt ose ROBOTS.TXT.

Përdorimi i një skedari robot.txt në vend të robots.txt

Edhe një herë, skedari duhet të quhet robots.txt.

Vargu bosh në agjentin e përdoruesit

Shume gabim:

Agjent përdorues:

Mos lejo:

Ashtu është:

Agjenti i përdoruesit: *

Mos lejo:

Url në direktivën Host

Duhet të shkruhet pa shkurtesën e protokollit të transferimit të hipertekstit, domethënë pa http:// dhe pa prerjen e mbylljes /

E gabuar:

Agjenti i përdoruesit: Yandex

Mos lejo: /cgi-bin

Pritësi: http://www.site.ru/

E drejta:

Agjenti i përdoruesit: Yandex

Mos lejo: /cgi-bin

Pritësi: www.site.ru

Direktiva e pritësit është e vlefshme vetëm për

Përdorimi i shkronjave të egra në Disallow

Ndonjëherë dëshironi të shkruani diçka si:

Agjenti i përdoruesit: *

Mos lejo: skedar*.html

për të specifikuar të gjithë skedarët file1.html, file2.html, file3.html, etj. Por ju nuk mundeni, për fat të keq (disa robotë mbështesin shkronjat e egra).

Stili i keq

Komentet në të njëjtën linjë me udhëzimet

Sipas standardit, një regjistrim i tillë është mjaft i mundur:

Mos lejo: /cgi-bin/ #disable robots nga indeksimi i cgi-bin

Në të kaluarën, disa robotë nuk përpunonin vargje të tilla. Ndoshta asnjë nga motorët kryesorë të kërkimit nuk e ka më këtë problem, por a ia vlen rreziku? Është më mirë të postoni komente veçmas.

Ridrejto te faqja e gabimit 404:

Shumë shpesh, në sajtet pa skedar robots.txt, kur kërkohet ky skedar, bëhet një ridrejtim në një faqe tjetër. Ndonjëherë një ridrejtim i tillë ndodh pa e kthyer statusin 404 Not Found. Vetë merimanga duhet të kuptojë nëse ka marrë robots.txt apo një skedar të rregullt html. Kjo situatë nuk ka gjasa të krijojë ndonjë problem, por megjithatë është më mirë të vendosni gjithmonë një skedar bosh robots.txt në rrënjën e sajtit.

Shkronjat e mëdha janë të stilit të keq

AGJENTI PËRDORUES: GOOGLEBOT

MUNDONI:

Edhe pse robots.txt nuk ka ndjeshmëri ndaj shkronjave të mëdha sipas standardit, emrat e skedarëve dhe drejtorive shpesh janë të ndjeshme ndaj shkronjave të vogla. Për më tepër, shkrimi i robots.txt me të gjitha shkronjat e mëdha konsiderohet si stil i keq.

Përdoruesi-agjent: googlebot

Mos lejo:

Listoni të gjithë skedarët

Një gabim tjetër është renditja e çdo skedari në një direktori:

Agjenti i përdoruesit: *

Mos lejo: /AL/Alabama.html

Mos lejo: /AL/AR.html

Mos lejo: /Az/AZ.html

Mos lejo: /Az/bali.html

Mos lejo: /Az/bed-breakfast.html

Në vend të kësaj, thjesht mund të mbyllni të gjithë drejtorinë nga indeksimi:

Agjenti i përdoruesit: *

Mos lejo: /AL/

Mos lejo: /Az/

Nuk ka asnjë udhëzim Lejo! [përkthimi i vjetëruar]

Shënim: Nuk ekzistonte në kohën e përkthimit të këtij teksti, tani ky udhëzim mbështetet nga Google dhe Yandex. Ju lutemi kontrolloni për përdorim me robotë të tjerë.

Nuk ka udhëzim Lejo, ka vetëm Disallow. Skedari robots.txt nuk lejon asgjë, vetëm e ndalon atë!

Shume gabim:

Agjenti i përdoruesit: Yandex

Mos lejo: /john/

Lejo: /jane/

Dhe kjo është e saktë:

Agjenti i përdoruesit: Yandex

Mos lejo: /john/

Mos lejo:

Përdorimi i direktivave shtesë në seksionin *

Shume gabim:

Agjenti i përdoruesit: *

Mos lejo: /css/

Pritësi: www.example.com

Dhe kjo është e saktë:

Agjenti i përdoruesit: *

Mos lejo: /css/Agjenti i përdoruesit: Yandex

Mos lejo: /css/

Pritësi: www.example.com

Mungesa e udhëzimit të moslejimit

Edhe nëse thjesht duam të përdorim një direktivë shtesë dhe nuk duam të mos lejojmë asgjë, është më mirë të specifikojmë një Disallow bosh. Sipas standardit, udhëzimi Disallow është i detyrueshëm dhe roboti mund t'ju "keqkuptojë".

Shume gabim:

Agjenti i përdoruesit: Yandex

Pritësi: www.example.com

Ashtu është:

Agjenti i përdoruesit: Yandex

Mos lejo:

Pritësi: www.example.com

Nuk ka prerje kur specifikoni një drejtori

Çfarë do të bëjë roboti në këtë rast?

Agjenti i përdoruesit: Yandex

Mos lejo: john

Si parazgjedhje, ai nuk do të indeksojë një skedar të quajtur "john" ose një drejtori të quajtur "john". Për të specifikuar vetëm drejtorinë, duhet të shkruani kështu:

Agjenti i përdoruesit: Yandex

Mos lejo: /john/

Titulli http i gabuar

Serveri duhet të kthejë "Lloji i përmbajtjes: tekst/i thjeshtë" në kokën e HTTP për robots.txt dhe, për shembull, jo "Lloji i përmbajtjes: tekst/html". Një kokë e pasaktë mund të pengojë disa robotë të përpunojnë skedarin.