Robots.txt este un fișier text care conține parametrii de indexare a site-ului pentru roboții motoarelor de căutare.

Yandex acceptă următoarele directive:

| Directivă | Ce face |

|---|---|

| Agent utilizator * | |

| Nu permiteți | |

| Harta site-ului | |

| Clean-param | |

| Permite | |

| Crawl-întârziere |

| Directivă | Ce face |

|---|---|

| Agent utilizator * | Indică un robot pentru care se aplică regulile enumerate în robots.txt. |

| Nu permiteți | Interzice indexarea secțiunilor sau a paginilor individuale ale site-ului. |

| Harta site-ului | Specifică calea către fișierul Sitemap care se află pe site. |

| Clean-param | Indică robotului că adresa URL a paginii conține parametri (de exemplu, etichete UTM) care nu trebuie să fie luate în considerare la indexare. |

| Permite | Permite indexarea secțiunilor sau a paginilor individuale ale site-ului. |

| Crawl-întârziere | Setează perioada minimă de timp (în secunde) pentru robot între terminarea încărcării unei pagini și începerea încărcării următoarei. |

* Directiva obligatorie.

Cele mai comune directive de care ați putea avea nevoie sunt Disallow, Sitemap și Clean-param. De exemplu:

User-agent: * #specificați pentru ce roboți sunt instalate directivele\nDisallow: /bin/ # interzice link-urile din \"Coșul de cumpărături\".\nDisallow: /search/ # interzice link-uri către paginile integrate în site-ul de căutare\nDisallow : /admin / # interzice linkurile de la panoul de administrare\nHapta site-ului: http://example.com/sitemap # îndreptați robotul către fișierul sitemap pentru site\nClean-param: ref /some_dir/get_book.pl

Roboții din alte motoare de căutare și servicii pot interpreta aceste directive în mod diferit.

Nota. Robotul ține cont de majuscule atunci când scrie subșiruri (nume sau cale către fișier, numele robotului) și nu ține cont de majuscule în numele directivelor.

Folosind alfabetul chirilic

Utilizarea chirilicului este interzisă în fișierul robots.txt și antetele HTTP ale serverului.

Pentru a specifica nume de domenii, utilizați Punycode. Specificați adresele paginii în codificare care corespunde codificării structurii actuale a site-ului.

Exemplu de fișier robots.txt:

#False:\nUser-agent: Yandex\nDisallow: /cart\n\n#Corect:\nUser-agent: Yandex\nDisallow: /%D0%BA%D0%BE%D1%80%D0%B7%D0% B8%D0%BD%D0%B0

Cum se creează robots.txt

Întrebări și răspunsuri

În Yandex.Webmaster, pe pagina „Diagnosticare site”, apare eroarea „Serverul răspunde cu o redirecționare la solicitarea /robots.txt”

Pentru ca un fișier robots.txt să fie luat în considerare de către robot, acesta trebuie să fie localizat în directorul rădăcină al site-ului și să răspundă cu un cod HTTP 200 Robotul de indexare nu acceptă utilizarea fișierelor aflate pe alte site-uri.

Puteți verifica răspunsul serverului și disponibilitatea fișierului robots.txt pentru robot folosind instrumentul Verificarea răspunsului serverului .

Dacă robots.txt redirecționează către un alt fișier robots.txt (de exemplu, când mutați un site), adăugați site-ul care este ținta redirecționării la Yandex.Webmaster și confirmați drepturile de gestionare a site-ului.

Salutare tuturor, prieteni!

Uneori apar situații când este necesar să închideți site-ul de la Ei bine, de exemplu, ați decis să schimbați designul blogului și nu doriți ca roboții de căutare să acceseze resursa în acest moment. Sau doar ați creat un site web și ați instalat un motor pe el, așa că dacă resursa nu are informații utile, atunci nu ar trebui să o arătați boților de căutare. În acest articol, veți învăța cum să blocați indexarea unui site web în Yandex, Google sau în toate motoarele de căutare simultan. Dar înainte de asta, puteți citi și un alt articol similar: „?” Acum să începem.

1. Blocați site-ul de la indexarea utilizând fișierul robots.txt.

Pentru a începe aveți nevoie. Pentru a face acest lucru, creați un document text obișnuit pe computer cu numele roboți și extensia .txt. Iată ce tocmai am creat:

![]()

Acum acest fișier trebuie să fie încărcat în . Dacă resursa este realizată pe motorul WordPress, atunci folderul rădăcină este unde sunt folderele wp-content, wp-includes etc.

Deci, am încărcat un fișier gol în găzduire, acum trebuie să folosim acest fișier pentru a închide cumva blogul de la indexare. Acest lucru se poate face, așa cum am scris deja, numai pentru Yandex, Google sau toate motoarele de căutare simultan. Să vorbim despre totul în ordine.

Cum să blochezi un site de la indexarea numai pentru Yandex?

Scrieți următorul rând în fișierul robots.txt:

Agent utilizator: Yandex

Nu permite: /

Pentru a vă asigura că ați împiedicat Yandex să vă indexeze resursa, mai întâi adăugați un site dacă nu ați făcut acest lucru deja, apoi accesați această pagină. Apoi, introduceți mai multe pagini ale site-ului dvs. și faceți clic pe butonul „Verifică”. Dacă paginile sunt interzise de la indexare, atunci veți vedea ceva de genul acesta:

Cum să blochezi un site să nu fie indexat doar de Google?

Deschideți fișierul robots.txt și scrieți următorul rând acolo:

Agent utilizator: Googlebot

Nu permite: /

Pentru a verifica dacă Google nu indexează site-ul, creați, adăugați resursa dvs. la Google Webmaster și mergeți. De asemenea, aici trebuie să introduceți mai multe pagini și să faceți clic pe butonul „verificare”.

Am observat că motorul de căutare Google chiar indexează acele documente care sunt interzise în fișierul robots.txt și le introduce într-un index suplimentar, așa-numitul „snot”. Nu știu de ce, dar trebuie să înțelegeți că este 100% imposibil să blocați un site sau o pagină individuală folosind fișierul robots.txt. Acest fișier, după cum am înțeles, este doar o recomandare pentru Google și decide ce să indexeze și ce nu.

Cum să blochezi un site de la indexarea pentru toate motoarele de căutare?

Pentru a împiedica toate motoarele de căutare să indexeze resursele dvs. simultan, adăugați următoarea linie la robots.txt:

Agent utilizator: *

Nu permite: /

Acum puteți accesa și Yandex sau Google Webmaster și verificați interdicția de indexare.

Puteți vedea fișierul robots.txt la această adresă:

Vashdomain.ru/robots.txt

Tot ce ai scris în acest fișier ar trebui să fie afișat în browser. Dacă, când mergi la această adresă, apare un mesaj în fața ta, înseamnă că ai încărcat fișierul în locul greșit.

Apropo, robots.txt-ul meu se află . Dacă resursa dvs. este realizată pe motorul WordPress, atunci puteți să o copiați pur și simplu. Este configurat corect pentru a se asigura că roboții de căutare indexează doar documentele necesare și că nu există duplicate pe site.

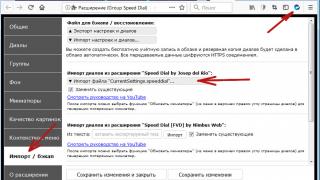

2. Blocați site-ul de la indexarea utilizând bara de instrumente.

Această metodă este potrivită doar pentru cei a căror resursă este realizată pe WordPress. Accesați „Panou de control” - „Setări” - „Citire”. Aici trebuie să bifați caseta de lângă inscripția „Recomandăm ca motoarele de căutare să nu indexeze site-ul”.

Vă rugăm să rețineți că mai jos există o inscripție foarte interesantă: „Motoarele de căutare înșiși decid dacă vă vor urma solicitarea.” Despre asta am scris mai sus. Cel mai probabil Yandex nu va indexa paginile cărora li se interzice indexarea, dar pot apărea probleme cu Google.

3. Închidem site-ul de la indexare manual.

Când închideți o întreagă resursă sau pagină de la indexare, următoarea linie apare automat în codul sursă:

Le spune roboților de căutare că documentul nu poate fi indexat. Pur și simplu puteți scrie manual această linie oriunde pe site-ul dvs., principalul lucru este că apare pe toate paginile și apoi resursa va fi închisă de la indexare.

Apropo, dacă creați un document inutil pe site-ul dvs. și nu doriți ca roboții de căutare să-l indexeze, puteți introduce și această linie în codul sursă.

După actualizare, deschideți codul sursă al paginii (CTRL + U) și vedeți dacă această linie apare acolo. Dacă există, atunci totul este în regulă. Pentru orice eventualitate, puteți verifica și folosind instrumente pentru webmasteri de la Yandex și Google.

Asta e tot pentru azi. Acum știi cum să blochezi un site de la indexare. Sper că acest articol v-a fost de ajutor. La revedere tuturor.

Cum să blochezi un site, un link, o pagină de la indexare?

Nu este întotdeauna necesar ca motoarele de căutare să indexeze toate informațiile de pe un site web.

Uneori, webmasterii chiar trebuie să blocheze complet site-ul de la indexarea, dar începătorii nu știu cum să facă acest lucru. Dacă doriți, puteți ascunde orice conținut, resursă sau paginile sale individuale de motoarele de căutare.

Cum să blochezi un site, un link, o pagină de la indexare? Există mai multe funcții simple pe care le puteți folosi pentru a închide orice informații de la Yandex și Google. În acest articol vă vom spune cum să blochezi un site de la indexarea prin roboți, și vă arată ce cod trebuie să adăugați la acest fișier.

Blocarea indexării motoarelor de căutare

Înainte de a vorbi despre metoda folosind robots.txt, vom arăta cum să blocăm indexarea unui site pe WordPress prin panoul de administrare. În setări (secțiunea de citire), există o funcție convenabilă:

Puteți elimina vizibilitatea site-ului, dar acordați atenție indicii. Se spune că motoarele de căutare pot indexa în continuare resursa, așa că este mai bine să folosiți o metodă dovedită și să adăugați codul necesar pe robots.txt.

Fișierul text al roboților este în , dar dacă nu este acolo, creați-l folosind notepad.

Următorul cod va ajuta la blocarea site-ului de la indexare:

Doar adăugați-l la prima linie (înlocuiți liniile existente). Dacă trebuie să închideți un site numai din Yandex, utilizați Yandex în loc de asterisc dacă doriți să închideți o resursă de la Google, introduceți Googlebot;

Dacă nu puteți utiliza această metodă, trebuie doar să adăugați linia la codul site-ului .

Când parcurgeți acești pași, site-ul nu va mai fi indexat, acesta este cel mai bun mod de a bloca resursa de la roboții de căutare.

Cum să blochezi o pagină de la indexare?

Dacă trebuie să ascundeți o singură pagină, atunci va trebui să scrieți cod diferit în fișierul robots:

Nu permiteți: /category/kak-nachat-zarabatyvat

În al doilea rând trebuie să indicați adresa paginii, dar fără numele domeniului. Alternativ, puteți bloca indexarea unei pagini dacă scrieți în codul acesteia:

Aceasta este o opțiune mai complexă, dar dacă nu doriți să adăugați linii la robots.txt, atunci aceasta este o soluție excelentă. Dacă ați ajuns pe această pagină în căutarea unei modalități de a preveni indexarea duplicaturilor, cel mai simplu mod este să adăugați toate linkurile către roboți.

Cum să blochezi un link sau un text de la indexare?

Nici aici nu este nimic complicat, trebuie doar să adăugați etichete speciale la codul de link sau să îl înconjurați cu ele:

Folosind aceleași etichete noindex, puteți ascunde text diferit din motoarele de căutare. Pentru a face acest lucru, trebuie să adăugați această etichetă în editorul de articole.

Din păcate, Google nu are o astfel de etichetă, așa că nu va fi posibilă ascunderea unei părți a textului de ea. Cel mai simplu mod de a face acest lucru este să adăugați o imagine cu text.

Scopul acestui ghid este de a ajuta webmasterii și administratorii să utilizeze robots.txt.

Introducere

Standardul de exceptare a roboților este foarte simplu la bază. Pe scurt, funcționează astfel:

Când un robot care urmează standardul vizitează un site, mai întâi solicită un fișier numit „/robots.txt”. Dacă un astfel de fișier este găsit, Robotul caută în el pentru instrucțiuni care interzic indexarea anumitor părți ale site-ului.

Unde să plasați fișierul robots.txt

Robotul solicită pur și simplu adresa URL „/robots.txt” pe site-ul dvs., în acest caz, site-ul este o anumită gazdă pe un anumit port;

| Adresa URL a site-ului | Adresa URL a fișierului Robots.txt |

| http://www.w3.org/ | http://www.w3.org/robots.txt |

| http://www.w3.org:80/ | http://www.w3.org:80/robots.txt |

| http://www.w3.org:1234/ | http://www.w3.org:1234/robots.txt |

| http://w3.org/ | http://w3.org/robots.txt |

Pe site poate exista un singur fișier „/robots.txt”. De exemplu, nu ar trebui să plasați fișierul robots.txt în subdirectoarele utilizatorilor - roboții oricum nu îi vor căuta acolo. Dacă doriți să puteți crea fișiere robots.txt în subdirectoare, atunci aveți nevoie de o modalitate de a le colecta în mod programatic într-un singur fișier robots.txt situat la rădăcina site-ului. Puteți folosi .

Rețineți că adresele URL țin cont de majuscule, iar numele fișierului „/robots.txt” trebuie scris în întregime cu litere mici.

| Locație greșită a robots.txt | |

| http://www.w3.org/admin/robots.txt | |

| http://www.w3.org/~timbl/robots.txt | Fișierul nu se află la rădăcina site-ului |

| ftp://ftp.w3.com/robots.txt | Roboții nu indexează ftp |

| http://www.w3.org/Robots.txt | Numele fișierului nu este scris cu litere mici |

După cum puteți vedea, fișierul robots.txt trebuie plasat exclusiv la rădăcina site-ului.

Ce să scrieți în fișierul robots.txt

Fișierul robots.txt conține de obicei ceva de genul:

Agent utilizator: *

Nu permiteți: /cgi-bin/

Nu permiteți: /tmp/

Nu permiteți: /~joe/

În acest exemplu, indexarea a trei directoare este interzisă.

Rețineți că fiecare director este listat pe o linie separată - nu puteți scrie „Disallow: /cgi-bin/ /tmp/”. De asemenea, nu puteți împărți o declarație Disallow sau User-agent în mai multe rânduri, deoarece Spărturile de linie sunt folosite pentru a separa instrucțiunile unele de altele.

Nici expresiile regulate și metacaracterele nu pot fi folosite. „Asteriscul” (*) din instrucțiunea User-agent înseamnă „orice robot”. Instrucțiuni precum „Disallow: *.gif” sau „User-agent: Ya*” nu sunt acceptate.

Instrucțiunile specifice din robots.txt depind de site-ul dvs. și de ceea ce doriți să împiedicați să fie indexat. Iată câteva exemple:

Blocați întregul site să nu fie indexat de către toți roboții

Agent utilizator: *

Nu permite: /

Permiteți tuturor roboților să indexeze întregul site

Agent utilizator: *

Nu permiteți:

Sau puteți crea pur și simplu un fișier gol „/robots.txt”.

Blocați doar câteva directoare de la indexare

Agent utilizator: *

Nu permiteți: /cgi-bin/

Nu permiteți: /tmp/

Nu permiteți: /privat/

Preveniți indexarea site-ului pentru un singur robot

Agent utilizator: BadBot

Nu permite: /

Permiteți unui robot să indexeze site-ul și să refuze pe toți ceilalți

Agent utilizator: Yandex

Nu permiteți:

Agent utilizator: *

Nu permite: /

Interziceți toate fișierele, cu excepția unuia, de la indexare

Este destul de dificil, pentru că... nu există nicio declarație „Permite”. În schimb, puteți muta toate fișierele cu excepția celui pe care doriți să-l permiteți indexarea într-un subdirector și să împiedicați indexarea acestuia:

Agent utilizator: *

Nu permiteți: /docs/

Sau puteți interzice indexarea tuturor fișierelor interzise:

Agent utilizator: *

Nu permiteți: /private.html

Nu permiteți: /foo.html

Nu permiteți: /bar.html

Agent utilizator: *\nPermite:

Nu permite: *

Nu permite: /

Yandex.Webmaster

Echipa de căutare

Ca semnal de interzicere în robots.txt.

Adesea, robotul de indexare nu poate accesa site-urile din cauza interdicției de a vizita toate paginile stabilite din greșeală în robots.txt. Unele dintre aceste erori sunt legate de utilizarea unei directive Allow goale:

Agent utilizator: *\nPermite:

Anterior, robotul a interpretat această regulă ca fiind complet prohibitivă, ceea ce a făcut site-ul inaccesibil pentru roboți, iar astfel de site-uri nu puteau fi afișate în rezultatele căutării. Atunci când proprietarii de site-uri au dorit în mod deliberat să blocheze vizitele pe site-uri, de obicei au declarat clar comanda de blocare.

Prin urmare, am decis să schimbăm procesarea de către robot a unei astfel de directive - acum este ignorată atunci când este detectată în robots.txt. Dacă site-ul dvs. folosește în mod deliberat o regulă Allow goală în robots.txt, atunci pentru ca robotul să ia în considerare corect interdicția, regula trebuie schimbată în directiva Disallow:

Nu permite: *

Nu permite: /

Puteți verifica ce este permis și ce este interzis în robots.txt în Yandex.Webmaster. Vă recomandăm să acordați o atenție deosebită valorilor goale pentru Allow - dacă trebuie să dezactivați indexarea, atunci acestea nu ar trebui să fie acolo.

Acum restricțiile din robots.txt funcționează și mai fiabil

Echipa de căutare

","contentType":"text/html"),"propposedBody":("sursa":"

Ca semnal de interzicere în robots.txt.

Adesea, robotul de indexare nu poate accesa site-urile din cauza interdicției de a vizita toate paginile stabilite din greșeală în robots.txt. Unele dintre aceste erori sunt legate de utilizarea unei directive Allow goale:

Agent utilizator: *\nPermite:

Anterior, robotul a interpretat această regulă ca fiind complet prohibitivă, ceea ce a făcut site-ul inaccesibil pentru roboți, iar astfel de site-uri nu puteau fi afișate în rezultatele căutării. Atunci când proprietarii de site-uri au dorit în mod deliberat să blocheze vizitele pe site-uri, de obicei au declarat clar comanda de blocare.

Prin urmare, am decis să schimbăm procesarea de către robot a unei astfel de directive - acum este ignorată atunci când este detectată în robots.txt. Dacă site-ul dvs. folosește în mod deliberat o regulă Allow goală în robots.txt, atunci pentru ca robotul să ia în considerare corect interdicția, regula trebuie schimbată în directiva Disallow:

Nu permite: *

Nu permite: /

Puteți verifica ce este permis și ce este interzis în robots.txt în Yandex.Webmaster. Vă recomandăm să acordați o atenție deosebită valorilor goale pentru Allow - dacă trebuie să dezactivați indexarea, atunci acestea nu ar trebui să fie acolo.

Acum restricțiile din robots.txt funcționează și mai fiabil

Echipa de căutare

Ca semnal de interzicere în robots.txt.

Adesea, robotul de indexare nu poate accesa site-urile din cauza interdicției de a vizita toate paginile stabilite din greșeală în robots.txt. Unele dintre aceste erori sunt legate de utilizarea unei directive Allow goale:

Agent utilizator: *\nPermite:

Anterior, robotul a interpretat această regulă ca fiind complet prohibitivă, ceea ce a făcut site-ul inaccesibil pentru roboți, iar astfel de site-uri nu puteau fi afișate în rezultatele căutării. Atunci când proprietarii de site-uri au dorit în mod deliberat să blocheze vizitele pe site-uri, de obicei au declarat clar comanda de blocare.

Prin urmare, am decis să schimbăm procesarea de către robot a unei astfel de directive - acum este ignorată atunci când este detectată în robots.txt. Dacă site-ul dvs. folosește în mod deliberat o regulă Allow goală în robots.txt, atunci pentru ca robotul să ia în considerare corect interdicția, regula trebuie schimbată în directiva Disallow:

Nu permite: *

Nu permite: /

Puteți verifica ce este permis și ce este interzis în robots.txt în Yandex.Webmaster. Vă recomandăm să acordați o atenție deosebită valorilor goale pentru Allow - dacă trebuie să dezactivați indexarea, atunci acestea nu ar trebui să fie acolo.

Acum restricțiile din robots.txt funcționează și mai fiabil

Echipa de căutare

","contentType":"text/html"),"authorId":"30364427","slug":"izmeneniya-v-obrabotke-robots-txt","canEdit":false,"canComment":false," isBanned":false,"canPublish":false,"viewType":"minor","isDraft":false,"isOnModeration":false,"isSubscriber":false,"commentsCount":45,"modificationDate":"Vi iunie 10 2016 14:41:00 GMT+0000 (Timp universal coordonat)","isAutoPreview":true,"showPreview":true,"tags":[("displayName":"Yandex.Webmaster","slug":" yandeks-vebmaster","url":"/blog??tag=yandeks-vebmaster"),("displayName":"Indexare","slug":"indeksirovanie","url":"/blog??tag= indeksirovanie"),("displayName":"robots.txt","slug":"robots-txt","url":"/blog??tag=robots-txt")],"isModerator":false," commentsEnabled":true,"url":"/blog/575aa00fef202d16005fe180","urlTemplate":"/blog/%slug%","fullBlogUrl":"https://webmaster.yandex.ru/blog","addCommentUrl" :"/blog/createComment/webmaster/575aa00fef202d16005fe180","updateCommentUrl":"/blog/updateComment/webmaster/575aa00fef202d16005fe180","addCommentWithCaptcha":"/webi/blog/f0afe0create5/webmaster 02d1600 5fe180","changeCaptchaUrl":"/blog / api/captcha/new","putImageUrl":"/blog/image/put","urlBlog":"/blog","urlEditPost":"/blog/575aa00fef202d16005fe180/edit","urlSlug":"/blog / post/generateSlug","urlPublishPost":"/blog/575aa00fef202d16005fe180/publish","urlUnpublishPost":"/blog/575aa00fef202d16005fe180/unpublish","urlRemovePost.50050000/fe750000/575aa00fef202d16005fe180 /removePost","urlDraft": "/ blog/575aa00fef202d16005fe180/draft","urlDraftTemplate":"/blog/%slug%/draft","urlRemoveDraft":"/blog/575aa00fef202d16005fe180/removeDraft/suggest/removeDraft/Suggest/aaaaa00fef202d16005fe180/removeDraft/Suggest ", "urlAfterDelete":"/blog","isAuthor":false,"subscribeUrl":"/blog/api/subscribe/575aa00fef202d16005fe180","unsubscribeUrl":"/blog/api/unsubscribe/575api/subscribe/575aa00fef202d16005fe180","unsubscribeUrl":"/blog/api/unsubscribe/575ai/unsubscribe/575aa0200fed18P02020000F00000000F :" /blog/575aa00fef202d16005fe180/edit","urlForTranslate":"/blog/post/translate","urlRelateIssue":"/blog/post/updateIssue","urlUpdateTranslate":"/blog/post/updateTranslate"," urlLoadTranslate" :"/blog/post/loadTranslate","urlTranslationStatus":"/blog/575aa00fef202d16005fe180/translationInfo","urlRelatedArticles":"/blog/api/relatedArticles/webmaster/575aa00fef202d16005fe180/translationInfo","urlRelatedArticles":"/blog/api/relatedArticles/webmaster/575aa00fef202d16005fe180/traducere :" 30364427","uid":("value":"30364427","lite":false,"hosted":false),,"aliases":(),"login":"webmaster","display_name" :(" nume":"webmaster","avatar":("implicit":"0/0-0","gol":adevărat)),,"adresă":" [email protected]","defaultAvatar":"0/0-0","imageSrc":"https://avatars.mds.yandex.net/get-yapic/0/0-0/islands-middle","isYandexStaff": false),"originalModificationDate":"2016-06-10T11:41:55.364Z","socialImage":("orig":("fullPath":"https://avatars.mds.yandex.net/get-yablogs) /51778/file_1461153249801/orig")))))">

Modificări în procesarea robots.txt

Roboții de căutare Yandex nu mai contează drept semnal de interdicție în robots.txt.

Adesea, robotul de indexare nu poate accesa site-urile din cauza interdicției de a vizita toate paginile stabilite din greșeală în robots.txt. Unele dintre aceste erori sunt legate de utilizarea unei directive Allow goale:

Agent utilizator: * Permite:

Anterior, robotul a interpretat această regulă ca fiind complet prohibitivă, ceea ce a făcut site-ul inaccesibil pentru roboți, iar astfel de site-uri nu puteau fi afișate în rezultatele căutării. Atunci când proprietarii de site-uri au dorit în mod deliberat să blocheze vizitele pe site-uri, de obicei au declarat clar comanda de blocare.

Prin urmare, am decis să schimbăm procesarea de către robot a unei astfel de directive - acum este ignorată atunci când este detectată în robots.txt. Dacă site-ul dvs. folosește în mod deliberat o regulă Allow goală în robots.txt, atunci pentru ca robotul să ia în considerare corect interdicția, regula trebuie schimbată în directiva Disallow:

Nu permite: *

Nu permite: /

Puteți verifica ce este permis și ce este interzis în robots.txt în . Vă recomandăm să acordați o atenție deosebită valorilor goale pentru Allow - dacă trebuie să dezactivați indexarea, atunci acestea nu ar trebui să fie acolo.

Acum restricțiile din robots.txt funcționează și mai fiabil

Echipa de căutare