Fiecare blog oferă propriul răspuns la aceasta. Prin urmare, noii veniți la promovarea căutării sunt adesea confuzi, astfel:

Ce fel de roboți ex ti?

Fişier robots.txt sau fișier index- un document text simplu în codificare UTF-8, valabil pentru protocoalele http, https și FTP. Fișierul oferă recomandări pentru roboții de căutare: ce pagini/fișiere trebuie accesate cu crawlere. Dacă fișierul conține caractere care nu sunt în UTF-8, ci într-o codificare diferită, roboții de căutare pot să nu le proceseze corect. Regulile enumerate în fișierul robots.txt sunt valabile numai pentru gazda, protocolul și numărul portului în care se află fișierul.

Fișierul trebuie să fie localizat în directorul rădăcină ca document text simplu și să fie disponibil la: https://site.com.ua/robots.txt.

În alte fișiere, este obișnuit să se marcheze BOM (Byte Order Mark). Acesta este un caracter Unicode care este folosit pentru a determina secvența în octeți atunci când citiți informații. Simbolul său de cod este U+FEFF. La începutul fișierului robots.txt, marcajul secvenței de octeți este ignorat.

Google a stabilit o limită pentru dimensiunea fișierului robots.txt - acesta nu trebuie să cântărească mai mult de 500 KB.

Bine, dacă sunteți interesat de detaliile tehnice, fișierul robots.txt este o descriere a formularului Backus-Naur (BNF). Aceasta folosește regulile RFC 822.

Când procesează regulile în fișierul robots.txt, roboții de căutare primesc una dintre cele trei instrucțiuni:

- acces parțial: este disponibilă scanarea elementelor individuale ale site-ului;

- acces complet: poți scana totul;

- interdicție completă: robotul nu poate scana nimic.

Când scanează fișierul robots.txt, roboții primesc următoarele răspunsuri:

- 2xx- scanarea a avut succes;

- 3xx- crawler-ul urmează redirecționarea până când primește un alt răspuns. Cel mai adesea există cinci încercări pentru ca robotul să obțină un alt răspuns decât răspunsul 3xx, apoi este înregistrată o eroare 404;

- 4xx- robotul de căutare consideră că este posibil să acceseze cu crawlere tot conținutul site-ului;

- 5xx- sunt evaluate ca erori temporare ale serverului, scanarea este complet dezactivată. Robotul va accesa fișierul până când primește un alt răspuns. Robotul de căutare Google poate determina dacă este configurat corect sau incorect pentru a returna răspunsuri la paginile lipsă ale site-ului, adică dacă în loc de o eroare 404, pagina returnează un răspuns 5xx , în acest caz pagina va fi procesată cu codul de răspuns 404.

Nu se știe încă cum este procesat fișierul robots.txt, care nu este disponibil din cauza problemelor serverului cu accesul la Internet.

De ce aveți nevoie de un fișier robots.txt

De exemplu, uneori roboții nu ar trebui să viziteze:

- pagini cu informații personale ale utilizatorilor de pe site;

- pagini cu diverse forme de transmitere a informațiilor;

- site-uri oglindă;

- paginile cu rezultatele căutării.

Important: chiar dacă pagina se află în fișierul robots.txt, există șansa ca aceasta să apară în rezultatele căutării dacă a fost găsit un link către aceasta în interiorul site-ului sau undeva pe o resursă externă.

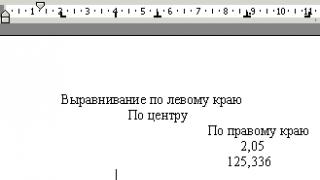

Iată cum văd roboții motoarelor de căutare un site cu și fără fișier robots.txt:

Fără robots.txt, informațiile care ar trebui ascunse privirilor indiscrete pot ajunge în rezultatele căutării și atât dvs., cât și site-ul veți avea de suferit din această cauză.

Acesta este modul în care robotul motorului de căutare vede fișierul robots.txt:

Google a găsit fișierul robots.txt pe site și a găsit regulile după care paginile site-ului trebuie accesate cu crawlere

Cum se creează un fișier robots.txt

Cu Notepad, Notepad, Sublime sau orice alt editor de text.

User-agent - carte de vizită pentru roboți

User-agent - o regulă despre care roboții trebuie să vadă instrucțiunile descrise în fișierul robots.txt. În acest moment sunt cunoscuți 302 roboți de căutare

Ea spune că specificăm regulile în robots.txt pentru toți roboții de căutare.

Pentru Google, robotul principal este Googlebot. Dacă vrem să luăm în considerare doar acesta, intrarea în fișier va fi astfel:

În acest caz, toți ceilalți roboți vor accesa cu crawlere conținutul pe baza directivelor lor pentru a procesa un fișier robots.txt gol.

Pentru Yandex, robotul principal este... Yandex:

Alți roboți speciali:

- Știri Googlebot- să caute știri;

- Mediapartners-Google- pentru serviciul AdSense;

- AdsBot-Google— pentru a verifica calitatea paginii de destinație;

- YandexImagini— Yandex.Indexator de imagini;

- Imagine Googlebot- pentru poze;

- YandexMetrika— robot Yandex.Metrica;

- YandexMedia- un robot care indexează date multimedia;

- YaDirectFetcher— Yandex.Robot direct;

- Googlebot Video- pentru video;

- Googlebot mobil- pentru versiunea mobilă;

- YandexDirectDyn— robot dinamic generator de bannere;

- YandexBlogs- un robot de căutare a blogurilor care indexează postările și comentariile;

- YandexMarket— Robot Yandex.Market;

- YandexNews— Robot Yandex.News;

- YandexDirect— descarcă informații despre conținutul site-urilor partenere ale rețelei de publicitate pentru a clarifica subiectul acestora pentru selectarea reclamelor relevante;

- YandexPagechecker— validator de microdate;

- YandexCalendar— Yandex.robot Calendar.

Nu permiteți - punem „cărămizi”

Ar trebui folosit dacă site-ul este în proces de îmbunătățire și nu doriți să apară în rezultatele căutării în starea sa actuală.

Este important să eliminați această regulă de îndată ce site-ul este pregătit pentru ca utilizatorii să o vadă. Din păcate, acest lucru este uitat de mulți webmasteri.

Exemplu. Cum se scrie o regulă de respingere pentru a sfătui roboții să nu vadă conținutul unui folder /pliant/:

Această linie împiedică indexarea tuturor fișierelor cu extensia .gif

Permite - roboți direcționați

Allow permite scanarea oricărui fișier/directiv/pagină. Să presupunem că este necesar ca roboții să poată vizualiza numai paginile care încep cu /catalog și să închidă restul conținutului. În acest caz, este prescrisă următoarea combinație:

Regulile Permiteți și Nu permiteți sunt sortate după lungimea prefixului URL (de la cel mai mic la cel mai lung) și aplicate secvenţial. Dacă o pagină se potrivește mai mult de o regulă, robotul selectează ultima regulă din lista sortată.

Gazdă - alegeți o oglindă a site-ului

Gazda este una dintre regulile obligatorii pentru robots.txt; îi spune robotului Yandex care dintre oglinzile site-ului ar trebui să fie luate în considerare pentru indexare.

Oglindă site - o copie exactă sau aproape exactă a site-ului, disponibilă la diferite adrese.

Robotul nu va fi confuz când va găsi oglinzi de site și va înțelege că oglinda principală este specificată în fișierul robots.txt. Adresa site-ului este specificată fără prefixul „http://”, dar dacă site-ul funcționează pe HTTPS, trebuie specificat prefixul „https://”.

Cum se scrie această regulă:

Un exemplu de fișier robots.txt dacă site-ul funcționează pe protocolul HTTPS:

Harta site - harta medicala a site-ului

Harta site-ului le spune roboților că toate adresele URL ale site-urilor necesare pentru indexare se află la http://site.ua/sitemap.xml. Cu fiecare accesare cu crawlere, robotul va analiza ce modificări au fost aduse acestui fișier și va reîmprospăta rapid informațiile despre site din bazele de date ale motorului de căutare.

Crawl-delay - cronometru pentru servere slabe

Crawl-delay - un parametru cu ajutorul căruia poți seta perioada după care vor fi încărcate paginile site-ului. Această regulă este relevantă dacă aveți un server slab. În acest caz, sunt posibile întârzieri mari atunci când roboții de căutare accesează paginile site-ului. Acest parametru este măsurat în secunde.

Clean-param - Vânător de conținut duplicat

Clean-param ajută la tratarea parametrilor de obținere pentru a evita conținutul duplicat care ar putea fi disponibil la diferite adrese URL dinamice (cu semne de întrebare). Astfel de adrese apar dacă site-ul are diferite sortări, ID-uri de sesiune și așa mai departe.

Să presupunem că pagina este disponibilă la adresele:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

În acest caz, fișierul robots.txt va arăta astfel:

Aici ref indică de unde provine linkul, deci este scris chiar de la început și abia apoi este indicat restul adresei.

Dar înainte de a trece la fișierul de referință, mai sunt câteva semne despre care trebuie să știți atunci când scrieți un fișier robots.txt.

Simboluri în robots.txt

Caracterele principale ale fișierului sunt „/, *, $, #”.

Prin intermediul bară oblică "/" arătăm ce vrem să ascundem de la detectarea de către roboți. De exemplu, dacă există o bară oblică în regula de respingere, interzicem accesarea cu crawlere a întregului site. Cu ajutorul a două bare oblice, puteți dezactiva scanarea oricărui director anume, de exemplu: /catalog/.

O astfel de intrare spune că interzicem scanarea întregului conținut al folderului de catalog, dar dacă scriem /catalog, interzicem toate linkurile de pe site care încep cu /catalog.

Asterisc „*”înseamnă orice secvență de caractere dintr-un fișier. Este plasat după fiecare regulă.

Această intrare spune că toți roboții nu ar trebui să indexeze niciun fișier .gif din folderul /catalog/

semnul dolarului «$» limitează sfera semnului asterisc. Dacă doriți să interziceți întregul conținut al folderului catalog, dar nu puteți interzice adresele URL care conțin /catalog, intrarea din fișierul index ar fi:

Hash „#” folosit pentru comentariile pe care webmasterul le lasă pentru el sau pentru alți webmasteri. Robotul nu le va ține cont atunci când scanează site-ul.

De exemplu:

Cum arată robots.txt ideal?

Fișierul deschide conținutul site-ului pentru indexare, gazda este înregistrată și se specifică harta site-ului, ceea ce va permite motoarelor de căutare să vadă mereu adresele care ar trebui indexate. Regulile pentru Yandex sunt scrise separat, deoarece nu toți roboții înțeleg instrucțiunea Gazdă.

Dar nu vă grăbiți să vă copiați conținutul fișierului - trebuie scrise reguli unice pentru fiecare site, care depind de tipul de site și de CMS. prin urmare, merită să vă amintiți toate regulile atunci când completați fișierul robots.txt.

Cum să verificați fișierul robots.txt

Dacă doriți să știți dacă ați completat corect fișierul robots.txt, verificați-l în instrumentele pentru webmasteri Googleși Yandex. Trebuie doar să introduceți codul sursă al fișierului robots.txt în formularul de la link și să specificați site-ul care urmează să fie verificat.

Cum să nu completați fișierul robots.txt

Adesea, greșelile enervante sunt făcute la completarea fișierului index și sunt asociate cu neatenția sau graba obișnuită. Un pic mai jos este un grafic al erorilor pe care le-am întâlnit în practică.

2. Scrierea mai multor foldere/directoare într-o singură declarație Disallow:

O astfel de intrare poate deruta roboții de căutare, este posibil să nu înțeleagă ce anume nu ar trebui să indexeze: fie primul folder, fie ultimul, așa că trebuie să scrieți fiecare regulă separat.

3. Fișierul în sine trebuie apelat numai robots.txt, nu Robots.txt, ROBOTS.TXT sau altfel.

4. Nu puteți lăsa regula User-agent goală - trebuie să spuneți care robot ar trebui să țină cont de regulile specificate în fișier.

5. Caractere suplimentare în fișier (bare oblice, asteriscuri).

6. Adăugarea paginilor la fișier care nu ar trebui să fie în index.

Utilizarea non-standard a robots.txt

Pe lângă funcțiile directe, un fișier index poate deveni o platformă pentru creativitate și o modalitate de a găsi noi angajați.

Iată un site unde robots.txt în sine este un site mic cu elemente de lucru și chiar o unitate de anunțuri.

Ca platformă de căutare a specialiștilor, fișierul este folosit în principal de agențiile SEO. Și cine altcineva poate ști despre existența lui? :)

Și Google are un fișier special oameni.txt, ca să nu îngăduiți gândul de discriminare a specialiștilor din piele și carne.

concluzii

Cu ajutorul Robots.txt, puteți seta instrucțiuni pentru roboții de căutare, vă puteți face reclamă, marca dvs., puteți căuta specialiști. Acesta este un domeniu grozav pentru experimentare. Principalul lucru este să vă amintiți despre completarea corectă a fișierului și despre greșelile tipice.

Reguli, sunt directive, sunt și instrucțiuni ale fișierului robots.txt:

- User-agent - o regulă despre care roboții trebuie să vadă instrucțiunile descrise în robots.txt.

- Disallow face o recomandare despre ce fel de informații nu ar trebui scanate.

- Sitemap informează roboții că toate adresele URL ale site-urilor necesare pentru indexare se află la http://site.ua/sitemap.xml.

- Gazda îi spune robotului Yandex care dintre oglinzile site-ului ar trebui să fie luate în considerare pentru indexare.

- Allow permite scanarea oricărui fișier/directiv/pagină.

Semne la compilarea robots.txt:

- Semnul dolar „$” limitează domeniul de aplicare al semnului asterisc.

- Cu ajutorul unei bare oblice „/” indicăm că vrem să ne ascundem de detectarea de către roboți.

- Asteriscul „*” înseamnă orice secvență de caractere din fișier. Este plasat după fiecare regulă.

- Semnul hash „#” este folosit pentru a indica comentariile pe care webmasterul le scrie pentru el sau pentru alți webmasteri.

Utilizați fișierul index cu înțelepciune - iar site-ul va fi întotdeauna în rezultatele căutării.

Generator de vânzăriDacă faceți o greșeală când creați fișierul robots.txt, atunci acesta poate fi inutil pentru roboții de căutare. Va exista riscul transmiterii incorecte a comenzilor necesare pentru căutarea roboților, ceea ce va duce la o scădere a ratingului, o modificare a indicatorilor de utilizator ai site-ului virtual. Chiar dacă site-ul funcționează bine și este complet, verificarea robots.txt nu-l va răni, ci doar îl va face să funcționeze mai bine.

Din acest articol veți învăța:

De ce să verificați robots.txt

Uneori, sistemul include pagini inutile ale resursei dvs. de Internet în rezultatele căutării, ceea ce nu este necesar. Poate părea că nu este nimic în neregulă cu un număr mare de pagini din indexul motorului de căutare, dar nu este așa:

- Pe paginile suplimentare, utilizatorul nu va găsi nicio informație utilă pentru el însuși. Cu un grad mai mare de probabilitate, nu va vizita deloc aceste pagini sau nu va sta mult timp pe ele;

- Rezultatele motorului de căutare conțin aceleași pagini, ale căror adrese sunt diferite (adică conținutul este duplicat);

- Roboții de căutare trebuie să petreacă mult timp pentru a indexa pagini complet inutile. În loc să indexeze conținut util, aceștia se vor plimba pe site inutil. Întrucât robotul nu poate indexa întreaga resursă și o face pagină cu pagină (deoarece există o mulțime de site-uri), informațiile necesare pe care ați dori să le primiți după rularea interogării s-ar putea să nu fie găsite foarte repede;

- Serverul este supus unei sarcini grele.

În acest sens, este recomandabil să închideți accesul la roboții de căutare la unele pagini de resurse web.

Ce fișiere și foldere pot fi interzise de la indexare:

- pagini de căutare. Acesta este un punct controversat. Uneori este necesară utilizarea unei căutări interne pe un site pentru a genera pagini relevante. Dar acest lucru nu se face întotdeauna. Adesea, rezultatul căutării este apariția unui număr mare de pagini duplicat. Prin urmare, se recomandă închiderea paginilor de căutare pentru indexare.

- Cosul si pagina unde se face/confirma comanda. Închiderea acestora este recomandată pentru site-urile de tranzacționare online și alte resurse comerciale folosind formularul de comandă. Introducerea acestor pagini în indexul motoarelor de căutare este extrem de nedorită.

- pagini de paginare. De regulă, ele se caracterizează prin prescrierea automată a acelorași metaetichete. În plus, sunt folosite pentru a plasa conținut dinamic, astfel încât în rezultatele căutării apar duplicate. În acest sens, paginarea ar trebui să fie închisă pentru indexare.

- Filtre și comparație de produse. Acestea trebuie să fie închise de magazinele online și site-urile de catalog.

- Pagini de înregistrare și autorizare. Acestea trebuie să fie închise din cauza confidențialității datelor introduse de utilizatori în timpul înregistrării sau autorizării. Indisponibilitatea acestor pagini pentru indexare va fi evaluată de Google.

- directoarele și fișierele de sistem. Fiecare resursă de pe Internet constă dintr-o mulțime de date (scripturi, tabele CSS, parte administrativă) care nu ar trebui să fie vizualizate de roboți.

Fișierul robots.txt va ajuta la închiderea fișierelor și a paginilor pentru indexare.

robots.txt este un fișier text simplu care conține instrucțiuni pentru roboții de căutare. Când robotul de căutare se află pe site, mai întâi caută fișierul robots.txt. Dacă lipsește (sau este gol), atunci robotul va merge la toate paginile și directoarele resursei (inclusiv cele de sistem) care se află în domeniul public și va încerca să le indexeze. În același timp, nu există nicio garanție că pagina de care aveți nevoie va fi indexată, deoarece este posibil să nu ajungă la ea.

robots.txt vă permite să direcționați roboții de căutare către paginile necesare și să nu le lăsați pe cele care nu ar trebui să fie indexate. Fișierul poate instrui atât toți roboții simultan, cât și pe fiecare individual. Dacă pagina site-ului este închisă de la indexare, atunci nu va apărea niciodată în rezultatele motorului de căutare. Crearea unui fișier robots.txt este esențială.

Locația fișierului robots.txt ar trebui să fie serverul, rădăcina resursei dvs. Fișierul robots.txt al oricărui site este disponibil pentru vizualizare pe Web. Pentru a-l vedea, trebuie să adăugați /robots.txt după adresa resursei.

De regulă, fișierele robots.txt ale diferitelor resurse diferă unele de altele. Dacă copiați fără minte fișierul site-ului altcuiva, atunci roboții de căutare vor avea probleme la indexarea site-ului dvs. Prin urmare, este atât de important să știți pentru ce este fișierul robots.txt și instrucțiunile (directivele) folosite pentru a-l crea.

Trimiteți cererea dvs

Cum verifică Yandex robots.txt

- Un serviciu special al Yandex.Webmaster „Analiza robots.txt” vă va ajuta să verificați fișierul. Îl puteți găsi la linkul: http://webmaster.yandex.ru/robots.xml

- În formularul propus, trebuie să introduceți conținutul fișierului robots.txt, pe care trebuie să îl verificați pentru erori. Există două moduri de a introduce date:

- Accesați site-ul folosind linkul http://your-site.ru/robots.txt , copiați conținutul în câmpul gol al serviciului (dacă nu există fișier robots.txt, trebuie neapărat să îl creați!);

- Introduceți un link către fișierul de verificat în câmpul „Nume gazdă”, faceți clic pe „Descărcați robots.txt de pe site” sau pe Enter.

- Verificarea este pornită prin apăsarea comenzii „Verificare”.

- După începerea testului, puteți analiza rezultatele.

După începerea verificării, analizorul analizează fiecare linie din conținutul câmpului „Text robots.txt” și analizează directivele pe care le conține. În plus, veți ști dacă robotul va accesa cu crawlere paginile din câmpul „Lista de adrese URL”.

Puteți crea un fișier robots.txt potrivit pentru resursa dvs. prin editarea regulilor. Rețineți că fișierul de resurse în sine rămâne neschimbat. Pentru ca modificările să intre în vigoare, va trebui să încărcați independent noua versiune a fișierului pe site.

La verificarea directivelor pentru secțiunile destinate robotului Yandex (User-agent: Yandex sau User-agent:*), analizorul este ghidat de regulile de utilizare a robots.txt. Secțiunile rămase sunt verificate în conformitate cu cerințele standardului. Când analizorul analizează fișierul, afișează un mesaj despre erorile găsite, avertizează dacă există inexactități în scrierea regulilor, listează ce părți ale fișierului sunt destinate robotului Yandex.

Analizatorul poate trimite două tipuri de mesaje: erori și avertismente.

Este afișat un mesaj de eroare dacă orice linie, secțiune sau întregul fișier nu poate fi procesat de parser din cauza prezenței unor erori grave de sintaxă care au fost făcute la compilarea directivelor.

De regulă, un avertisment informează despre o abatere de la reguli care nu poate fi corectată de analizor sau despre prezența unei potențiale probleme (s-ar putea să nu fie), a cărei cauză este o greșeală accidentală sau reguli compuse incorect.

Mesajul de eroare „Această adresă URL nu aparține domeniului dvs.” indică faptul că lista de adrese URL conține adresa uneia dintre oglinzile resursei dvs., de exemplu, http://example.com în loc de http://www.example. com (în mod oficial, aceste adrese URL sunt diferite). Adresele URL de verificat trebuie să fie legate de site-ul al cărui fișier robots.txt este analizat.

Cum verifică Google robots.txt

Instrumentul Google Search Console vă permite să verificați dacă fișierul robots.txt conține o interdicție ca Googlebot să acceseze cu crawlere anumite adrese URL de pe proprietatea dvs. De exemplu, aveți o imagine pe care nu doriți să apară în rezultatele căutării de imagini Google. Instrumentul vă va spune dacă Googlebot-Image are acces la acea imagine.

Pentru a face acest lucru, specificați adresa URL de interes. După aceea, fișierul robots.txt este procesat de instrumentul de inspecție, similar inspecției Googlebot. Acest lucru face posibil să se stabilească dacă adresa este accesibilă.

Procedura de verificare:

- După ce ați selectat proprietatea în Google Search Console, accesați instrumentul de verificare, care vă va oferi conținutul fișierului robots.txt. Textul evidențiat este erori de sintaxă sau logice. Numărul lor este indicat în fereastra de editare.

- În partea de jos a paginii interfeței, veți vedea o fereastră specială în care trebuie să introduceți adresa URL.

- În partea dreaptă va apărea un meniu, din care trebuie să selectați un robot.

- Faceți clic pe butonul „Verifică”.

- Dacă verificarea are ca rezultat un mesaj cu textul „disponibil”, înseamnă că Googlebots au voie să viziteze pagina specificată. Starea „indisponibil” indică faptul că accesul la acesta la roboți este închis.

- Dacă este necesar, puteți schimba meniul și puteți efectua o nouă verificare. Atenţie! Nu vor exista modificări automate ale fișierului robots.txt din resursa dvs.

- Copiați modificările și faceți-le în fișierul robots.txt de pe serverul dvs. web.

La ce trebuie să fii atent:

- Modificările făcute în editor nu sunt salvate pe serverul web. Va trebui să copiați codul rezultat și să-l inserați în fișierul robots.txt.

- Numai agenții de utilizator Google și roboții care au legătură cu Google (de exemplu, Googlebot) pot primi rezultatele verificării fișierului robots.txt de către instrument. În același timp, nu există nicio garanție că interpretarea conținutului fișierului dvs. de către roboții altor motoare de căutare va fi similară.

15 erori la verificarea fișierului robots.txt

Greșeala 1. Instrucțiuni confuze

Cea mai frecventă greșeală din fișierul robots.txt este instrucțiunile încurcate. De exemplu:

- agent utilizator: /

- Nu permiteți: Yandex

Opțiunea corectă este aceasta:

- Agent utilizator: Yandex

- interzice: /

Greșeala 2: specificarea mai multor directoare într-o singură instrucțiune Disallow

Adesea, proprietarii de resurse de Internet încearcă să enumere toate directoarele pe care doresc să dezactiveze indexarea într-o declarație Disallow.

Nu permiteți: /css/ /cgi-bin/ /images/

O astfel de înregistrare nu îndeplinește cerințele standardului; este imposibil de prezis cum va fi procesată de diferiți roboți. Unii dintre ei pot ignora spațiile. Interpretarea lor a intrării ar fi „Disallow: /css/cgi-bin/images/”. Alții pot folosi doar primul sau ultimul dosar. Alții pot chiar să renunțe la instrucțiune fără să o înțeleagă.

Există șansa ca procesarea acestei construcții să fie exact așa cum a contat vrăjitorul, dar este mai bine să o scrieți corect:

- Nu permiteți: /css/

- Nu permiteți: /cgi-bin/

- Nu permiteți: /imagini/

Eroare 3. Numele fișierului conține majuscule

Numele corect de fișier este robots.txt, nu Robots.txt sau ROBOTS.TXT.

Greșeala 4: scrierea numelui fișierului ca robot.txt în loc de robots.txt

Nu uitați să denumiți corect fișierul robots.txt.

Greșeală 5. Lăsând gol un șir în User-agent

Opțiune greșită:

- agent utilizator:

- Nu permiteți:

- Agent utilizator: *

- Nu permiteți:

Greșeala 6. Scrierea adresei URL în directiva gazdă

Adresa URL trebuie specificată fără a utiliza abrevierea Hypertext Transfer Protocol (http://) și bara oblică (/).

Intrare invalida:

Opțiunea corectă:

Utilizarea corectă a directivei gazdă este numai pentru robotul Yandex.

Greșeala 7: Utilizarea wildcards într-o declarație Disallow

Uneori, pentru a enumera toate fișierele file1.html, file2.html, file3.html etc., webmasterul poate scrie:

- Agent utilizator: *

- Disallow: fișier*.html

Dar acest lucru nu se poate face, deoarece unii roboți nu au suport pentru wildcards.

Greșeala 8. Folosirea unui rând pentru a scrie comentarii și instrucțiuni

Standardul permite intrări ca aceasta:

Nu permiteți: /cgi-bin/ #interzice roboților să indexeze cgi-bin

Anterior, prelucrarea unor astfel de șiruri de către unii roboți era imposibilă. Poate că niciun motor de căutare nu va avea o problemă în acest moment, dar merită riscul? Este mai bine să plasați comentariile pe o linie separată.

Eroare 9. Redirecționare către o pagină 404

Adesea, dacă site-ul nu are un fișier robots.txt, atunci când acesta este solicitat, motorul de căutare va redirecționa către o altă pagină. Uneori, aceasta nu returnează starea 404 Not Found. Robotul trebuie să-și dea seama ce a primit - robots.txt sau un fișier html obișnuit. Aceasta nu este o problemă, dar este mai bine dacă un fișier robots.txt gol este plasat în rădăcina site-ului.

Greșeala 10. Folosirea majusculelor este un semn de stil prost

AGENT UTILIZATOR: GOOGLEBOT

Deși standardul nu reglementează sensibilitatea cu majuscule și minuscule a robots.txt, este adesea cazul cu numele de fișiere și directoare. În plus, dacă fișierul robots.txt este scris în întregime cu majuscule, atunci acest lucru este considerat un stil prost.

Agent utilizator: googlebot

Greșeala 11. Listarea tuturor fișierelor

Ar fi incorect să enumerați fiecare fișier dintr-un director individual:

- Agent utilizator: *

- Nu permiteți: /AL/Alabama.html

- Nu permiteți: /AL/AR.html

- Nu permiteți: /Az/AZ.html

- Nu permiteți: /Az/bali.html

- Nu permiteți: /Az/bed-breakfast.html

Va fi corect să închideți întregul director de la indexare:

- Agent utilizator: *

- Nu permiteți: /AL/

- Nu permiteți: /az/

Greșeala 12. Utilizarea directivelor suplimentare în secțiunea *

Unii roboți pot reacționa incorect la utilizarea directivelor suplimentare. Prin urmare, utilizarea lor în secțiunea „*” este nedorită.

Dacă directiva nu este standard (cum ar fi „Gazdă”, de exemplu), atunci este mai bine să creați o secțiune specială pentru ea.

Opțiune nevalidă:

Corect ar fi sa scriu:

Greșeala 13. Pierderea unei instrucțiuni de respingere

Chiar dacă doriți să utilizați o directivă suplimentară și să nu setați nicio interdicție, este recomandat să specificați un Disallow gol. Standardul afirmă că instrucțiunea Disallow este obligatorie; dacă este absentă, robotul poate să vă „înțeleagă greșit”.

Nu dreapta:

Dreapta:

Eroare 14. Nu folosiți bare oblice când specificați un director

Care vor fi acțiunile robotului în acest caz?

- Agent utilizator: Yandex

- Nu permite: John

Conform standardului, nici fișierul, nici directorul numit „john” nu vor fi indexate. Pentru a specifica doar un director, trebuie să scrieți:

- Agent utilizator: Yandex

- Nu permiteți: /john/

Greșeala 15: ortografie greșită a antetului HTTP

Serverul ar trebui să returneze „Content-Type: text/plain” în antetul HTTP pentru robots.txt și, de exemplu, nu „Content-Type: text/html”. Dacă antetul este scris incorect, unii roboți nu vor putea procesa fișierul.

Cum să compuneți corect fișierul, astfel încât verificarea robots.txt să nu dezvăluie erori

Care ar trebui să fie fișierul robots.txt corect pentru o resursă de internet? Luați în considerare structura sa:

1.User-agent

Această directivă este cea principală, ea determină pentru ce roboți sunt scrise regulile.

Dacă pentru orice robot, scriem:

Dacă pentru un anumit bot:

Agent utilizator: GoogleBot

Este demn de remarcat faptul că caracterele minuscule nu contează în robots.txt. De exemplu, un agent de utilizator pentru Google poate fi scris astfel:

agent utilizator: googlebot

Iată un tabel cu principalii agenți utilizatori ai diferitelor motoare de căutare.

|

Principalul robot de indexare al Google |

|

|

Stiri google |

|

|

Google Pictures |

|

|

Mediapartners-Google |

|

|

Google Adsense, Google Mobile Adsense |

|

|

verificarea calității paginii de destinație |

|

|

AdsBot-Google-Mobile-Apps |

Robot Google pentru aplicații |

|

Robotul principal de indexare al lui Yandex |

|

|

Yandex.Imagini |

|

|

Yandex.Video |

|

|

date multimedia |

|

|

robot de căutare blog |

|

|

robot care accesează pagina când aceasta este adăugată prin formularul „Adăugați URL”. |

|

|

robot care indexează pictogramele site-ului (favicons) |

|

|

Yandex.Direct |

|

|

Yandex.Metrica |

|

|

Yandex.Catalog |

|

|

Yandex.News |

|

|

YandexImageResizer |

robot de servicii mobile |

|

principalul robot de indexare Bing |

|

|

robot de indexare principal Yahoo! |

|

|

robot de indexare principal Mail.Ru |

|

2. Dezactivați și permiteți

Disallow vă permite să dezactivați indexarea paginilor și a secțiunilor din resursa de Internet.

Allow este folosit pentru a forța deschiderea lor pentru indexare.

Dar folosirea lor este destul de dificilă.

În primul rând, trebuie să vă familiarizați cu operatori suplimentari și cu regulile de utilizare a acestora. Acestea includ: *, $ și #.

- * - orice număr de caractere, chiar și absența acestora. Nu este necesar să puneți acest operator la sfârșitul liniei, se presupune că este acolo implicit;

- $ - indică faptul că caracterul dinaintea lui trebuie să fie ultimul;

- # - acest operator este folosit pentru a desemna un comentariu, orice informație după acesta nu este luată în considerare de robot.

Cum să utilizați acești operatori:

- Nu permite: *?s=

- Nu permiteți: /categorie/$

În al doilea rând, trebuie să înțelegeți cum sunt executate regulile imbricate în fișierul robots.txt.

Nu contează în ce ordine sunt scrise directivele. Determinarea moștenirii regulilor (ce se deschide sau se închide de la indexare) se realizează conform directoarelor specificate. Să luăm un exemplu.

Permite: *.css

Nu permiteți: /șablon/

Dacă trebuie să deschideți toate fișierele .css pentru indexare, atunci va trebui să specificați acest lucru suplimentar pentru fiecare folder, accesul la care este închis. În cazul nostru:

- Permite: *.css

- Permite: /template/*.css

- Nu permiteți: /șablon/

Amintiți-vă din nou: nu contează în ce ordine sunt scrise directivele.

3. Harta site-ului

Această directivă specifică calea către fișierul XML Sitemap. URL-ul are aceeași formă ca în bara de adrese.

Directiva Sitemap poate fi specificată oriunde în fișierul robots.txt și nu trebuie să fie legată de un anumit user-agent. Sunt permise mai multe reguli sitemap.

Această directivă specifică oglinda principală a resursei (de obicei cu www sau fără www). Rețineți: atunci când specificați oglinda principală, nu scrieți http://, ci https://. Dacă este necesar, se specifică și portul.

Această directivă poate fi acceptată numai de roboții Yandex și Mail.Ru. Alți roboți, inclusiv GoogleBot, nu iau în considerare această comandă. Vă puteți înregistra gazdă o singură dată!

5. Întârziere de accesare cu crawlere

Vă permite să setați perioada de timp după care robotul trebuie să descarce paginile de resurse. Directiva este susținută de roboții Yandex, Mail.Ru, Bing, Yahoo. Când setați intervalul, puteți utiliza atât valori întregi, cât și fracționale, folosind un punct ca separator. Unitatea de măsură este secundele.

Întârziere de accesare cu crawlere: 0,5

Dacă încărcarea pe site este mică, atunci nu este nevoie să setați această regulă. Dar dacă rezultatul indexării paginilor de către robot depășește limitele sau o creștere serioasă a încărcării, ceea ce duce la întreruperi ale serverului, atunci utilizarea acestei directive este rezonabilă: vă permite să reduceți încărcarea.

Cu cât intervalul pe care îl setați este mai lung, cu atât va fi mai mic numărul de descărcări în timpul unei sesiuni. Valoarea optimă pentru fiecare resursă este diferită. La început, se recomandă să setați valori mici (0,1, 0,2, 0,5), apoi să le creșteți treptat. Pentru roboții motoarelor de căutare care nu sunt deosebit de importanți pentru rezultatele promovării (de exemplu, Mail.Ru, Bing și Yahoo), puteți seta imediat valori care sunt mai mari decât pentru roboții Yandex.

6.Clean param

Această directivă este necesară pentru a informa crawler-ul (robotul de căutare) despre inutilitatea indexării URL-urilor cu parametrii specificați. Regula are două argumente: un parametru și o adresă URL a secțiunii. Yandex sprijină directiva.

http://site.ru/articles/?author_id=267539 - nu va fi indexat

http://site.ru/articles/?author_id=267539&sid=0995823627 - nu va fi indexat

Clean-Param: utm_source utm_medium utm_campaign

7. Alte opțiuni

Specificația extinsă robots.txt conține, de asemenea, următorii parametri: Rata cererii și Timpul vizitei. Dar în prezent nu există suport pentru motoarele lor de căutare de top.

Sunt necesare directive pentru următoarele:

- Rata de solicitare: 1/5 - permite încărcarea a nu mai mult de 1 pagină în 5 secunde

- timpul de vizită: 0600-0845 - Permite încărcarea paginii numai de la 6:00 la 8:45 GMT

Pentru a configura corect fișierul robots.txt, vă recomandăm să utilizați următorul algoritm:

2) Închideți accesul roboților la contul dvs. personal, la paginile de autorizare și înregistrare;

4) Închideți scripturile ajax, json de la indexare;

6) Interziceți indexarea pluginurilor, temelor, js, css pentru roboții tuturor motoarelor de căutare, cu excepția Yandex și Google;

7) Acces strâns la roboți la funcționalitatea de căutare;

8) Interzicerea secțiunilor serviciului de indexare care nu sunt valoroase pentru resursa din căutare (eroare 404, lista autorilor);

9) Închiderea de la indexarea duplicatelor tehnice ale paginilor și paginilor, al căror conținut dublează într-o oarecare măsură conținutul altor pagini (calendare, arhive, RSS);

12) Utilizați parametrul „site:” pentru a verifica ce au indexat Yandex și Google. Pentru a face acest lucru, introduceți „site:site.ru” în bara de căutare. Dacă există pagini în SERP care nu trebuie indexate, adăugați-le la robots.txt;

13) Notați Harta site-ului și regulile de gazdă;

14) Dacă este necesar, specificați Crawl-Delay și Clean-Param;

15) Verificați corectitudinea fișierului robots.txt folosind instrumentele Google și Yandex;

16) După 14 zile, verificați din nou pentru a vă asigura că nu există pagini în rezultatele motorului de căutare care să nu fie indexate. Dacă există, repetați toate punctele de mai sus.

Verificarea fișierului robots.txt are sens numai dacă site-ul dvs. este în regulă. Un audit de șantier efectuat de specialiști calificați va ajuta la determinarea acestui lucru.

Sperăm că articolul nostru despre idei de afaceri vă va fi de folos. Și dacă ați decis deja direcția activității dvs. și sunteți implicat activ în dezvoltarea și, atunci vă sfătuim să faceți un audit al site-ului pentru a prezenta o imagine reală a capacităților resursei dumneavoastră.

Primul lucru pe care îl face un robot de căutare când vine vorba de site-ul dvs. este să caute și să citească fișierul robots.txt. Ce este acest fișier? este un set de instrucțiuni pentru un motor de căutare.

Este un fișier text cu extensia txt, care se află în directorul rădăcină al site-ului. Acest set de instrucțiuni îi spune robotului de căutare ce pagini și fișiere de site trebuie indexate și care nu. De asemenea, indică oglinda principală a site-ului și unde să cauți harta site-ului.

Pentru ce este fișierul robots.txt? Pentru indexarea corectă a site-ului dvs. Pentru ca în căutare să nu existe pagini duplicat, diverse pagini de serviciu și documente. Odată ce ați configurat corect directivele în roboți, vă veți salva site-ul de multe probleme cu indexarea și oglindirea site-ului.

Cum să compun robots.txt corect

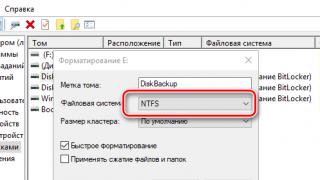

Compilarea robots.txt este destul de ușoară, creăm un document text într-un bloc de note standard Windows. Scriem directive pentru motoarele de căutare în acest fișier. Apoi, salvați acest fișier cu numele „roboți” și extensia de text „txt”. Totul poate fi încărcat acum în hosting, în folderul rădăcină al site-ului. Vă rugăm să rețineți că un singur document roboți poate fi creat pe site. Dacă acest fișier lipsește de pe site, atunci botul „decide” automat că totul poate fi indexat.

Deoarece este unul, conține instrucțiuni pentru toate motoarele de căutare. Mai mult, puteți nota atât instrucțiuni separate pentru fiecare PS, cât și cea generală imediat pentru tot. Separarea instrucțiunilor pentru diferiți roboți de căutare se face prin directiva User-agent. Vom vorbi mai multe despre asta mai jos.

directive robots.txt

Fișierul „robot” poate conține următoarele directive de indexare: User-agent, Disallow, Allow, Sitemap, Host, Crawl-delay, Clean-param. Să ne uităm la fiecare instrucțiune mai detaliat.

Directiva agent de utilizator

Directiva agent de utilizator- indică pentru ce motor de căutare vor exista instrucțiuni (mai precis, pentru ce bot anume). Dacă este „*”, instrucțiunile sunt pentru toți roboții. Dacă este listat un anumit bot, cum ar fi Googlebot, atunci instrucțiunile sunt numai pentru botul principal de indexare Google. În plus, dacă există instrucțiuni separat pentru Googlebot și pentru toate celelalte PS-uri, atunci Google va citi doar propriile instrucțiuni și le va ignora pe cele generale. Botul Yandex va face același lucru. Să ne uităm la un exemplu de intrare directivă.

Agent utilizator: YandexBot - instrucțiuni numai pentru botul principal de indexare Yandex

Agent utilizator: Yandex - instrucțiuni pentru toți roboții Yandex

User-agent: * - instrucțiuni pentru toți roboții

Directivele Disallow și Allow

Directivele Disallow și Allow- dați comenzi ce să indexați și ce nu. Disallow dă comanda de a nu indexa o pagină sau o întreagă secțiune a site-ului. Și Allow, dimpotrivă, indică ceea ce trebuie indexat.

Disallow: / - interzice indexarea întregului site

Disallow: /papka/ - interzice indexarea întregului conținut al folderului

Disallow: /files.php - interzice indexarea fișierului files.php

Allow: /cgi-bin - permite indexarea paginilor cgi-bin

Este posibil și adesea necesar să folosiți caractere speciale în directivele Disallow și Allow. Sunt necesare pentru a defini expresiile regulate.

Caracter special * - înlocuiește orice succesiune de caractere. Este implicit atașat la sfârșitul fiecărei reguli. Chiar dacă nu l-ați înregistrat, PS-ul îl va pune singuri. Exemplu de utilizare:

Disallow: /cgi-bin/*.aspx - interzice indexarea tuturor fișierelor cu extensia .aspx

Disallow: /*foto - interzice indexarea fișierelor și folderelor care conțin cuvântul foto

Caracterul special $ - anulează efectul caracterului special „*” la sfârșitul regulii. De exemplu:

Disallow: /example$ - interzice indexarea „/example”, dar nu interzice „/example.html”

Și dacă scrieți fără caracterul special $, atunci instrucțiunea va funcționa diferit:

Disallow: /example - nu permite atât „/example” cât și „/example.html”

Directiva Sitemap

Directiva Sitemap- este conceput pentru a indica robotului motorului de căutare unde se află harta site-ului pe găzduire. Formatul sitemap-ului trebuie să fie sitemaps.xml. Este necesară o hartă a site-ului pentru o indexare mai rapidă și mai completă a site-ului. Mai mult, o hartă a site-ului nu este neapărat un fișier, pot fi mai multe. Formatul de intrare al directivei:

Harta site-ului: http://site/sitemaps1.xml

Harta site-ului: http://site/sitemaps2.xml

Directiva gazdă

Directiva gazdă- indică robotului oglinda principală a site-ului. Indiferent ce se află în indexul oglindă al site-ului, trebuie să specificați întotdeauna această directivă. Dacă nu este specificat, robotul Yandex va indexa cel puțin două versiuni ale site-ului cu și fără www. Până când robotul oglindă le lipește. Exemplu de înregistrare:

Gazdă: www.site

gazdă: site

În primul caz, robotul va indexa versiunea cu www, în al doilea caz fără. Este permisă o singură directivă Gazdă în fișierul robots.txt. Dacă scrieți mai multe dintre ele, botul îl va procesa și îl va lua în considerare doar pe primul.

O directivă gazdă validă ar trebui să aibă următoarele date:

— indicați protocolul de conectare (HTTP sau HTTPS);

- un nume de domeniu scris corect (nu poți scrie o adresă IP);

- numărul portului, dacă este necesar (de exemplu, Gazdă: site.com:8080).

Directivele făcute incorect vor fi pur și simplu ignorate.

Directiva privind întârzierea cu crawl

Directiva privind întârzierea cu crawler vă permite să reduceți sarcina pe server. Este necesar în cazul în care site-ul dvs. începe să cadă sub atacul diverșilor roboți. Directiva Crawl-delay îi spune robotului de căutare să aștepte între sfârșitul descărcării unei pagini și începutul descărcării unei alte pagini a site-ului. Directiva trebuie să apară imediat după intrările directivei „Disallow” și/sau „Allow”. Robotul de căutare Yandex poate citi valori fracționale. De exemplu: 1,5 (o secundă și jumătate).

Directiva Clean-param

Directiva Clean-param necesare site-urilor ale căror pagini conțin parametri dinamici. Vorbim despre cele care nu afectează conținutul paginilor. Acestea sunt diverse informații despre servicii: identificatori de sesiune, utilizatori, referreri etc. Deci, pentru a evita duplicarea acestor pagini, se folosește această directivă. Acesta va spune PS-ului să nu reîncarce informațiile de re-navetă. Încărcarea pe server și timpul necesar robotului pentru a accesa cu crawlere site-ul vor scădea, de asemenea.

Clean-param: s /forum/showthread.php

Această intrare îi spune PS că parametrul s va fi considerat nesemnificativ pentru toate adresele URL care încep cu /forum/showthread.php. Lungimea maximă a înregistrării este de 500 de caractere.

Ne-am dat seama de directive, să trecem la configurarea roboților noștri.

Setarea robots.txt

Trecem direct la configurarea fișierului robots.txt. Trebuie să conțină cel puțin două intrări:

agent utilizator:- indică pentru ce motor de căutare vor fi instrucțiunile de mai jos.

Nu permiteți:- Specifică care parte a site-ului nu trebuie indexată. Se poate închide de la indexarea atât a unei pagini separate a site-ului, cât și a secțiunilor întregi.

Mai mult, puteți specifica că aceste directive sunt destinate tuturor motoarelor de căutare, sau pentru unul anume. Acest lucru este specificat în directiva User-agent. Dacă doriți ca toți roboții să citească instrucțiunile, puneți un asterisc

Dacă doriți să scrieți instrucțiuni pentru un anumit robot, dar trebuie să specificați numele acestuia.

Agent utilizator: YandexBot

Un exemplu simplificat de fișier roboți compus corespunzător ar fi:

Agent utilizator: *

Nu permiteți: /files.php

Nu permiteți: /secțiune/

gazdă: site

Unde, *

spune că instrucțiunile sunt destinate tuturor PS;

Nu permiteți: /files.php- interzice indexarea fisierului file.php;

Nu permiteți: /foto/- interzice indexarea întregii secțiuni „foto” cu toate fișierele atașate;

gazdă: site- le spune roboților ce oglindă să indexeze.

Dacă site-ul dvs. nu are pagini care trebuie închise de la indexare, atunci fișierul dvs. robots.txt ar trebui să fie astfel:

Agent utilizator: *

Nu permiteți:

gazdă: site

Robots.txt pentru Yandex (Yandex)

Pentru a indica faptul că aceste instrucțiuni sunt destinate motorului de căutare Yandex, trebuie să specificați în directiva User-agent: Yandex. Mai mult, dacă scriem „Yandex”, atunci site-ul va fi indexat de toți roboții Yandex, iar dacă specificăm „YandexBot”, atunci aceasta va fi o comandă numai pentru robotul principal de indexare.

De asemenea, este necesar să înregistrați directiva „Gazdă”, unde să specificați oglinda principală a site-ului. După cum am scris mai sus, acest lucru se face pentru a preveni duplicarea paginilor. Robots.txt-ul tău corect pentru Yandex va fi astfel:

Agent utilizator: Yandex

Nu permiteți: /cgi-bin

Nu permiteți: /adminka

gazdă: site

Până acum, se aude deseori întrebări despre ce este mai bine de precizat în directiva gazdă, un site cu sau fără www. Și până la urmă, nu există nicio diferență. Cam așa îți place, cum ar arăta site-ul în SERP-uri. Principalul lucru este să nu uitați deloc să îl specificați, pentru a nu crea duplicate.

Robots.txt pentru Google

Motorul de căutare Google acceptă toate formatele obișnuite de introducere a fișierelor robots.txt. Adevărat, nu ține cont de directiva Gazdă. Prin urmare, nu vor exista diferențe față de Yandex. Robots.txt pentru Google va arăta astfel:

Agent utilizator: Googlebot

Nu permiteți: /cgi-bin

Nu permiteți: /adminka

Harta site-ului: http://site/sitemaps.xml

Sper că datele pe care le-am prezentat vor fi suficiente pentru a compila un fișier de înaltă calitate și, cel mai important, corect. robots.txt Dacă utilizați unul dintre CMS-urile populare, atunci în următorul articol am pregătit pentru dvs. o selecție de roboți - robots.txt pentru evaluări populare CMS 1, medie: 5,00

din 5)

/ vizualizare: 21952

Salutare dragi prieteni! Verificarea robots.txt este la fel de importantă ca și scrisul corect.

Verificarea fișierului robots.txt în panourile Yandex și Google Webmasters.

Verificând robots.txt, de ce este important să verificați?

Mai devreme sau mai târziu, fiecare autor de site care se respectă își amintește fișierul roboților. Despre acest fișier, plasat în rădăcina site-ului, este scris din belșug pe Internet. Aproape fiecare webmaster are un site despre relevanța și corectitudinea compilației sale. În acest articol, le voi reaminti bloggerilor începători cum să-l verifice folosind instrumentele din panoul pentru webmasteri furnizate de Yandex și Google.

În primul rând, puțin despre el. Fișierul Robots.txt (uneori numit în mod eronat robot.txt, la singular, se cere atenție la litera engleză s de la sfârșit) este creat de webmasteri pentru a marca sau interzice anumite fișiere și foldere ale unui site web, pentru păianjeni de căutare (ca precum și alte tipuri de roboți). Adică acele fișiere la care robotul motorului de căutare nu ar trebui să aibă acces.

Verificarea robots.txt este un atribut obligatoriu pentru autorul site-ului atunci când creează un blog pe WordPress și promovează în continuare. Mulți webmasteri vor vedea cu siguranță paginile proiectului. Analiza le spune roboților sintaxa corectă pentru a se asigura că este într-un format valid. Cert este că există un standard stabilit pentru excepții pentru roboți. Nu va fi de prisos să aflați înșiși părerea motoarelor de căutare, citiți documentația, în care motoarele de căutare și-au expus în detaliu viziunea asupra acestui dosar.

Toate acestea nu vor fi de prisos pentru a vă proteja în continuare site-ul de erori în timpul indexării. Cunosc exemple când, din cauza unui fișier compilat incorect, s-a dat un semnal de interzicere a vizibilității acestuia în rețea. Cu o corecție suplimentară, puteți aștepta mult timp pentru o schimbare a situației din jurul site-ului.

Nu mă voi opri asupra compilării corecte a fișierului în sine în acest articol. Există multe exemple pe net, poți să mergi pe blogul oricărui blogger popular și să adaugi /robots.txt la sfârșitul domeniului său pentru verificare. Browserul va afișa versiunea sa, pe care o puteți folosi ca bază. Cu toate acestea, fiecare are propriile excepții, așa că trebuie să verificați conformitatea în mod specific pentru site-ul dvs. De asemenea, o descriere și un exemplu de text corect pentru un blog WordPress pot fi găsite la:

Harta site-ului: http://site-ul dvs./sitemap.xml

Agent utilizator: Googlebot Image

#Google AdSense

Agent utilizator: Mediapartners-Google*

Agent utilizator: duggmirror

Nu permiteți: /cgi-bin/

Nu permiteți: /wp-admin/

Nu permiteți: /wp-includes/

Nu permiteți: /wp-content/plugins/

Nu permiteți: /wp-content/cache/

Disallow: /wp-content/themes/

Nu permiteți: /trackback/

Nu permiteți: /feed/

Nu permiteți: /comments/

Nu permite: /categorie/*/*

Nu permiteți: */trackback/

Nu permiteți: */feed/

Nu permiteți: */comentarii/

Permite: /wp-content/uploads/

Există unele diferențe în compilarea și verificarea ulterioară a fișierului robots.txt pentru principalele motoare de căutare Runet. Mai jos voi da exemple despre cum să verificați în panourile Yandex Webmaster și Google.

După ce ați compilat fișierul și l-ați încărcat la rădăcina site-ului dvs. prin FTP, trebuie să verificați dacă acesta este conform, de exemplu, cu motorul de căutare Yandex. Astfel, vom afla dacă nu am închis accidental acele pagini, datorită cărora vizitatorii vor veni la tine.

Se verifică robots.txt în panoul Yandex Webmaster

Trebuie să aveți un cont în panoul Yandex Webmaster. Intrând în instrumente și specificând site-ul dvs., în dreapta va fi o listă de funcții disponibile. Accesați fila „Verificați robots.txt”

Specificați domeniul dvs. și faceți clic pe „Descărcați robots.txt de pe site”. Dacă ați compilat un fișier care indică separat pentru fiecare motor de căutare, atunci trebuie să selectați liniile pentru Yandex și să le copiați în câmpul de mai jos. Vă reamintesc că directiva Host: este relevantă pentru Jand., așa că nu uitați să o introduceți în câmpul pentru verificare. Rămâne de verificat robots.txt. butonul din dreapta.

Veți vedea imediat o analiză de la Yandex pentru conformitatea cu robots.txt. Mai jos vor fi rândurile pe care Yand. acceptat spre considerare. Și uită-te la rezultatele testelor. Directivele sunt indicate în partea stângă a adresei URL. În dreapta este rezultatul în sine. După cum puteți vedea în captura de ecran, va fi corect să vedeți inscripția în roșu - interzisă de regulă și regula în sine este indicată. Dacă ați specificat o directivă pentru indexare, atunci vom vedea verde - este permis.

După ce verificați robots.txt, veți putea să vă corectați fișierul. De asemenea, recomand să verificați paginile site-ului. Lipiți adresa URL a unei singure intrări în câmpul /Lista de adrese URL/. Și la ieșire obținem rezultatul - permis. Deci putem verifica separat interdicțiile pentru arhive, categorii și așa mai departe.

Nu uitați să vă abonați, în următorul articol plănuiesc să vă arăt cum să vă înregistrați gratuit în catalogul Mail.ru. Nu ratați, .

Cum să verificați în Yandex Webmasters.

Verificați robots.txt în panoul Google Webmasters

Intrăm în contul tău și ne uităm în stânga /Stare/ - /Adrese URL blocate/Aici îi vom vedea prezența și posibilitatea de a-l edita. Dacă trebuie să verificați întregul site pentru conformitate, specificați adresa paginii principale în câmpul de mai jos. Este posibil să verificați modul în care diferiți roboți Google văd site-ul dvs., ținând cont de verificarea fișierului robots.txt

Pe lângă botul principal Google, alegem și un robot specializat în diferite tipuri de conținut (2). Captură de ecran de mai jos.

- Googlebot

- Imagine Googlebot

- Googlebot mobil

- Mediapartners-Google - Valori pentru AdSense

- AdsBot-Google - Verificarea calității paginii de destinație

Nu am găsit indicatori pentru alți roboți Google:

- Googlebot Video

- Știri Googlebot

Prin analogie cu verificarea fișierului robots.txt din panoul Yandex, există și posibilitatea de a analiza o pagină separată a site-ului. După verificare, veți vedea rezultatul separat pentru fiecare bot de căutare.

Cu condiția ca rezultatele verificării să nu ți se potrivească, trebuie doar să continui editarea. Și verificare în continuare.

Analizați robots.txt online

Pe lângă aceste funcții, puteți analiza și fișierul robots.txt folosind servicii online. Cele pe care le-am găsit sunt în mare parte vorbitoare de engleză. Mi-a plăcut acest serviciu. După analiză, se vor da recomandări pentru corectarea acesteia.

tool.motoricerca.info/robots-checker.phtml

Asta e tot. Sper că verificarea fișierului robots.txt prin ochii Yandex și Google nu v-a supărat? Dacă observați o nerespectare a dorințelor dvs., atunci puteți oricând edita și apoi reanaliza. Vă mulțumim pentru tweetul dvs. pe Twitter și pentru like pe Facebook!

Fișierul robots.txt este unul dintre cele mai importante atunci când optimizați orice site. Absența acestuia poate duce la o încărcare mare a site-ului din partea roboților de căutare și la indexare și reindexare lentă, iar o setare incorectă poate duce la dispariția completă a site-ului din căutare sau pur și simplu neindexat. Prin urmare, nu va fi căutat în Yandex, Google și alte motoare de căutare. Să aruncăm o privire la toate nuanțele configurarii corecte a robots.txt.

Mai întâi, un scurt videoclip care vă va oferi o idee generală despre ce este un fișier robots.txt.

Cum afectează robots.txt indexarea site-urilor

Roboții de căutare vor indexa site-ul dvs. indiferent de prezența unui fișier robots.txt. Dacă un astfel de fișier există, atunci roboții pot fi ghidați de regulile care sunt scrise în acest fișier. În același timp, unii roboți pot ignora anumite reguli sau unele reguli pot fi specifice doar unor roboți. În special, GoogleBot nu utilizează directivele Gazdă și Crawl-Delay, YandexNews a început recent să ignore directiva Crawl-Delay, iar YandexDirect și YandexVideoParser ignoră directivele roboților mai generale (dar sunt ghidate de cele specificate special pentru aceștia).

Mai multe despre excepții:

Excepții Yandex

Standard de excepție pentru robot (Wikipedia)

Sarcina maximă pe site este creată de roboții care descarcă conținut de pe site-ul dvs. Prin urmare, specificând ce să indexați și ce să ignorați, precum și la ce intervale de timp să descărcați, puteți, pe de o parte, să reduceți semnificativ încărcarea site-ului de la roboți și, pe de altă parte, să accelerați descărcarea. proces prin interzicerea ocolirii paginilor inutile.

Astfel de pagini inutile includ ajax, script-uri json responsabile de formulare pop-up, bannere, ieșire captcha etc., formulare de comandă și un coș de cumpărături cu toți pașii efectuării unei achiziții, funcționalitate de căutare, cont personal, panou de administrare.

Pentru majoritatea roboților, este, de asemenea, de dorit să dezactivați indexarea tuturor JS și CSS. Dar pentru GoogleBot și Yandex, astfel de fișiere trebuie lăsate pentru indexare, deoarece sunt folosite de motoarele de căutare pentru a analiza confortul site-ului și clasarea acestuia (dovada Google, dovada Yandex).

directive robots.txt

Directivele sunt reguli pentru roboți. Există o specificație W3C din 30 ianuarie 1994 și un standard extins din 1996. Cu toate acestea, nu toate motoarele de căutare și roboții acceptă anumite directive. În acest sens, ne va fi mai util să cunoaștem nu standardul, ci modul în care roboții principali sunt ghidați de anumite directive.

Să ne uităm la el în ordine.

agent utilizator

Aceasta este cea mai importantă directivă care determină pentru ce roboți urmează regulile.

Pentru toți roboții:

Agent utilizator: *

Pentru un anumit bot:

Agent utilizator: GoogleBot

Rețineți că robots.txt nu face distincție între majuscule și minuscule. Acestea. Agentul utilizator pentru Google poate fi scris la fel de bine astfel:

agent utilizator: googlebot

Mai jos este un tabel cu principalii agenți de utilizator ai diferitelor motoare de căutare.

| Bot | Funcţie |

|---|---|

| Googlebot | Principalul robot de indexare al Google |

| Știri Googlebot | Stiri google |

| Imagine Googlebot | Google Pictures |

| Googlebot Video | video |

| Mediapartners-Google | |

| parteneri media | Google Adsense, Google Mobile Adsense |

| AdsBot-Google | verificarea calității paginii de destinație |

| AdsBot-Google-Mobile-Apps | Robot Google pentru aplicații |

| Yandex | |

| YandexBot | Robotul principal de indexare al lui Yandex |

| YandexImagini | Yandex.Imagini |

| YandexVideo | Yandex.Video |

| YandexMedia | date multimedia |

| YandexBlogs | robot de căutare blog |

| YandexAddurl | robot care accesează pagina când aceasta este adăugată prin formularul „Adăugați URL”. |

| YandexFavicons | robot care indexează pictogramele site-ului (favicons) |

| YandexDirect | Yandex.Direct |

| YandexMetrika | Yandex.Metrica |

| YandexCatalog | Yandex.Catalog |

| YandexNews | Yandex.News |

| YandexImageResizer | robot de servicii mobile |

| Bing | |

| bingbot | principalul robot de indexare Bing |

| Yahoo! | |

| Slurp | robot de indexare principal Yahoo! |

| Mail.Ru | |

| Mail.Ru | robot de indexare principal Mail.Ru |

| Hoinar | |

| StackRambler | Fostul principal robot de indexare Rambler. Cu toate acestea, din 23 iunie 2011, Rambler nu mai susține propriul motor de căutare și acum utilizează tehnologia Yandex pentru serviciile sale. Nu mai este relevant. |

Permiteți și permiteți

Disallow închide paginile și secțiunile site-ului de la indexare.

Permite deschiderea forțată a paginilor și a secțiunilor site-ului pentru indexare.

Dar nu totul este atât de simplu aici.

În primul rând, trebuie să cunoașteți operatori suplimentari și să înțelegeți cum sunt utilizați - aceștia sunt *, $ și #.

* reprezintă orice număr de caractere, inclusiv absența acestora. În același timp, nu puteți pune un asterisc la sfârșitul liniei, se înțelege că este acolo implicit.

$ - indică faptul că caracterul dinaintea lui trebuie să fie ultimul.

# - comentează, totul după acest caracter din rând nu este luat în considerare de robot.

Exemple de utilizare:

Nu permite: *?s=

Nu permiteți: /categorie/$

În al doilea rând, trebuie să înțelegeți cum sunt executate regulile imbricate.

Nu uitați că ordinea în care sunt scrise directivele nu este importantă. Moștenirea regulilor a ceea ce se deschide sau se închide de la indexare este determinată de directoarele specificate. Să luăm un exemplu.

Permite: *.css

Nu permiteți: /șablon/

http://site.ru/template/ - închis de la indexare

http://site.ru/template/style.css - închis de la indexare

http://site.ru/style.css - deschis pentru indexare

http://site.ru/theme/style.css - deschis pentru indexare

Dacă doriți ca toate fișierele .css să fie deschise pentru indexare, va trebui să înregistrați suplimentar acest lucru pentru fiecare dintre folderele închise. În cazul nostru:

Permite: *.css

Permite: /template/*.css

Nu permiteți: /șablon/

Din nou, ordinea directivelor nu este importantă.

Harta site-ului

Directiva pentru specificarea căii către fișierul XML Sitemap. URL-ul este scris în același mod ca în bara de adrese.

De exemplu,

Harta site-ului: http://site.ru/sitemap.xml

Directiva Sitemap este specificată oriunde în fișierul robots.txt fără a fi legată de un anumit user-agent. Puteți specifica mai multe reguli pentru sitemap.

Gazdă

Directiva pentru specificarea oglinzii principale a site-ului (de cele mai multe ori: cu www sau fara www). Vă rugăm să rețineți că oglinda principală este indicată FĂRĂ http://, dar CU https://. De asemenea, dacă este necesar, se specifică portul.

Directiva este acceptată doar de roboții Yandex și Mail.Ru. Alți roboți, în special GoogleBot, nu vor lua în considerare comanda. Gazda este înregistrată o singură dată!

Exemplul 1:

Gazdă: site.ru

Exemplul 2:

Gazdă: https://site.ru

Crawl-întârziere

Directiva pentru setarea intervalului de timp dintre descărcarea paginilor site-ului de către robot. Sprijinit de roboții Yandex, Mail.Ru, Bing, Yahoo. Valoarea poate fi setată în unități întregi sau fracționale (separator - punct), timpul în secunde.

Exemplul 1:

Întârziere accesare cu crawlere: 3

Exemplul 2:

Întârziere de accesare cu crawlere: 0,5

Dacă site-ul are o încărcătură mică, atunci nu este nevoie să setați o astfel de regulă. Totuși, dacă indexarea paginilor de către un robot duce la faptul că site-ul depășește limitele sau suferă încărcări semnificative, până la întreruperi ale serverului, atunci această directivă va ajuta la reducerea încărcării.

Cu cât valoarea este mai mare, cu atât robotul va descărca mai puține pagini într-o singură sesiune. Valoarea optimă este determinată individual pentru fiecare site. Este mai bine să începeți cu valori nu foarte mari - 0,1, 0,2, 0,5 - și să le creșteți treptat. Pentru roboții motoarelor de căutare care sunt mai puțin importanți pentru rezultatele promovării, cum ar fi Mail.Ru, Bing și Yahoo, puteți seta inițial valori mai mari decât pentru roboții Yandex.

Curăță param

Această regulă îi spune crawler-ului că adresele URL cu parametrii specificați nu trebuie indexate. Regula are două argumente: un parametru și o adresă URL a secțiunii. Directiva este susținută de Yandex.

Clean-param: author_id http://site.ru/articles/

Clean-param: author_id&sid http://site.ru/articles/

Clean-Param: utm_source&utm_medium&utm_campaign

Alte optiuni

În specificația extinsă robots.txt, puteți găsi, de asemenea, parametrii Request-rate și Visit-time. Cu toate acestea, în prezent nu sunt acceptate de motoarele de căutare de top.

Semnificația directivelor:

Rata de solicitare: 1/5 - nu încărcați mai mult de o pagină în cinci secunde

Timp de vizită: 0600-0845 - Încărcați paginile numai între orele 6:00 și 8:45 GMT.

Se închide robots.txt

Dacă trebuie să configurați site-ul să NU fie indexat de roboții de căutare, atunci trebuie să scrieți următoarele directive:

Agent utilizator: *

interzice: /

Asigurați-vă că aceste directive sunt scrise pe site-urile de testare ale site-ului dvs.

Setarea corectă a robots.txt

Pentru Rusia și țările CSI, unde cota Yandex este tangibilă, directivele ar trebui scrise pentru toți roboții și separat pentru Yandex și Google.

Pentru Rusia și țările CSI, unde cota Yandex este tangibilă, directivele ar trebui scrise pentru toți roboții și separat pentru Yandex și Google.

Pentru a configura corect robots.txt, utilizați următorul algoritm:

- Închideți panoul de administrare a site-ului de la indexare

- Închidere cont personal, autorizare, înregistrare de la indexare

- Închideți coșul de cumpărături, formularele de comandă, expedierea și datele comenzii de la indexare

- Închideți de la indexarea ajax, scripturile json

- Închideți folderul cgi de la indexare

- Închideți pluginurile, temele, js, css de la indexare pentru toți roboții, cu excepția Yandex și Google

- Închideți funcționalitatea de căutare de la indexare

- Închideți secțiunile de servicii de la indexare care nu au nicio valoare pentru site-ul în căutare (eroare 404, lista autorilor)

- Închideți duplicatele tehnice ale paginilor din indexare, precum și paginile pe care tot conținutul este duplicat într-o formă sau alta din alte pagini (calendare, arhive, RSS)

- Închideți paginile de indexare cu opțiuni de filtrare, sortare, comparare

- Opriți indexarea paginilor cu etichete UTM și parametri de sesiuni

- Verificați ce este indexat de Yandex și Google folosind parametrul „site:” (tastați „site:site.ru” în bara de căutare). Dacă există pagini în căutare care trebuie să fie închise de la indexare, adăugați-le la robots.txt

- Specificați Sitemap și Gazdă

- Dacă este necesar, scrieți Crawl-Delay și Clean-Param

- Verificați corectitudinea fișierului robots.txt folosind instrumentele Google și Yandex (descrise mai jos)

- După 2 săptămâni, verificați din nou dacă există pagini noi în SERP care nu ar trebui să fie indexate. Dacă este necesar, repetați pașii de mai sus.

exemplu robots.txt

# Un exemplu de fișier robots.txt pentru configurarea unui site ipotetic https://site.ru User-agent: * Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: * /?s= Disallow: *sort= Disallow: *view= Disallow: *utm= Crawl-Delay: 5 User-agent: GoogleBot Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow : */?s = Nepermis: *sort= Nepermis: *view= Disallow: *utm= Permite: /plugins/*.css Permite: /plugins/*.js Permite: /plugins/*.png Permite: /plugins/ *.jpg Permite: /plugins/*.gif Agent utilizator: Yandex Disallow: /admin/ Disallow: /plugins/ Disallow: /search/ Disallow: /cart/ Disallow: */?s= Disallow: *sort= Disallow: *view= Permite: /plugins/*.css Permite: /plugins/*.js Permite: /plugins/*.png Permite: /plugins/*.jpg Permite: /plugins/*.gif Clean-Param: utm_source&utm_medium&utm_campaign Crawl- Întârziere: 0,5 Sitemap: https://site.ru/sitemap.xml Gazdă: https://site.ruCum se adaugă și unde este robots.txt

După ce ați creat fișierul robots.txt, acesta trebuie plasat pe site-ul dvs. la site.ru/robots.txt - adică. în directorul rădăcină. Crawler-ul accesează întotdeauna fișierul la adresa URL /robots.txt

Cum se verifică robots.txt

Verificarea robots.txt se efectuează la următoarele link-uri:

- În Yandex.Webmaster — în fila Instrumente> Analiză Robots.txt

- ÎN Google Search Console- în fila Scanare > instrument de inspecție a fișierelor robots.txt

Greșeli frecvente în robots.txt

La sfârșitul articolului, voi da câteva erori tipice ale fișierului robots.txt.

La sfârșitul articolului, voi da câteva erori tipice ale fișierului robots.txt.

- robots.txt lipsește

- în robots.txt site-ul este închis de la indexare (Disallow: /)

- fișierul conține doar cele mai elementare directive, nu există un studiu detaliat al fișierului

- paginile cu etichete UTM și ID-uri de sesiune nu sunt blocate de la indexare în fișier

- fisierul contine doar directive

Permite: *.css

Permite: *.js

Permite: *.png

Permite: *.jpg

Permite: *.gif

în timp ce fișierele css, js, png, jpg, gif sunt închise de alte directive într-un număr de directoare - Directiva gazdă este scrisă de mai multe ori

- Gazda nu specifică protocolul https

- calea către Harta site-ului este incorectă sau este specificat un protocol sau o oglindă a site-ului greșit

P.S.

P.S.2

Video util de la Yandex (Atenție! Unele recomandări sunt potrivite numai pentru Yandex).