Registrazione del suono- il processo di registrazione dei segnali audio. Il risultato di una registrazione sonora è un fonogramma.

Attrezzatura necessaria: un dispositivo per convertire le vibrazioni acustiche in un segnale elettrico (microfono) o un generatore di suoni (es. sintetizzatore di suoni, campionatore), un dispositivo per convertire le vibrazioni elettriche in una sequenza di numeri (nella registrazione digitale), un dispositivo di memorizzazione (nastro registratore, disco rigido del computer o altro dispositivo per la memorizzazione delle informazioni ricevute sul supporto). La registrazione del suono può essere mono, stereo o quadrifonica.

La più antica registrazione sonora conosciuta fu effettuata il 9 aprile 1860 dall'inventore parigino Édouard-Leon Scott de Martinville, utilizzando un dispositivo chiamato "fonoautografo".

A seconda della conservazione, ci sono due tipi principali di registrazione del suono: analogico e digitale.

Registrazione audio analogica[ | ]

registrazione del suono magnetico[ | ]

La registrazione viene eseguita utilizzando una testina di registrazione magnetica, che crea un campo magnetico alternato su una sezione di un mezzo in movimento (spesso un nastro magnetico) che ha proprietà magnetiche. Una traccia di magnetizzazione residua rimane sullo strato ferromagnetico del supporto. La traccia è la traccia del fonogramma. Durante la riproduzione, la testina magnetica converte il flusso magnetico residuo del supporto di registrazione in movimento in un segnale audio elettrico.

Audio digitale[ | ]

La registrazione digitale è la digitalizzazione e la memorizzazione del suono sotto forma di un insieme di bit (sequenza di bit), che descrive la riproduzione dell'uno o dell'altro dispositivo.

Audio digitale magnetico[ | ]

I segnali digitali sono registrati su nastro magnetico. Esistono due tipi di record:

registrazione magneto-ottica[ | ]

La registrazione su un disco magneto-ottico viene effettuata secondo la seguente tecnologia: la radiazione laser riscalda un tratto della pista al di sopra della temperatura del punto di Curie, dopodiché un impulso elettromagnetico modifica la magnetizzazione, creando stampe equivalenti a fosse sui dischi ottici. La lettura viene effettuata dallo stesso laser, ma ad una potenza inferiore, insufficiente per riscaldare il disco: un raggio laser polarizzato attraversa il materiale del disco, viene riflesso dal substrato, attraversa il sistema ottico e colpisce il sensore. In questo caso, a seconda della magnetizzazione, il piano di polarizzazione del raggio laser cambia (effetto Kerr), determinato dal sensore.

registrazione laser [ | ]

Durante la scrittura, i dati vengono scritti sul disco con un raggio laser ad alta potenza per "bruciare" fisicamente il colorante organico dello strato di registrazione. Quando il colorante viene riscaldato al di sopra di una certa temperatura, si rompe e si scurisce, modificando la riflettività dell'area bruciata. Così, durante la scrittura, controllando la potenza del laser, si ottiene un'alternanza di macchie scure e chiare sullo strato di registrazione che, una volta lette, vengono interpretate come fosse. Durante la lettura, il laser ha una potenza molto inferiore rispetto alla scrittura e non distrugge il colorante dello strato di registrazione. Il raggio riflesso dallo strato riflettente colpisce il fotodiodo e se il raggio colpisce un'area scura - "bruciata", il raggio quasi non lo attraversa fino allo strato riflettente e il fotodiodo registra l'indebolimento del flusso luminoso. L'alternanza di sezioni chiare e scure del binario generano un cambiamento nel flusso luminoso del raggio riflesso e si traducono in un cambiamento nel segnale elettrico, che viene ulteriormente convertito in bit di informazione dal sistema di azionamento elettrico - "decodificato".

Registrazione audio digitale ottica[ | ]

L'accompagnamento sonoro al film viene stampato direttamente su pellicola da 35 mm utilizzando il metodo ottico in una forma codificata digitalmente. Durante la riproduzione, il segnale digitale viene letto da un apposito allegato al proiettore cinematografico e quindi decodificato dal processore in un fonogramma multicanale.

Formati audio digitali[ | ]

I dati audio vengono registrati in un file di un determinato formato, che viene archiviato su un supporto audio elettronico.

Tutti i diritti in questo documento appartengono agli autori. La riproduzione di questo testo o di parte di esso è consentita solo previa autorizzazione scritta di entrambi gli autori.

Di recente, le capacità delle apparecchiature multimediali hanno subito una crescita significativa, ma per qualche motivo a quest'area non è stata prestata sufficiente attenzione. L'utente medio soffre di una mancanza di informazioni ed è costretto a imparare solo dalla propria esperienza e dai propri errori. Con questo articolo cercheremo di eliminare questo fastidioso malinteso. Questo articolo è focalizzato sull'utente medio e mira ad aiutarlo a comprendere i fondamenti teorici e pratici del suono digitale, ad identificare le possibilità ei metodi di base del suo utilizzo.

Cosa sappiamo esattamente delle capacità audio di un computer, oltre al fatto che il nostro computer di casa ha una scheda audio e due altoparlanti? Sfortunatamente, probabilmente per mancanza di letteratura o per qualche altro motivo, ma l'utente, il più delle volte, non ha familiarità con nient'altro che il mixer di ingresso/uscita audio integrato in Windows e il Registratore. L'unico uso di una scheda audio che un utente semplice trova è l'output del suono nei giochi e l'ascolto di una raccolta di audio. Ma, dopo tutto, anche la più semplice scheda audio installata in quasi tutti i computer oggi può fare molto di più: apre le più ampie possibilità per tutti coloro che amano e sono interessati alla musica e al suono e per coloro che vogliono creare la propria musica, una scheda audio può diventare uno strumento onnipotente. Per scoprire cosa può fare un computer nel campo del suono, devi solo interessarti e si apriranno opportunità davanti a te che potresti nemmeno immaginare. E tutto questo non è così difficile come potrebbe sembrare a prima vista.

Alcuni fatti e concetti di cui è difficile fare a meno.

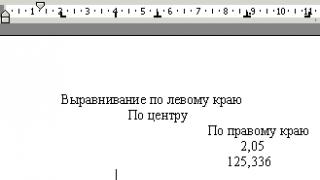

Secondo la teoria del matematico Fourier, un'onda sonora può essere rappresentata come uno spettro di frequenze in essa incluse (Fig. 1).

Le componenti di frequenza dello spettro sono oscillazioni sinusoidali (i cosiddetti toni puri), ognuna delle quali ha una propria ampiezza e frequenza. Pertanto, qualsiasi oscillazione, anche la più complessa nella forma (ad esempio una voce umana), può essere rappresentata dalla somma delle più semplici oscillazioni sinusoidali di determinate frequenze e ampiezze. E viceversa, generando varie vibrazioni e sovrapponendole l'una all'altra (mixing, mixing), si ottengono suoni diversi.

Riferimento: l'apparecchio acustico/cervello umano è in grado di distinguere le componenti di frequenza del suono nell'intervallo da 20 Hz a ~20 kHz (il limite superiore può variare a seconda dell'età e di altri fattori). Inoltre, il limite inferiore varia notevolmente a seconda dell'intensità del suono.

1. Digitalizzazione del suono e sua memorizzazione su supporto digitale

Il suono analogico "normale" è rappresentato nelle apparecchiature analogiche da un segnale elettrico continuo. Il computer opera con dati in forma digitale. Ciò significa che il suono nel computer è rappresentato in forma digitale. Come viene convertito il segnale analogico in digitale?

L'audio digitale è un modo per rappresentare un segnale elettrico in termini di valori numerici discreti della sua ampiezza. Supponiamo di avere una colonna sonora analogica di buona qualità (con "buona qualità" si intende una registrazione silenziosa contenente componenti spettrali dell'intera gamma di frequenze udibili - approssimativamente da 20 Hz a 20 kHz) e di volerla "introdurre" in un computer (cioè digitalizzarlo) senza perdita di qualità. Come si può raggiungere questo obiettivo e come sta procedendo la digitalizzazione? Un'onda sonora è una specie di funzione complessa, la dipendenza dell'ampiezza di un'onda sonora dal tempo. Sembrerebbe che, trattandosi di una funzione, sia possibile scriverla sul computer "così com'è", ovvero descrivere la forma matematica della funzione e salvarla nella memoria del computer. Tuttavia, questo è praticamente impossibile, poiché le vibrazioni sonore non possono essere rappresentate da una formula analitica (come y=x 2 , per esempio). C'è solo un modo rimasto: descrivere la funzione memorizzando i suoi valori discreti in determinati punti. In altre parole, in ogni momento, il valore dell'ampiezza del segnale può essere misurato e scritto come numeri. Tuttavia, questo metodo ha anche i suoi svantaggi, poiché non possiamo registrare i valori di ampiezza del segnale con precisione infinita e siamo costretti ad arrotondarli per eccesso. In altre parole, approssimeremo questa funzione lungo due assi di coordinate: ampiezza e tempo (approssimare in punti significa, in parole povere, prendere i valori della funzione in punti e scriverli con precisione finita). Pertanto, la digitalizzazione di un segnale comprende due processi: il processo di campionamento (campionamento) e il processo di quantizzazione. Il processo di campionamento è il processo per ottenere i valori del segnale convertito a determinati intervalli di tempo (Fig. 2).

La quantizzazione è il processo di sostituzione dei valori del segnale reale con quelli approssimativi con una certa precisione (Fig. 3). Pertanto, la digitalizzazione sta fissando l'ampiezza del segnale a determinati intervalli e registrando i valori di ampiezza ottenuti sotto forma di valori digitali arrotondati (poiché i valori di ampiezza sono un valore continuo, non è possibile annotare il valore esatto dell'ampiezza del segnale in un numero finito, motivo per cui ricorrono all'arrotondamento). I valori di ampiezza del segnale registrati sono chiamati letture. Ovviamente, più spesso prendiamo misure di ampiezza (maggiore è la frequenza di campionamento) e meno arrotondiamo i valori ottenuti (maggiori sono i livelli di quantizzazione), più accurata sarà la rappresentazione del segnale in forma digitale che avremo. Il segnale digitalizzato come insieme di valori di ampiezza successivi può essere memorizzato.

Ora per le questioni pratiche. Innanzitutto, va tenuto presente che la memoria del computer non è infinita, quindi ogni volta che si digitalizza, è necessario trovare una sorta di compromesso tra la qualità (direttamente dipendente dai parametri utilizzati nella digitalizzazione) e il volume occupato dal segnale digitalizzato .

In secondo luogo, secondo il teorema di Kotelnikov, la frequenza di campionamento stabilisce il limite superiore delle frequenze del segnale digitalizzato, ovvero la frequenza massima delle componenti spettrali è uguale alla metà della frequenza di campionamento del segnale. In poche parole, per ottenere informazioni complete sul suono nella banda di frequenza fino a 22050 Hz, è necessario campionare almeno 44,1 kHz.

Ci sono altri problemi e sfumature associati alla digitalizzazione del suono. Senza entrare troppo nei dettagli, notiamo che a causa della discrezione delle informazioni sull'ampiezza del segnale originale, nel "suono digitale" compaiono vari rumori e distorsioni (la frase "ci sono tali e tali frequenze e rumori nel suono digitale" significa che quando questo suono viene riconvertito da digitale ad analogico, le frequenze e i rumori menzionati saranno presenti nel suo suono). Quindi, ad esempio, il jitter (jitter) è un rumore che appare come risultato del fatto che il campionamento di un segnale durante il campionamento non avviene ad intervalli di tempo assolutamente uguali, ma con alcune deviazioni. Cioè, se, ad esempio, il campionamento viene eseguito a una frequenza di 44,1 kHz, i campioni vengono prelevati non esattamente ogni 1/44100 di secondo, ma a volte un po' prima, a volte un po' più tardi. E poiché il segnale di ingresso è in continua evoluzione, un tale errore porta a una "cattura" di un livello di segnale non del tutto corretto. Di conseguenza, durante la riproduzione di un segnale digitalizzato potrebbero verificarsi jitter e distorsioni. L'aspetto del jitter è il risultato della stabilità non assoluta dei convertitori analogico-digitali. Per combattere questo fenomeno vengono utilizzati generatori di clock altamente stabili. Un altro problema è il rumore di schiacciamento. Come abbiamo detto, quando l'ampiezza del segnale è quantizzata, viene arrotondata al livello più vicino. Un tale errore provoca una sensazione di suono "sporco".

Un piccolo riferimento: i parametri standard per la registrazione di CD audio sono i seguenti: frequenza di campionamento - 44,1 kHz, livello di quantizzazione - 16 bit. Tali parametri corrispondono a 65536 (2 16) livelli di quantizzazione dell'ampiezza quando si prendono i suoi valori 44100 volte al secondo.

In pratica il processo di digitalizzazione (campionamento e quantizzazione del segnale) rimane invisibile all'utente - tutto il lavoro grossolano viene svolto da vari programmi che danno gli opportuni comandi al driver (sottoprogramma di controllo del sistema operativo) della scheda audio . Qualsiasi programma (integrato in Windows Recorder o un potente editor di suoni) in grado di registrare un segnale analogico su un computer digitalizza in qualche modo il segnale con determinati parametri che possono essere importanti nel lavoro successivo con il suono registrato, ed è per questo motivo che è importante capire come avviene il processo di digitalizzazione e quali fattori ne influenzano i risultati.

2. Conversione audio da digitale ad analogico

Come ascoltare il suono dopo la digitalizzazione? Cioè, come riconvertirlo da digitale ad analogico?

Per convertire il segnale campionato in una forma analogica adatta per l'elaborazione da parte di dispositivi analogici (amplificatori e filtri) e la successiva riproduzione attraverso sistemi acustici, viene utilizzato un convertitore digitale-analogico (DAC). Il processo di conversione è un processo di campionamento inverso: avendo informazioni sul valore dei campioni (ampiezza del segnale) e prelevando un certo numero di campioni per unità di tempo, il segnale originale viene ripristinato per interpolazione (Fig. 4).

Più recentemente, la riproduzione del suono nei computer domestici è stata un problema, poiché i computer non erano dotati di DAC speciali. All'inizio, l'altoparlante integrato (altoparlante per PC) veniva utilizzato come il dispositivo audio più semplice in un computer. In generale, quasi tutti i PC hanno ancora questo altoparlante, ma nessuno ricorda come "rockeggiarlo" in modo che inizi a suonare. In breve, questo altoparlante è collegato a una porta sulla scheda madre, che ha due posizioni: 1 e 0. Quindi, se questa porta viene attivata e disattivata rapidamente, è possibile estrarre suoni più o meno plausibili dall'altoparlante. La riproduzione di diverse frequenze è ottenuta grazie al fatto che il cono dell'altoparlante ha una risposta finita e non è in grado di saltare istantaneamente da un posto all'altro, quindi "oscilla dolcemente" a causa di un brusco cambiamento di tensione attraverso di esso. E se lo fai vibrare a velocità diverse, puoi ottenere vibrazioni dell'aria a frequenze diverse. Il cosiddetto Covox è diventato una naturale alternativa alla dinamica - questo è il DAC più semplice, realizzato su diverse resistenze selezionate (o un microcircuito finito), che forniscono il trasferimento della rappresentazione digitale del segnale all'analogico - cioè a valori di ampiezza reali. Covox è facile da produrre e quindi è stato un successo tra gli hobbisti fino al momento in cui la scheda audio è diventata disponibile per tutti.

In un computer moderno, il suono viene riprodotto e registrato utilizzando una scheda audio collegata o integrata nella scheda madre del computer. Lo scopo di una scheda audio in un computer è di inviare e trasmettere l'audio. In pratica, questo significa che la scheda audio è il convertitore che converte il suono analogico in digitale e viceversa. In modo semplicistico, il funzionamento di una scheda audio può essere spiegato come segue. Supponiamo che all'ingresso della scheda audio venga applicato un segnale analogico e che la scheda sia accesa (tramite software) nella modalità Innanzitutto, il segnale analogico in ingresso viene inviato al mixer analogico, che gestisce il mixaggio dei segnali e regola il volume e il bilanciamento. Il miscelatore è necessario, in particolare, per consentire all'utente di controllare i livelli Fig. Quindi il segnale regolato e bilanciato entra nel convertitore analogico-digitale, dove il segnale viene campionato e quantizzato, a seguito del quale un flusso di bit viene inviato al computer tramite il bus dati, che è un segnale audio digitalizzato. L'output delle informazioni audio è quasi lo stesso dell'input, solo che avviene nella direzione opposta. Il flusso di dati diretto alla scheda audio supera il convertitore digitale-analogico, che forma un segnale elettrico dai numeri che descrivono l'ampiezza del segnale; il segnale analogico ricevuto può essere fatto passare attraverso qualsiasi percorso analogico per ulteriori conversioni, inclusa la riproduzione. Va notato che se la scheda audio è dotata di un'interfaccia per lo scambio di dati digitali, quando si lavora con l'audio digitale, non vengono utilizzati blocchi analogici della scheda. .

3. Modi per memorizzare l'audio digitale

Esistono molti modi diversi per archiviare l'audio digitale. Come abbiamo detto, il suono digitalizzato è un insieme di valori di ampiezza del segnale rilevati a determinati intervalli di tempo. Pertanto, in primo luogo, un blocco di informazioni audio digitalizzate può essere scritto in un file "così com'è", cioè da una sequenza di numeri (valori di ampiezza). In questo caso, ci sono due modi per memorizzare le informazioni.

Il primo (Fig. 5) - PCM (Pulse Code Modulation - Pulse Code Modulation) - un metodo per codificare digitalmente un segnale registrando i valori assoluti delle ampiezze (ci sono rappresentazioni con segno o senza segno). È in questa forma che i dati vengono registrati su tutti i CD audio. Il secondo metodo (Fig. 6) - ADPCM (Adaptive Delta PCM - modulazione adattiva del codice di impulso relativo) - registrando i valori del segnale non in assoluto, ma in variazioni relative di ampiezza (incrementi).

In secondo luogo, puoi comprimere o semplificare i dati in modo che occupino meno memoria che se fossero scritti "così come sono". Anche qui ci sono due strade.

La codifica senza perdita di dati è un metodo di codifica audio che consente il recupero dei dati al 100% da un flusso compresso. Questo metodo di compattazione dei dati viene utilizzato nei casi in cui la conservazione della qualità dei dati originali è fondamentale. Ad esempio, dopo aver mixato il suono in uno studio di registrazione, i dati devono essere archiviati nella loro qualità originale per un eventuale uso successivo. Gli algoritmi di codifica Lossless che esistono oggi (ad esempio Monkeys Audio) possono ridurre la quantità di dati occupati del 20-50%, ma allo stesso tempo fornire un recupero del 100% dei dati originali da quelli ottenuti dopo la compressione. Tali codificatori sono una sorta di archiviatori di dati (come ZIP, RAR e altri), destinati esclusivamente alla compressione audio.

C'è anche un secondo metodo di codifica, di cui parleremo più in dettaglio: la codifica con perdita. Ciò si ottiene utilizzando vari algoritmi che "semplificano" il segnale originale (eliminando da esso dettagli "non necessari" difficili da ascoltare), il che porta al fatto che il segnale decodificato cessa effettivamente di essere identico all'originale, ma solo suona simile. Esistono molti metodi di compressione, nonché programmi che implementano questi metodi. I più famosi sono MPEG-1 Layer I, II, III (l'ultimo è il noto MP3), MPEG-2 AAC (codifica audio avanzata), Ogg Vorbis, Windows Media Audio (WMA), TwinVQ (VQF), MPEGPlus , TAC e altri. In media, il rapporto di compressione fornito da tali encoder è compreso tra 10 e 14 (volte). Va sottolineato che alla base di tutti i lossy encoder c'è l'uso del cosiddetto modello psicoacustico, che è proprio ciò che "semplifica" il segnale originario. Più precisamente, il meccanismo di tali codificatori esegue un'analisi del segnale codificato, durante la quale vengono determinate sezioni del segnale, in determinate regioni di frequenza di cui sono presenti sfumature (frequenze mascherate o impercettibili) che sono impercettibili all'orecchio umano, dopodiché vengono rimossi dal segnale originale. Pertanto, il grado di compressione del segnale originale dipende dal grado della sua "semplificazione"; una forte compressione si ottiene per "semplificazione aggressiva" (quando l'encoder "ritiene" non necessarie più sfumature), tale compressione porta naturalmente a un grave degrado della qualità, poiché è possibile rimuovere non solo i dettagli sonori impercettibili, ma anche significativi.

Come abbiamo detto, ci sono molti moderni codificatori con perdita di dati. Il formato più comune è MPEG-1 Layer III (il noto MP3). Il formato ha guadagnato la sua popolarità in modo abbastanza meritato: è stato il primo codec comune del suo genere, a raggiungere un livello di compressione così elevato con un'eccellente qualità del suono. Oggi ci sono molte alternative a questo codec, la scelta spetta all'utente. Sfortunatamente, lo scopo dell'articolo non consente di testare e confrontare i codec esistenti qui, ma gli autori dell'articolo si prendono la libertà di fornire alcune informazioni utili nella scelta di un codec. Quindi, i vantaggi dell'MP3 sono l'ampia distribuzione e la qualità piuttosto elevata della codifica, che migliora oggettivamente grazie allo sviluppo di vari codificatori MP3 da parte degli appassionati (ad esempio il codificatore Lame). Una potente alternativa all'MP3 è il codec Microsoft Windows Media Audio (file .WMA e .ASF). Secondo vari test, questo codec si mostra da "come MP3" a "notevolmente peggiore di MP3" a bitrate medi e, più spesso, "meglio di MP3" a bitrate bassi. Ogg Vorbis (file .OGG) è un codec completamente privo di licenza creato da sviluppatori indipendenti. Molto spesso si comporta meglio dell'MP3, lo svantaggio è solo una bassa prevalenza, che può essere un argomento critico quando si sceglie un codec per l'archiviazione audio a lungo termine. Ricordiamo anche il giovane codec MP3 Pro, annunciato nel luglio 2001 da Coding Technologies insieme a Thomson Multimedia. Il codec è una continuazione, o meglio un'evoluzione del vecchio MP3 - è compatibile con MP3 indietro (completamente) e avanti (parzialmente). Grazie all'uso della nuova tecnologia SBR (Spectral Band Replication), il codec si comporta notevolmente meglio di altri formati a bitrate bassi, tuttavia, la qualità di codifica a bitrate medi e alti è spesso inferiore alla qualità di quasi tutti i codec descritti. Pertanto, MP3 Pro è più adatto per condurre trasmissioni audio su Internet, nonché per creare anteprime di brani e musica.

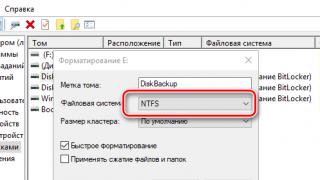

Parlando dei modi di immagazzinare il suono in forma digitale, non si può fare a meno di ricordare il supporto di memorizzazione. Il familiare CD audio, apparso nei primi anni '80, si è diffuso negli ultimi anni (a causa della significativa riduzione del costo di supporti e unità). E prima ancora, i supporti di dati digitali erano cassette a nastro magnetico, ma non ordinarie, ma appositamente progettate per i cosiddetti registratori a nastro DAT. Niente di straordinario: i registratori a nastro sono come i registratori a nastro, ma il prezzo per loro è sempre stato alto e un tale piacere non era per tutti. Questi registratori sono stati utilizzati principalmente negli studi di registrazione. Il vantaggio di tali registratori era che, nonostante l'uso di supporti convenzionali, i dati su di essi venivano archiviati in forma digitale e non si verificavano praticamente perdite durante la lettura / scrittura su di essi (che è molto importante nell'elaborazione e nella memorizzazione del suono in studio). Oggi è apparso un gran numero di diversi supporti di dati, oltre ai soliti compact disc. I vettori vengono migliorati e diventano ogni anno più convenienti e compatti. Ciò apre grandi opportunità nel campo della creazione di lettori audio mobili. Già oggi viene venduto un numero enorme di diversi modelli di lettori digitali portatili. E possiamo presumere che questo sia lontano dall'apice dello sviluppo di questo tipo di tecnologia.

4. Vantaggi e svantaggi dell'audio digitale

Dal punto di vista di un utente ordinario, i vantaggi sono molti: la compattezza dei moderni supporti di memorizzazione gli consente, ad esempio, di trasferire tutti i dischi e i record dalla sua collezione alla rappresentazione digitale e di archiviarli per molti anni su un piccolo tre- disco rigido da pollici o su una dozzina o due CD; puoi utilizzare un software speciale e "pulire" a fondo i vecchi dischi da bobine e dischi, rimuovendo il rumore e il crepitio dal loro suono; puoi anche non solo correggere il suono, ma anche abbellirlo, aggiungere ricchezza, volume e ripristinare le frequenze. Oltre alle suddette manipolazioni con il suono a casa, Internet viene in aiuto anche a un amante dell'audio. Ad esempio, il Web consente alle persone di condividere musica, ascoltare centinaia di migliaia di diverse stazioni radio Internet e mostrare al pubblico le proprie creazioni audio con solo un computer e Internet. E, infine, è apparsa di recente un'enorme massa di varie apparecchiature audio digitali portatili, le cui capacità anche del rappresentante più medio spesso rendono facile portare con sé una raccolta di musica in viaggio, della durata di decine di ore .

Dal punto di vista professionale, il suono digitale apre possibilità davvero immense. Se i precedenti studi audio e radiofonici si trovavano su diverse decine di metri quadrati, ora possono essere sostituiti da un buon computer, che in termini di capacità supera dieci di questi studi messi insieme e in termini di costi è molte volte più economico di uno. Ciò rimuove molte barriere finanziarie e rende la registrazione del suono più accessibile sia ai professionisti che ai dilettanti. Il software moderno ti consente di fare qualsiasi cosa con il suono. In precedenza, vari effetti sonori venivano ottenuti con l'aiuto di dispositivi ingegnosi, che non erano sempre all'altezza del pensiero tecnico o erano semplicemente dispositivi artigianali. Oggi, gli effetti più complessi e prima inimmaginabili si ottengono premendo un paio di pulsanti. Naturalmente, quanto sopra è alquanto esagerato e un computer non sostituisce una persona: un tecnico del suono, un regista o un montatore, ma possiamo affermare con sicurezza che la compattezza, la mobilità, la potenza colossale e la qualità delle moderne apparecchiature digitali progettate per l'elaborazione del suono hanno ha quasi completamente sostituito la vecchia attrezzatura analogica.

Naturalmente, anche la tecnologia digitale ha i suoi svantaggi. Molti (professionisti e dilettanti) notano che il suono analogico si sentiva più vivace. E questo non è solo un omaggio al passato. Come abbiamo detto sopra, il processo di digitalizzazione introduce un certo errore nel suono, inoltre, varie apparecchiature di amplificazione digitale introducono il cosiddetto "rumore del transistor" e altre distorsioni specifiche. Il termine "rumore del transistor", forse, non ha una definizione precisa, ma possiamo dire che si tratta di oscillazioni caotiche nella regione delle alte frequenze. Nonostante il fatto che l'apparecchio acustico umano sia in grado di percepire frequenze fino a 20 kHz, sembra che il cervello umano raccolga ancora frequenze più alte. Ed è a livello subconscio che una persona sente ancora che il suono analogico è più pulito di quello digitale.

Tuttavia, la rappresentazione digitale dei dati ha un vantaggio indiscutibile e molto importante: con un supporto di archiviazione sicuro, i dati su di esso non vengono distorti nel tempo. Se il nastro magnetico si smagnetizza nel tempo e la qualità della registrazione va persa, se il disco è graffiato e al suono vengono aggiunti clic e crepitii, allora il CD/disco rigido/memoria elettronica è leggibile (in caso di sicurezza) o no, e non vi è alcun effetto di invecchiamento. È importante notare che non stiamo parlando del CD audio (CD-DA è uno standard che imposta i parametri e il formato per la registrazione su CD audio), perché nonostante si tratti di un supporto di informazioni digitali, l'effetto di l'invecchiamento non lo aggira. Ciò è dovuto alle peculiarità della memorizzazione e della lettura dei dati audio da un CD audio. Le informazioni su tutti i tipi di CD vengono memorizzate fotogramma per fotogramma e ogni fotogramma ha un'intestazione con cui può essere identificato. Tuttavia, diversi tipi di CD hanno strutture diverse e utilizzano metodi di marcatura dei frame diversi. Poiché le unità CD-ROM dei computer sono progettate per leggere i principali CD-Dati (va detto che esistono diverse versioni dello standard CD-Dati, ognuna delle quali integra lo standard CD-DA principale), spesso non sono in grado di "orientare" al CD Audio, dove il metodo di marcatura dei frame è diverso da Data-CD (nei CD audio, i frame non hanno un'intestazione speciale e per determinare l'offset di ogni frame è necessario seguire il informazioni nella cornice). Ciò significa che se l'unità si "orienta" facilmente sul disco durante la lettura di un CD di dati e non confonde mai i frame, durante la lettura da un CD audio, l'unità non può orientarsi chiaramente, il che, ad esempio, appare un graffio o della polvere , può portare a leggere il fotogramma sbagliato e, di conseguenza, a un salto o un crepitio nel suono. Lo stesso problema (l'impossibilità della maggior parte dei drive di posizionarsi correttamente su CD-DA) è causa di un altro spiacevole effetto: la copia di informazioni da un CD Audio provoca problemi anche con dischi completamente integri per il fatto che il corretto "orientamento sul disco " dipende completamente dall'unità di lettura e non può essere chiaramente controllata dal software.

L'ubiquità e l'ulteriore sviluppo dei già citati codificatori audio con perdita (MP3, AAC e altri) ha aperto le più ampie possibilità per la distribuzione e l'archiviazione dell'audio. I moderni canali di comunicazione consentono da tempo il trasferimento di grandi quantità di dati in un tempo relativamente breve, ma il trasferimento di dati tra l'utente finale e il fornitore di servizi di comunicazione rimane il più lento. Le linee telefoniche che la maggior parte degli utenti si connettono a Internet non consentono un veloce trasferimento dei dati. Inutile dire che tali volumi di dati occupati dalle informazioni audio e video non compresse impiegheranno molto tempo per essere trasferiti attraverso i consueti canali di comunicazione. Tuttavia, l'avvento di codificatori con perdita di dati che forniscono una compressione da dieci a quindici volte ha trasformato il trasferimento e lo scambio di dati audio in un'attività quotidiana per ogni utente di Internet e ha rimosso tutte le barriere formate da canali di comunicazione deboli. A questo proposito, va detto che le comunicazioni mobili digitali, che oggi si stanno sviluppando a passi da gigante, sono in gran parte dovute alla codifica con perdita di dati. Il fatto è che i protocolli per la trasmissione dell'audio sui canali di comunicazione mobile funzionano all'incirca secondo gli stessi principi dei noti codificatori musicali. Pertanto, l'ulteriore sviluppo nel campo della codifica audio porta invariabilmente a una diminuzione del costo della trasmissione dei dati nei sistemi mobili, di cui beneficia solo l'utente finale: la comunicazione diventa più economica, si aprono nuove opportunità, la durata della batteria dei dispositivi mobili viene estesa, eccetera. In misura non minore, la codifica con perdita di dati aiuta a risparmiare sull'acquisto di dischi con le tue canzoni preferite: oggi devi solo andare su Internet e puoi trovare quasi tutte le canzoni di tuo interesse. Naturalmente, questo stato di cose è stato a lungo un pugno nell'occhio per le case discografiche: sotto il naso, invece di acquistare dischi, le persone si scambiano le canzoni direttamente tramite Internet, il che trasforma la manna d'oro in un'attività non redditizia, ma questa è già una questione di etica e finanza. Una cosa è certa: nulla si può fare per questo stato di cose, e il boom della condivisione di musica su Internet, generato proprio dall'avvento dei lossy encoder, non si può più fermare. E questo è solo nelle mani di un utente normale.

5. Alla questione dell'elaborazione del suono

L'elaborazione del suono dovrebbe essere intesa come varie trasformazioni di informazioni sonore al fine di modificare alcune caratteristiche del suono. L'elaborazione del suono include metodi per creare vari effetti sonori, filtri, nonché metodi per pulire il suono da rumori indesiderati, cambiare il timbro, ecc. Tutto questo enorme insieme di trasformazioni si riduce, in definitiva, ai seguenti tipi principali:

1. Trasformazioni di ampiezza . Vengono eseguiti sull'ampiezza del segnale e portano alla sua amplificazione/attenuazione o modifica secondo qualche legge in alcune sezioni del segnale.

2. Trasformazioni di frequenza . Vengono eseguiti sulle componenti di frequenza del suono: il segnale viene presentato sotto forma di uno spettro di frequenze a determinati intervalli, vengono elaborate le componenti di frequenza necessarie, ad esempio il filtraggio e il "ripiegamento" inverso del segnale dal spettro in un'onda.

3. Trasformazioni di fase . Spostare la fase del segnale in un modo o nell'altro; ad esempio, tali trasformazioni di un segnale stereo consentono di realizzare l'effetto di rotazione o suono "volumetrico".

4. Trasformazioni temporali . Implementato sovrapponendo, allungando/comprimendo i segnali; consentono di creare, ad esempio, effetti di eco o chorus, nonché di influenzare le caratteristiche spaziali del suono.

Una discussione su ciascuno di questi tipi di trasformazioni può diventare un intero lavoro scientifico. Vale la pena fornire alcuni esempi pratici sull'utilizzo di questi tipi di trasformazioni durante la creazione di effetti sonori reali:

- Echo (echo) Implementato utilizzando trasformazioni temporali. Infatti, per ottenere un'eco, è necessario sovrapporre la sua copia ritardata al segnale di ingresso originale. Affinché l'orecchio umano percepisca la seconda copia del segnale come una ripetizione e non come un'eco del segnale principale, è necessario impostare il tempo di ritardo a circa 50 ms. Più di una sua copia può essere sovrapposta al segnale principale, ma diverse, che ti permetteranno di ottenere l'effetto di ripetizione ripetuta del suono (eco polifonico) in uscita. Per far sembrare che l'eco stia svanendo, è necessario sovrapporre non solo copie ritardate del segnale al segnale originale, ma anche smorzate in ampiezza.

- Riverbero (ripetizione, riflessione). L'effetto è quello di conferire al suono il volume caratteristico di una grande sala, dove ogni suono genera un'eco corrispondente, che si attenua lentamente. In pratica, con l'aiuto del riverbero, puoi "ravvivare", ad esempio, una colonna sonora realizzata in una stanza ovattata. Il riverbero differisce dall'effetto "eco" in quanto un segnale di uscita ritardato è sovrapposto al segnale di ingresso, piuttosto che una copia ritardata del segnale di ingresso. In altre parole, il blocco di riverbero è semplicemente un loop in cui l'uscita del blocco è collegata al suo ingresso, in modo che il segnale già elaborato venga reimmesso nell'ingresso ad ogni ciclo, mescolandosi con il segnale originale.

- Coro (coro). Come risultato della sua applicazione, il suono del segnale si trasforma, per così dire, nel suono di un coro o nel suono simultaneo di più strumenti. Lo schema per produrre un tale effetto è simile a quello per creare un effetto eco, con l'unica differenza che le copie ritardate del segnale in ingresso sono soggette a una debole modulazione di frequenza (in media da 0,1 a 5 Hz) prima di miscelarsi con il segnale in ingresso . L'aumento del numero delle voci nel coro si ottiene aggiungendo copie del segnale con diversi tempi di ritardo.

Naturalmente, come in tutte le altre aree, anche l'elaborazione del segnale presenta problemi che sono una sorta di ostacolo. Quindi, ad esempio, quando si scompongono i segnali in uno spettro di frequenza, esiste un principio di indeterminazione che non può essere superato. Il principio afferma che è impossibile ottenere un'immagine spettrale accurata di un segnale in un determinato momento: o per ottenere un'immagine spettrale più accurata, è necessario analizzare una sezione temporale più ampia del segnale, oppure, se siamo più interessati al momento in cui si è verificato questo o quel cambiamento nello spettro, è necessario sacrificare l'accuratezza dello spettro stesso. In altre parole, è impossibile ottenere lo spettro esatto del segnale in un punto: lo spettro esatto per un'ampia sezione del segnale, o uno spettro molto approssimativo, ma per una breve sezione.

I meccanismi per l'elaborazione del segnale esistono sia in versione software che hardware (i cosiddetti processori di effetti). Ad esempio, vocoder e processori per chitarra, ritornelli e riverberi esistono sia come hardware che come software.

L'elaborazione pratica del segnale può essere suddivisa in due tipi: elaborazione al volo e post-elaborazione. L'elaborazione al volo significa conversione istantanea del segnale (ovvero con la capacità di emettere il segnale elaborato quasi contemporaneamente al suo ingresso). Un semplice esempio sono i "gadget" di chitarra o il riverbero durante un'esibizione dal vivo sul palco. Tale elaborazione avviene istantaneamente, cioè, ad esempio, l'esecutore canta in un microfono e il processore di effetti trasforma la sua voce e l'ascoltatore ascolta la versione già elaborata della voce. La post-elaborazione è l'elaborazione di un segnale già registrato. La velocità di tale elaborazione può essere molto inferiore alla velocità di riproduzione. Tale elaborazione persegue gli stessi obiettivi, ovvero conferire al suono un certo carattere, o modificarne le caratteristiche, tuttavia, viene utilizzata nella fase di masterizzazione o di preparazione del suono per la replica, quando non c'è bisogno di fretta, ma cosa più importante è la qualità e lo studio scrupoloso di tutte le sfumature del suono. Ci sono molte diverse operazioni sul suono che, a causa delle prestazioni insufficienti dei processori odierni, non possono essere implementate al volo, quindi tali conversioni vengono eseguite solo in post-mode.

L'elaborazione del segnale è una procedura complessa e, soprattutto, ad alta intensità di risorse. Recentemente ha iniziato a essere eseguito su dispositivi digitali - prima, vari effetti sonori e altri sono stati ottenuti mediante l'elaborazione del suono in dispositivi analogici. Nelle apparecchiature analogiche, il suono sotto forma di oscillazioni elettriche passa attraverso vari percorsi (blocchi di elementi elettrici), ottenendo un cambiamento nella fase, nello spettro e nell'ampiezza del segnale. Tuttavia, questo metodo di elaborazione presenta molti svantaggi. In primo luogo, la qualità dell'elaborazione ne risente, poiché ogni elemento analogico ha il proprio errore e diverse dozzine di elementi possono influire in modo critico sull'accuratezza e sulla qualità del risultato desiderato. E in secondo luogo, e questa è forse la cosa più importante, quasi ogni singolo effetto si ottiene utilizzando un dispositivo separato, quando ciascuno di questi dispositivi può essere molto costoso. La possibilità di utilizzare dispositivi digitali ha vantaggi innegabili. La qualità dell'elaborazione del segnale in essi dipende molto meno dalla qualità dell'apparecchiatura, l'importante è digitalizzare il suono con alta qualità ed essere in grado di riprodurlo in alta qualità, quindi la qualità dell'elaborazione ricade solo sul meccanismo del software . Inoltre, per varie manipolazioni con il suono, non è richiesto un cambio costante dell'attrezzatura. E, soprattutto, poiché l'elaborazione viene eseguita in modo programmatico, si aprono semplicemente incredibili opportunità, limitate solo dalla potenza dei computer (e aumenta ogni giorno) e dall'immaginazione di una persona. Tuttavia, (almeno oggi) ci sono anche dei problemi. Quindi, ad esempio, spesso, anche per l'implementazione di una semplice elaborazione del segnale, è necessario scomporlo in uno spettro di frequenze. In questo caso, l'elaborazione del segnale al volo può essere difficile proprio a causa dell'intensità delle risorse della fase di decomposizione. Pertanto, le trasformazioni che richiedono la decomposizione spettrale vengono eseguite più spesso in modalità post.

6. Attrezzatura

Una parte importante della conversazione sul suono è legata all'attrezzatura. Esistono molti dispositivi diversi per l'elaborazione del suono e l'ingresso/uscita. Per quanto riguarda un personal computer convenzionale, dovremmo soffermarci sulle schede audio in modo più dettagliato. Le schede audio sono generalmente suddivise in suono, musica e musica sonora. In base alla progettazione, tutte le schede audio possono essere divise in due gruppi: le principali (installate sulla scheda madre del computer e forniscono input e output di dati audio) e quelle secondarie (hanno una differenza strutturale fondamentale rispetto alle schede principali: sono spesso collegato ad un apposito connettore posto sulla scheda principale). Le schede figlie vengono spesso utilizzate per fornire o espandere le capacità di un sintetizzatore MIDI.

Le schede audio e musicali e le schede audio sono realizzate sotto forma di dispositivi inseriti nello slot della scheda madre (o già integrati in esso dall'inizio). Visivamente, di solito hanno due ingressi analogici: linea e microfono e diverse uscite analogiche: uscite di linea e un'uscita per le cuffie. Recentemente, le schede sono state dotate anche di un ingresso e un'uscita digitali che forniscono audio tra dispositivi digitali. Gli ingressi e le uscite analogici di solito hanno connettori simili ai jack per cuffie (1/8"). In generale, la scheda audio ha poco più di due ingressi: CD analogico, MIDI e altri ingressi. Essi, a differenza degli ingressi microfono e linea, si trovano non sul pannello posteriore della scheda audio, ma sulla scheda stessa; potrebbero esserci altri ingressi, ad esempio, per il collegamento di un modem vocale. Gli ingressi e le uscite digitali sono generalmente implementati come interfaccia S/PDIF (Digital Signal Transfer Interface) con un connettore corrispondente (S/PDIF è l'abbreviazione di Sony/Panasonic Digital Interface - Sony/Panasonic Digital Interface). S / PDIF è una versione "familiare" del più complesso standard professionale AES / EBU (Audio Engineering Society / European Broadcast Union). Il segnale S/PDIF viene utilizzato per trasmettere digitalmente (codificare) dati stereo a 16 bit a qualsiasi frequenza di campionamento. Oltre a quanto sopra, le schede audio e musicali dispongono di un'interfaccia MIDI con connettori per il collegamento di dispositivi MIDI e joystick, nonché per il collegamento di una scheda musicale figlia (sebbene recentemente la possibilità di collegare quest'ultima sia diventata rara). Per comodità dell'utente, alcuni modelli di schede audio sono dotati di un pannello frontale installato sul lato anteriore dell'unità di sistema del computer, che ospita connettori collegati ai vari ingressi e uscite della scheda audio.

Definiamo alcuni blocchi principali che compongono le tavole sonore e musicali.

1. Blocco dell'elaborazione del segnale digitale (codec). In questo blocco vengono eseguite le conversioni da analogico a digitale e da digitale ad analogico (ADC e DAC). Questo blocco determina caratteristiche della scheda come la massima frequenza di campionamento durante la registrazione e la riproduzione del segnale, il massimo livello di quantizzazione e il numero massimo di canali elaborati (mono o stereo). In larga misura, le caratteristiche di rumore dipendono anche dalla qualità e dalla complessità dei componenti di questo blocco.

2. Blocco sintetizzatore. Presente nelle carte musicali. Viene eseguito sulla base della sintesi FM o WT o di entrambe contemporaneamente. Può funzionare sia sotto il controllo del proprio processore, sia sotto il controllo di un driver speciale.

3. Blocco interfaccia. Fornisce il trasferimento dei dati tramite varie interfacce (ad es. S/PDIF). Una scheda audio pura spesso manca di questo blocco.

4. Blocco miscelatore. Nelle schede audio, l'unità di missaggio consente la regolazione di:

- livelli di segnale dagli ingressi di linea;

- livelli da ingresso MIDI e ingresso audio digitale;

- livello generale del segnale;

- panoramica;

- timbro.

Consideriamo i parametri più importanti che caratterizzano il suono e le tavole sonore. Le caratteristiche più importanti sono: la massima frequenza di campionamento (frequenza di campionamento) in modalità di registrazione e modalità di riproduzione, il livello massimo di quantizzazione o profondità di bit (livello di quantizzazione massimo) in modalità di registrazione e riproduzione. Inoltre, poiché anche le schede audio e musicali hanno un sintetizzatore, nelle loro caratteristiche sono inclusi anche i parametri del sintetizzatore installato. Naturalmente, maggiore è il livello di quantizzazione che la scheda è in grado di codificare segnali, maggiore è la qualità del segnale ottenuto. Tutti i moderni modelli di schede audio sono in grado di codificare un segnale con un livello di 16 bit. Una delle caratteristiche importanti è la possibilità di riproduzione e registrazione simultanea di flussi audio. La caratteristica della scheda per riprodurre e registrare contemporaneamente è chiamata full duplex (full duplex). C'è un'altra caratteristica che spesso gioca un ruolo decisivo quando si acquista una scheda audio: il rapporto segnale/rumore (rapporto segnale/rumore, S/N). Questo indicatore influisce sulla purezza della registrazione e della riproduzione del segnale. Il rapporto segnale/rumore è il rapporto tra la potenza del segnale e la potenza del rumore all'uscita del dispositivo, questo indicatore è solitamente misurato in dB. Un rapporto di 80-85 dB può essere considerato buono; ideale - 95-100 dB. Tuttavia, tenere presente che la qualità della riproduzione e della registrazione è fortemente influenzata dalle interferenze (interferenze) provenienti da altri componenti del computer (alimentatore, ecc.). Di conseguenza, il rapporto segnale/rumore potrebbe cambiare in peggio. In pratica, ci sono molti modi per affrontarlo. Alcuni suggeriscono di collegare a terra il computer. Altri, per proteggere la scheda audio dalle interferenze il più accuratamente possibile, la "estraggono" fuori dal case del computer. Tuttavia, è molto difficile proteggersi completamente dai pickup, poiché anche gli elementi della mappa stessa creano pickup l'uno sull'altro. Stanno anche cercando di affrontare questo e per questo proteggono ogni elemento sul tabellone. Ma non importa quanti sforzi siano stati fatti per risolvere questo problema, è impossibile eliminare completamente l'influenza delle interferenze esterne.

Un'altra caratteristica altrettanto importante è il coefficiente di distorsione non lineare o distorsione armonica totale, THD. Questo indicatore influisce anche in modo critico sulla purezza del suono. Il coefficiente di distorsione non lineare è misurato in percentuale: 1% - suono "sporco"; 0,1% - suono normale; 0,01% - suono Hi-Fi puro; 0,002% - Suono di classe Hi-Fi - Hi End .. La distorsione non lineare è il risultato di imprecisioni nel recupero del segnale da digitale ad analogico. Semplificato, il processo di misurazione di questo coefficiente viene eseguito come segue. L'ingresso della scheda audio è un segnale sinusoidale puro. All'uscita del dispositivo viene prelevato un segnale il cui spettro è la somma dei segnali sinusoidali (la somma della sinusoide originale e delle sue armoniche). Quindi, secondo una formula speciale, viene calcolato il rapporto quantitativo tra il segnale originale e le sue armoniche ottenuto all'uscita del dispositivo. Questo rapporto quantitativo è il coefficiente di distorsione non lineare (THD).

Cos'è un sintetizzatore MIDI? Il termine "sintetizzatore" viene solitamente utilizzato in relazione ad uno strumento musicale elettronico in cui il suono viene creato ed elaborato, modificandone il colore e le caratteristiche. Naturalmente, il nome di questo dispositivo deriva dal suo scopo principale: la sintesi del suono. Esistono solo due metodi principali di sintesi del suono: FM (Modulazione di frequenza - modulazione di frequenza) e WT (Tabella d'onda - tabella d'onda). Dal momento che non possiamo soffermarci sulla loro considerazione qui, descriveremo solo l'idea principale dei metodi. La sintesi FM si basa sull'idea che qualsiasi oscillazione anche la più complessa è essenzialmente la somma di quelle sinusoidali più semplici. In questo modo è possibile sovrapporre segnali provenienti da un numero finito di generatori sinusoidi e, variando le frequenze delle sinusoidi, ottenere suoni simili a quelli reali. La sintesi Wavetable si basa su un principio diverso. La sintesi del suono utilizzando questo metodo si ottiene manipolando i suoni preregistrati (digitalizzati) di strumenti musicali reali. Questi suoni (chiamati campioni) sono archiviati nella memoria permanente del sintetizzatore.

Un sintetizzatore MIDI è un sintetizzatore che soddisfa i requisiti dello standard di cui parleremo tra poco. Il MIDI è una specifica generalmente accettata relativa all'organizzazione di un'interfaccia digitale per dispositivi musicali, incluso uno standard hardware e software.

Questa specifica è destinata all'organizzazione di una rete locale di strumenti elettronici (Fig. 7). I dispositivi MIDI includono vari hardware e strumenti musicali conformi ai requisiti MIDI. Pertanto, un sintetizzatore MIDI è uno strumento musicale, solitamente progettato per sintetizzare suono e musica e soddisfa anche le specifiche MIDI. Diamo una rapida occhiata al motivo per cui una classe separata di dispositivi chiamata MIDI viene individuata.

Il fatto è che l'implementazione dell'elaborazione del suono del software è spesso associata a inconvenienti dovuti a varie caratteristiche tecniche di questo processo. Anche dopo aver assegnato le operazioni di elaborazione del suono a una scheda audio oa qualsiasi altra apparecchiatura, permangono molti problemi diversi. In primo luogo, spesso è desiderabile utilizzare la sintesi hardware del suono di strumenti musicali (almeno perché un computer è uno strumento troppo generico, spesso basta un sintetizzatore hardware di suoni e musica, niente di più). In secondo luogo, l'elaborazione del suono del software è spesso accompagnata da ritardi temporali, mentre il lavoro dal vivo richiede la ricezione istantanea del segnale elaborato. Per questi e altri motivi, ricorrono all'uso di apparecchiature speciali per l'elaborazione e non a computer con programmi speciali. Tuttavia, quando si utilizzano apparecchiature, è necessario un unico standard che consenta ai dispositivi di essere collegati tra loro e combinati. Questi prerequisiti hanno costretto diverse aziende leader nel campo delle apparecchiature musicali ad approvare il primo standard MIDI nel 1982, che successivamente ha ricevuto una continuazione e si sviluppa fino ad oggi. Che cos'è, in definitiva, un'interfaccia MIDI e i dispositivi in essa inclusi dal punto di vista di un personal computer?

- Hardware: sono installati sulla scheda audio: un sintetizzatore di vari suoni e strumenti musicali, un microprocessore che controlla e gestisce il funzionamento dei dispositivi MIDI, nonché vari connettori e cavi standardizzati per il collegamento di dispositivi aggiuntivi.

- Il software è un protocollo MIDI, che è un insieme di messaggi (comandi) che descrivono varie funzioni del sistema MIDI e attraverso il quale viene effettuata la comunicazione (scambio di informazioni) tra dispositivi MIDI. I messaggi possono essere considerati come un mezzo di controllo remoto.

Lo scopo di questo articolo non ci consente di approfondire una descrizione particolare del MIDI, tuttavia, va notato che in relazione ai sintetizzatori di suoni, il MIDI stabilisce requisiti rigorosi per le loro capacità, i metodi di sintesi del suono in essi utilizzati, nonché per quanto riguarda i parametri di controllo della sintesi. Inoltre, affinché la musica creata su un sintetizzatore possa essere facilmente trasferita e riprodotta con successo su un altro, sono stati stabiliti diversi standard per abbinare gli strumenti (voci) e i loro parametri in vari sintetizzatori: General MIDI (GM), General Synth ( GS) e Generale esteso (XG). Lo standard di base è GM, gli altri due sono le sue estensioni ed estensioni logiche.

Come esempio pratico di un dispositivo MIDI, si consideri una normale tastiera MIDI. In parole povere, una tastiera MIDI è una tastiera di pianoforte accorciata in una custodia con un'interfaccia MIDI che consente di collegarla ad altri dispositivi MIDI, ad esempio a un sintetizzatore MIDI installato nella scheda audio del computer. Utilizzando un software speciale (ad esempio un sequencer MIDI), è possibile portare il sintetizzatore MIDI in modalità di riproduzione, ad esempio sul pianoforte, e premendo i tasti della tastiera MIDI è possibile ascoltare i suoni del pianoforte. Naturalmente, la questione non si limita al pianoforte: lo standard GM ha 128 strumenti melodici e 46 strumenti a percussione. Inoltre, utilizzando un sequencer MIDI, è possibile registrare le note suonate su una tastiera MIDI in un computer per le successive modifiche e arrangiamenti, o semplicemente per la stampa elementare delle note.

Va notato che poiché i dati MIDI sono un insieme di comandi, anche la musica scritta utilizzando il MIDI viene registrata utilizzando i comandi del sintetizzatore. In altre parole, una partitura MIDI è una sequenza di comandi: quale nota suonare, quale strumento utilizzare, per quanto tempo e per quanto tempo deve suonare e così via. Familiari a molti file MIDI (.MID) non sono altro che un insieme di tali comandi. Naturalmente, poiché esistono moltissimi produttori di sintetizzatori MIDI, lo stesso file può suonare in modo diverso su sintetizzatori diversi (perché gli strumenti stessi non sono memorizzati nel file, ma ci sono solo indicazioni al sintetizzatore quali strumenti suonare, mentre quanto sono diversi i sintetizzatori possono suonare in modo diverso).

Torniamo alla considerazione delle schede audio e musicali. Poiché abbiamo già chiarito cosa sia il MIDI, non possiamo ignorare le caratteristiche del sintetizzatore hardware integrato nella scheda audio. Un moderno sintetizzatore, molto spesso, si basa sulla cosiddetta "tabella d'onda" - WaveTable (in breve, il principio di funzionamento di un tale sintetizzatore è che il suono in esso contenuto viene sintetizzato da un insieme di suoni registrati imponendoli dinamicamente e modificando i parametri del suono), in precedenza la sintesi di tipo principale era FM (Modulazione di frequenza - sintesi del suono generando semplici oscillazioni sinusoidali e mescolandole). Le principali caratteristiche del sintetizzatore WT sono: il numero di strumenti in ROM e le sue dimensioni, la disponibilità di RAM e la sua dimensione massima, il numero di possibili effetti di elaborazione del segnale, nonché la possibilità di elaborazione degli effetti canale per canale ( ovviamente, nel caso di un processore di effetti), il numero di generatori che determinano il numero massimo di voci in modalità polifonica (multi-voice) e, forse soprattutto, lo standard secondo cui è realizzato il sintetizzatore (GM, GS o XG). A proposito, la quantità di memoria del sintetizzatore non è sempre un valore fisso. Il fatto è che recentemente i sintetizzatori hanno smesso di avere una propria ROM, ma utilizzano la RAM principale del computer: in questo caso, tutti i suoni utilizzati dal sintetizzatore vengono memorizzati in un file su disco e, se necessario, letti nella RAM.

7. Software

Il tema del software è molto ampio, quindi qui discuteremo solo brevemente dei principali rappresentanti del software di elaborazione audio.

La classe di programmi più importante è editor audio digitale. Le caratteristiche principali di tali programmi sono, come minimo, la possibilità di registrare (digitalizzare) l'audio e salvarlo su disco. I rappresentanti sviluppati di questo tipo di programmi consentono molto di più: registrazione, missaggio audio multicanale su più tracce virtuali, elaborazione con effetti speciali (sia integrati che collegati esternamente - ne parleremo più avanti), rimozione del rumore, navigazione e strumenti avanzati sotto forma di spettroscopio e altri strumenti virtuali, controllo/gestibilità di dispositivi esterni, conversione audio da formato a formato, generazione di segnali, registrazione su CD e molto altro. Alcuni di questi programmi sono Cool Edit Pro (Syntrillium), Sound Forge (Sonic Foundry), Nuendo (Steinberg), Samplitude Producer (Magix), Wavelab (Steinberg).

Le caratteristiche principali dell'editor Cool Edit Pro 2.0 (vedi Screenshot 1 - un esempio della finestra di lavoro del programma in modalità multitraccia): editing e mixaggio dell'audio su 128 tracce, 45 effetti DSP integrati, inclusi strumenti per il mastering, l'analisi e il ripristino audio, elaborazione a 32 bit, supporto audio a 24 bit/192 kHz, potenti strumenti di loop, supporto DirectX, controllo SMPTE/MTC, supporto video e MIDI e altro ancora.

Schermata 1

Le caratteristiche principali dell'editor Sound Forge 6.0a (vedi Screenshot 2 - un esempio della finestra di lavoro del programma): potenti capacità di editing non distruttivo, elaborazione multitasking in background delle attività, supporto per file con parametri fino a 32 bit / 192 kHz, gestore preimpostazioni, supporto per file superiori a 4 GB, lavoro con video, un'ampia serie di effetti di elaborazione, ripristino da blocchi, anteprima degli effetti applicati, un analizzatore di spettro e altro ancora.

Schermata 2

Non meno importante in senso funzionale, un gruppo di programmi - sequenziatori(programmi per scrivere musica). Molto spesso, tali programmi utilizzano un sintetizzatore MIDI (hardware esterno o integrato in quasi tutte le schede audio o software, organizzati da software speciali). Tali programmi forniscono all'utente un pentagramma familiare (come il programma Finale di CODA) o un modo più comune di modificare l'audio su un computer, il cosiddetto piano-roll (questa è una rappresentazione più comprensibile della musica per le persone che non hanno familiarità con spartiti; in questo la rappresentazione ha un asse verticale con l'immagine dei tasti del pianoforte, e il tempo è disposto orizzontalmente, quindi, ponendo all'intersezione tratti di diversa lunghezza, si ottiene il suono di una certa nota con una certa durata) . Esistono anche programmi che consentono di visualizzare e modificare l'audio in entrambe le visualizzazioni. I sequencer avanzati, oltre all'editing audio, possono duplicare ampiamente le capacità degli editor audio digitali: registrare su CD, combinare tracce MIDI con segnali digitali ed eseguire il mastering. Rappresentanti brillanti di questa classe di programmi: Cubase (Steinberg), Logic Audio (Emagic), Cakewalk (Twelve Tone Systems) e il già citato Finale.

Le caratteristiche principali dell'editor Cubase 5.1 (vedi Screenshot 3 - un esempio della finestra di lavoro del programma nella modalità di visualizzazione delle tracce MIDI): editing della musica in tempo reale utilizzando una rappresentazione grafica delle informazioni, alta risoluzione dell'editor (15360 impulsi per trimestre ), numero quasi illimitato di tracce, 72 canali audio, supporto per VST32, 4 equalizzatori per canale e altri effetti per canale, strumenti di elaborazione integrati che utilizzano la modellazione analogica (strumenti virtuali, processori di effetti, strumenti di missaggio e registrazione) e molti altri caratteristiche.

Schermata 3

Le caratteristiche principali dell'editor di Logic Audio 5 (vedi Screenshot 4 - un esempio della finestra di lavoro del programma): lavoro dal suono con precisione a 32 bit, alta risoluzione temporale degli eventi, mixer audio e MIDI autoadattante, interfaccia utente ottimizzata, sincronizzazione con video, numero virtualmente illimitato di tracce MIDI, elaborazione audio in tempo reale, sincronizzazione completa con MTC, MMC, SMPTE, moduli di elaborazione integrati e strumenti automatici, supporto per un gran numero di apparecchiature hardware e molte altre funzionalità .

Schermata 4

Nell'insieme di programmi per l'utente coinvolto nell'elaborazione del suono, ci sono molti strumenti diversi, come lo era prima e così sarà in futuro: non ci sono combinazioni universali per lavorare con il suono. Tuttavia, nonostante tutta la varietà di software, i programmi utilizzano spesso meccanismi simili per l'elaborazione del suono (ad esempio processori di effetti e altri). Ad un certo punto dello sviluppo del software audio, i produttori si sono resi conto che era più conveniente creare la possibilità di collegare strumenti esterni nei loro programmi piuttosto che creare ogni volta nuovi strumenti per ogni singolo programma. Tanti programmi appartenenti a un particolare gruppo di software consentono di collegare i cosiddetti "plug-in" - plug-in esterni che ampliano le possibilità di elaborazione del suono. Ciò è diventato possibile grazie all'emergere di numerosi standard per l'interfaccia tra il programma e il plug-in. Ad oggi esistono due principali standard di interfaccia: DX e VST. L'esistenza di standard consente di collegare lo stesso plug-in a programmi completamente diversi senza preoccuparsi di conflitti e malfunzionamenti. Parlando dei plugin stessi, va detto che questa è solo una vasta famiglia di programmi. Di solito, un plug-in è un meccanismo che implementa un effetto specifico, come un riverbero o un filtro passa-basso. Tra i plug-in interessanti ricordiamo, ad esempio, iZotope Vinyl - permette di conferire al suono l'effetto di un disco in vinile (vedi Screenshot 5 - un esempio della finestra di lavoro del plug-in nell'ambiente Cool Edit Pro ), Antares AutoTune ti consente di correggere il suono vocale in modalità semiautomatica e Orange Vocoder è un meraviglioso vocoder (un meccanismo per far suonare diversi strumenti come una voce umana).

Schermata 5

L'elaborazione del suono e la scrittura di musica non sono solo un processo creativo. A volte è necessaria un'analisi rigorosa dei dati, così come la ricerca di difetti nel loro suono. Inoltre, il materiale audio con cui si ha a che fare non è sempre della qualità desiderata. A questo proposito, non si possono non ricordare alcuni programmi di analisi audio appositamente progettati per misurare l'analisi dei dati audio. Tali programmi aiutano a presentare i dati audio in un modo più conveniente rispetto agli editor convenzionali, oltre a studiarli attentamente utilizzando vari strumenti, come analizzatori FFT (costruttori di risposta in frequenza dinamica e statica), costruttori di sonogrammi e altri. Uno dei programmi più famosi e sviluppati di questo tipo è il programma SpectraLAB (Sound Technology Inc.), leggermente più semplice, ma potente: Analyzer2000 e Spectrogram.

Il programma SpectraLAB è il prodotto più potente del suo genere che esista oggi (vedi Screenshot 6 - un esempio della finestra di lavoro del programma, sullo schermo: un'immagine spettrale in tre rappresentazioni e un'immagine di fase). Caratteristiche del programma: 3 modalità di funzionamento (modalità post, modalità in tempo reale, modalità di registrazione), la strumentazione principale è un oscilloscopio, uno spettrometro (bidimensionale, tridimensionale e un generatore di ecografia) e un misuratore di fase, la capacità di confrontare le caratteristiche ampiezza-frequenza di diversi segnali, ampie opzioni di ridimensionamento, strumenti di misura: distorsione non lineare, rapporto segnale-rumore, distorsione e altri.

Schermata 6

Specializzato restauratori audio Svolgono anche un ruolo importante nell'elaborazione del suono. Tali programmi consentono di ripristinare la qualità del suono persa del materiale audio, rimuovere clic, rumori, crepitii, rumori specifici dalle registrazioni di audiocassette ed eseguire altre regolazioni audio. Programmi di questo tipo: Dart, Clean (da Steinberg Inc.), Audio Cleaning Lab. (da Magix Ent.), Wave Corrector.

Le caratteristiche principali del restauratore Clean 3.0 (vedi Screenshot 8 - la finestra di lavoro del programma): eliminazione di tutti i tipi di crepitii e rumori, modalità di correzione automatica, una serie di effetti per l'elaborazione del suono corretto, incluso il "suono surround" funzione con simulazione visiva acustica dell'effetto, registrazione di un CD con i dati preparati, sistema di suggerimenti "intelligente", supporto per plug-in VST esterni e altre funzionalità.

Schermata 8

Tracker- Questa è una categoria separata di programmi audio progettati specificamente per la creazione di musica. In precedenza, abbiamo considerato due modi fondamentalmente diversi di archiviare i dati audio (musica): il primo è memorizzare il suono come flusso audio compresso o non compresso, il secondo è memorizzare la musica come file MIDI (come un insieme di comandi a un sintetizzatore MIDI). La struttura e il concetto di creazione di file tracker sono molto simili al principio di memorizzazione delle informazioni MIDI. I moduli tracker (i file creati nei tracker sono generalmente chiamati moduli), così come i file MIDI, contengono una partitura in base alla quale gli strumenti devono essere suonati. Inoltre, contengono informazioni su quali effetti e in quale momento dovrebbero essere applicati quando si suona uno strumento particolare. Tuttavia, la differenza fondamentale tra moduli tracker e file MIDI è che gli strumenti suonati in questi moduli (o, più precisamente, campioni) sono memorizzati nei moduli stessi (cioè all'interno dei file), e non nel sintetizzatore (come è il caso del MIDI). Questo modo di memorizzare la musica ha molti vantaggi: la dimensione del file è piccola rispetto alla musica digitalizzata continua (poiché solo gli strumenti utilizzati e lo spartito sono registrati sotto forma di comandi), non c'è dipendenza del suono dal computer cui avviene la riproduzione (in MIDI, come dicevamo, c'è una dipendenza sonora dal sintetizzatore utilizzato), c'è grande libertà di creatività, poiché l'autore della musica non si limita a set di strumenti (come in MIDI), ma può usare qualsiasi suono digitalizzato come strumento. Principale programmi -tracker Scream Tracker, Fast Tracker, Impulse Tracker, OctaMED SoundStudio, MAD Tracker, ModPlug Tracker.

Il programma ModPlug Tracker è oggi uno di quei tracker che sono riusciti a diventare un ambiente di lavoro universale per molti tipi di moduli tracker (vedi Screenshot 7 - un esempio della finestra di lavoro del programma, sullo schermo: il contenuto delle tracce di una modulo caricato e la finestra di lavoro dei campioni di un altro modulo). Caratteristiche principali: supporto per un massimo di 64 canali fisici di audio, supporto per quasi tutti i formati di moduli tracker esistenti, importazione di strumenti in una varietà di formati, missaggio interno a 32 bit, filtro di ricampionamento di alta qualità, supporto MMX/3dNow!/SSE , rimozione automatica del crackle, estensione dei bassi, riverbero, espansione stereo, equalizzatore grafico a 6 bande e altro ancora.

Schermata 7

Infine, va detto che esiste un'enorme quantità di altri software audio: lettori audio (i più importanti: WinAMP, Sonique, Apollo, XMPlay, Cubic Player), plug-in per lettori (tra i "potenziatori" del suono audio - DFX, Enhancer, iZotop Ozone), utilità per copiare informazioni da CD audio (ExactAudioCopy, CDex, AudioGrabber), intercettori di flussi audio (Total Recorder, AudioTools), codificatori audio (codificatori MP3: codificatore Lame, codificatore Blade, Go-Go e altri; encoder VQF: encoder TwinVQ, Yamaha SoundVQ , NTT TwinVQ; encoder AAC: FAAC, PsyTel AAC, Quartex AAC), convertitori audio (per convertire informazioni audio da un formato all'altro), generatori vocali e molte altre utilità specifiche e generali. Naturalmente, tutto quanto sopra è solo una piccola parte di ciò che può essere utile quando si lavora con il suono.

8. Prospettive e problemi

Le prospettive per lo sviluppo e l'uso dell'audio digitale sono considerate dagli autori dell'articolo molto ampie. Sembrerebbe che tutto ciò che si potrebbe fare in questo settore sia già stato fatto. Tuttavia, non lo è. Ci sono ancora molti problemi irrisolti.

Ad esempio, il campo del riconoscimento vocale è ancora molto poco sviluppato. Da tempo si tenta e si cerca di creare software in grado di riconoscere qualitativamente il linguaggio umano, ma non tutti ancora hanno portato al risultato sperato. Ma la tanto attesa svolta in questo settore potrebbe semplificare incredibilmente l'immissione di informazioni nel computer. Immagina che invece di digitare, potresti semplicemente dettarlo mentre bevi un caffè da qualche parte vicino al computer. Ci sono molti programmi presumibilmente in grado di fornire tale opportunità, tuttavia, non tutti sono universali e si smarriscono con una leggera deviazione della voce del lettore da un dato tono. Tale lavoro non porta tanto comodità quanto dolore. Un compito ancora più difficile (molto probabilmente irrisolvibile) è il riconoscimento di suoni comuni, ad esempio il suono di un violino nei suoni di un'orchestra o l'isolamento di una parte di pianoforte. Si può sperare che un giorno ciò diventi possibile, perché il cervello umano affronta facilmente tali compiti, ma oggi è troppo presto per parlare anche dei minimi cambiamenti in quest'area.

Spazio anche all'esplorazione nel campo della sintesi sonora. Esistono diversi modi per sintetizzare il suono oggi, ma nessuno di questi consente di sintetizzare un suono che non potrebbe essere distinto da quello reale. Se, ad esempio, i suoni di un pianoforte o di un trombone sono ancora più o meno suscettibili di realizzazione, non sono ancora stati in grado di ottenere un suono credibile di un sassofono o di una chitarra elettrica - ci sono molte sfumature di suono che sono quasi impossibile da ricreare artificialmente.

Possiamo quindi tranquillamente affermare che nel campo dell'elaborazione, della creazione e della sintesi del suono e della musica, è ancora molto lontano da quella parola decisiva che metterà fine allo sviluppo di questo ramo dell'attività umana.

Glossario di termini

1) DSP – Processore di segnale digitale(processore di segnale digitale). Un dispositivo (o motore software) progettato per l'elaborazione del segnale digitale.

2) Bitrate– in relazione ai flussi di dati, il numero di bit al secondo (bit al secondo). Per quanto riguarda i file audio (ad esempio, dopo la codifica con perdita) - quanti bit descrivono un secondo di audio.

3) Suono- onda acustica che si propaga nello spazio; in ogni punto dello spazio può essere rappresentato in funzione dell'ampiezza rispetto al tempo.

4) Interfaccia- un insieme di software e hardware progettato per organizzare l'interazione di vari dispositivi.