سلام، امروز در مورد نحوه ایجاد Txt صحیح Robots و اینکه اصلاً چرا به آن نیاز است صحبت خواهیم کرد.

محتوا:

robots txt چیست

در یکی از مقالات قبلی ما در مورد نحوه کار ربات های جستجوگر صحبت کردیم. فایل txt robots دستورالعمل هایی را به روبات های جستجو می دهد که چگونه سایت خود را به درستی ایندکس کنند. با استفاده از دایرکتوری ها می توانید به عنوان مثال به ربات بگویید که کدام صفحات یا دایرکتوری ها باید ایندکس شوند و کدام نه، گروهی از آینه ها برای سایت خود بسازید (در صورت داشتن آنها)، مسیر فایل نقشه سایت را مشخص کنید و غیره. عمدتاً برای جلوگیری از نمایه سازی صفحات خاصی از یک سایت استفاده می شود.

نحوه ایجاد txt ربات صحیح

در هر ویرایشگر متنی، فایلی به نام robots txt ایجاد کنید. سپس، با استفاده از دستورالعمل های توضیح داده شده در زیر، ربات را به صفحات سایتی که باید اضافه شوند یا برعکس از نتایج جستجو حذف شوند، نشان دهید. پس از ایجاد فایل، با استفاده از Yandex Webmaster یا Google Search Console آن را برای خطا بررسی کنید.

فایل تمام شده را در دایرکتوری ریشه سایت خود (جایی که فایل index.html قرار دارد) قرار دهید.

دستورالعمل عامل کاربر

این یک نوع خوش آمدگویی به ربات های جستجوگر است.

خط "User-agent:*" به همه ربات های جستجوگر می گوید که از دستورالعمل های موجود در این فایل استفاده کنند. و، به عنوان مثال، خط "کاربر-عامل: Yandex" دستورالعمل ها را فقط برای ربات جستجوی Yandex ارائه می دهد. نمونه هایی از استفاده در زیر ذکر شده است. موتورهای جستجو نیز ربات های کمکی برای دسته های مختلف دارند. به عنوان مثال، YandexNews و Googlebot-News روبات هایی برای کار با اخبار هستند.

دستورات مجاز و غیرمجاز

با استفاده از دستور Disallow، مشخص می کنید که کدام صفحات یا دایرکتوری های سایت از ایندکس شدن منع شده اند. و با استفاده از دستورالعمل Allow، بر این اساس، امکان پذیر است.

مثال ها:عامل کاربر:*

غیر مجاز:/

مجاز:/کاتالوگ/

چنین رکوردی به همه ربات های جستجوگر اطلاع می دهد که از کل سایت فقط می توانند فهرست فهرست را فهرست کنند.

به هر حال، نماد # برای توصیف نظرات در نظر گرفته شده است. همه چیز بعد از این کاراکتر و تا آخر خط در نظر گرفته نمی شود.

در اینجا یک مثال است روبات txtبا دستورالعمل های جداگانه برای موتورهای جستجوی مختلف:

#به ربات اجازه می دهد تا کل سایت به جز بخش دوچرخه را فهرست کند

عامل کاربر:*

غیر مجاز: /دوچرخه/

#ربات را از ایندکس کردن سایت منع می کند، به جز بخش دارای قایق

عامل کاربر: Googlebot

اجازه دهید: /قایق/

غیر مجاز:/

#همه موتورهای جستجوی دیگر را از ایندکس کردن سایت منع خواهد کرد

عامل کاربر: *

غیر مجاز:/

توجه داشته باشید که بین دستورالعمل های User-agent، Allow و Disallow خطوط خالی وجود ندارد!

کاراکترهای ویژه * و $

در دستورات اجازه و غیر مجاز، می توانید از کاراکترهای ویژه * و $ برای تعیین عبارات منظم استفاده کنید. *-توالی مشخص شده را انتخاب می کند

به عنوان مثال: #ربات ها را از ایندکس کردن تمام صفحاتی که آدرس URL آنها خصوصی است ممنوع می کندعامل کاربر:*

غیر مجاز: /*خصوصی

به طور پیش فرض، کاراکتر ویژه * باید در پایان هر قانون اضافه شود. و برای لغو * در انتهای قانون، از نماد $ استفاده کنید.

به عنوان مثال: # "/lock" را غیرفعال می کند# اما "/lock.html" را غیرفعال نمی کند

عامل کاربر:*

غیر مجاز: /lock$# "/lock" را نیز غیرفعال می کند

# و "/lock.html"

عامل کاربر:*

غیر مجاز: /قفل

کاراکتر ویژه $ در پایان * مشخص شده را ممنوع نمی کند، یعنی:

عامل کاربر:*غیر مجاز: /lock$# فقط "/lock" را غیرفعال می کند

غیر مجاز: /lock*$# مشابه "عدم اجازه: / lock"

# /lock.html و /lock را غیرفعال می کند

دستورالعمل نقشه سایت

اگر از نقشه سایت استفاده می کنید، از دستورالعمل نقشه سایت استفاده کنید و مسیر یک (یا چند فایل) را مشخص کنید.

عامل کاربر:*نقشه سایت:https://site.com/sitemap.xml

دستورالعمل میزبان

اگر سایت شما دارای آینه است، با استفاده از این دستورالعمل یک ربات خاص گروهی از آینه های سایت شما را تشکیل می دهد و فقط آینه اصلی را در جستجو شامل می شود. این بخشنامه انتخاب سایت مشخص شده در آن را به عنوان آینه اصلی تضمین نمی کند، اما در هنگام تصمیم گیری اولویت بالایی به آن می دهد.

مثال:#آینه اصلی سایت را نشان دهید

عامل کاربر: Yandexغیر مجاز:/mg-admin

میزبان: https://www.zerkalo.ru

توجه داشته باشید. این بخشنامه استفاده می شود منحصرا برای Yandex! + فقط یک دستور میزبان برای هر فایل robots.txt پردازش می شود.اگر چندین دستورالعمل در فایل مشخص شده باشد، ربات از دستور اول استفاده می کند.

دستورالعمل میزبان باید شامل موارد زیر باشد:

- اگر آینه فقط از طریق یک کانال امن قابل دسترسی باشد، پروتکل HTTPS. اگر از پروتکل HTTP استفاده می کنید، نیازی به تعیین آن نیست.

- یک نام دامنه معتبر که با RFC 952 مطابقت دارد و یک آدرس IP نیست.

- شماره پورت، در صورت لزوم (میزبان: myhost.ru:8080).

آیا می توان از سیریلیک در روبات txt استفاده کرد؟

نه، شما نمی توانید از الفبای سیریلیک استفاده کنید. برای تعیین نام دامنه به زبان سیریلیک، برای مثال از این سرویس استفاده کنید.

راه اندازی روبات txt MogutaCMS

در MogutaCMS، نیازی به پر کردن robots.txt ندارید، زیرا هنگام نصب موتور به طور خودکار پر می شود.

اکنون می دانید که چگونه txt روبات های صحیح را تنظیم کنید و همچنین می دانید که چگونه از دستورالعمل های مختلف برای مدیریت ایندکس سایت خود استفاده کنید و اگر باز هم سؤالی دارید، ما آماده پاسخگویی به آنها در یک بحث ویژه در VK یا در سایت هستیم. نظرات زیر دوباره می بینمت!

اگر در حال خواندن این مقاله هستید، با نوشتن صحیح robots.txt مشکل دارید. شاید با اصول اولیه آشنا باشید، چندین دستورالعمل از این دست را برای دستگاه های جستجو دیده باشید، اصل کامپایل را بدانید یا حتی تجربه زیادی در کامپایل این فایل داشته باشید. خواندن مقاله برای همه مفید و جالب خواهد بود. امروز به قوانین، اشتباهات و "شکل خوب" ایجاد ربات های مناسب و همچنین اصلاح آن در هنگام استفاده از CMS محبوب خواهیم پرداخت. ما در مورد اصول اولیه صحبت نمی کنیم. همه باید تمام قوانین اساسی برای ایجاد و تنظیم روبات ها را بدانند. و اگر آنها را نمی شناسید، ابتدا باید به Yandex Help بروید، جایی که به طور مفصل نحوه ایجاد robots.txt را خواهید خواند.

همچنین، اگر به دنبال نحوه راهاندازی یک فایل robots.txt برای انتقال از HTTP به HTTPS هستید، به اینجا بروید - تنظیم گواهی SSL

پس بزن بریم!

ربات ها را می توان به دو گروه "عنکبوت" و "دارکوب" تقسیم کرد.

عنکبوت ها پیوندهای سایت را در امتداد ساختار آن دنبال می کنند و تمام داده های مربوط به محتوای سایت را عمیق تر و عمیق تر جمع آوری می کنند. دارکوب ها روی صفحات یک سایت ضربه می زنند و بررسی می کنند که آیا این صفحات کار می کنند، آیا کاربران آن ها را می بینند یا نه، و آیا صفحه خطای 404 نمی دهد یا خیر.این مقاله بر روی یک ربات عنکبوتی تمرکز خواهد کرد که هنگام دنبال کردن لینک های داخلی، قوانین و ممنوعیت های مشخص شده در فایل robots.txt را هدایت می کند.در زیر خطاهای رایج پیکربندی robots.txt را که خودم دیده ام شرح خواهم داد و به شما خواهم گفت که چگونه می توان از آنها اجتناب کرد.

خطاهایی در کامپایل robots.txt برای وب سایتی که با آن مواجه شده ایم

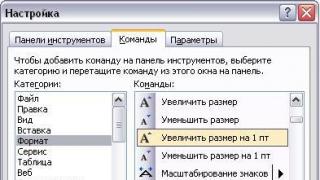

دستورالعمل های مختلط

من افتخار دیدن بسیاری از فایل های ربات را در تجربه خود داشتم، اما موارد فوق العاده و غیرممکن نیز وجود داشت. به عنوان مثال:

عامل کاربر: /

غیر مجاز: Yandex

امیدوارم همه بدانند که درست است که اینگونه بنویسیم:

عامل کاربر: Yandex

غیر مجاز:/

تعیین چندین قانون در یک عبارت

من هم به اندازه کافی خوش شانس بودم که این ننگ را در زندگی خود دیدم:

غیر مجاز: /wp-admin/ /wp-includes/ /wp-feed/

در این مورد، مشخص نیست که این یا آن ربات موتور جستجو چگونه رفتار خواهد کرد. یکی ممکن است این قانون را با هم بپذیرد - Disallow: /wp-admin/wp-includes/wp-feed/، دیگری ممکن است اولین قانون (/wp-admin/) یا آخرین (/wp-feed/) را بپذیرد. این خط را به هیچ وجه نمی پذیرد. بنابراین، ما ریسک نمی کنیم و قوانین را خط به خط، در دستورالعمل های جداگانه می نویسیم:

غیر مجاز: /wp-admin/

غیر مجاز: /wp-includes/

غیر مجاز: /wp-feed/

خطا در نام فایل

در طول زندگی من، موارد بسیار عجیبی نیز وجود داشته است. میخواستم ربات های سایت رو ببینم وارد شدم http://site.ru/robots.txtو جواب یک انجیر بود! فکر کردم: "احتمالا پرونده ای وجود ندارد." اما وقتی وارد ساختار سایت شدم شوکه شدم! املای متفاوتی داشت:

- R obots.txt (با حروف بزرگ)؛

- robot.txt (بدون s);

- ROBOTS.TXT (!CAPSOM!).

املای صحیح به طور طبیعی "robots.txt" است.

مقدار خالی در User-agent

اغلب در سایت های ناتمام ساختار زیر یافت می شود:

عامل کاربر:

غیر مجاز:

برای کیست؟ غیر واضح. تنها چیزی که از اینجا مشخص است این است که این پیام به یک ربات هم نرسیده است. نام رباتی را که دستورالعمل های زیر به آن اختصاص داده شده است را به درستی وارد کنید:

عامل کاربر: Googlebot

غیر مجاز:

تعامل بین دستورات Disallow و Allow

اغلب اوقات می بینم که دستورالعمل های مجاز و ممنوعیت اشتباه نوشته می شود:

عامل کاربر: Yandex

غیر مجاز: /admin/

غیر مجاز: /tools/

مجاز: /kartinki/

اول، بلافاصله پس از User-agent باید قوانینی وجود داشته باشد سهل گیرعبور به ربات، و پس از همه دستورالعمل های Allow باید با Disallow دنبال شود:

عامل کاربر: Yandex

مجاز: /kartinki/

غیر مجاز: /admin/

غیر مجاز: /tools/

الزامات برای تهیه پیش نویس دستورالعمل میزبان

برخی از افراد URL سایت را کپی می کنند و بی شرمانه، بدون نگاه کردن، آن را به همراه http در دستورالعمل هاست قرار می دهند:

اشتباه جدی! شما نیازی به تعیین پروتکل HTTP ندارید. اما پروتکل امن HTTPS در robots.txt ضروری است، زیرا... به ربات نشان می دهد که چگونه منبع را به درستی قرار دهد:

همچنین، نباید چندین دستورالعمل Host را در robots.txt قرار دهید. او هنوز هم فقط اولین مورد را خواهد خواند و درک می کند. بنابراین ما میزبان را بعد از تمام قوانین در بخش Yandex قرار می دهیم:

عامل کاربر: Yandex

غیر مجاز: /admin/

غیر مجاز: /tools/

میزبان: وب سایت

به یاد داشته باشید: دستورالعمل های موجود در فایل robots.txt که به اشتباه ترکیب شده اند نادیده گرفته می شوند! مثلا:

- میزبان: www.-yourresurs.ru

- میزبان: www.yourresource-.ru

- میزبان: www.yourresurs.ru:100000

- میزبان: www.your_resource.ru

- میزبان: .your-resource.ru:8000

- میزبان: your..resource.ru

- میزبان: your-resource.ru.

- میزبان: 215.160.195.128

- میزبان: www.yourresurs.ru:8080/

- میزبان: www.pervyresurs.ru www.secondresurs.ru

- میزبان: www.first resource.ru، www.second resource.ru

ایجاد یک فایل robots.txt تمرین خوبی است.

در این بخش به "سبک بد" ایجاد robots.txt خواهیم پرداخت. هر کد یا نشانه گذاری قوانین ناگفته یا نوشته شده خود را دارد که افراد کمی از آنها پیروی می کنند که می تواند منجر به عواقب فاجعه بار شود. در مورد فایل ممنوعیت نمایه سازی، ممکن است سوء تفاهم بین ربات موتور جستجو و فایل ایجاد شود، یا برنامه نویس جدید (بعدی) پروژه ممکن است متوجه نشود یا مدت زیادی طول بکشد تا آنچه نوشته شده است را درک کند. بنابراین از سوء تفاهم های ناخوشایند زیر جلوگیری می کنیم.

نظر یک خطی با قوانین و دستورالعمل ها

به طور کلی، چنین ضبطی امکان پذیر است، اما توصیه نمی شود:

Disallow: /admin/ #جلوگیری از ایندکس کردن دایرکتوری مدیریت توسط روبات ها

قبلاً برخی از سیستم ها چنین رشته هایی را درک نمی کردند. اکنون، فکر میکنم موتورهای جستجو با بسیاری از موارد زشتی که مدیران وبسایتها به آنها برخورد میکنند سازگار شدهاند، اما بهتر است ریسک نکنید و در یک خط جدید نظر بنویسید.

تغییر مسیر صفحه به خطای 404:

شرایطی وجود دارد که هنگام توسعه یک پروژه جدید، برنامه نویس فایل روبات ها را فراموش می کند و هنگامی که یک "عنکبوت" به سایت دسترسی پیدا می کند، و مطمئناً بدون این فایل این اتفاق می افتد، منبع آن را به صفحه دیگری هدایت می کند. این اتفاق می افتد که چنین تغییر مسیر عجیبی بدون برگرداندن 404 Not Found رخ می دهد. برای جلوگیری از این امر، به شما توصیه می کنم که فایل robots.txt صحیح را در ریشه سایت قرار دهید. همچنین توصیه می شود تنبل نباشید و در آن بنویسید:

عامل کاربر: *

غیر مجاز:

این robots.txt باز است. اگر در زمان توسعه یا شرایط فعلی نیاز به مسدود کردن یک سایت از نمایه سازی دارید، طبیعتاً ما از موارد زیر استفاده می کنیم:

عامل کاربر: *

غیر مجاز:/

حروف بزرگ در دستورالعمل

عامل کاربر: YANDEX

غیرفعال کردن: /ADMIN/

اینجا نظری وجود ندارد. فقط انسان باش! درست بنویس:

عامل کاربر: Yandex

غیر مجاز: /admin/

لیست کردن همه فایل ها در یک فهرست

گاهی اوقات وقتی داشتم بهینه سازی انجام می دادم به چیزی شبیه ساختار زیر برخوردم:

عامل کاربر: Yandex

غیر مجاز: /admin/backup/

غیر مجاز: /admin/cache/

غیر مجاز: /admin/components/

غیر مجاز: /admin/modules/

غیر مجاز: /admin/themes/

غیر مجاز: /admin/wizards/

و بنابراین برنامه نویس قبلی تمام پوشه های تودرتوی Admin را بست. هر چند فقط نوشتن کافی بود:

عامل کاربر: Yandex

غیر مجاز: /admin/

اگر واقعاً نیاز دارید که چند دایرکتوری را در یک پوشه بسته باز کنید، از این روش استفاده کنید:

عامل کاربر: Yandex

مجاز: /admin/css/

مجاز به: /admin/images/

غیر مجاز: /admin/

نوشتن دستورالعمل های اضافی در بخش ها

مدتی در شرکت ما بحث هایی وجود داشت: دستورالعمل میزبان را کجا قرار دهیم؟ در کدام بخش: در قسمت عمومی یا بعد از تمام قوانین انتهای فایل؟ کارمندان ما در دوره های واجد شرایط در Unibrains، Top Expert و غیره شرکت کردند و دانش و دیدگاه های متفاوتی را در مورد این موضوع به ارمغان آوردند. به نظر می رسد هیچ کس نمی دانست که چگونه robots.txt را بنویسد و کجا این دستورالعمل را به درستی بنویسد. در واقع، برخی از ربات ها ممکن است به استفاده از دستورالعمل های اضافی واکنش نادرستی نشان دهند، به این معنی که شما نباید آنها را در بخش * - (برای همه) بنویسید. Host را در بخش ربات Yandex بنویسید:

عامل کاربر: Yandex

غیر مجاز: /admin/

میزبان: وب سایت

عامل کاربر: *

غیر مجاز: /admin/

فقدان دستورالعمل عدم اجازه

این دستورالعمل اجباری است و به دلیل عدم وجود آن، ممکن است ربات متوجه شما شود.

عامل کاربر: Yandex

میزبان: وب سایت

درست می نویسیم:

عامل کاربر: Yandex

غیر مجاز: /wp-admin/

میزبان: وب سایت

در هنگام تعیین دایرکتوری هیچ علامت اسلش وجود ندارد

من آزمایشی را انجام دادم تا نشان دهم که عدم وجود اسلش در دستورالعمل ها توسط ربات به عنوان یک خطا درک می شود.

اگر بخواهیم چیزی را ببندیم فقط با اسلش قانون می نویسیم!

عامل کاربر: Yandex

غیر مجاز: /blog/

نحوه و مکان ثبت بخش نقشه سایت در ربات ها

اغلب من با تفسیر نادرست خط نقشه سایت مواجه شده ام. واقعیت این است که آنها دائماً سعی می کردند آن را در جایی وصل کنند: یا برای هر نماینده وارد شده بود یا نمی دانم چگونه و کجا آن را قرار دهم ، اما پس از تمام دستورالعمل های ربات فقط در یک عامل وارد شد. درست است که نقشه سایت را در robots.txt بعد از همه عوامل در انتهای فایل بنویسید و این قانون را با یک خط خالی بعد از آخرین دستورالعمل آخرین ربات جدا کنید:

عامل کاربر: * ...

غیر مجاز: /postednee-pravilo/

نقشه سایت: http://mysite.ru/sitemap.xml

ویژگی های robots.txt که بسیاری از آنها استفاده نمی کنند

در این پاراگراف به ویژگی ها و دستورات اضافی برای فایل robots.txt می پردازیم که توسط وب مسترها، بهینه سازان و برنامه نویسان کم استفاده می شود. من در اینجا در مورد قابلیتهای Crawl-delay، Clean-param و سایر دستورالعملها و قوانینی که قبلاً در help.yandex موجود است بحث نمیکنم.

تعامل بین صفحات معمولی و صفحات برای گوگل ادوردز

اگر می خواهید تبلیغات گوگل را در برخی از صفحات اینترنتی خود قرار دهید، اما نمی خواهید این صفحات در فهرست گوگل قرار گیرند، باید از نمایندگی Mediapartners-Google استفاده کنید. برای انجام این کار، صفحاتی را در گوگل مسدود می کنیم و آنها را (یا کل سایت) را برای تبلیغات باز می کنیم:

عامل کاربر: Googlebot

غیر مجاز: /admin/

غیر مجاز: /search/

عامل کاربر: Mediapartners-Google

مجاز: /reklamnaya-stranica/

اما به یاد داشته باشید که بخش Mediapartners-Google باید بعد از همه عوامل، از جمله "*" - برای همه قرار گیرد. در غیر این صورت معلوم می شود که ابتدا اجازه می دهید ربات از این صفحات عبور کند و سپس آن را انکار می کنید و در نهایت کاری از پیش نمی برد.

تعامل بین صفحات معمولی و صفحات برای Yandex Direct

مانند گوگل ادوردز. آنچه را که نیاز نداریم را می بندیم و آنچه را که برای تبلیغات نیاز داریم در عامل YaDirectBot باز می کنیم:

عامل کاربر: *

غیر مجاز: /admin/

غیر مجاز: /search/

غیر مجاز: /reklamnaya-stranica/

عامل کاربر: YaDirectBot

مجاز: /reklamnaya-stranica/

باز هم، فراموش نکنید که این بخش را زیر همه قرار دهید! میتوانید YaDirectBot و Mediapartners-Google را در پایین، قبل از دستورالعملهای نقشه سایت، کنار هم قرار دهید.

باز کردن تصاویر برای نمایه سازی در Yandex Images و Google Images

برای اینکه تصاویر شما در سایت در پایگاه داده های تصاویر Yandex و Google گنجانده شود، ما نمایندگان زیر را ثبت می کنیم:

عامل کاربر: Googlebot-Image

مجاز به: /themes/images/

عامل کاربر: YandexImages

مجاز به: /themes/images/

فراموش نکنید که ویژگی alt صحیح را روی تصاویر خود قرار دهید تا تصاویر شما در جستجوها یافت شوند.

قسمتی از متن را از نمایه سازی مسدود کنید

برای شروع، می خواهم توجه شما را به این واقعیت جلب کنم که این روش فقط در Yandex و Rambler کار می کند! گوگل این تگ یک معامله بزرگ است! Noindex برچسبی است که از ایندکس شدن قسمت ضروری محتوا توسط ربات جلوگیری می کند. این تگ مشابه متا تگ noindex است، اما در نظر گرفته شده است که فقط در متن استفاده شود. معمولاً از شمارنده های نمایه سازی مسدود می شوند.

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Phasellus convallis viverra diam sed pretium. Nam ut orci ut arcu ornare pretium ut a diam. Nunc ac tempus ague. Morbi in molestie massa. در hac habitasse platea dictumst. در quis maximus libero. Ut varius dolor et justo hendrerit mollis. Vivamus در semper mi، et hendrerit lacus. Pellentesque quis mollis felis. Etiam eu hendrerit libero.

تگ noindex معتبر نیست و وقتی توسط یک اعتبار سنجی بررسی می شود خطا می دهد.برای اینکه تأیید شود، آن را به عنوان یک نظر پنهان می کنیم... . این روش جواب میده!

دیمیتری سمنوف

lockki.ru، کارشناس مستقل

به هر طریقی، robots.txt باید طبق قوانین کامپایل شود. برای سرعت بخشیدن به کامپایل robots.txt مجموعه ای از فایل ها را برای 22 CMS محبوب آماده کرده ام که فقط کافی است آن ها را کمی برای سایت خود تغییر دهید.

10 قانون برای ایجاد یک فایل robots.txt از دیمیتری

- نام فایل باید robots.txt باشد نه چیز دیگری.

- باید در ریشه سایت باشد، یعنی. vashsite.ru/robots.txt

- تمام بخش های فنی را ببندید: افزونه ها، پنل مدیریت و غیره.

- قوانین به طور جداگانه برای هر ربات نوشته شده است، یعنی. در دستورالعمل User Agent تنها 1 ربات وجود دارد و هیچ شمارشی وجود ندارد.

- اگر میخواهید قوانینی را برای همه روباتها تعیین کنید، User-agent: *

- Host فقط یک بار و فقط برای Yandex نوشته می شود، این User-agent است: Yandex

- 1 دستورالعمل = 1 مقدار، یعنی. Disallow: /admin، و غیر مجاز: /admin /manage و غیره. در یک خط

- دسترسی را مسدود نمی کند، اجازه دسترسی را می دهد.

- از نمایه سازی تصاویر جلوگیری نکنید.

- صفحات اصلی تکراری که توسط CMS شما تولید می شوند را ببندید.

ویتالی کراوچنکو

رئیس آژانس تبلیغاتی وب لاین، بهینه ساز و بازاریاب اینترنتی مجرب، دوستدار آزمایش و تجربه

هنگام ایجاد فایل robots.txt به چه نکاتی باید توجه کرد

به نظر من، یکی از رایج ترین اشتباهات این است که بسیاری از بهینه سازهای تازه کار فایل Robots.txt را به عنوان یک قانون برای ربات های جستجوگر درک می کنند، اما در واقع این فایل فقط یک توصیه است. البته، اول از همه، باید درک روشنی از ساختار داشته باشید - سپس ایجاد فایل robots.txt به درستی بسیار آسان تر خواهد بود. اشاره انگشت به سمت آسمان هم می تواند مشکلات زیادی را در نمایه سازی ایجاد کند و هم سایت را از احتمال بهبود عملکرد در فصل های موتور جستجو نجات دهد. اگر سایت دیگر جوان نیست و در فهرست موتورهای جستجو ثابت است، هنگام کامپایل فایل، حتما صفحات ایندکس شده را آنالیز کنید. اگر نه، باید صفحات و فایل های خصوصی و سیستمی را که باید بسته شوند شناسایی کنید. و البته، مهم است که بررسی کنید که آیا موتور جستجو واقعاً فایل شما را درک می کند یا خیر. اغلب اوقات، عامل انسانی یا فقدان دانش لازم تأثیر بسیار منفی بر روند ارتقاء می گذارد. اگر بر کار یک بهینه ساز مبتدی نظارت می کنید، همیشه باید قبل از انتشار این فایل، کارهای انجام شده را بررسی کنید.

از تجربه من می توانم الگوریتم خاصی را یادداشت کنم:

- ما صفحات عملکردی ثابت (پنل مدیریت، سبد خرید، صفحات ورود، صفحه یادآوری رمز عبور و غیره) را تعریف می کنیم - یک لیست ایجاد کنید.

- ما صفحات زباله پویا و استاندارد را تعریف می کنیم (صفحه های چاپی، صفحات مقایسه، مجموعه فیلترهای تبلیغاتی نشده و غیره).

- ما پوشه هایی را با فایل ها و تصاویری تعریف می کنیم که نباید ایندکس شوند.

- تولید فایل Robots.txt

اکثر ربات ها به خوبی طراحی شده اند و هیچ مشکلی برای صاحبان وب سایت ایجاد نمی کنند. اما اگر ربات توسط یک آماتور نوشته شده باشد یا "مشکلی پیش آمده باشد"، می تواند بار قابل توجهی در سایتی که می خزند ایجاد کند. به هر حال، عنکبوت ها به هیچ وجه مانند ویروس ها وارد سرور نمی شوند - آنها به سادگی صفحات مورد نیاز خود را از راه دور درخواست می کنند (در واقع، اینها آنالوگ مرورگرها هستند، اما بدون عملکرد مشاهده صفحه).

Robots.txt - راهنمای کاربر-عامل و ربات های موتور جستجو

Robots.txt یک نحو بسیار ساده دارد که با جزئیات زیاد توضیح داده شده است، به عنوان مثال، در کمک Yandexو کمک گوگل. معمولاً نشان می دهد که دستورالعمل های زیر برای کدام ربات جستجو در نظر گرفته شده اند: نام ربات (" عامل کاربر")، اجازه می دهد (" اجازه") و منع (" غیر مجاز")، و "Sitemap" نیز به طور فعال برای نشان دادن محل دقیق فایل نقشه به موتورهای جستجو استفاده می شود.

این استاندارد خیلی وقت پیش ایجاد شد و بعداً چیزی اضافه شد. دستورالعمل ها و قوانین طراحی وجود دارد که فقط توسط روبات های موتورهای جستجوی خاص قابل درک است. در RuNet، فقط Yandex و Google مورد توجه هستند، به این معنی که باید با کمک آنها در کامپایل robots.txt با جزئیات خاص آشنا شوید (پیوندها را در پاراگراف قبلی ارائه کردم).

به عنوان مثال، قبلاً برای موتور جستجوی Yandex مفید بود که نشان دهد پروژه وب شما در دستورالعمل ویژه "میزبان" اصلی است که فقط این موتور جستجو آن را می فهمد (خوب، همچنین Mail.ru، زیرا جستجوی آنها از Yandex است. ). درست است، در آغاز سال 2018 Yandex همچنان Host را لغو کرده استو اکنون عملکردهای آن، مانند سایر موتورهای جستجو، توسط یک تغییر مسیر 301 انجام می شود.

حتی اگر منبع شما آینه نداشته باشد، مفید خواهد بود که مشخص کنید کدام گزینه املای اصلی است - .

حال اجازه دهید کمی در مورد نحو این فایل صحبت کنیم. دستورالعمل ها در robots.txt به شکل زیر هستند:

<поле>:<пробел><значение><пробел> <поле>:<пробел><значение><пробел>

کد صحیح باید حاوی حداقل یک دستورالعمل "عدم اجازه"پس از هر ورودی "کاربر-عامل". یک فایل خالی اجازه ایندکس کردن کل سایت را در نظر می گیرد.

عامل کاربر

دستورالعمل "کاربر-عامل".باید حاوی نام ربات جستجو باشد. با استفاده از آن، می توانید قوانین رفتاری را برای هر موتور جستجوی خاص تنظیم کنید (به عنوان مثال، ممنوعیت فهرست بندی یک پوشه جداگانه را فقط برای Yandex ایجاد کنید). نمونه ای از نوشتن "کاربر-عامل" خطاب به تمام ربات هایی که از منبع شما بازدید می کنند به این صورت است:

عامل کاربر: *

اگر می خواهید شرایط خاصی را در "کاربر-عامل" فقط برای یک ربات تنظیم کنید، به عنوان مثال، Yandex، باید این را بنویسید:

عامل کاربر: Yandex

نام ربات های موتور جستجو و نقش آنها در فایل robots.txt

هر دو موتور جستجونام خاص خود را دارد (به عنوان مثال، برای rambler آن StackRambler است). در اینجا من لیستی از معروف ترین آنها را ارائه می دهم:

Google http://www.google.com Googlebot Yandex http://www.ya.ru Yandex Bing http://www.bing.com/ bingbot

موتورهای جستجوی بزرگ گاهی اوقات به جز ربات های اصلی، همچنین موارد جداگانه ای برای نمایه سازی وبلاگ ها، اخبار، تصاویر و غیره وجود دارد. شما می توانید اطلاعات زیادی در مورد انواع ربات ها (برای Yandex) و (برای Google) دریافت کنید.

چگونه در این مورد باشیم؟ اگر نیاز به نوشتن یک قانون برای ممنوعیت ایندکس دارید که همه انواع ربات های گوگل باید از آن پیروی کنند، از نام Googlebot استفاده کنید و همه عنکبوت های دیگر این موتور جستجو نیز از آن تبعیت می کنند. با این حال، برای مثال، فقط میتوانید فهرستبندی تصاویر را با تعیین ربات Googlebot-Image به عنوان User-agent ممنوع کنید. حالا این خیلی واضح نیست، اما با مثال، فکر می کنم راحت تر خواهد شد.

نمونه هایی از استفاده از دستورات Disallow و Allow در robots.txt

من به شما چند مورد ساده می دهم. نمونه هایی از استفاده از دستورالعمل هابا توضیح اعمالش

- کد زیر به همه ربات ها (که با یک ستاره در User-agent نشان داده شده است) اجازه می دهد تا همه محتوا را بدون هیچ استثنایی فهرست کنند. این داده شده است دستور خالی غیر مجاز کردن. عامل کاربر: * غیر مجاز:

- برعکس، کد زیر به طور کامل تمام موتورهای جستجو را از اضافه کردن صفحات این منبع به فهرست منع می کند. این را با "/" در فیلد مقدار روی Disallow قرار می دهد. عامل کاربر: * غیر مجاز: /

- در این صورت، همه ربات ها از مشاهده محتویات دایرکتوری /image/ منع خواهند شد (http://mysite.ru/image/ مسیر مطلق این دایرکتوری است) User-agent: * Disallow: /image/

- برای مسدود کردن یک فایل، کافی است مسیر مطلق آن را ثبت کنید (بخوانید): User-agent: * Disallow: /katalog1//katalog2/private_file.html

با کمی نگاه کردن به آینده، می گویم که استفاده از علامت ستاره (*) آسان تر است تا مسیر کامل را ننویسید:

غیر مجاز: /*private_file.html

- در مثال زیر، دایرکتوری "image" و همچنین تمامی فایل ها و دایرکتوری هایی که با کاراکترهای "image" شروع می شوند، ممنوع خواهند بود، به عنوان مثال فایل ها: "image.htm"، "images.htm"، دایرکتوری ها: "image"، " images1"، "image34"، و غیره): User-agent: * Disallow: /image واقعیت این است که به طور پیش فرض در انتهای ورودی یک ستاره وجود دارد که جایگزین هر کاراکتری از جمله عدم وجود آنها می شود. در مورد آن در زیر بخوانید.

- با استفاده از دستورات را مجاز کنیدما اجازه دسترسی را می دهیم. مکمل ها Disallow به خوبی. به عنوان مثال، با این شرایط، ربات جستجوگر Yandex را از دانلود (نمایه گذاری) همه چیز منع می کنیم، به جز صفحات وب که آدرس آنها با /cgi-bin شروع می شود: User-agent: Yandex Allow: /cgi-bin Disallow: /

خوب، یا این مثال واضح از استفاده از ترکیب Allow و Disallow:

عامل کاربر: * غیر مجاز: /catalog اجازه: /catalog/auto

- هنگام تشریح مسیرها برای دستورالعملهای Allow-Disallow، میتوانید از نمادها استفاده کنید "*" و "$"، بنابراین عبارات منطقی خاصی را تعریف می کند.

- سمبل "*"(ستاره)به معنای هر دنباله (از جمله خالی) کاراکترها است. مثال زیر همه موتورهای جستجو را از فهرست کردن فایلهای با پسوند “.php” منع میکند: User-agent: * Disallow: *.php$

- چرا در پایان مورد نیاز است؟ علامت $? واقعیت این است که، طبق منطق کامپایل کردن فایل robots.txt، یک ستاره پیش فرض در انتهای هر دستورالعمل اضافه می شود (آنجا نیست، اما به نظر می رسد وجود دارد). برای مثال می نویسیم: Disallow: /images

به این معنی که این همان است:

غیر مجاز: /images*

آن ها این قانون فهرست کردن همه فایلها (صفحات وب، تصاویر و انواع دیگر فایلها) را که آدرس آنها با /images شروع میشود، و سپس هر چیزی که دنبال میشود، ممنوع میکند (به مثال بالا مراجعه کنید). بنابراین، نماد دلاربه سادگی ستاره پیش فرض را در پایان لغو می کند. مثلا:

غیر مجاز: /images$

فقط از نمایه سازی فایل /images جلوگیری می کند، اما نه /images.html یا /images/primer.html. خب، در مثال اول، ما ایندکس کردن فایلهایی را که به .php ختم میشوند (دارای چنین پسوندی) ممنوع کردهایم تا چیز غیر ضروری را نگیریم:

غیر مجاز: *.php$

ستاره بعد از علامت سوال خودش را نشان می دهد، اما همانطور که در بالا متوجه شدیم، قبلاً در پایان ذکر شده است. بنابراین، نمایه سازی صفحات جستجو و سایر صفحات خدمات ایجاد شده توسط موتور را که ربات جستجوگر می تواند به آنها دسترسی پیدا کند، ممنوع می کنیم. این اضافی نخواهد بود، زیرا علامت سوال اغلب توسط CMS به عنوان شناسه جلسه استفاده می شود، که می تواند منجر به اضافه شدن صفحات تکراری در فهرست شود.

راهنمای نقشه سایت و میزبان (برای Yandex) در Robots.txt

برای جلوگیری از مشکلات ناخوشایند با آینه های سایت، قبلاً توصیه شده بود که یک دستورالعمل Host به robots.txt اضافه کنید که ربات Yandex را به آینه اصلی نشان می دهد.

دستورالعمل میزبان - آینه اصلی سایت را برای Yandex نشان می دهد

به عنوان مثال، زودتر اگر شما هنوز به پروتکل ایمن تغییر نکرده اند، لازم بود در Host نه URL کامل، بلکه نام دامنه (بدون http://، i.e..ru) نشان داده شود. اگر قبلاً به https تغییر داده اید، باید URL کامل را نشان دهید (مانند https://myhost.ru).

یک ابزار فوق العاده برای مبارزه با محتوای تکراری - اگر یک URL متفاوت در Canonical ثبت شود، موتور جستجو به سادگی صفحه را فهرست نمی کند. مثلاً برای چنین صفحه ای از وبلاگ من (صفحه با صفحه بندی)، Canonical به https://site اشاره می کند و نباید مشکلی برای تکرار عناوین وجود داشته باشد.

اما من پرت میشم...

اگر پروژه شما بر اساس هر موتوری ایجاد شده است، پس محتوای تکراری رخ خواهد دادبا احتمال زیاد، به این معنی که شما باید با آن مبارزه کنید، از جمله با کمک ممنوعیت در robots.txt، و به خصوص در متا تگ، زیرا در حالت اول ممکن است گوگل ممنوعیت را نادیده بگیرد، اما دیگر قادر نخواهد بود. برای دادن لعنت به متا تگ (به این ترتیب مطرح شده است).

به عنوان مثال، در وردپرس، صفحاتی با محتوای بسیار مشابه می توانند توسط موتورهای جستجو نمایه شوند، در صورتی که نمایه سازی محتوای دسته بندی، محتوای آرشیو برچسب و محتوای آرشیو موقت مجاز باشد. اما اگر با استفاده از متا تگ Robots که در بالا توضیح داده شد، بایگانی برچسب و بایگانی موقت را ممنوع کنید (می توانید برچسب ها را رها کنید و فهرست بندی محتوای دسته ها را ممنوع کنید)، در این صورت تکرار محتوا رخ نخواهد داد. نحوه انجام این کار در پیوندی که دقیقاً در بالا داده شده است (به افزونه OlInSeoPak) توضیح داده شده است.

به طور خلاصه، می گویم که فایل Robots برای تنظیم قوانین جهانی برای ممانعت از دسترسی به کل فهرست های سایت یا فایل ها و پوشه هایی که نام آنها حاوی کاراکترهای مشخص شده است (با ماسک) در نظر گرفته شده است. می توانید نمونه هایی از تنظیم چنین ممنوعیت هایی را دقیقاً در بالا مشاهده کنید.

حال بیایید به نمونه های خاصی از ربات های طراحی شده برای موتورهای مختلف - جوملا، وردپرس و SMF نگاه کنیم. به طور طبیعی، هر سه گزینه ایجاد شده برای CMS های مختلف به طور قابل توجهی (اگر نه به طور اساسی) با یکدیگر متفاوت خواهند بود. درست است که همه آنها یک چیز مشترک خواهند داشت و این لحظه با موتور جستجوی Yandex مرتبط است.

زیرا در RuNet، Yandex وزن بسیار زیادی دارد، پس باید تمام تفاوت های ظریف کار آن را در نظر بگیریم، و در اینجا ما دستورالعمل میزبان کمک خواهد کرد. این به صراحت به این موتور جستجو آینه اصلی سایت شما را نشان می دهد.

برای این، توصیه می شود از یک وبلاگ عامل کاربر جداگانه استفاده کنید که فقط برای Yandex در نظر گرفته شده است (کاربر-عامل: Yandex). این به این دلیل است که سایر موتورهای جستجو ممکن است Host را درک نکنند و بر این اساس، گنجاندن آن در رکورد User-agent در نظر گرفته شده برای همه موتورهای جستجو (User-agent: *) ممکن است منجر به عواقب منفی و نمایه سازی نادرست شود.

به سختی می توان گفت که وضعیت واقعاً چگونه است، زیرا الگوریتم های جستجو به خودی خود یک چیز هستند، بنابراین بهتر است همانطور که توصیه می شود انجام دهید. اما در این مورد، ما باید در دستورالعمل User-agent: Yandex تمام قوانینی را که User-agent تنظیم کرده ایم کپی کنیم: *. اگر User-agent: Yandex را با Disallow خالی رها کنید، به این ترتیب به Yandex اجازه میدهید به هر جایی برود و همه چیز را به فهرست بکشد.

ربات برای وردپرس

من نمونه ای از فایلی را که توسعه دهندگان توصیه می کنند ذکر نمی کنم. می توانید خودتان آن را تماشا کنید. بسیاری از وبلاگ نویسان به هیچ وجه ربات های Yandex و Google را در قدم زدن خود در محتوای موتور وردپرس محدود نمی کنند. اغلب در وبلاگ ها می توانید ربات هایی را پیدا کنید که به طور خودکار با یک افزونه پر شده اند.

اما، به نظر من، ما همچنان باید به جستجو در کار دشوار غربال کردن گندم از کاه کمک کنیم. اولا، زمان زیادی طول می کشد تا ربات های Yandex و Google این زباله ها را فهرست کنند، و ممکن است زمانی برای افزودن صفحات وب با مقالات جدید شما به فهرست باقی نماند. در مرحله دوم، خزیدن رباتها در فایلهای موتور زباله، بار اضافی روی سرور میزبان شما ایجاد میکند که خوب نیست.

شما می توانید نسخه من از این فایل را برای خودتان ببینید. قدیمی است و مدت زیادی است که تغییر نکرده است، اما من سعی میکنم از این اصل پیروی کنم که «آنچه خراب نیست را تعمیر نکن» و این با شماست که تصمیم میگیرید: از آن استفاده کنید، خودتان بسازید یا از آن بدزدید. شخص دیگری من همچنین تا همین اواخر ممنوعیت ایندکس کردن صفحات با صفحه بندی را داشتم (Disallow: */page/) اما اخیراً با اتکا به Canonical که در بالا در مورد آن نوشتم آن را حذف کردم.

اما به طور کلی، تنها فایل صحیحبرای وردپرس احتمالا وجود ندارد. شما البته می توانید هر پیش نیازی را در آن پیاده کنید، اما چه کسی گفته است که آنها درست خواهند بود. گزینه های زیادی برای robots.txt ایده آل در اینترنت وجود دارد.

من دو حالت افراطی می دهم:

- می توانید یک مگا فایل با توضیحات دقیق پیدا کنید (نماد # نظراتی را که بهتر است در یک فایل واقعی حذف شوند جدا می کند): عامل کاربر: * # قانون کلی برای روبات ها، به جز Yandex و Google، # زیرا برای آنها قوانین زیر Disallow است: /cgi-bin # پوشه در میزبانی غیر مجاز: /؟ # همه پارامترهای درخواست در صفحه اصلی غیر مجاز: /wp- # همه فایلهای WP: /wp-json/، /wp-includes، /wp-content/plugins غیر مجاز: /wp/ # اگر یک زیر شاخه /wp/ وجود دارد که در آن CMS نصب شده است (اگر نه، # قانون را می توان حذف کرد) غیر مجاز: *?s= # جستجو غیرمجاز: *&s= # جستجو غیرمجاز: /search/ # جستجو غیرمجاز: /author/ # بایگانی نویسنده غیر مجاز: /users/ # بایگانی نویسنده غیر مجاز: */ trackback # پسگیریها، اعلانها در نظرات درباره ظاهر یک پیوند باز # به یک مقاله غیرمجاز: */feed # همه فیدها غیرمجاز: */rss # فید rss غیرمجاز: */embed # همه جاسازیها غیرمجاز : */wlwmanifest.xml # فایل xml manifest Windows Live Writer (اگر از آن استفاده نمیکنید، # قانون را میتوان حذف کرد) غیر مجاز: /xmlrpc.php # فایل API وردپرس غیرمجاز: *utm= # پیوند با برچسبهای utm غیر مجاز : *openstat= # پیوند با برچسبهای openstat مجاز است: */uploads # باز کردن پوشه با آپلود فایلها عامل کاربر: GoogleBot # قوانین برای Google (من نظرات را تکراری نمیکنم) غیرمجاز: /cgi-bin غیر مجاز: /؟ Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss غیر مجاز: */embed غیر مجاز: */wlwmanifest.xml غیر مجاز: /xmlrpc.php غیر مجاز: *utm= غیر مجاز: *openstat= مجاز: */uploads مجاز: /*/*.js # باز کردن اسکریپت های js در داخل /wp - (/*/ - برای اولویت) اجازه: /*/*.css # باز کردن فایلهای css در /wp- (/*/ - برای اولویت) اجازه: /wp-*.png # تصاویر در افزونهها، پوشه کش و غیره. مجاز به: /wp-*.jpg # تصاویر در افزونه ها، پوشه کش و غیره. اجازه دادن به: /wp-*.jpeg # تصاویر در افزونه ها، پوشه کش و غیره. اجازه دادن به: /wp-*.gif # تصاویر در افزونه ها، پوشه کش و غیره. اجازه دهید: /wp-admin/admin-ajax.php # مورد استفاده پلاگینها باشد تا JS و CSS مسدود نشود. Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss غیر مجاز: */embed غیر مجاز: */wlwmanifest.xml غیر مجاز: /xmlrpc.php مجاز: */uploads مجاز: /*/*.js مجاز: /*/*.css مجاز: /wp-*.png مجاز: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Yandex توصیه میکند # را از نمایهسازی مسدود نکنید، اما حذف کنید پارامترهای برچسب، # Google از چنین قوانینی پشتیبانی نمیکند. Clean-Param: openstat # مشابه # یک یا چند فایل نقشه سایت را مشخص کنید (نیازی به کپی کردن برای هر User-agent # نیست). Google XML Sitemap 2 نقشه سایت مانند مثال زیر ایجاد می کند. نقشه سایت: http://site.ru/sitemap.xml نقشه سایت: http://site.ru/sitemap.xml.gz # آینه اصلی سایت را مانند مثال زیر مشخص کنید (با WWW / بدون WWW، اگر HTTPS # سپس پروتکل را بنویسید، اگر نیاز به تعیین پورت دارید، آن را نشان دهید). دستور Host توسط # Yandex و Mail.RU قابل درک است، گوگل آن را در نظر نمی گیرد. میزبان: www.site.ru

- اما می توانید از نمونه ای از مینیمالیسم استفاده کنید: User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php میزبان: https://site.ru نقشه سایت: https://site. ru/sitemap.xml

حقیقت احتمالاً جایی در وسط نهفته است. همچنین، فراموش نکنید که متا تگ Robots را برای صفحات «اضافی» اضافه کنید، به عنوان مثال، با استفاده از افزونه فوق العاده - . همچنین به شما در راه اندازی Canonical کمک می کند.

robots.txt را برای جوملا درست کنید

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ غیر مجاز: /libraries/ غیر مجاز: /logs/ غیر مجاز: /modules/ غیر مجاز: /plugins/ غیر مجاز: /tmp/

اصولاً اینجا تقریباً همه چیز در نظر گرفته شده است و به خوبی کار می کند. تنها نکته این است که باید یک User-agent جداگانه اضافه کنید: قانون Yandex برای درج دستورالعمل Host، که آینه اصلی را برای Yandex تعریف می کند، و همچنین مسیر فایل Sitemap را مشخص می کند.

بنابراین، در شکل نهایی، ربات های صحیح جوملا، به نظر من، باید به این شکل باشند:

عامل کاربر: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /component/tags* Disallow: /*mailto/ Disallow: /*.pdf غیر مجاز : /*% غیر مجاز: /index.php میزبان: vash_sait.ru (یا www.vash_sait.ru) عامل کاربر: * مجاز: /*.css؟*$ مجاز: /*.js؟*$ مجاز: /* jpg؟*$ مجاز: /*.png؟*$ غیر مجاز: /administrator/ غیر مجاز: /cache/ غیر مجاز: /includes/ غیر مجاز: /installation/ غیر مجاز: /language/ غیر مجاز: /libraries/ غیر مجاز: /modules/ Disallow : /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /*mailto/ Disallow: /*. pdf Disallow: /*% Disallow: /index.php نقشه سایت: http://path به نقشه فرمت XML شما

بله، همچنین توجه داشته باشید که در گزینه دوم دستورالعمل وجود دارد اجازه، اجازه فهرستبندی سبکها، اسکریپتها و تصاویر را میدهد. این به طور خاص برای گوگل نوشته شده است، زیرا Googlebot آن گاهی اوقات شکایت می کند که نمایه سازی این فایل ها، به عنوان مثال، از پوشه با موضوع مورد استفاده، در ربات ها ممنوع است. او حتی تهدید می کند که رتبه خود را برای این کار پایین می آورد.

بنابراین، ما اجازه میدهیم که تمام این موارد از قبل با استفاده از Allow ایندکس شود. اتفاقاً در فایل نمونه وردپرس هم همین اتفاق افتاد.

موفق باشی! به زودی شما را در صفحات سایت وبلاگ می بینیم

با رفتن به اینجا می توانید ویدیوهای بیشتری را تماشا کنید");">ممکن است علاقه مند باشید

دامنه های با و بدون www - تاریخچه ظاهر آنها، استفاده از تغییر مسیر 301 برای چسباندن آنها به یکدیگر

آینه ها، صفحات تکراری و آدرس های URL - ممیزی سایت شما یا علت شکست در هنگام ارتقاء سئو آن

سلام دوستان! این مقاله نشان میدهد که روبات txt صحیح برای سایتی که در آن قرار دارد چیست، چگونه یک فایل روبات ایجاد کنیم، چگونه یک فایل روبات را از سایت دیگری تطبیق دهیم، چگونه آن را در وبلاگ خود آپلود کنیم.

فایل چیستروبات ها txt،چرا مورد نیاز است و مسئولیت آن چیست؟

فایل txt robots یک فایل متنی است که حاوی دستورالعملهایی برای روباتهای جستجوگر است. ربات قبل از دسترسی به صفحات وبلاگ شما ابتدا فایل روبات ها را جستجو می کند و به همین دلیل اهمیت زیادی دارد. فایل txt robots استانداردی برای جلوگیری از ایندکس کردن صفحات خاص توسط روبات ها است. فایل txt robots تعیین می کند که آیا داده های محرمانه شما منتشر می شود یا خیر. Txt صحیح روبات برای یک سایت به ارتقای آن کمک می کند، زیرا ابزار مهمی در تعامل بین سایت شما و روبات های جستجوگر است.

بی جهت نیست که فایل txt robots را مهمترین ابزار سئو می نامند؛ این فایل کوچک مستقیماً بر نمایه سازی صفحات سایت و کل سایت تأثیر می گذارد. برعکس، txt روباتهای نادرست میتوانند برخی از صفحات، بخشها یا کل سایت را از نتایج جستجو حذف کنند. در این صورت، شما می توانید 1000 مقاله در وبلاگ خود داشته باشید، اما به سادگی هیچ بازدید کننده ای از سایت وجود نخواهد داشت، رهگذران کاملا تصادفی وجود خواهند داشت.

وب مستر Yandex یک فیلم آموزشی دارد که در آن Yandex یک فایل txt روبات را با جعبه ای از وسایل شخصی شما که نمی خواهید به کسی نشان دهید مقایسه می کند. برای جلوگیری از نگاه کردن افراد غریبه به این جعبه، آن را با نوار چسب ببندید و روی آن بنویسید «باز نکن».

ربات ها، به عنوان افراد خوش اخلاق، این جعبه را باز نمی کنند و نمی توانند آنچه را که در آن وجود دارد به دیگران بگویند. اگر فایل txt robots وجود نداشته باشد، ربات موتور جستجو معتقد است که همه فایلها در دسترس هستند، جعبه را باز میکند، به همه چیز نگاه میکند و به دیگران میگوید چه چیزی در جعبه است. برای جلوگیری از بالا رفتن ربات به داخل این جعبه، باید آن را از صعود به آنجا منع کنید؛ این کار با استفاده از دستور Disallow انجام می شود که از انگلیسی به عنوان ممنوع و Allow as allow ترجمه می شود.

این یک فایل txt معمولی است که در یک دفترچه یادداشت معمولی یا برنامه NotePad++ کامپایل شده است، فایلی که به روباتها پیشنهاد میکند صفحات خاصی را در سایت فهرست نکنند. این برای چیست:

- یک فایل txt robots که به درستی کامپایل شده است به روبات ها اجازه نمی دهد که هر گونه زباله را فهرست کنند و نتایج جستجو را با مطالب غیر ضروری مسدود نمی کند و همچنین صفحات تکراری ایجاد نمی کند که یک پدیده بسیار مضر است.

- به روباتها اجازه نمیدهد اطلاعاتی را که برای استفاده رسمی لازم است فهرست کنند.

- از سرقت اطلاعات محرمانه و استفاده از آن برای ارسال هرزنامه توسط روبات های جاسوس جلوگیری می کند.

این بدان معنا نیست که ما می خواهیم چیزی را از موتورهای جستجو پنهان کنیم، چیزی مخفی، فقط این اطلاعات برای موتورهای جستجو و بازدیدکنندگان ارزشی ندارد. به عنوان مثال، صفحه ورود، فیدهای RSS و غیره. علاوه بر این، فایل robots txt آینه سایت و همچنین نقشه سایت را مشخص می کند. به طور پیش فرض، یک وب سایت ساخته شده بر روی وردپرس فایل txt روبات ندارد. بنابراین باید یک فایل robots txt ایجاد کرده و آن را در پوشه ریشه وبلاگ خود آپلود کنید.در این مقاله به بررسی robots txt برای وردپرس، ایجاد، تنظیم و آپلود آن در سایت می پردازیم. بنابراین ابتدا می دانیم که فایل txt robots کجاست؟

کجاستروبات ها txtچگونه آن را ببینیم؟

من فکر می کنم بسیاری از مبتدیان این سوال را از خود می پرسند - robots txt در کجا قرار دارد؟ فایل در پوشه ریشه سایت قرار دارد، در پوشه public_html به سادگی قابل مشاهده است. می توانید به هاست خود بروید، پوشه سایت خود را باز کنید و ببینید آیا این فایل وجود دارد یا خیر. ویدئوی زیر نحوه انجام این کار را نشان می دهد. می توانید فایل را با استفاده از وب مستر Yandex و وب مستر گوگل مشاهده کنید، اما بعداً در مورد آن صحبت خواهیم کرد.

یک گزینه ساده تر نیز وجود دارد که به شما امکان می دهد نه تنها ربات های خود را txt، بلکه ربات های هر سایتی را نیز مشاهده کنید. این کار به این صورت انجام می شود - شما سایت (وبلاگ) مورد نیاز خود را باز می کنید و robots.txt را با استفاده از اسلش اضافه می کنید (نگاه کنید به اسکرین شات)

و Enter را فشار دهید، فایل robots txt باز می شود. در این حالت، نمی توانید ببینید که robots txt در کجا قرار دارد، اما می توانید آن را مشاهده و دانلود کنید.

چگونه یک مورد مناسب ایجاد کنیمروبات ها txt

برای سایت

گزینه های مختلفی برای ایجاد روبات txt برای یک وب سایت وجود دارد:

- از ژنراتورهای آنلاین استفاده کنید که به سرعت یک فایل txt روبات ایجاد می کنند؛ سایت ها و سرویس های زیادی وجود دارند که می توانند این کار را انجام دهند.

- از افزونه هایی برای وردپرس استفاده کنید که به حل این مشکل کمک می کند.

- یک فایل txt روبات را با دستان خود در یک دفترچه یادداشت معمولی یا برنامه NotePad++ ایجاد کنید.

- از روباتهای آماده و صحیح txt از سایت دیگران (وبلاگ) استفاده کنید و آدرس سایت خود را در آن جایگزین کنید.

ژنراتورها

بنابراین، من قبلا از ژنراتور برای ایجاد فایل های txt روبات استفاده نکرده ام، اما قبل از نوشتن این مقاله تصمیم گرفتم 4 سرویس را برای تولید فایل های txt روبات ها آزمایش کنم، نتایج خاصی گرفتم، بعداً در مورد آنها خواهم گفت. این خدمات عبارتند از:

- SEOlib ;

- خدمات PR-CY؛

- سرویس Raskruty.ru؛

- seo café می توانید با استفاده از این لینک به اینجا بروید - info.seocafe.info/tools/robotsgenerator.

نحوه استفاده از روبات ژنراتور txt در عمل به تفصیل در فیلم زیر نشان داده شده است. در طول فرآیند تست، من به این نتیجه رسیدم که آنها برای مبتدیان مناسب نیستند، و در اینجا چرا؟ ژنراتور فقط به شما اجازه می دهد تا ورودی صحیح را بدون خطا در خود فایل ایجاد کنید، اما برای نوشتن txt روبات صحیح هنوز باید دانش داشته باشید، باید بدانید که کدام پوشه ها را ببندید و کدام را نه. به همین دلیل، استفاده از robots txt generator را برای ایجاد یک فایل برای مبتدیان توصیه نمی کنم.

پلاگین هابرای

وردپرس

پلاگین هایی مانند PC Robots.txt برای ایجاد فایل وجود دارد. این افزونه به شما این امکان را می دهد که فایل را مستقیماً در کنترل پنل سایت ویرایش کنید. پلاگین دیگر iRobots.txt SEO است - این افزونه عملکرد مشابهی دارد. شما می توانید مجموعه ای از پلاگین های مختلف را پیدا کنید که به شما امکان می دهد با فایل txt روبات کار کنید. در صورت تمایل می توانید در قسمت “جستجوی افزونه ها” عبارت robots را وارد کنید. txt کرده و روی دکمه «جستجو» کلیک کنید و چندین پلاگین به شما پیشنهاد می شود. البته، شما باید در مورد هر یک از آنها مطالعه کنید و به بررسی ها نگاه کنید.

نحوه کار پلاگین های txt روبات برای وردپرس بسیار شبیه به نحوه عملکرد ژنراتورها است. برای دریافت txt ربات صحیح برای یک سایت، به دانش و تجربه نیاز دارید، اما مبتدیان از کجا می توانند آن را دریافت کنند؟ به نظر من از چنین خدماتی ضرر بیشتری می تواند داشته باشد تا سود. و اگر افزونه ای نصب کنید، هاست را نیز بارگذاری می کند. به همین دلیل، نصب افزونه robots txt وردپرس را توصیه نمی کنم.

ايجاد كردنروبات ها txtبه صورت دستی

شما می توانید با استفاده از یک دفترچه یادداشت معمولی یا برنامه NotePad++ به صورت دستی robots txt ایجاد کنید، اما این نیاز به دانش و تجربه دارد. این گزینه برای مبتدیان نیز مناسب نیست. اما با گذشت زمان، زمانی که تجربه کسب کردید، قادر به انجام این کار خواهید بود و میتوانید یک فایل txt robots برای سایت ایجاد کنید، دستورالعملهای Disallow robots را ثبت کنید، پوشههای لازم را از فهرستسازی ببندید، یک بررسی ربات انجام دهید و آن را فقط در مدت زمان کوتاه تنظیم کنید. 10 دقیقه. تصویر زیر ربات txt را در دفترچه یادداشت نشان می دهد:

ما روش ایجاد یک فایل txt روبات را در اینجا در نظر نخواهیم گرفت؛ این به طور مفصل در بسیاری از منابع، به عنوان مثال، Yandex Webmaster نوشته شده است. قبل از کامپایل یک فایل txt روبات، باید به Yandex Webmaster بروید، جایی که هر دستورالعمل با جزئیات توضیح داده شده است، مسئولیت آن چیست، و یک فایل بر اساس این اطلاعات بسازید. (نگاه کنید به اسکرین شات).

به هر حال، وب مستر جدید Yandex اطلاعات دقیق و مفصلی را ارائه می دهد، مقاله ای در مورد آن در وبلاگ یافت می شود. به طور دقیق تر، دو مقاله ارائه شده است که برای وبلاگ نویسان مفید خواهد بود و نه تنها مبتدیان، توصیه می کنم آنها را بخوانید.

اگر مبتدی نیستید و میخواهید خودتان رباتها را به صورت txt بسازید، باید تعدادی از قوانین را دنبال کنید:

- استفاده از کاراکترهای ملی در فایل txt robots مجاز نمی باشد.

- حجم فایل ربات نباید بیشتر از 32 کیلوبایت باشد.

- نام فایل روبات ها را نمی توان مانند Robots یا ROBOTS نوشت، فایل باید دقیقاً همانطور که در مقاله نشان داده شده است امضا شود.

- هر بخشنامه باید از یک خط جدید شروع شود.

- شما نمی توانید بیش از یک دستورالعمل را در یک خط مشخص کنید.

- دستورالعمل "عدم اجازه" با یک خط خالی معادل دستورالعمل "اجازه دادن" است - اجازه دهید، این را باید به خاطر بسپارید.

- شما نمی توانید یک فاصله در ابتدای یک خط قرار دهید.

- اگر بین دستورالعملهای مختلف «کاربر-عامل» فاصله ایجاد نکنید، رباتها فقط دستورالعمل برتر را میپذیرند - بقیه موارد نادیده گرفته میشوند.

- خود پارامتر دایرکتیو باید فقط در یک خط نوشته شود.

- شما نمی توانید پارامترهای دستورالعمل را در گیومه قرار دهید.

- شما نمی توانید یک خط را با نقطه ویرگول بعد از یک دستورالعمل ببندید.

- اگر فایل روبات ها شناسایی نشود یا خالی باشد، ربات ها این را به عنوان "همه چیز مجاز است" درک می کنند.

- میتوانید در خط دستورالعمل (برای اینکه مشخص شود خط چیست) نظر بدهید، اما فقط پس از علامت هش #.

- اگر بین خطوط فاصله بگذارید، این به معنای پایان دستورالعمل User-agent است.

- دستورات "عدم اجازه" و "اجازه دادن" باید فقط شامل یک پارامتر باشد.

- برای دستورالعمل هایی که یک دایرکتوری هستند، یک اسلش اضافه می شود، به عنوان مثال – Disallow/wp-admin.

- در بخش «تاخیر خزیدن»، باید فاصله زمانی بین دانلود اسناد از سرور، معمولاً 4-5 ثانیه را به روباتها توصیه کنید.

- مهم - نباید هیچ خط خالی بین دستورالعمل ها وجود داشته باشد. یک دستورالعمل جدید با یک فضا شروع می شود. این به معنای پایان قوانین برای ربات جستجوگر است، همانطور که ویدیوی پیوست شده با جزئیات نشان می دهد. ستاره به معنای دنباله ای از هر شخصیت است.

- من به شما توصیه می کنم تمام قوانین را به طور جداگانه برای ربات Yandex تکرار کنید، یعنی تمام دستورالعمل هایی را که برای سایر روبات ها برای Yandex به طور جداگانه تجویز شده است تکرار کنید. در پایان اطلاعات ربات Yandex، باید دستورالعمل میزبان را یادداشت کنید (Host - فقط توسط Yandex پشتیبانی می شود) و وبلاگ خود را نشان دهید. میزبان به Yandex نشان می دهد که کدام آینه سایت شما با یا بدون www اصلی است.

- علاوه بر این، در یک پوشه جداگانه از فایل txt robots، یعنی با فاصله جدا شده، توصیه می شود آدرس نقشه سایت خود را مشخص کنید. ایجاد فایل را می توان در چند دقیقه انجام داد و با عبارت User-agent: شروع می شود. اگر می خواهید برای مثال، تصاویر را از نمایه سازی مسدود کنید، باید Disallow را تنظیم کنید: /images/.

از صحیح استفاده کنیدروبات ها txt

از سایت شخص دیگری

هیچ فایل ایده آلی وجود ندارد؛ به طور دوره ای باید سعی کنید آزمایش کنید و تغییرات در عملکرد موتورهای جستجو را در نظر بگیرید، خطاهایی را که ممکن است در طول زمان در وبلاگ شما ظاهر شود را در نظر بگیرید. بنابراین، برای شروع، می توانید فایل txt روبات تایید شده شخص دیگری را بردارید و آن را برای خود نصب کنید.

مطمئن شوید که ورودی هایی که نشانی وبلاگ شما را در دایرکتوری Host نشان می دهند (نگاه کنید به اسکرین شات، همچنین ویدیو را ببینید) تغییر دهید، و همچنین آن را با آدرس سایت خود در آدرس نقشه سایت جایگزین کنید (دو خط پایین). با گذشت زمان، این فایل باید کمی تنظیم شود. به عنوان مثال، متوجه شدید که صفحات تکراری ظاهر می شوند.

در بخش “Roots txt در کجا قرار دارد، چگونه آن را ببینیم” که در بالا قرار دارد، نحوه مشاهده و دانلود robots txt را بررسی کردیم. بنابراین، شما باید یک سایت اعتماد خوب انتخاب کنید که دارای شاخص های TIC بالا، ترافیک بالا، باز کردن و دانلود صحیح روبات txt باشد. باید چندین سایت را با هم مقایسه کنید، فایل txt روبات مورد نظر را برای خود انتخاب کرده و در سایت خود آپلود کنید.

نحوه آپلود فایل در سایتروبات ها txt

به پوشه ریشه سایت

همانطور که قبلاً نوشته شد، پس از ایجاد یک سایت در وردپرس، به طور پیش فرض، هیچ فایل txt ربات وجود ندارد. بنابراین، باید ایجاد و در پوشه ریشه وب سایت ما (وبلاگ) در هاست آپلود شود. آپلود فایل بسیار ساده است. در میزبانی TimeWeb، در هاست های دیگر می توانید از طریق یا از طریق آپلود کنید. ویدئوی زیر روند آپلود فایل txt روبات در هاست TimeWeb را نشان می دهد.

بررسی فایل txt robots

پس از دانلود فایل txt robots، باید وجود و عملکرد آن را بررسی کنید. برای انجام این کار، میتوانیم فایل را از مرورگر نگاه کنیم، همانطور که در بالا در بخش «روباتهای txt در کجا قرار دارد، نحوه دیدن» نشان داده شده است. می توانید عملکرد فایل را با استفاده از وب مستر Yandex و وب مستر Google بررسی کنید. ما به یاد داریم که برای این باید وجود داشته باشد و در .

برای بررسی Yandex، به حساب وب مستر Yandex ما بروید، اگر چندین سایت دارید، سایتی را انتخاب کنید. "Indexing settings"، "Robots.txt analysis" را انتخاب کنید و سپس دستورالعمل ها را دنبال کنید.

در وب مستر گوگل نیز همین کار را انجام می دهیم، به اکانت خود می رویم، سایت مورد نظر را انتخاب می کنیم (اگر چندین مورد از آنها وجود دارد)، دکمه "Crawling" را کلیک می کنیم و "Robots.txt file verification tool" را انتخاب می کنیم. فایل txt robots باز می شود، می توانید آن را ویرایش یا بررسی کنید.

در همان صفحه دستورالعمل های بسیار خوبی برای کار با فایل txt robots وجود دارد که می توانید آنها را بخوانید. در پایان، من یک ویدیو ارائه می کنم که نشان می دهد فایل txt ربات چیست، چگونه آن را پیدا کنید، چگونه آن را مشاهده و دانلود کنید، چگونه با تولید کننده فایل کار کنید، چگونه یک robots txt ایجاد کنید و آن را برای خود تطبیق دهید، اطلاعات دیگر نشان داده شده است:

نتیجه

بنابراین، در این مقاله به این سوال پرداختیم که فایل txt ربات چیست و متوجه شدیم که این فایل برای سایت بسیار مهم است. ما یاد گرفتیم که چگونه روباتها را txt درست کنیم، چگونه یک فایل txt روبات را از سایت شخص دیگری با سایت خود تطبیق دهیم، چگونه آن را در وبلاگ خود آپلود کنیم، و چگونه آن را بررسی کنیم.

از مقاله مشخص شد که برای مبتدیان در ابتدا بهتر است از یک روبات آماده و صحیح txt استفاده کنید، اما باید به یاد داشته باشید که دامنه موجود در آن را در پوشه Host با دامنه خود جایگزین کنید و همچنین آدرس را وارد کنید. وبلاگ شما در نقشه سایت می توانید فایل txt ربات های من را از اینجا دانلود کنید. حال پس از اصلاح می توانید از فایل موجود در وبلاگ خود استفاده کنید.

یک وب سایت جداگانه برای فایل txt robots وجود دارد که می توانید به آن مراجعه کنید و اطلاعات دقیق تری را دریافت کنید. امیدوارم همه چیز برای شما خوب باشد و وبلاگ به خوبی نمایه شود. موفق باشی!

با احترام، ایوان کانپان.

P.S.برای تبلیغ صحیح وبلاگ خود، باید در مورد بهینه سازی مقالات در وبلاگ خود به درستی بنویسید، سپس بازدید و رتبه بندی بالایی خواهد داشت. محصولات اطلاعاتی من، که شامل تجربه سه ساله من است، به شما در این امر کمک خواهد کرد. شما می توانید محصولات زیر را تهیه کنید:

- کتاب پرداخت شده؛

- نقشه اطلاعاتی;

- دوره ویدیویی پولی " ".

مقالات جدید وبلاگ را مستقیماً به ایمیل خود دریافت کنید. فرم را پر کنید، روی دکمه "اشتراک" کلیک کنید

دستورالعمل های مختلط

یکی از رایج ترین خطاها در robots.txt دستورالعمل های گیج کننده است. مثلا:

عامل کاربر: /

غیر مجاز: Yandex

روش صحیح نوشتن این است:

عامل کاربر: Yandex

غیر مجاز:/

تعیین چندین دایرکتوری در یک عبارت Disallow

بسیاری از صاحبان سایت سعی می کنند همه دایرکتوری هایی را که از فهرست بندی منع شده اند در یک عبارت Disallow قرار دهند.

غیر مجاز: /css/ /cgi-bin/ /images/

چنین ضبطی استاندارد را نقض می کند و نمی توان حدس زد که ربات های مختلف چگونه آن را پردازش می کنند. برخی ممکن است فضای خالی را "رد کنند" و این ورودی را به عنوان "عدم اجازه: /css/cgi-bin/images/" تفسیر کنند. برخی ممکن است فقط از اولین یا آخرین پوشه (به ترتیب /css/ یا /images/) استفاده کنند. برخی ممکن است به سادگی دستورالعمل های نامشخص را به طور کامل کنار بگذارند.

البته، برخی از رباتها میتوانند این طرح را دقیقاً همانطور که مدیر وبمستر مد نظر دارد پردازش کنند، اما هنوز نباید روی آن حساب کنید. روش صحیح نوشتن این است:

غیر مجاز: /css/

غیر مجاز: /cgi-bin/

غیر مجاز: /images/

نام فایل شامل حروف بزرگ است

نام فایل باید robots.txt باشد نه Robots.txt یا ROBOTS.TXT.

استفاده از فایل robot.txt به جای robots.txt

یک بار دیگر، فایل باید robots.txt نامیده شود.

رشته خالی در User-agent

خیلی اشتباه:

عامل کاربر:

غیر مجاز:

درست است:

عامل کاربر: *

غیر مجاز:

آدرس اینترنتی در دستورالعمل میزبان

باید بدون مخفف پروتکل انتقال ابرمتن، یعنی بدون http:// و بدون اسلش بسته / نوشته شود.

اشتباه:

عامل کاربر: Yandex

غیر مجاز: /cgi-bin

میزبان: http://www.site.ru/

درست:

عامل کاربر: Yandex

غیر مجاز: /cgi-bin

میزبان: www.site.ru

دستورالعمل میزبان فقط برای

استفاده از حروف عام در Disallow

گاهی اوقات می خواهید چیزی بنویسید:

عامل کاربر: *

غیر مجاز: file*.html

برای تعیین تمام فایل های file1.html، file2.html، file3.html و غیره. اما متأسفانه نمی توانید (بعضی ربات ها از حروف عامیانه پشتیبانی می کنند).

سبک بد

نظرات در همان خط با دستورالعمل

طبق استاندارد، چنین ضبط کاملاً ممکن است:

غیرفعال کردن: /cgi-bin/ ربات ها را از فهرست کردن cgi-bin غیرفعال کنید

در گذشته، برخی از روبات ها چنین رشته هایی را پردازش نمی کردند. احتمالاً هیچ یک از موتورهای جستجوی اصلی دیگر این مشکل را ندارند، اما آیا ارزش ریسک کردن را دارد؟ بهتر است نظرات را جداگانه ارسال کنید.

تغییر مسیر به صفحه خطای 404:

اغلب، در سایتهایی که فایل robots.txt ندارند، زمانی که این فایل درخواست میشود، تغییر مسیر به صفحه دیگری انجام میشود. گاهی اوقات چنین تغییر مسیری بدون بازگرداندن وضعیت 404 Not Found رخ می دهد. خود عنکبوت باید بفهمد که آیا robots.txt را دریافت کرده است یا یک فایل html معمولی. این وضعیت بعید است که مشکلی ایجاد کند، اما بهتر است همیشه یک فایل robots.txt خالی در ریشه سایت قرار دهید.

حروف بزرگ سبک بدی دارند

عامل کاربر: GOOGLEBOT

غیرفعال کردن:

اگرچه robots.txt از نظر استاندارد به حروف بزرگ و کوچک حساس نیست، نام فایل ها و دایرکتوری ها اغلب به حروف بزرگ و کوچک حساس هستند. علاوه بر این، نوشتن robots.txt با تمام حروف به سبک بد در نظر گرفته می شود.

عامل کاربر: googlebot

غیر مجاز:

لیست همه فایل ها

اشتباه دیگر این است که همه فایل ها را در یک فهرست فهرست کنید:

عامل کاربر: *

غیر مجاز: /AL/Alabama.html

غیر مجاز: /AL/AR.html

غیر مجاز: /Az/AZ.html

غیر مجاز: /Az/bali.html

غیر مجاز: /Az/bed-breakfast.html

در عوض، می توانید به سادگی کل دایرکتوری را از فهرست بندی ببندید:

عامل کاربر: *

غیر مجاز: /AL/

غیر مجاز: /Az/

هیچ دستورالعمل Allow وجود ندارد! [ترجمه قدیمی]

توجه داشته باشید:در زمان ترجمه این متن وجود نداشت، اکنون این دستورالعمل توسط Google و Yandex پشتیبانی می شود. لطفا برای استفاده با ربات های دیگر بررسی کنید.

هیچ دستورالعمل Allow وجود ندارد، فقط Disallow وجود دارد. فایل robots.txt هیچ چیزی را اجازه نمی دهد، فقط آن را ممنوع می کند!

خیلی اشتباه:

عامل کاربر: Yandex

غیر مجاز: /جان/

اجازه دهید: /jane/

و این درست است:

عامل کاربر: Yandex

غیر مجاز: /جان/

غیر مجاز:

استفاده از دستورالعمل های اضافی در بخش *

خیلی اشتباه:

عامل کاربر: *

غیر مجاز: /css/

میزبان: www.example.com

و این درست است:

عامل کاربر: *

غیر مجاز: /css/عامل کاربر: Yandex

غیر مجاز: /css/

میزبان: www.example.com

فقدان دستورالعمل عدم اجازه

حتی اگر فقط می خواهیم از یک دستورالعمل اضافی استفاده کنیم و نمی خواهیم چیزی را غیرمجاز کنیم، بهتر است یک Disallow خالی را مشخص کنیم. طبق استاندارد، دستور Disallow اجباری است و ربات ممکن است شما را اشتباه متوجه شود.

خیلی اشتباه:

عامل کاربر: Yandex

میزبان: www.example.com

درست است:

عامل کاربر: Yandex

غیر مجاز:

میزبان: www.example.com

در هنگام تعیین دایرکتوری هیچ علامت اسلش وجود ندارد

ربات در این صورت چه خواهد کرد؟

عامل کاربر: Yandex

غیر مجاز: جان

بهطور پیشفرض، فایلی به نام «جان» یا فهرستی به نام «جان» را فهرست نمیکند. برای مشخص کردن فقط دایرکتوری باید به صورت زیر بنویسید:

عامل کاربر: Yandex

غیر مجاز: /جان/

هدر http نادرست است

سرور باید "Content-Type: text/plain" را در هدر HTTP برای robots.txt برگرداند و به عنوان مثال، "Content-Type: text/html" را برگرداند. هدر نادرست ممکن است مانع از پردازش فایل توسط برخی روبات ها شود.